id

int64 2.05k

16.6k

| title

stringlengths 5

75

| fromurl

stringlengths 19

185

| date

timestamp[s] | tags

sequencelengths 0

11

| permalink

stringlengths 20

37

| content

stringlengths 342

82.2k

| fromurl_status

int64 200

526

⌀ | status_msg

stringclasses 339

values | from_content

stringlengths 0

229k

⌀ |

|---|---|---|---|---|---|---|---|---|---|

10,676 | 计算机实验室之树莓派:课程 10 输入01 | https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/input01.html | 2019-04-02T12:23:00 | [

"键盘",

"树莓派"

] | https://linux.cn/article-10676-1.html |

欢迎进入输入课程系列。在本系列,你将会学会如何使用键盘接收输入给树莓派。我们将会从揭示输入开始本课,然后转向更传统的文本提示符。

这是第一堂输入课,会教授一些关于驱动和链接的理论,同样也包含键盘的知识,最后以在屏幕上显示文本结束。

### 1、开始

希望你已经完成了 OK 系列课程,这会对你完成屏幕系列课程很有帮助。很多 OK 课程上的文件会被使用而不会做解释。如果你没有这些文件,或者希望使用一个正确的实现,可以从该堂课的[下载页](https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/downloads.html)下载模板。如果你使用你自己的实现,请删除调用了 `SetGraphicsAddress` 之后全部的代码。

### 2、USB

如你所知,树莓派 B 型有两个 USB 接口,通常用来连接一个鼠标和一个键盘。这是一个非常好的设计决策,USB 是一个非常通用的接口,很多种设备都可以使用它。这就很容易为它设计新外设,很容易为它编写设备驱动,而且通过 USB 集线器可以非常容易扩展。还能更好吗?当然是不能,实际上对一个操作系统开发者来说,这就是我们的噩梦。USB 标准太大了。我是说真的,在你思考如何连接设备之前,它的文档将近 700 页。

>

> USB 标准的设计目的是通过复杂的软件来简化硬件交互。

>

>

>

我和很多爱好操作系统的开发者谈过这些,而他们全部都说几句话:不要抱怨。“实现这个需要花费很久时间”,“你不可能写出关于 USB 的教程”,“收益太小了”。在很多方面,他们是对的,我不可能写出一个关于 USB 标准的教程,那得花费几周时间。我同样不能教授如何为全部所有的设备编写外设驱动,所以使用自己写的驱动是没什么用的。然而,即便不能做到最好,我仍然可以获取一个正常工作的 USB 驱动,拿一个键盘驱动,然后教授如何在操作系统中使用它们。我开始寻找可以运行在一个甚至不知道文件是什么的操作系统的自由驱动,但是我一个都找不到,它们都太高层了,所以我尝试写一个。大家说的都对,这耗费了我几周时间。然而我可以高兴的说我做的这些工作没有获取操作系统以外的帮助,并且可以和鼠标和键盘通信。这绝不是完整的、高效的,或者正确的,但是它能工作。驱动是以 C 编写的,而且有兴趣的可以在下载页找到全部源代码。

所以,这一个教程不会是 USB 标准的课程(一点也没有)。实际上我们将会看到如何使用其他人的代码。

### 3、链接

既然我们要引进外部代码到操作系统,我们就需要谈一谈<ruby> 链接 <rt> linking </rt></ruby>。链接是一种过程,可以在程序或者操作系统中链接函数。这意味着当一个程序生成之后,我们不必要编写每一个函数(几乎可以肯定,实际上并非如此)。链接就是我们做的用来把我们程序和别人代码中的函数连结在一起。这个实际上已经在我们的操作系统进行了,因为链接器把所有不同的文件链接在一起,每个都是分开编译的。

>

> 链接允许我们制作可重用的代码库,所有人都可以在他们的程序中使用。

>

>

>

有两种链接方式:静态和动态。静态链接就像我们在制作自己的操作系统时进行的。链接器找到全部函数的地址,然后在链接结束前,将这些地址都写入代码中。动态链接是在程序“完成”之后。当程序加载后,动态链接器检查程序,然后在操作系统的库找到所有不在程序里的函数。这就是我们的操作系统最终应该能够完成的一项工作,但是现在所有东西都将是静态链接的。

>

> 程序经常调用调用库,这些库会调用其它的库,直到最终调用了我们写的操作系统的库。

>

>

>

我编写的 USB 驱动程序适合静态编译。这意味着我给你的是每个文件的编译后的代码,然后链接器找到你的代码中的那些没有实现的函数,就将这些函数链接到我的代码。在本课的 [下载页](https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/downloads.html) 是一个 makefile 和我的 USB 驱动,这是接下来需要的。下载并使用这个 makefile 替换你的代码中的 makefile, 同事将驱动放在和这个 makefile 相同的文件夹。

### 4、键盘

为了将输入传给我们的操作系统,我们需要在某种程度上理解键盘是如何实际工作的。键盘有两种按键:普通键和修饰键。普通按键是字母、数字、功能键,等等。它们构成了键盘上几乎全部按键。修饰键是多达 8 个的特殊键。它们是左 shift、右 shift、左 ctrl、右 ctrl、左 alt、右 alt、左 GUI 和右 GUI。键盘可以检测出所有的组合中那个修饰键被按下了,以及最多 6 个普通键。每次一个按钮变化了(例如,是按下了还是释放了),键盘就会报告给电脑。通常,键盘也会有 3 个 LED 灯,分别指示大写锁定,数字键锁定,和滚动锁定,这些都是由电脑控制的,而不是键盘自己。键盘也可能有更多的灯,比如电源、静音,等等。

对于标准 USB 键盘,有一个按键值的表,每个键盘按键都一个唯一的数字,每个可能的 LED 也类似。下面的表格列出了前 126 个值。

表 4.1 USB 键盘值

| 序号 | 描述 | 序号 | 描述 | 序号 | 描述 | 序号 | 描述 |

| --- | --- | --- | --- | --- | --- | --- | --- |

| 4 | `a` 和 `A` | 5 | `b` 和 `B` | 6 | `c` 和 `C` | 7 | `d` 和 `D` |

| 8 | `e` 和 `E` | 9 | `f` 和 `F` | 10 | `g` 和 `G` | 11 | `h` 和 `H` |

| 12 | `i` 和 `I` | 13 | `j` 和 `J` | 14 | `k` 和 `K` | 15 | `l` 和 `L` |

| 16 | `m` 和 `M` | 17 | `n` 和 `N` | 18 | `o` 和 `O` | 19 | `p` 和 `P` |

| 20 | `q` 和 `Q` | 21 | `r` 和 `R` | 22 | `s` 和 `S` | 23 | `t` 和 `T` |

| 24 | `u` 和 `U` | 25 | `v` 和 `V` | 26 | `w` 和 `W` | 27 | `x` 和 `X` |

| 28 | `y` 和 `Y` | 29 | `z` 和 `Z` | 30 | `1` 和 `!` | 31 | `2` 和 `@` |

| 32 | `3` 和 `#` | 33 | `4` 和 `$` | 34 | `5` 和 `%` | 35 | `6` 和 `^` |

| 36 | `7` 和 `&` | 37 | `8` 和 `*` | 38 | `9` 和 `(` | 39 | `0` 和 `)` |

| 40 | `Return`(`Enter`) | 41 | `Escape` | 42 | `Delete`(`Backspace`) | 43 | `Tab` |

| 44 | `Spacebar` | 45 | `-` 和 `_` | 46 | `=` 和 `+` | 47 | `[` 和 `{` |

| 48 | `]` 和 `}` | 49 | `\` 和 `|` | 50 | `#` 和 `~` | 51 | `;` 和 `:` |

| 52 | `'` 和 `"` | 53 | ``` 和 `~` | 54 | `,` 和 `<` | 55 | `.` 和 `>` |

| 56 | `/` 和 `?` | 57 | `Caps Lock` | 58 | `F1` | 59 | `F2` |

| 60 | `F3` | 61 | `F4` | 62 | `F5` | 63 | `F6` |

| 64 | `F7` | 65 | `F8` | 66 | `F9` | 67 | `F10` |

| 68 | `F11` | 69 | `F12` | 70 | `Print Screen` | 71 | `Scroll Lock` |

| 72 | `Pause` | 73 | `Insert` | 74 | `Home` | 75 | `Page Up` |

| 76 | `Delete forward` | 77 | `End` | 78 | `Page Down` | 79 | `Right Arrow` |

| 80 | `Left Arrow` | 81 | `Down Arrow` | 82 | `Up Arrow` | 83 | `Num Lock` |

| 84 | 小键盘 `/` | 85 | 小键盘 `*` | 86 | 小键盘 `-` | 87 | 小键盘 `+` |

| 88 | 小键盘 `Enter` | 89 | 小键盘 `1` 和 `End` | 90 | 小键盘 `2` 和 `Down Arrow` | 91 | 小键盘 `3` 和 `Page Down` |

| 92 | 小键盘 `4` 和 `Left Arrow` | 93 | 小键盘 `5` | 94 | 小键盘 `6` 和 `Right Arrow` | 95 | 小键盘 `7` 和 `Home` |

| 96 | 小键盘 `8` 和 `Up Arrow` | 97 | 小键盘 `9` 和 `Page Up` | 98 | 小键盘 `0` 和 `Insert` | 99 | 小键盘 `.` 和 `Delete` |

| 100 | `\` 和 `|` | 101 | `Application` | 102 | `Power` | 103 | 小键盘 `=` |

| 104 | `F13` | 105 | `F14` | 106 | `F15` | 107 | `F16` |

| 108 | `F17` | 109 | `F18` | 110 | `F19` | 111 | `F20` |

| 112 | `F21` | 113 | `F22` | 114 | `F23` | 115 | `F24` |

| 116 | `Execute` | 117 | `Help` | 118 | `Menu` | 119 | `Select` |

| 120 | `Stop` | 121 | `Again` | 122 | `Undo` | 123 | `Cut` |

| 124 | `Copy` | 125 | `Paste` | 126 | `Find` | 127 | `Mute` |

| 128 | `Volume Up` | 129 | `Volume Down` | | | | |

完全列表可以在[HID 页表 1.12](https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/downloads/hut1_12v2.pdf)的 53 页,第 10 节找到。

### 5、车轮后的螺母

通常,当你使用其他人的代码,他们会提供一份自己代码的总结,描述代码都做了什么,粗略介绍了是如何工作的,以及什么情况下会出错。下面是一个使用我的 USB 驱动的相关步骤要求。

>

> 这些总结和代码的描述组成了一个 API - 应用程序产品接口。

>

>

>

表 5.1 CSUD 中和键盘相关的函数

| 函数 | 参数 | 返回值 | 描述 |

| --- | --- | --- | --- |

| `UsbInitialise` | 无 | `r0` 是结果码 | 这个方法是一个集多种功能于一身的方法,它加载 USB 驱动程序,枚举所有设备并尝试与它们通信。这种方法通常需要大约一秒钟的时间来执行,但是如果插入几个 USB 集线器,执行时间会明显更长。在此方法完成之后,键盘驱动程序中的方法就可用了,不管是否确实插入了键盘。返回代码如下解释。 |

| `UsbCheckForChange` | 无 | 无 | 本质上提供与 `UsbInitialise` 相同的效果,但不提供相同的一次初始化。该方法递归地检查每个连接的集线器上的每个端口,如果已经添加了新设备,则添加它们。如果没有更改,这应该是非常快的,但是如果连接了多个设备的集线器,则可能需要几秒钟的时间。 |

| `KeyboardCount` | 无 | `r0` 是计数 | 返回当前连接并检测到的键盘数量。`UsbCheckForChange` 可能会对此进行更新。默认情况下最多支持 4 个键盘。可以通过这个驱动程序访问多达这么多的键盘。 |

| `KeyboardGetAddress` | `r0` 是索引 | `r0` 是地址 | 检索给定键盘的地址。所有其他函数都需要一个键盘地址,以便知道要访问哪个键盘。因此,要与键盘通信,首先要检查计数,然后检索地址,然后使用其他方法。注意,在调用 `UsbCheckForChange` 之后,此方法返回的键盘顺序可能会改变。 |

| `KeyboardPoll` | `r0` 是地址 | `r0` 是结果码 | 从键盘读取当前键状态。这是通过直接轮询设备来操作的,与最佳实践相反。这意味着,如果没有频繁地调用此方法,可能会错过一个按键。所有读取方法只返回上次轮询时的值。 |

| `KeyboardGetModifiers` | `r0` 是地址 | `r0` 是修饰键状态 | 检索上次轮询时修饰键的状态。这是两边的 `shift` 键、`alt` 键和 `GUI` 键。这回作为一个位字段返回,这样,位 0 中的 1 表示左控件被保留,位 1 表示左 `shift`,位 2 表示左 `alt` ,位 3 表示左 `GUI`,位 4 到 7 表示前面几个键的右版本。如果有问题,`r0` 包含 0。 |

| `KeyboardGetKeyDownCount` | `r0` 是地址 | `r0` 是计数 | 检索当前按下键盘的键数。这排除了修饰键。这通常不能超过 6。如果有错误,这个方法返回 0。 |

| `KeyboardGetKeyDown` | `r0` 是地址,`r1` 键号 | `r0` 是扫描码 | 检索特定按下键的扫描码(见表 4.1)。通常,要计算出哪些键是按下的,可以调用 `KeyboardGetKeyDownCount`,然后多次调用 `KeyboardGetKeyDown` ,将 `r1` 的值递增,以确定哪些键是按下的。如果有问题,返回 0。可以(但不建议这样做)在不调用 `KeyboardGetKeyDownCount` 的情况下调用此方法将 0 解释为没有按下的键。注意,顺序或扫描代码可以随机更改(有些键盘按数字排序,有些键盘按时间排序,没有任何保证)。 |

| `KeyboardGetKeyIsDown` | `r0` 是地址,`r1` 扫描码 | `r0` 是状态 | 除了 `KeyboardGetKeyDown` 之外,还可以检查按下的键中是否有特定的扫描码。如果没有,返回 0;如果有,返回一个非零值。当检测特定的扫描码(例如寻找 `ctrl+c`)时更快。出错时,返回 0。 |

| `KeyboardGetLedSupport` | `r0` 是地址 | `r0` 是 LED | 检查特定键盘支持哪些 LED。第 0 位代表数字锁定,第 1 位代表大写锁定,第 2 位代表滚动锁定,第 3 位代表合成,第 4 位代表假名,第 5 位代表电源,第 6 位代表 Shift ,第 7 位代表静音。根据 USB 标准,这些 LED 都不是自动更新的(例如,当检测到大写锁定扫描代码时,必须手动设置大写锁定 LED)。 |

| `KeyboardSetLeds` | `r0` 是地址, `r1` 是 LED | `r0` 是结果码 | 试图打开/关闭键盘上指定的 LED 灯。查看下面的结果代码值。参见 `KeyboardGetLedSupport` 获取 LED 的值。 |

有几种方法返回“返回值”。这些都是 C 代码的老生常谈了,就是用数字代表函数调用发生了什么。通常情况, 0 总是代表操作成功。下面的是驱动用到的返回值。

>

> 返回值是一种处理错误的简单方法,但是通常更优雅的解决途径会出现于更高层次的代码。

>

>

>

表 5.2 - CSUD 返回值

| 代码 | 描述 |

| --- | --- |

| 0 | 方法成功完成。 |

| -2 | 参数:函数调用了无效参数。 |

| -4 | 设备:设备没有正确响应请求。 |

| -5 | 不匹配:驱动不适用于这个请求或者设备。 |

| -6 | 编译器:驱动没有正确编译,或者被破坏了。 |

| -7 | 内存:驱动用尽了内存。 |

| -8 | 超时:设备没有在预期的时间内响应请求。 |

| -9 | 断开连接:被请求的设备断开连接,或者不能使用。 |

驱动的通常用法如下:

1. 调用 `UsbInitialise`

2. 调用 `UsbCheckForChange`

3. 调用 `KeyboardCount`

4. 如果返回 0,重复步骤 2。

5. 针对你支持的每个键盘:

1. 调用 `KeyboardGetAddress`

2. 调用 `KeybordGetKeyDownCount`

3. 针对每个按下的按键:

1. 检查它是否已经被按下了

2. 保存按下的按键

4. 针对每个保存的按键:

1. 检查按键是否被释放了

2. 如果释放了就删除

6. 根据按下/释放的案件执行操作

7. 重复步骤 2

最后,你可以对键盘做所有你想做的任何事了,而这些方法应该允许你访问键盘的全部功能。在接下来的两节课,我们将会着眼于完成文本终端的输入部分,类似于大部分的命令行电脑,以及命令的解释。为了做这些,我们将需要在更有用的形式下得到一个键盘输入。你可能注意到我的驱动是(故意的)没有太大帮助,因为它并没有方法来判断是否一个按键刚刚按下或释放了,它只有方法来判断当前那个按键是按下的。这就意味着我们需要自己编写这些方法。

### 6、可用更新

首先,让我们实现一个 `KeyboardUpdate` 方法,检查第一个键盘,并使用轮询方法来获取当前的输入,以及保存最后一个输入来对比。然后我们可以使用这个数据和其它方法来将扫描码转换成按键。这个方法应该按照下面的说明准确操作:

>

> 重复检查更新被称为“轮询”。这是针对驱动 IO 中断而言的,这种情况下设备在准备好后会发一个信号。

>

>

>

1. 提取一个保存好的键盘地址(初始值为 0)。

2. 如果不是 0 ,进入步骤 9.

3. 调用 `UsbCheckForChange` 检测新键盘。

4. 调用 `KeyboardCount` 检测有几个键盘在线。

5. 如果返回 0,意味着没有键盘可以让我们操作,只能退出了。

6. 调用 `KeyboardGetAddress` 参数是 0,获取第一个键盘的地址。

7. 保存这个地址。

8. 如果这个值是 0,那么退出,这里应该有些问题。

9. 调用 `KeyboardGetKeyDown` 6 次,获取每次按键按下的值并保存。

10. 调用 `KeyboardPoll`

11. 如果返回值非 0,进入步骤 3。这里应该有些问题(比如键盘断开连接)。

要保存上面提到的值,我们将需要下面 `.data` 段的值。

```

.section .data

.align 2

KeyboardAddress:

.int 0

KeyboardOldDown:

.rept 6

.hword 0

.endr

```

```

.hword num 直接将半字的常数插入文件。

```

```

.rept num [commands] .endr 复制 `commands` 命令到输出 num 次。

```

试着自己实现这个方法。对此,我的实现如下:

1、我们加载键盘的地址。

```

.section .text

.globl KeyboardUpdate

KeyboardUpdate:

push {r4,r5,lr}

kbd .req r4

ldr r0,=KeyboardAddress

ldr kbd,[r0]

```

2、如果地址非 0,就说明我们有一个键盘。调用 `UsbCheckForChanges` 慢,所以如果一切正常,我们要避免调用这个函数。

```

teq kbd,#0

bne haveKeyboard$

```

3、如果我们一个键盘都没有,我们就必须检查新设备。

```

getKeyboard$:

bl UsbCheckForChange

```

4、如果有新键盘添加,我们就会看到这个。

```

bl KeyboardCount

```

5、如果没有键盘,我们就没有键盘地址。

```

teq r0,#0

ldreq r1,=KeyboardAddress

streq r0,[r1]

beq return$

```

6、让我们获取第一个键盘的地址。你可能想要支持更多键盘。

```

mov r0,#0

bl KeyboardGetAddress

```

7、保存键盘地址。

```

ldr r1,=KeyboardAddress

str r0,[r1]

```

8、如果我们没有键盘地址,这里就没有其它活要做了。

```

teq r0,#0

beq return$

mov kbd,r0

```

9、循环查询全部按键,在 `KeyboardOldDown` 保存下来。如果我们询问的太多了,返回 0 也是正确的。

```

saveKeys$:

mov r0,kbd

mov r1,r5

bl KeyboardGetKeyDown

ldr r1,=KeyboardOldDown

add r1,r5,lsl #1

strh r0,[r1]

add r5,#1

cmp r5,#6

blt saveKeys$

```

10、现在我们得到了新的按键。

```

mov r0,kbd

bl KeyboardPoll

```

11、最后我们要检查 `KeyboardOldDown` 是否工作了。如果没工作,那么我们可能是断开连接了。

```

teq r0,#0

bne getKeyboard$

return$:

pop {r4,r5,pc}

.unreq kbd

```

有了我们新的 `KeyboardUpdate` 方法,检查输入变得简单,固定周期调用这个方法就行,而它甚至可以检查键盘是否断开连接,等等。这是一个有用的方法,因为我们实际的按键处理会根据条件不同而有所差别,所以能够用一个函数调以它的原始方式获取当前的输入是可行的。下一个方法我们希望它是 `KeyboardGetChar`,简单的返回下一个按下的按钮的 ASCII 字符,或者如果没有按键按下就返回 0。这可以扩展到支持如果它按下一个特定时间当做多次按下按键,也支持锁定键和修饰键。

如果我们有一个 `KeyWasDown` 方法可以使这个方法有用起来,如果给定的扫描代码不在 `KeyboardOldDown` 值中,它只返回 0,否则返回一个非零值。你可以自己尝试一下。与往常一样,可以在下载页面找到解决方案。

### 7、查找表

`KeyboardGetChar` 方法如果写得不好,可能会非常复杂。有 100 多种扫描码,每种代码都有不同的效果,这取决于 shift 键或其他修饰符的存在与否。并不是所有的键都可以转换成一个字符。对于一些字符,多个键可以生成相同的字符。在有如此多可能性的情况下,一个有用的技巧是查找表。查找表与物理意义上的查找表非常相似,它是一个值及其结果的表。对于一些有限的函数,推导出答案的最简单方法就是预先计算每个答案,然后通过检索返回正确的答案。在这种情况下,我们可以在内存中建立一个序列的值,序列中第 n 个值就是扫描代码 n 的 ASCII 字符代码。这意味着如果一个键被按下,我们的方法只需要检测到,然后从表中检索它的值。此外,我们可以为当按住 shift 键时的值单独创建一个表,这样按下 shift 键就可以简单地换个我们用的表。

>

> 在编程的许多领域,程序越大,速度越快。查找表很大,但是速度很快。有些问题可以通过查找表和普通函数的组合来解决。

>

>

>

在 `.section .data` 命令之后,复制下面的表:

```

.align 3

KeysNormal:

.byte 0x0, 0x0, 0x0, 0x0, 'a', 'b', 'c', 'd'

.byte 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l'

.byte 'm', 'n', 'o', 'p', 'q', 'r', 's', 't'

.byte 'u', 'v', 'w', 'x', 'y', 'z', '1', '2'

.byte '3', '4', '5', '6', '7', '8', '9', '0'

.byte '\n', 0x0, '\b', '\t', ' ', '-', '=', '['

.byte ']', '\\\', '#', ';', '\'', '`', ',', '.'

.byte '/', 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, '/', '*', '-', '+'

.byte '\n', '1', '2', '3', '4', '5', '6', '7'

.byte '8', '9', '0', '.', '\\\', 0x0, 0x0, '='

.align 3

KeysShift:

.byte 0x0, 0x0, 0x0, 0x0, 'A', 'B', 'C', 'D'

.byte 'E', 'F', 'G', 'H', 'I', 'J', 'K', 'L'

.byte 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T'

.byte 'U', 'V', 'W', 'X', 'Y', 'Z', '!', '"'

.byte '£', '$', '%', '^', '&', '*', '(', ')'

.byte '\n', 0x0, '\b', '\t', ' ', '_', '+', '{'

.byte '}', '|', '~', ':', '@', '¬', '<', '>'

.byte '?', 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, '/', '*', '-', '+'

.byte '\n', '1', '2', '3', '4', '5', '6', '7'

.byte '8', '9', '0', '.', '|', 0x0, 0x0, '='

```

这些表直接将前 104 个扫描码映射到 ASCII 字符作为一个字节表。我们还有一个单独的表来描述 `shift` 键对这些扫描码的影响。我使用 ASCII `null` 字符(`0`)表示所有没有直接映射的 ASCII 键(例如功能键)。退格映射到 ASCII 退格字符(8 表示 `\b`),`enter` 映射到 ASCII 新行字符(10 表示 `\n`), `tab` 映射到 ASCII 水平制表符(9 表示 `\t`)。

>

> `.byte num` 直接插入字节常量 num 到文件。

>

>

>

.

>

> 大部分的汇编器和编译器识别转义序列;如 `\t` 这样的字符序列会插入该特殊字符。

>

>

>

`KeyboardGetChar` 方法需要做以下工作:

1. 检查 `KeyboardAddress` 是否返回 `0`。如果是,则返回 0。

2. 调用 `KeyboardGetKeyDown` 最多 6 次。每次:

1. 如果按键是 0,跳出循环。

2. 调用 `KeyWasDown`。 如果返回是,处理下一个按键。

3. 如果扫描码超过 103,进入下一个按键。

4. 调用 `KeyboardGetModifiers`

5. 如果 `shift` 是被按着的,就加载 `KeysShift` 的地址,否则加载 `KeysNormal` 的地址。

6. 从表中读出 ASCII 码值。

7. 如果是 0,进行下一个按键,否则返回 ASCII 码值并退出。

3. 返回 0。

试着自己实现。我的实现展示在下面:

1、简单的检查我们是否有键盘。

```

.globl KeyboardGetChar

KeyboardGetChar:

ldr r0,=KeyboardAddress

ldr r1,[r0]

teq r1,#0

moveq r0,#0

moveq pc,lr

```

2、`r5` 将会保存按键的索引,`r4` 保存键盘的地址。

```

push {r4,r5,r6,lr}

kbd .req r4

key .req r6

mov r4,r1

mov r5,#0

keyLoop$:

mov r0,kbd

mov r1,r5

bl KeyboardGetKeyDown

```

2.1、 如果扫描码是 0,它要么意味着有错,要么说明没有更多按键了。

```

teq r0,#0

beq keyLoopBreak$

```

2.2、如果按键已经按下了,那么他就没意义了,我们只想知道按下的按键。

```

mov key,r0

bl KeyWasDown

teq r0,#0

bne keyLoopContinue$

```

2.3、如果一个按键有个超过 104 的扫描码,它将会超出我们的表,所以它是无关的按键。

```

cmp key,#104

bge keyLoopContinue$

```

2.4、我们需要知道修饰键来推断字符。

```

mov r0,kbd

bl KeyboardGetModifiers

```

2.5、当将字符更改为其 shift 变体时,我们要同时检测左 `shift` 键和右 `shift` 键。记住,`tst` 指令计算的是逻辑和,然后将其与 0 进行比较,所以当且仅当移位位都为 0 时,它才等于 0。

```

tst r0,#0b00100010

ldreq r0,=KeysNormal

ldrne r0,=KeysShift

```

2.6、现在我们可以从查找表加载按键了。

```

ldrb r0,[r0,key]

```

2.7、如果查找码包含一个 0,我们必须继续。为了继续,我们要增加索引,并检查是否到 6 次了。

```

teq r0,#0

bne keyboardGetCharReturn$

keyLoopContinue$:

add r5,#1

cmp r5,#6

blt keyLoop$

```

3、在这里我们返回我们的按键,如果我们到达 `keyLoopBreak$` ,然后我们就知道这里没有按键被握住,所以返回 0。

```

keyLoopBreak$:

mov r0,#0

keyboardGetCharReturn$:

pop {r4,r5,r6,pc}

.unreq kbd

.unreq key

```

### 8、记事本操作系统

现在我们有了 `KeyboardGetChar` 方法,可以创建一个操作系统,只打印出用户对着屏幕所写的内容。为了简单起见,我们将忽略所有非常规的键。在 `main.s`,删除 `bl SetGraphicsAddress` 之后的所有代码。调用 `UsbInitialise`,将 `r4` 和 `r5` 设置为 0,然后循环执行以下命令:

1. 调用 `KeyboardUpdate`

2. 调用 `KeyboardGetChar`

3. 如果返回 0,跳转到步骤 1

4. 复制 `r4` 和 `r5` 到 `r1` 和 `r2` ,然后调用 `DrawCharacter`

5. 把 `r0` 加到 `r4`

6. 如果 `r4` 是 1024,将 `r1` 加到 `r5`,然后设置 `r4` 为 0。

7. 如果 `r5` 是 768,设置 `r5` 为0

8. 跳转到步骤 1

现在编译,然后在树莓派上测试。你几乎可以立即开始在屏幕上输入文本。如果没有工作,请参阅我们的故障排除页面。

当它工作时,祝贺你,你已经实现了与计算机的接口。现在你应该开始意识到,你几乎已经拥有了一个原始的操作系统。现在,你可以与计算机交互、发出命令,并在屏幕上接收反馈。在下一篇教程[输入02](https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/input02.html)中,我们将研究如何生成一个全文本终端,用户在其中输入命令,然后计算机执行这些命令。

---

via: <https://www.cl.cam.ac.uk/projects/raspberrypi/tutorials/os/input01.html>

作者:[Alex Chadwick](https://www.cl.cam.ac.uk) 选题:[lujun9972](https://github.com/lujun9972) 译者:[ezio](https://github.com/oska874) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | Raspberry Pi

# Lesson 10 Input01

Welcome to the Input lesson series. In this series, you will learn how to receive inputs to the Raspberry Pi using the keyboard. We will start with just revealing the input, and then move to a more traditional text prompt.

This first input lesson teaches some theory about drivers and linking, as well as about keyboards and ends up displaying text on the screen.

Contents |

## 1 Getting Started

It is expected that you have completed the OK series, and it would be helpful to

have completed the Screen series. Many of the files from that series will be called,

without comment. If you do not have these files, or prefer to use a correct implementation,

download the template for this lesson from the [Downloads](downloads.html)

page. If you're using your own implementation, please remove everything after your

call to SetGraphicsAddress.

## 2 USB

The USB standard was designed to make simple hardware in exchange for complex software.

As you are no doubt aware, the Raspberry Pi model B has two USB ports, commonly used for connecting a mouse and keyboard. This was a very good design decision, USB is a very generic connector, and many different kinds of device use it. It's simple to build new devices for, simple to write device drivers for, and is highly extensible thanks to USB hubs. Could it get any better? Well, no, in fact for an Operating Systems developer this is our worst nightmare. The USB standard is huge. I really mean it this time, it is over 700 pages, before you've even thought about connecting a device.

I spoke to a number of other hobbyist Operating Systems developers about this and they all say one thing: don't bother. "It will take too long to implement", "You won't be able to write a tutorial on it" and "It will be of little benefit". In many ways they are right, I'm not able to write a tutorial on the USB standard, as it would take weeks. I also can't teach how to write device drivers for all the different devices, so it is useless on its own. However, I can do the next best thing: Get a working USB driver, get a keyboard driver, and then teach how to use these in an Operating System. I set out searching for a free driver that would run in an operating system that doesn't even know what a file is yet, but I couldn't find one. They were all too high level. So, I attempted to write one. Everybody was right, this took weeks to do. However, I'm pleased to say I did get one that works with no external help from the Operating System, and can talk to a mouse and keyboard. It is by no means complete, efficient, or correct, but it does work. It has been written in C and the full source code can be found on the downloads page for those interested.

So, this tutorial won't be a lesson on the USB standard (at all). Instead we'll look at how to work with other people's code.

## 3 Linking

Linking allows us to make reusable code 'libraries' that anyone can use in their program.

Since we're about to incorporate external code into the Operating System, we need to talk about linking. Linking is a process which is applied to programs or Operating System to link in functions. What this means is that when a program is made, we don't necessarily code every function (almost certainly not in fact). Linking is what we do to make our program link to functions in other people's code. This has actually been going on all along in our Operating Systems, as the linker links together all of the different files, each of which is compiled separately.

Programs often just call libraries, which call other libraries and so on until eventually they call an Operating System library which we would write.

There are two types of linking: static and dynamic. Static linking is like what goes on when we make our Operating Systems. The linker finds all the addresses of the functions, and writes them into the code, before the program is finished. Dynamic linking is linking that occurs after the program is 'complete'. When it is loaded, the dynamic linker goes through the program and links any functions which are not in the program to libraries in the Operating System. This is one of the jobs our Operating System should eventually be capable of, but for now everything will be statically linked.

The USB driver I have written is suitable for static linking. This means I give

you the compiled code for each of my files, and then the linker finds functions

in your code which are not defined in your code, and links them to functions in

my code. On the [Downloads](downloads.html) page for this lesson is a

makefile and my USB driver, which you will need to continue. Download them and replace

the makefile in your code with this one, and also put the driver in the same folder

as that makefile.

## 4 Keyboards

In order to get input into our Operating System, we need to understand at some level how keyboards actually work. Keyboards have two types of keys: Normal and Modifier keys. The normal keys are the letters, numbers, function keys, etc. They constitute almost every key on the keyboard. The modifiers are up to 8 special keys. These are left shift, right shift, left control, right control, left alt, right alt, left GUI and right GUI. The keyboard can detect any combination of the modifier keys being held, as well as up to 6 normal keys. Every time a key changes (i.e. is pushed or released), it reports this to the computer. Typically, keyboards also have three LEDs for Caps Lock, Num Lock and Scroll Lock, which are controlled by the computer, not the keyboard itself. Keyboards may have many more lights such as power, mute, etc.

In order to help standardise USB keyboards, a table of values was produced, such that every keyboard key ever is given a unique number, as well as every conceivable LED. The table below lists the first 126 of values.

Number | Description | Number | Description | Number | Description | Number | Description |

---|---|---|---|---|---|---|---|

4 | a and A | 5 | b and B | 6 | c and C | 7 | d and D |

8 | e and E | 9 | f and F | 10 | g and G | 11 | h and H |

12 | i and I | 13 | j and J | 14 | k and K | 15 | l and L |

16 | m and M | 17 | n and N | 18 | o and O | 19 | p and P |

20 | q and Q | 21 | r and R | 22 | s and S | 23 | t and T |

24 | u and U | 25 | v and V | 26 | w and W | 27 | x and X |

28 | y and Y | 29 | z and Z | 30 | 1 and ! | 31 | 2 and @ |

32 | 3 and # | 33 | 4 and $ | 34 | 5 and % | 35 | 6 and ^ |

36 | 7 and & | 37 | 8 and * | 38 | 9 and ( | 39 | 0 and ) |

40 | Return (Enter) | 41 | Escape | 42 | Delete (Backspace) | 43 | Tab |

44 | Spacebar | 45 | - and _ | 46 | = and + | 47 | [ and { |

48 | ] and } | 49 | \ and | | 50 | # and ~ | 51 | ; and : |

52 | ' and " | 53 | ` and ~ | 54 | , and < | 55 | . and > |

56 | / and ? | 57 | Caps Lock | 58 | F1 | 59 | F2 |

60 | F3 | 61 | F4 | 62 | F5 | 63 | F6 |

64 | F7 | 65 | F8 | 66 | F9 | 67 | F10 |

68 | F11 | 69 | F12 | 70 | Print Screen | 71 | Scroll Lock |

72 | Pause | 73 | Insert | 74 | Home | 75 | Page Up |

76 | Delete forward | 77 | End | 78 | Page Down | 79 | Right Arrow |

80 | Left Arrow | 81 | Down Arrow | 82 | Up Arrow | 83 | Num Lock |

84 | Keypad / | 85 | Keypad * | 86 | Keypad - | 87 | Keypad + |

88 | Keypad Enter | 89 | Keypad 1 and End | 90 | Keypad 2 and Down Arrow | 91 | Keypad 3 and Page Down |

92 | Keypad 4 and Left Arrow | 93 | Keypad 5 | 94 | Keypad 6 and Right Arrow | 95 | Keypad 7 and Home |

96 | Keypad 8 and Up Arrow | 97 | Keypad 9 and Page Up | 98 | Keypad 0 and Insert | 99 | Keypad . and Delete |

100 | \ and | | 101 | Application | 102 | Power | 103 | Keypad = |

104 | F13 | 105 | F14 | 106 | F15 | 107 | F16 |

108 | F17 | 109 | F18 | 110 | F19 | 111 | F20 |

112 | F21 | 113 | F22 | 114 | F23 | 115 | F24 |

116 | Execute | 117 | Help | 118 | Menu | 119 | Select |

120 | Stop | 121 | Again | 122 | Undo | 123 | Cut |

124 | Copy | 125 | Paste | 126 | Find | 127 | Mute |

128 | Volume Up | 129 | Volume Down |

The full list can be found in section 10, page 53 of [

HID Usage Tables 1.12](downloads/hut1_12v2.pdf).

## 5 The Nut Behind the Wheel

These summaries and the code they describe form an API - Application Product Interface.

Normally, when you work with someone else's code, they provide a summary of their methods, what they do and roughly how they work, as well as how they can go wrong. Here is a table of the relevant instructions required to use my USB driver.

Function | Arguments | Returns | Description |

---|---|---|---|

UsbInitialise | None | r0 is result code | This method is the all-in-one method that loads the USB driver, enumerates all devices and attempts to communicate with them. This method generally takes about a second to execute, though with a few USB hubs plugged in this can be significantly longer. After this method is completed methods in the keyboard driver become available, regardless of whether or not a keyboard is indeed inserted. Result code explained below. |

UsbCheckForChange | None | None | Essentially provides the same effect as UsbInitialise, but does not provide the same one time initialisation. This method checks every port on every connected hub recursively, and adds new devices if they have been added. This should be very quick if there are no changes, but can take up to a few seconds if a hub with many devices is attached. |

KeyboardCount | None | r0 is count | Returns the number of keyboards currently connected and detected. UsbCheckForChange may update this. Up to 4 keyboards are supported by default. Up to this many keyboards may be accessed through this driver. |

KeyboardGetAddress | r0 is index | r0 is address | Retrieves the address of a given keyboard. All other functions take a keyboard address in order to know which keyboard to access. Thus, to communicate with a keyboard, first check the count, then retrieve the address, then use other methods. Note, the order of keyboards that this method returns may change after calls to UsbCheckForChange. |

KeyboardPoll | r0 is address | r0 is result code | Reads in the current key state from the keyboard. This operates via polling the device directly, contrary to the best practice. This means that if this method is not called frequently enough, a key press could be missed. All reading methods simply return the value as of the last poll. |

KeyboardGetModifiers | r0 is address | r0 is modifier state | Retrieves the status of the modifier keys as of the last poll. These are the shift, alt control and GUI keys on both sides. This is returned as a bit field, such that a 1 in the bit 0 means left control is held, bit 1 means left shift, bit 2 means left alt, bit 3 means left GUI and bits 4 to 7 mean the right versions of those previous. If there is a problem r0 contains 0. |

KeyboardGetKeyDownCount | r0 is address | r0 is count | Retrieves the number of keys currently held down on the keyboard. This excludes modifier keys. Normally, this cannot go above 6. If there is an error this method returns 0. |

KeyboardGetKeyDown | r0 is address, r1 is key number | r0 is scan code | Retrieves the scan code (see Table 4.1) of a particular held down key. Normally, to work out which keys are down, call KeyboardGetKeyDownCount and then call KeyboardGetKeyDown up to that many times with increasing values of r1 to determine which keys are down. Returns 0 if there is a problem. It is safe (but not recommended) to call this method without calling KeyboardGetKeyDownCount and interpret 0s as keys not held. Note, the order or scan codes can change randomly (some keyboards sort numerically, some sort temporally, no guarantees are made). |

KeyboardGetKeyIsDown | r0 is address, r1 is scan code | r0 is status | Alternative to KeyboardGetKeyDown, checks if a particular scan code is among the held down keys. Returns 0 if not, or a non-zero value if so. Faster when detecting particular scan codes (e.g. looking for ctrl+c). On error, returns 0. |

KeyboardGetLedSupport | r0 is address | r0 is LEDs | Checks which LEDs a particular keyboard supports. Bit 0 being 1 represents Number Lock, bit 1 represents Caps Lock, bit 2 represents Scroll Lock, bit 3 represents Compose, bit 4 represents Kana, bit 5 represents Power, bit 6 represents Mute and bit 7 represents Compose. As per the USB standard, none of these LEDs update automatically (e.g. Caps Lock must be set manually when the Caps Lock scan code is detected). |

KeyboardSetLeds | r0 is address, r1 is LEDs | r0 is result code | Attempts to turn on/off the specified LEDs on the keyboard. See below for result code values. See KeyboardGetLedSupport for LEDs' values. |

Result codes are an easy way to handle errors, but often more elegant solutions exist in higher level code.

Several methods return 'result codes'. These are commonplace in C code, and are just numbers which represent what happened in a method call. By convention, 0 always indicates success. The following result codes are used by this driver.

Code | Description |

---|---|

0 | Method completed successfully. |

-2 | Argument: A method was called with an invalid argument. |

-4 | Device: The device did not respond correctly to the request. |

-5 | Incompatible: The driver is not compatible with this request or device. |

-6 | Compiler: The driver was compiled incorrectly, and is broken. |

-7 | Memory: The driver ran out of memory. |

-8 | Timeout: The device did not respond in the expected time. |

-9 | Disconnect: The device requested has disconnected, and cannot be used. |

The general usage of the driver is as follows:

- Call UsbInitialise

- Call UsbCheckForChange

- Call KeyboardCount

- If this is 0, go to 2.

- For each keyboard you support:

- Call KeyboardGetAddress

- Call KeybordGetKeyDownCount

- For each key down:

- Check whether or not it has just been pushed

- Store that the key is down

- For each key stored:

- Check whether or not key is released

- Remove key if released

- Perform actions based on keys pushed/released

- Go to 2.

Ultimately, you may do whatever you wish to with the keyboard, and these methods should allow you to access all of its functionality. Over the next 2 lessons, we shall look at completing the input side of a text terminal, similarly to most command line computers, and interpreting the commands. In order to do this, we're going to need to have keyboard inputs in a more useful form. You may notice that my driver is (deliberately) unhelpful, because it doesn't have methods to deduce whether or not a key has just been pushed down or released, it only has methods about what is currently held down. This means we'll need to write such methods ourselves.

## 6 Updates Available

Repeatedly checking for updates is called 'polling'. This is in contrast to interrupt driven IO, where the device sends a signal when data is ready.

First of all, let's implement a method KeyboardUpdate which detects the first keyboard and uses its poll method to get the current input, as well as saving the last inputs for comparison. We can then use this data with other methods to translate scan codes to keys. The method should do precisely the following:

- Retrieve a stored keyboard address (initially 0).

- If this is not 0, go to 9.

- Call UsbCheckForChange to detect new keyboards.

- Call KeyboardCount to detect how many keyboards are present.

- If this is 0 store the address as 0 and return; we can't do anything with no keyboard.

- Call KeyboardGetAddress with parameter 0 to get the first keyboard's address.

- Store this address.

- If this is 0, return; there is some problem.

- Call KeyboardGetKeyDown 6 times to get each key currently down and store them

- Call KeyboardPoll

- If the result is non-zero go to 3. There is some problem (such as disconnected keyboard).

To store the values mentioned above, we will need the following values in the .data section.

.section .data

.align 2

KeyboardAddress:

.int 0

KeyboardOldDown:

.rept 6

.hword 0

.endr

.hword num inserts the half word constant num into the file directly.

.rept num [commands] .endr copies the commands commands to the output num times.

Try to implement the method yourself. My implementation for this is as follows:

-

.section .text

.globl KeyboardUpdate

KeyboardUpdate:

push {r4,r5,lr}

kbd .req r4

ldr r0,=KeyboardAddress

ldr kbd,[r0]

-

teq kbd,#0

bne haveKeyboard$

-

getKeyboard$:

bl UsbCheckForChange

-

bl KeyboardCount

-

teq r0,#0

ldreq r1,=KeyboardAddress

streq r0,[r1]

beq return$

-

mov r0,#0

bl KeyboardGetAddress

-

ldr r1,=KeyboardAddress

str r0,[r1]

-

teq r0,#0

beq return$

mov kbd,r0

-

saveKeys$:

mov r0,kbd

mov r1,r5

bl KeyboardGetKeyDown

ldr r1,=KeyboardOldDown

add r1,r5,lsl #1

strh r0,[r1]

add r5,#1

cmp r5,#6

blt saveKeys$

-

mov r0,kbd

bl KeyboardPoll

-

teq r0,#0

bne getKeyboard$

return$:

pop {r4,r5,pc}

.unreq kbd

With our new KeyboardUpdate method, checking for inputs becomes as simple as calling this method at regular intervals, and it will even check for disconnections etc. This is a useful method to have, as our actual key processing may differ based on the situation, and so being able to get the current input in its raw form with one method call is generally applicable. The next method we ideally want is KeyboardGetChar, a method that simply returns the next key pressed as an ASCII character, or returns 0 if no key has just been pressed. This could be extended to support typing a key multiple times if it is held for a certain duration, and to support the 'lock' keys as well as modifiers.

To make this method it is useful if we have a method KeyWasDown, which simply returns 0 if a given scan code is not in the KeyboardOldDown values, and returns a non-zero value otherwise. Have a go at implementing this yourself. As always, a solution can be found on the downloads page.

## 7 Look Up Tables

In many areas of programming, the larger the program, the faster it is. Look up tables are large, but are very fast. Some problems can be solved by a mixture of look up tables and normal functions.

The KeyboardGetChar method could be quite complex if we write it poorly. There are 100s of scan codes, each with different effects depending on the presence or absence of the shift key or other modifiers. Not all of the keys can be translated to a character. For some characters, multiple keys can produce the same character. A useful trick in situations with such vast arrays of possibilities is look up tables. A look up table, much like in the physical sense, is a table of values and their results. For some limited functions, the simplest way to deduce the answer is just to precompute every answer, and just return the correct one by retrieving it. In this case, we could build up a sequence of values in memory such that the nth value into the sequence is the ASCII character code for the scan code n. This means our method would simply have to detect if a key was pressed, and then retrieve its value from the table. Further, we could have a separate table for the values when shift is held, so that the shift key simply changes which table we're working with.

After the .section .data command, copy the following tables:

.align 3

KeysNormal:

.byte 0x0, 0x0, 0x0, 0x0, 'a', 'b', 'c', 'd'

.byte 'e', 'f', 'g', 'h', 'i', 'j', 'k', 'l'

.byte 'm', 'n', 'o', 'p', 'q', 'r', 's', 't'

.byte 'u', 'v', 'w', 'x', 'y', 'z', '1', '2'

.byte '3', '4', '5', '6', '7', '8', '9', '0'

.byte '\n', 0x0, '\b', '\t', ' ', '-', '=', '['

.byte ']', '\\', '#', ';', '\'', '`', ',', '.'

.byte '/', 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, '/', '*', '-', '+'

.byte '\n', '1', '2', '3', '4', '5', '6', '7'

.byte '8', '9', '0', '.', '\\', 0x0, 0x0, '='

.align 3

KeysShift:

.byte 0x0, 0x0, 0x0, 0x0, 'A', 'B', 'C', 'D'

.byte 'E', 'F', 'G', 'H', 'I', 'J', 'K', 'L'

.byte 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T'

.byte 'U', 'V', 'W', 'X', 'Y', 'Z', '!', '"'

.byte '£', '$', '%', '^', '&', '*', '(', ')'

.byte '\n', 0x0, '\b', '\t', ' ', '_', '+', '{'

.byte '}', '|', '~', ':', '@', '¬', '<', '>'

.byte '?', 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0, 0x0

.byte 0x0, 0x0, 0x0, 0x0, '/', '*', '-', '+'

.byte '\n', '1', '2', '3', '4', '5', '6', '7'

.byte '8', '9', '0', '.', '|', 0x0, 0x0, '='

.byte num inserts the byte constant num into the file directly.

Most assemblers and compilers recognise escape sequences; character sequences such as \t which insert special characters instead.

These tables map directly the first 104 scan codes onto the ASCII characters as a table of bytes. We also have a separate table describing the effects of the shift key on those scan codes. I've used the ASCII null character (0) for all keys without direct mappings in ASCII (such as the function keys). Backspace is mapped to the ASCII backspace character (8 denoted \b), enter is mapped to the ASCII new line character (10 denoted \n) and tab is mapped to the ASCII horizontal tab character (9 denoted \t).

The KeyboardGetChar method will need to do the following:

- Check if KeyboardAddress is 0. If so, return 0.

- Call KeyboardGetKeyDown up to 6 times. Each time:

- If key is 0, exit loop.

- Call KeyWasDown. If it was, go to the next key.

- If the scan code is more than 103, go to the next key.

- Call KeyboardGetModifiers

- If shift is held, load the address of KeysShift. Otherwise load KeysNormal.

- Read the ASCII value from the table.

- If it is 0, go to the next key otherwise return this ASCII code and exit.

- Return 0.

Try to implement this yourself. My implementation is presented below:

-

.globl KeyboardGetChar

KeyboardGetChar:

ldr r0,=KeyboardAddress

ldr r1,[r0]

teq r1,#0

moveq r0,#0

moveq pc,lr

Simple check to see if we have a keyboard.

-

push {r4,r5,r6,lr}

kbd .req r4

key .req r6

mov r4,r1

mov r5,#0

keyLoop$:mov r0,kbd

mov r1,r5

bl KeyboardGetKeyDownr5 will hold the index of the key, r4 holds the keyboard address.

-

teq r0,#0

beq keyLoopBreak$

If a scan code is 0, it either means there is an error, or there are no more keys.

-

mov key,r0

bl KeyWasDown

teq r0,#0

bne keyLoopContinue$

If a key was already down it is uninteresting, we only want ot know about key presses.

-

cmp key,#104

bge keyLoopContinue$

If a key has a scan code higher than 104, it will be outside our table, and so is not relevant.

-

mov r0,kbd

bl KeyboardGetModifiers

We need to know about the modifier keys in order to deduce the character.

-

tst r0,#0b00100010

ldreq r0,=KeysNormal

ldrne r0,=KeysShift

We detect both a left and right shift key as changing the characters to their shift variants. Remember, a tst instruction computes the logical AND and then compares it to zero, so it will be equal to 0 if and only if both of the shift bits are zero.

-

ldrb r0,[r0,key]

Now we can load in the key from the look up table.

-

teq r0,#0

bne keyboardGetCharReturn$

keyLoopContinue$:

add r5,#1

cmp r5,#6

blt keyLoop$

If the look up code contains a zero, we must continue. To continue, we increment the index, and check if we've reached 6.

-

-

keyLoopBreak$:

mov r0,#0

keyboardGetCharReturn$:

pop {r4,r5,r6,pc}

.unreq kbd

.unreq key

We return our key here, if we reach keyLoopBreak$, then we know there is no key held, so return 0.

## 8 Notepad OS

Now we have our KeyboardGetChar method, we can make an operating system that just types what the user writes to the screen. For simplicity we'll ignore all the unusual keys. In 'main.s' delete all code after bl SetGraphicsAddress. Call UsbInitialise, set r4 and r5 to 0, then loop forever over the following commands:

- Call KeyboardUpdate

- Call KeyboardGetChar

- If it is 0, got to 1

- Copy r4 and r5 to r1 and r2 then call DrawCharacter

- Add r0 to r4

- If r4 is 1024, add r1 to r5 and set r4 to 0

- If r5 is 768 set r5 to 0

- Go to 1

Now compile this and test it on the Pi. You should almost immediately be able to start typing text to the screen when the Pi starts. If not, please see our troubleshooting page.

When it works, congratulations, you've achieved an interface with the computer.

You should now begin to realise that you've almost got a primitive operating system

together. You can now interface with the computer, issuing it commands, and receive

feedback on screen. In the next tutorial, [Input02](input02.html) we

will look at producing a full text terminal, in which the user types commands, and

the computer executes them. |

10,677 | 我的去 Google 化的安卓之旅 | https://lushka.al/my-android-setup/ | 2019-04-02T13:34:56 | [

"安卓",

"Goole"

] | https://linux.cn/article-10677-1.html |

>

> 一篇介绍如何在你的生活中和设备里去 Google 化的文章。

>

>

>

最近人们经常问我有关我手机的事情,比如安卓怎么安装,怎样绕过 Google Service 使用手机。好吧,这篇文章就来详细的解决那些问题。我尽可能让这篇文章适合初学者,因此我会慢慢介绍,一个一个来讲并且附上截图,你就能更好地看到它是怎样运作的。

首先我会告诉你为什么 Google Services(在我看来)对你的设备不好。我可以一言以概之,并让你看 [Richard Stallman](https://en.wikipedia.org/wiki/Richard_Stallman) 写的这篇[文章](https://stallman.org/google.html),但我决定抓住几个要点附在这。

* 要用<ruby> 非自由软件 <rt> Nonfree software </rt></ruby>

+ 大体上,大多数 Google Services 需要运行在非自由的 Javascript 代码之上。现如今,如果禁用掉 Javascript,什么都没有了,甚至 Google 帐号都需要运行非自由软件(由站点发送的 JavaScript),对于登录也是。

* 被监视

+ Google 悄悄地把它的<ruby> 广告跟踪方式 <rt> ad-tracking profiles </rt></ruby>与浏览方式结合在一起,并存储了每个用户的大量数据。

* 服务条款

+ Google 会终止转卖了 Pixel 手机的用户账户。他们无法访问帐户下保存在 Google Services 中的所有邮件和文档。

* 审查

+ Amazon 和 Google 切断了<ruby> 域前置 <rt> domain-fronting </rt></ruby>,该技术能使身处某些国家的人们访问到在那里禁止的通信系统。

+ Google 已经同意为巴基斯坦政府执行特殊的 Youtube 审查,删除对立观点。这将有助于压制异议。

+ Youtube 的“content ID”会自动删除已发布的视频,这并不包含在版权法中。

这只是几个原因,你可以阅读上面我提到的 RMS 的文章,他详细解释了这几点。尽管听起来骇人听闻,但这些行为在现实生活中已经每天在发生。

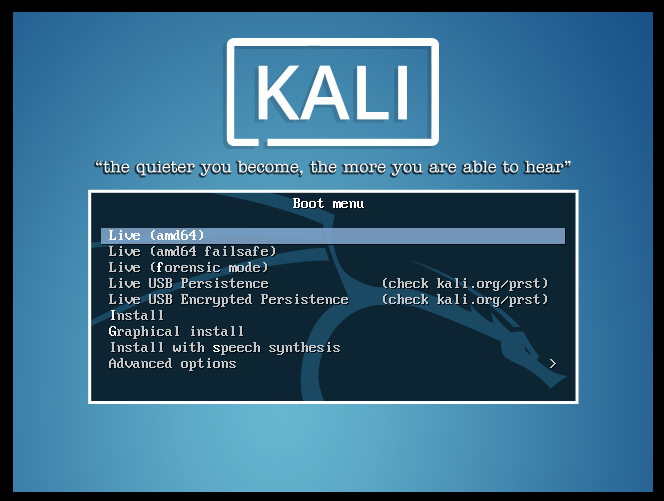

### 下一步,我的搭建教程

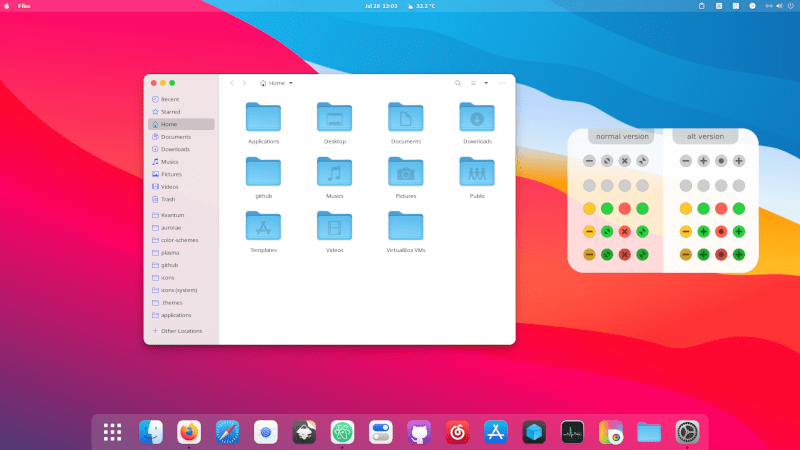

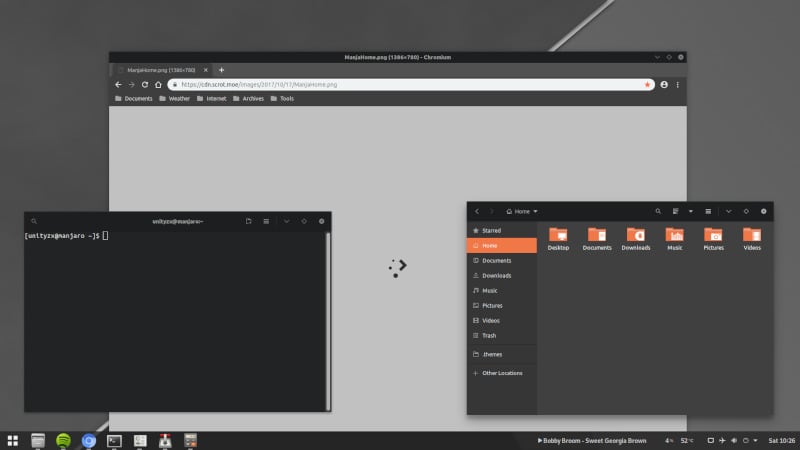

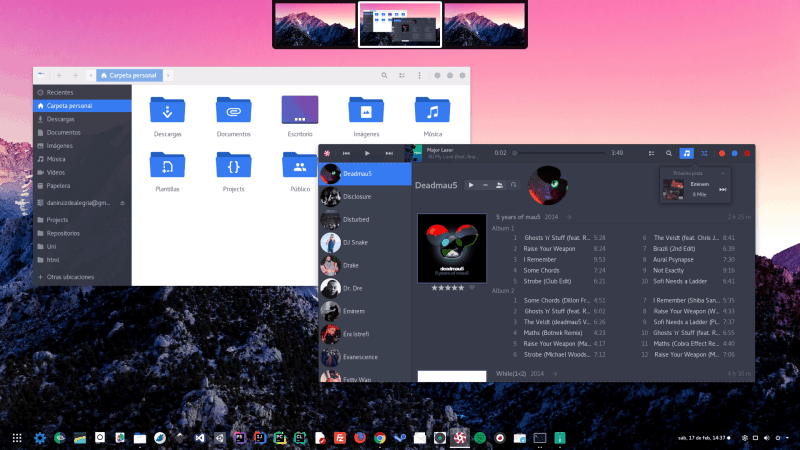

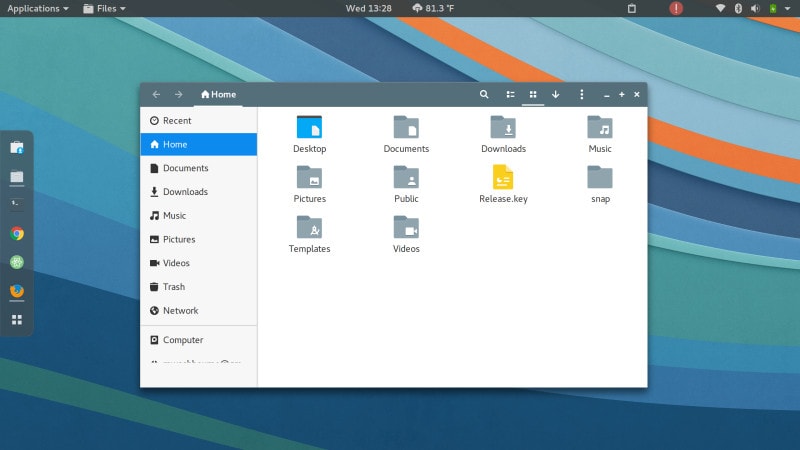

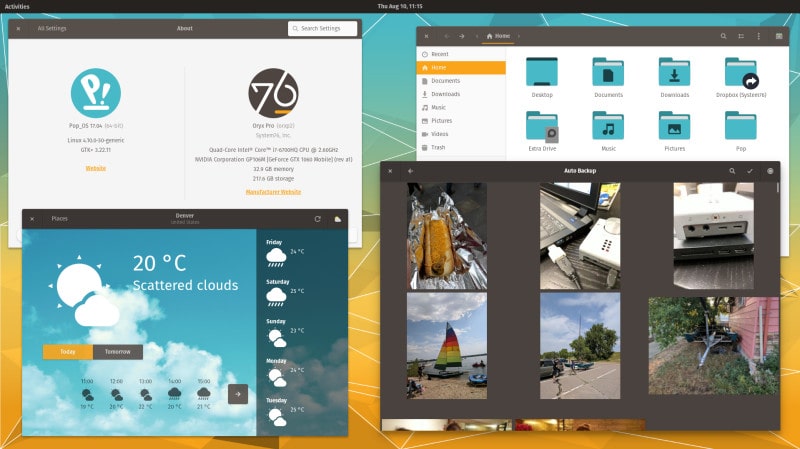

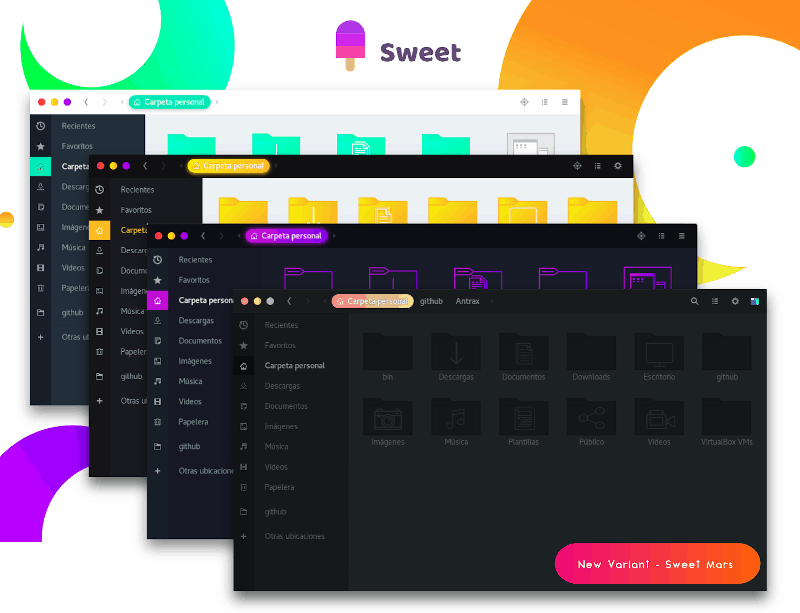

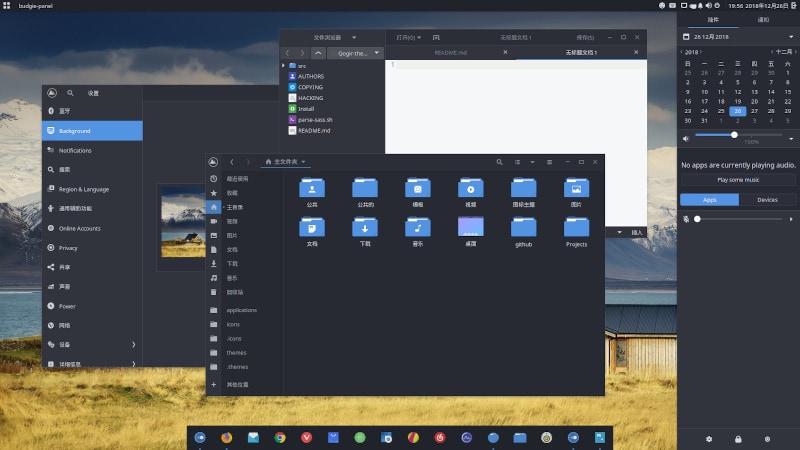

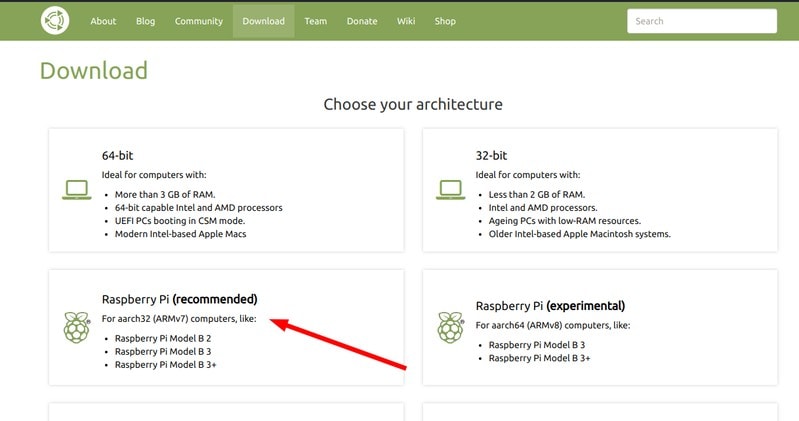

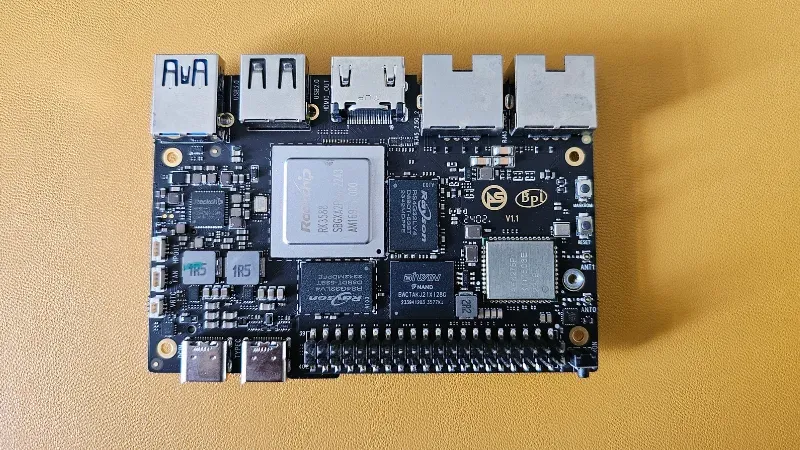

我有一款[小米红米 Note 5 Pro](https://www.gsmarena.com/xiaomi_redmi_note_5_pro-8893.php) 智能手机(代号 whyred),生产于中国的[小米](https://en.wikipedia.org/wiki/Xiaomi)。它是 4 个月之前(距写这篇文章的时候)我花了大约 185 欧元买的。

现在你也许会想,“但你为什么买中国品牌,他们不可靠”。是的,它不是通常你所期望的(品牌)所生产的,例如三星(人们通常会将它和安卓联系在一起,这显然是错的)、一加、诺基亚等。但你应当知道几乎所有的手机都生产于中国。

我选择这款手机有几个原因,首先当然是价格。它是一款<ruby> 性价比 <rt> budget-friendly </rt></ruby>相当高的产品,大多数人都能买得起。下一个原因是说明书上的规格(不仅仅是),在这个<ruby> 价位 <rt> price tag </rt></ruby>上相当合适。拥有 6 英尺屏幕(<ruby> 全高清分辨率 <rt> Full HD resolution </rt></ruby>),4000 毫安电池(一流的电池寿命),4GB RAM,64GB 存储,双后摄像头(12 MP + 5 MP),一个带闪光灯的前摄像头(13 MP)和一个高性能的<ruby> 骁龙 <rt> Snapdragon </rt></ruby> 636,它可能是那时候最好的选择。

随之而来的问题是 [MIUI](https://en.wikipedia.org/wiki/MIUI),大多数小米设备所附带的安卓外壳(除了 Android One 项目设备)。是的,它没有那么可怕,它有一些额外的功能,但问题在更深的地方。小米设备如此便宜(据我所知销售利润仅有 5-10%)的一个原因是**他们在系统里伴随 MIUI 添加了数据挖掘和广告**。这样的话,系统应用需要额外不必要的权限来获取你的数据并且进行广告轰炸,从中获取利润。

更有趣的是,所包含的“天气”应用想要访问我的联系人并且拨打电话,如果它仅是显示天气的话为什么需要访问联系人呢。另一个例子是“录音机”应用,它也需要联系人和网络权限,可能想把录音发送回小米。

为了解决它,我不得不格式化手机并且摆脱 MIUI。在市场上近来的手机上这就变得极为艰难。

格式化手机的想法很简单,删除掉现有的系统然后安装一个新的喜欢的系统(这次是原生安卓)。为了实现它,你先得解锁 [bootloader](https://forum.xda-developers.com/wiki/Bootloader)。

>

> bootloader 是一个在计算机完成自检后为其加载操作系统或者运行环境的计算机程序。—[维基百科](https://en.wikipedia.org/wiki/Booting)

>

>

>

问题是小米关于解锁 bootloader 有明确的政策。几个月之前,流程就像这样:你需向小米[申请](https://en.miui.com/unlock/)解锁代码,并提供真实的原因,但不是每次都成功,因为他们可以拒绝你的请求并且不提供理由。

现在,流程变了。你要从小米那下载一个软件,叫做 [Mi Unlock](http://www.miui.com/unlock/apply.php),在 Windows 电脑上安装它,在手机的[开发者模式中打开调试选项](https://www.youtube.com/watch?v=7zhEsJlivFA),重启到 bootloader 模式(关机状态下长按向下音量键 + 电源键)并将手机连接到电脑上,开始一个叫做“许可”的流程。这个过程会在小米的服务器上启动一个定时器,允许你**在 15 天之后解锁手机**(在一些少数情况下或者一个月,完全随机)。

15 天过去后,重新连接手机并重复之前的步骤,这时候按下解锁键,你的 bootloader 就会解锁,并且能够安装其他 ROM(系统)。**注意,确保你已经备份好了数据,因为解锁 bootloader 会清空手机。**

下一步就是找一个兼容的系统([ROM](https://www.xda-developers.com/what-is-custom-rom-android/))。我在 [XDA 开发者论坛上](https://forum.xda-developers.com/)找了个遍,它是 Android 开发者和用户们交流想法、应用等东西的地方。幸运的是,我的手机相当流行,因此论坛上有它[专门的版块](https://forum.xda-developers.com/redmi-note-5-pro)。在那儿,我略过一些流行的 ROM 并决定使用 [AOSiP ROM](https://forum.xda-developers.com/redmi-note-5-pro/development/rom-aosip-8-1-t3804473)。(AOSiP 代表<ruby> 安卓开源 illusion 项目 <rt> Android Open Source illusion Project </rt></ruby>)

>

> **校订**:有人发邮件告诉我说文章里写的就是[/e/](https://e.foundation)的目的与所做的事情。我想说谢谢你的帮助,但完全不是这样。我关于 /e/ 的看法背后的原因可以见此[网站](https://ewwlo.xyz/evil),但我仍会在此列出一些原因。

>

>

> eelo 是一个从 Kickstarter 和 IndieGoGo 上集资并超过 200K € 的“基金会”,承诺创造一个开放、安全且保护隐私的移动 OS 和网页服务器。

>

>

> 1. 他们的 OS 基于 LineageOS 14.1 (Android 7.1) 且搭载 microG 和其他开源应用,此系统已经存在很长一段时间了并且现在叫做 [Lineage for microG](https://lineage.microg.org/)。

> 2. 所有的应用程序并非从源代码构建,而是从 [APKPure](https://apkpure.com/) 上下载安装包并推送进 ROM,不知道那些安装包中是否包含<ruby> 专有代码 <rt> proprietary code </rt></ruby>或<ruby> 恶意软件 <rt> malware </rt></ruby>。

> 3. 有一段时间,它们就那样随意地从代码中删除 Lineage 的<ruby> 版权标头 <rt> copyright header </rt></ruby>并加入自己的。

> 4. 他们喜欢删除负面反馈并且监视用户 Telegram 群聊中的舆论。

>

>

> 总而言之,我**不建议使用 /e/** ROM。(至少现在)

>

>

>

另一件你有可能要做的事情是获取手机的 [root 权限](https://lifehacker.com/5789397/the-always-up-to-date-guide-to-rooting-any-android-phone),让它真正的成为你的手机,并且修改系统中的文件,例如使用系统范围的 adblocker 等。为了实现它,我决定使用 [Magisk](https://forum.xda-developers.com/apps/magisk/official-magisk-v7-universal-systemless-t3473445),一个天赐的应用,它由一个学生开发,可以帮你获取设备的 root 权限并安装一种叫做[模块](https://forum.xda-developers.com/apps/magisk)的东西,基本上是软件。

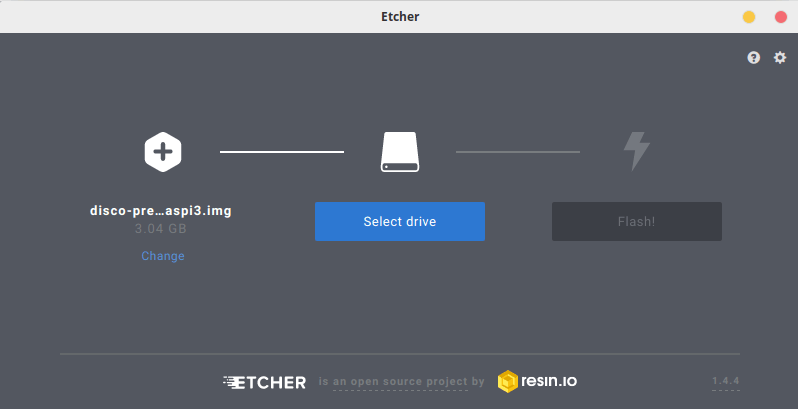

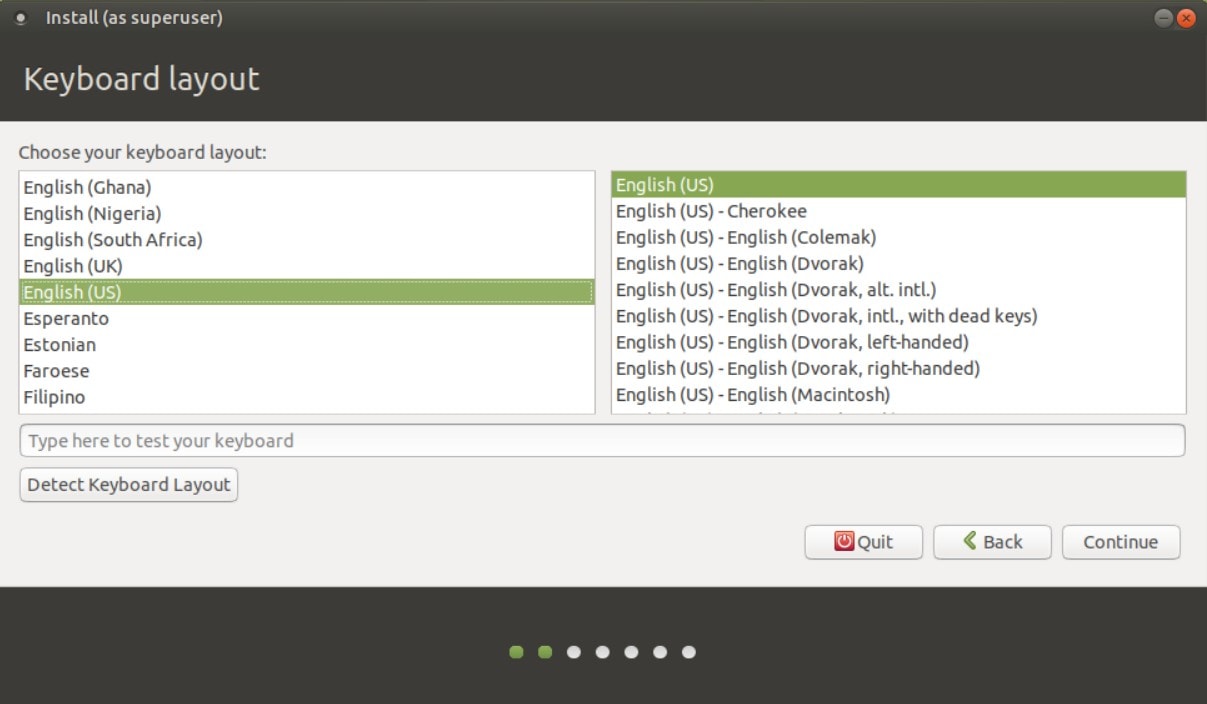

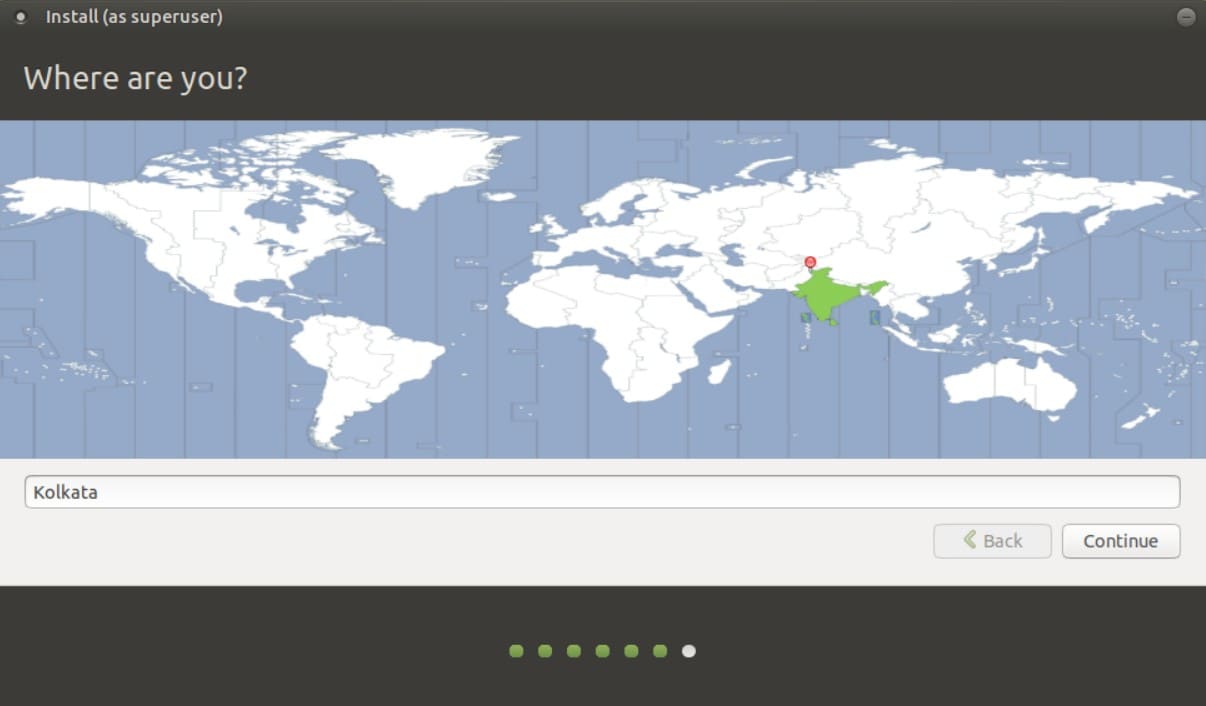

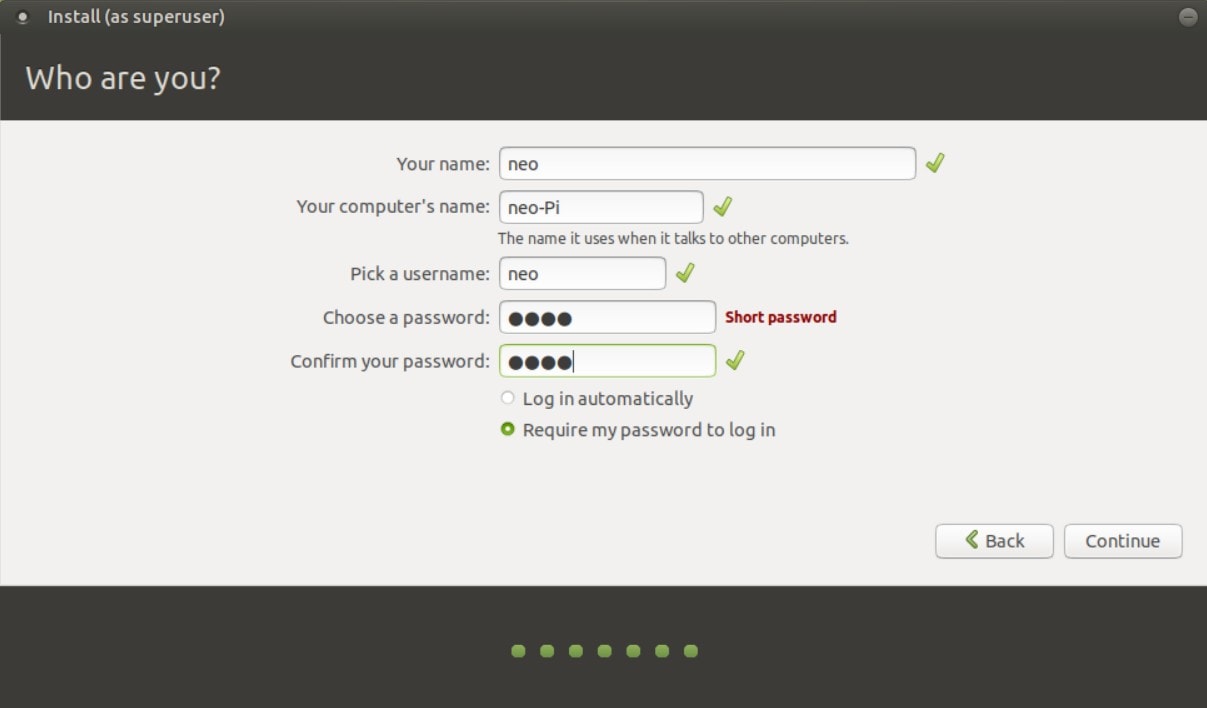

下载 ROM 和 Magisk 之后,我得在手机上安装它们。为了完成安装,我将文件移动到了 SD 卡上。现在,若要安装系统,我需要使用 [恢复系统](http://www.smartmobilephonesolutions.com/content/android-system-recovery)。我用的是较为普遍的 [TWRP](https://dl.twrp.me/whyred/)(代表 TeamWin Recovery Project)。

要安装恢复系统(听起来有点难,我知道),我需要将文件[烧录](https://lifehacker.com/5789397/the-always-up-to-date-guide-to-rooting-any-android-phone)进手机。为了完成烧录,我将手机用一个叫做 [ADB 的工具](https://developer.android.com/studio/command-line/adb)连接上电脑(Fedora Linux 系统)。使用命令让自己定制的恢复系统覆盖掉原先的。

```

fastboot flash recovery twrp.img

```

完成之后,我关掉手机并按住音量上和电源键,直到 TWRP 界面显示。这意味着我进行顺利,并且它已经准备好接收我的指令。

下一步是**发送擦除命令**,在你第一次为手机安装自定义 ROM 时是必要的。如上图所示,擦除命令会清除掉<ruby> 数据 <rt> Data </rt></ruby>,<ruby> 缓存 <rt> Cache </rt></ruby>和 Dalvik 。(这里也有高级选项让我们可以勾选以删除掉系统,如果我们不再需要旧系统的话)

这需要几分钟去完成,之后,你的手机基本上就干净了。现在是时候**安装系统了**。通过按下主屏幕上的安装按钮,我们选择之前添加进的 zip 文件(ROM 文件)并滑动屏幕安装它。下一步,我们需要安装 Magisk,它可以给我们访问设备的 root 权限。

>

> **校订**:一些有经验的安卓用户或发烧友也许注意到了,手机上不包含 [GApps](谷歌应用)。这在安卓世界里称之为 GApps-less,一个 GAps 应用也不安装。

>

>

> 注意有一个不好之处在于若不安装 Google Services 有的应用无法正常工作,例如它们的通知也许会花更长的时间到达或者根本不起作用。(对我来说这一点是最影响应用程序使用的)原因是这些应用使用了 [Google Cloud Messaging](https://developers.google.com/cloud-messaging/)(现在叫做 [Firebase](https://firebase.google.com/docs/cloud-messaging/))唤醒手机并推送通知。

>

>

> 你可以通过安装使用 [microG](https://microg.org/)(部分地)解决它,microG 提供一些 Google Services 的特性且允许你拥有更多的控制。我不建议使用它,因为它仍然有助于 Google Services 并且你不一定信任它。但是,如果你没法<ruby> 立刻放弃使用 <rt> go cold turkey on it </rt> <ruby> ,只想慢慢地退出谷歌,这便是一个好的开始。 </ruby></ruby>

>

>

>

都成功地安装之后,现在我们重启手机,就进入了主屏幕。

### 下一个部分,安装应用并配置一切

事情开始变得简单了。为了安装应用,我使用了 [F-Droid](https://f-droid.org/),一个可替代的应用商店,里面**只包含自由及开源应用**。如果这里没有你要的应用,你可以使用 [Aurora Store](https://f-droid.org/en/packages/com.dragons.aurora/),一个从应用商店里下载应用且不需要使用谷歌帐号或被追踪的客户端。

F-Droid 里面有名为 repos 的东西,它是一个包含你可以安装应用的“仓库”。我使用默认的仓库,并从 [IzzyOnDroid](https://android.izzysoft.de/repo) 添加了另一个,它有更多默认仓库中没有的应用,并且它更新地更频繁。

从下面你可以发现我所安装的应用清单,它们替代的应用与用途。

* [AdAway](https://f-droid.org/en/packages/org.adaway) > 系统广告拦截器,使用 hosts 文件拦截所有的广告

* [AfWall+](https://f-droid.org/en/packages/dev.ukanth.ufirewall) > 一个防火墙,可以阻止不想要的连接

* [Amaze](https://f-droid.org/en/packages/com.amaze.filemanager) > 替代系统的文件管理器,允许文件的 root 访问权限,并且拥有 zip/unzip 功能

* [Ameixa](https://f-droid.org/en/packages/org.xphnx.ameixa) > 大多数应用的图标包

* [andOTP](https://f-droid.org/en/packages/org.shadowice.flocke.andotp) > 替代谷歌验证器/Authy,一个可以用来登录启用了<ruby> 双因子验证 <rt> 2FA </rt></ruby>的网站账户的 TOTP 应用,可以使用 PIN 码备份和锁定

* [AnySoftKeyboard/AOSP Keyboard](https://f-droid.org/packages/com.menny.android.anysoftkeyboard/) > 开源键盘,它有许多主题和语言包,我也是该[项目](https://anysoftkeyboard.github.io/)的一员

* [Audio Recorder](https://f-droid.org/en/packages/com.github.axet.audiorecorder) > 如其名字,允许你从麦克风录制不同格式的音频文件

* [Battery Charge Limit](https://f-droid.org/en/packages/com.slash.batterychargelimit) > 当到 80% 时自动停止充电,降低<ruby> 电池磨损 <rt> battery wear </rt></ruby>并增加寿命

* [DAVx5](https://f-droid.org/en/packages/at.bitfire.davdroid) > 这是我最常用的应用之一,对我来说它基本上替代了谷歌联系人、谷歌日历和谷歌 Tasks,它连接着我的 Nextcloud 环境可以让我完全控制自己的数据

* [Document Viewer](https://f-droid.org/en/packages/org.sufficientlysecure.viewer) > 一个可以打开数百种文件格式的查看器应用,快速、轻量

* [Deezloader Remix](https://gitlab.com/Nick80835/DeezLoader-Android/) > 让我可以在 Deezer 上下载高质量 MP3 的应用

* [Easy xkcd](https://f-droid.org/en/packages/de.tap.easy_xkcd) > xkcd 漫画阅读器,我喜欢这些 xkcd 漫画

* [Etar](https://f-droid.org/en/packages/ws.xsoh.etar) > 日历应用,替代谷歌日历,与 DAVx5 一同工作

* [FastHub-Libre](https://f-droid.org/en/packages/com.fastaccess.github.libre) > 一个 GitHub 客户端,完全 FOSS(自由及开源软件),非常实用如果你像我一样喜欢使用 Github 的话

* [Fennec F-Droid](https://f-droid.org/en/packages/org.mozilla.fennec_fdroid) > 替代谷歌 Chrome 和其他类似的应用,一个为 F-Droid 打造的火狐浏览器,不含专有二进制代码并允许安装扩展提升浏览体验

* [Gadgetbridge](https://f-droid.org/en/packages/nodomain.freeyourgadget.gadgetbridge) > 替代小米运动,可以用来配对小米硬件的应用,追踪你的健康、步数、睡眠等。

* [K-9 Mail](https://f-droid.org/en/packages/com.fsck.k9) > 邮件客户端,替代 GMail 应用,可定制并可以添加多个账户

* [Lawnchair](https://f-droid.org/en/packages/ch.deletescape.lawnchair.plah) > 启动器,可以替代 Nova Launcher 或 Pixel Launcher,允许自定义和各种改变,也支持图标包

* [Mattermost](https://f-droid.org/en/packages/com.mattermost.mattermost) > 可以连接 Mattermost 服务器的应用。Mattermost 是一个 Slack 替代品

* [NewPipe](https://f-droid.org/en/packages/org.schabi.newpipe) > 最好的 YouTube 客户端(我认为),可以替代 YoubTube,它完全是 FOSS,免除 YouTube 广告,占用更少空间,允许背景播放,允许下载视频/音频等。试一试吧

* [Nextcloud SMS](https://f-droid.org/en/packages/fr.unix_experience.owncloud_sms) > 允许备份/同步 SMS 到我的 Nextcloud 环境

* [Nextcloud Notes](https://f-droid.org/en/packages/it.niedermann.owncloud.notes) > 允许我创建,修改,删除,分享笔记并同步/备份到 Nextcloud 环境

* [OpenTasks](https://f-droid.org/en/packages/org.dmfs.tasks) > 允许我创建、修改、删除任务并同步到我的 Nextcloud 环境

* [OsmAnd~](https://f-droid.org/en/packages/net.osmand.plus) > 一个地图应用,使用 [OpenStreetMap](https://openstreetmap.org/),允许下载离线地图和导航

* [QKSMS](https://f-droid.org/en/packages/com.moez.QKSMS) > 我最喜欢的短信应用,可以替代原来的 Messaging 应用,拥有漂亮的界面,拥有备份、个性化、延迟发送等特性。

* [Resplash/Mysplash](https://f-droid.org/en/packages/com.wangdaye.mysplash) > 允许你无限地从 [Unsplash](https://unsplash.com/) 下载无数的漂亮壁纸,全都可以免费使用和修改。

* [ScreenCam](https://f-droid.org/en/packages/com.orpheusdroid.screenrecorder) > 一个录屏工具,允许各样的自定义和录制模式,没有广告并且免费

* [SecScanQR](https://f-droid.org/en/packages/de.t_dankworth.secscanqr) > 二维码识别应用,快速轻量

* [Send Reduced Free](https://f-droid.org/en/packages/mobi.omegacentauri.SendReduced) > 这个应用可以在发送之前通过移除 PII(<ruby> 个人识别信息 <rt> personally identifiable information </rt></ruby>)和减小尺寸,让你立即分享大图

* [Slide](https://f-droid.org/en/packages/me.ccrama.redditslide/) > 开源 Reddit 客户端

* [Telegram FOSS](https://f-droid.org/en/packages/org.telegram.messenger) > 没有追踪和 Google Services 的纯净版 Telegram 安卓客户端

* [TrebleShot](https://f-droid.org/en/packages/com.genonbeta.TrebleShot) > 这个天才般的应用可以让你通过 WIFI 分享文件给其它设备,真的超快,甚至无需连接网络

* [Tusky](https://f-droid.org/en/packages/com.keylesspalace.tusky) > Tusky 是 [Mastodon](https://joinmastodon.org/) 平台的客户端(替代 Twitter)

* [Unit Converter Ultimate](https://f-droid.org/en/packages/com.physphil.android.unitconverterultimate) > 这款应用可以一键在 200 种单位之间来回转换,非常快并且完全离线

* [Vinyl Music Player](https://f-droid.org/en/packages/com.poupa.vinylmusicplayer) > 我首选的音乐播放器,可以替代谷歌音乐播放器或其他你已经安装的音乐播放器,它有漂亮的界面和许多特性

* [VPN Hotspot](https://f-droid.org/en/packages/be.mygod.vpnhotspot) > 这款应用可以让我打开热点的时候分享 VPN,因此我可以在笔记本上什么都不用做就可以安全地浏览网页

这些差不多就是我列出的一张**最实用的 F-Droid 应用**清单,但不巧,这些并不是所有应用。我使用的专有应用如下(我知道,我也许听起来是一个伪君子,但并不是所有的应用都可以替代,至少现在不是):

* Google Camera(与 Camera API 2 结合起来,需要 F-Droid 的基本的 microG 才能工作)

* Instagram

* MyVodafoneAL (运营商应用)

* ProtonMail (email 应用)

* Titanium Backup(备份应用数据,wifi 密码,通话记录等)

* WhatsApp (专有的端到端聊天应用,几乎我认识的所有人都有它)

差不多就是这样,这就是我用的手机上所有的应用。**配置非常简单明了,我可以给几点提示**。

1. 仔细阅读和检查应用的权限,不要无脑地点“安装”。

2. 尽可能多地使用开源应用,它们即尊重你的隐私又是免费的(且自由)。

3. 尽可能地使用 VPN,找一个有名气的,别用免费的,否则你将被收割数据然后成为产品。

4. 不要一直打开 WIFI/移动数据/定位,有可能引起安全隐患。

5. 不要只依赖指纹解锁,或者尽可能只用 PIN/密码/模式解锁,因为生物数据可以被克隆后针对你,例如解锁你的手机盗取你的数据。

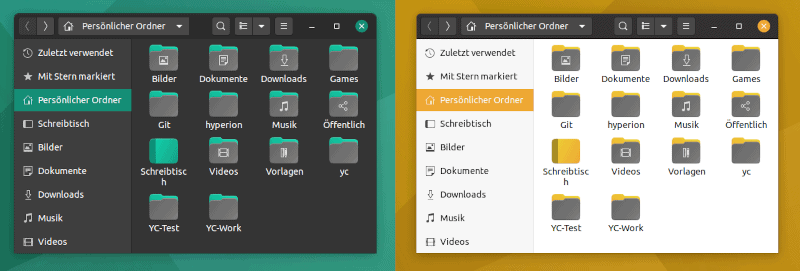

作为坚持读到这儿的奖励,**一张主屏幕的截图奉上。**

---

via: <https://lushka.al/my-android-setup/>

作者:[Anxhelo Lushka](https://lushka.al/) 选题:[lujun9972](https://github.com/lujun9972) 译者:[LuuMing](https://github.com/luuming) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | null |

10,679 | 10 个 Python 图像编辑工具 | https://opensource.com/article/19/3/python-image-manipulation-tools | 2019-04-03T11:39:05 | [

"Python",

"图像"

] | https://linux.cn/article-10679-1.html |

>

> 以下提到的这些 Python 工具在编辑图像、操作图像底层数据方面都提供了简单直接的方法。

>

>

>

当今的世界充满了数据,而图像数据就是其中很重要的一部分。但只有经过处理和分析,提高图像的质量,从中提取出有效地信息,才能利用到这些图像数据。

常见的图像处理操作包括显示图像,基本的图像操作,如裁剪、翻转、旋转;图像的分割、分类、特征提取;图像恢复;以及图像识别等等。Python 作为一种日益风靡的科学编程语言,是这些图像处理操作的最佳选择。同时,在 Python 生态当中也有很多可以免费使用的优秀的图像处理工具。

下文将介绍 10 个可以用于图像处理任务的 Python 库,它们在编辑图像、查看图像底层数据方面都提供了简单直接的方法。

### 1、scikit-image

[scikit-image](https://scikit-image.org/) 是一个结合 [NumPy](http://docs.scipy.org/doc/numpy/reference/index.html#module-numpy) 数组使用的开源 Python 工具,它实现了可用于研究、教育、工业应用的算法和应用程序。即使是对于刚刚接触 Python 生态圈的新手来说,它也是一个在使用上足够简单的库。同时它的代码质量也很高,因为它是由一个活跃的志愿者社区开发的,并且通过了<ruby> 同行评审 <rt> peer review </rt></ruby>。

#### 资源

scikit-image 的[文档](http://scikit-image.org/docs/stable/user_guide.html)非常完善,其中包含了丰富的用例。

#### 示例

可以通过导入 `skimage` 使用,大部分的功能都可以在它的子模块中找到。

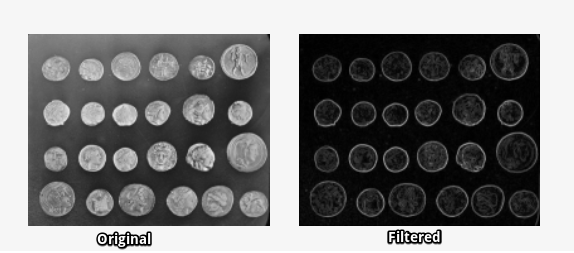

<ruby> 图像滤波 <rt> image filtering </rt></ruby>:

```

import matplotlib.pyplot as plt

%matplotlib inline

from skimage import data,filters

image = data.coins() # ... or any other NumPy array!

edges = filters.sobel(image)

plt.imshow(edges, cmap='gray')

```

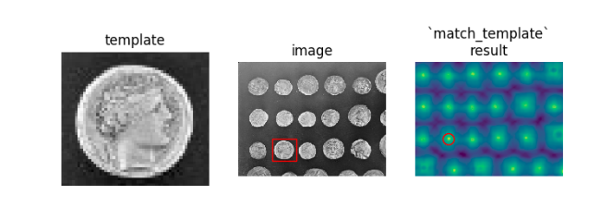

使用 [match\_template()](http://scikit-image.org/docs/dev/auto_examples/features_detection/plot_template.html#sphx-glr-auto-examples-features-detection-plot-template-py) 方法实现<ruby> 模板匹配 <rt> template matching </rt></ruby>:

在[展示页面](https://scikit-image.org/docs/dev/auto_examples)可以看到更多相关的例子。

### 2、NumPy

[NumPy](http://www.numpy.org/) 提供了对数组的支持,是 Python 编程的一个核心库。图像的本质其实也是一个包含像素数据点的标准 NumPy 数组,因此可以通过一些基本的 NumPy 操作(例如切片、<ruby> 掩膜 <rt> mask </rt></ruby>、<ruby> 花式索引 <rt> fancy indexing </rt></ruby>等),就可以从像素级别对图像进行编辑。通过 NumPy 数组存储的图像也可以被 skimage 加载并使用 matplotlib 显示。

#### 资源

在 NumPy 的[官方文档](http://www.numpy.org/)中提供了完整的代码文档和资源列表。

#### 示例

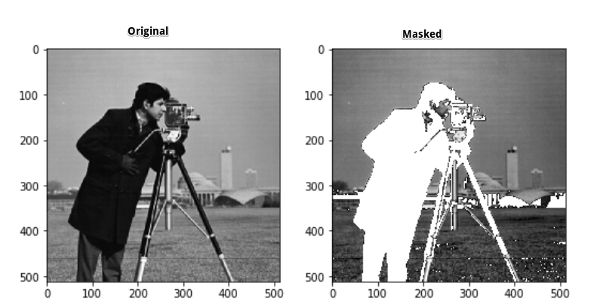

使用 NumPy 对图像进行<ruby> 掩膜 <rt> mask </rt></ruby>操作:

```

import numpy as np

from skimage import data

import matplotlib.pyplot as plt

%matplotlib inline

image = data.camera()

type(image)

numpy.ndarray #Image is a NumPy array:

mask = image < 87

image[mask]=255

plt.imshow(image, cmap='gray')

```

### 3、SciPy

像 NumPy 一样,[SciPy](https://www.scipy.org/) 是 Python 的一个核心科学计算模块,也可以用于图像的基本操作和处理。尤其是 SciPy v1.1.0 中的 [scipy.ndimage](https://docs.scipy.org/doc/scipy/reference/ndimage.html#module-scipy.ndimage) 子模块,它提供了在 n 维 NumPy 数组上的运行的函数。SciPy 目前还提供了<ruby> 线性和非线性滤波 <rt> linear and non-linear filtering </rt></ruby>、<ruby> 二值形态学 <rt> binary morphology </rt></ruby>、<ruby> B 样条插值 <rt> B-spline interpolation </rt></ruby>、<ruby> 对象测量 <rt> object measurements </rt></ruby>等方面的函数。

#### 资源

在[官方文档](https://docs.scipy.org/doc/scipy/reference/tutorial/ndimage.html#correlation-and-convolution)中可以查阅到 `scipy.ndimage` 的完整函数列表。

#### 示例

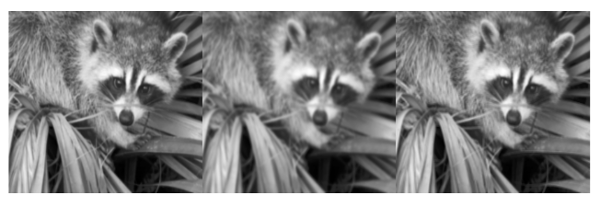

使用 SciPy 的[高斯滤波](https://docs.scipy.org/doc/scipy/reference/generated/scipy.ndimage.gaussian_filter.html)对图像进行模糊处理:

```

from scipy import misc,ndimage

face = misc.face()

blurred_face = ndimage.gaussian_filter(face, sigma=3)

very_blurred = ndimage.gaussian_filter(face, sigma=5)

#Results

plt.imshow(<image to be displayed>)

```

### 4、PIL/Pillow

PIL (Python Imaging Library) 是一个免费 Python 编程库,它提供了对多种格式图像文件的打开、编辑、保存的支持。但在 2009 年之后 PIL 就停止发布新版本了。幸运的是,还有一个 PIL 的积极开发的分支 [Pillow](https://python-pillow.org/),它的安装过程比 PIL 更加简单,支持大部分主流的操作系统,并且还支持 Python 3。Pillow 包含了图像的基础处理功能,包括像素点操作、使用内置卷积内核进行滤波、颜色空间转换等等。

#### 资源

Pillow 的[官方文档](https://pillow.readthedocs.io/en/3.1.x/index.html)提供了 Pillow 的安装说明自己代码库中每一个模块的示例。

#### 示例

使用 Pillow 中的 ImageFilter 模块实现图像增强:

```

from PIL import Image,ImageFilter

#Read image

im = Image.open('image.jpg')

#Display image

im.show()

from PIL import ImageEnhance

enh = ImageEnhance.Contrast(im)

enh.enhance(1.8).show("30% more contrast")

```

* [源码](http://sipi.usc.edu/database/)

### 5、OpenCV-Python

OpenCV(Open Source Computer Vision 库)是计算机视觉领域最广泛使用的库之一,[OpenCV-Python](https://opencv-python-tutroals.readthedocs.io/en/latest/py_tutorials/py_setup/py_intro/py_intro.html) 则是 OpenCV 的 Python API。OpenCV-Python 的运行速度很快,这归功于它使用 C/C++ 编写的后台代码,同时由于它使用了 Python 进行封装,因此调用和部署的难度也不大。这些优点让 OpenCV-Python 成为了计算密集型计算机视觉应用程序的一个不错的选择。

#### 资源

入门之前最好先阅读 [OpenCV2-Python-Guide](https://github.com/abidrahmank/OpenCV2-Python-Tutorials) 这份文档。

#### 示例

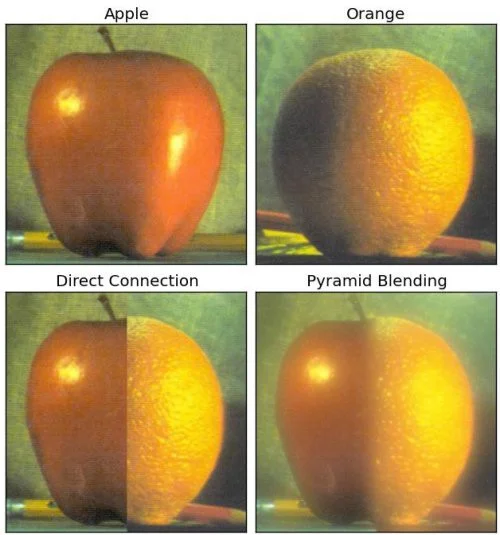

使用 OpenCV-Python 中的<ruby> 金字塔融合 <rt> Pyramid Blending </rt></ruby>将苹果和橘子融合到一起:

* [源码](https://opencv-python-tutroals.readthedocs.io/en/latest/py_tutorials/py_imgproc/py_pyramids/py_pyramids.html#pyramids)

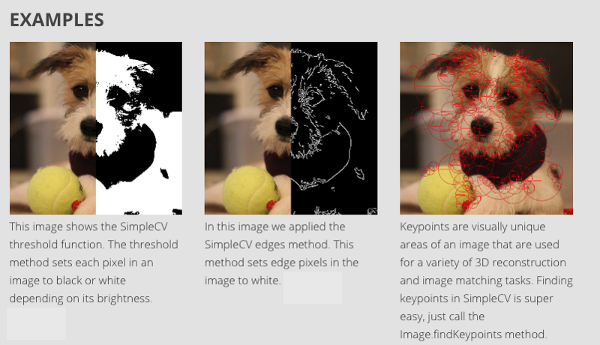

### 6、SimpleCV

[SimpleCV](http://simplecv.org/) 是一个开源的计算机视觉框架。它支持包括 OpenCV 在内的一些高性能计算机视觉库,同时不需要去了解<ruby> 位深度 <rt> bit depth </rt></ruby>、文件格式、<ruby> 色彩空间 <rt> color space </rt></ruby>之类的概念,因此 SimpleCV 的学习曲线要比 OpenCV 平缓得多,正如它的口号所说,“将计算机视觉变得更简单”。SimpleCV 的优点还有:

* 即使是刚刚接触计算机视觉的程序员也可以通过 SimpleCV 来实现一些简易的计算机视觉测试

* 录像、视频文件、图像、视频流都在支持范围内

#### 资源

[官方文档](http://examples.simplecv.org/en/latest/)简单易懂,同时也附有大量的学习用例。

#### 示例

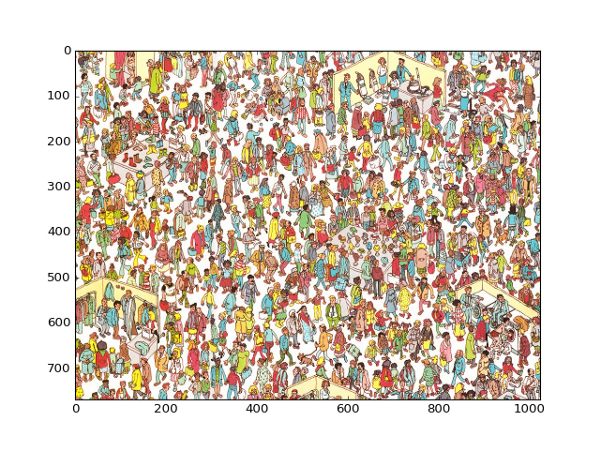

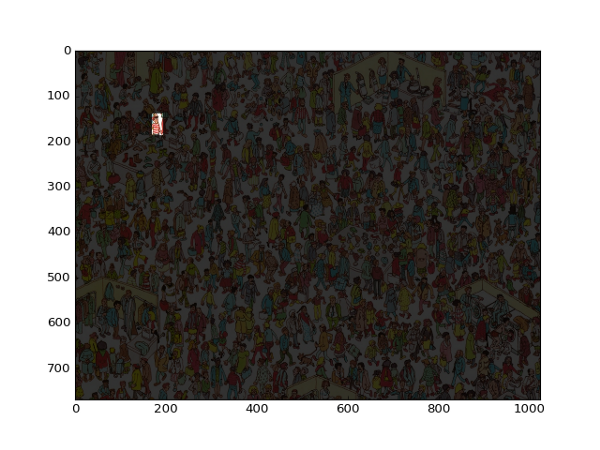

### 7、Mahotas

[Mahotas](https://mahotas.readthedocs.io/en/latest/) 是另一个 Python 图像处理和计算机视觉库。在图像处理方面,它支持滤波和形态学相关的操作;在计算机视觉方面,它也支持<ruby> 特征计算 <rt> feature computation </rt></ruby>、<ruby> 兴趣点检测 <rt> interest point detection </rt></ruby>、<ruby> 局部描述符 <rt> local descriptors </rt></ruby>等功能。Mahotas 的接口使用了 Python 进行编写,因此适合快速开发,而算法使用 C++ 实现,并针对速度进行了优化。Mahotas 尽可能做到代码量少和依赖项少,因此它的运算速度非常快。可以参考[官方文档](https://openresearchsoftware.metajnl.com/articles/10.5334/jors.ac/)了解更多详细信息。

#### 资源

[文档](https://mahotas.readthedocs.io/en/latest/install.html)包含了安装介绍、示例以及一些 Mahotas 的入门教程。

#### 示例

Mahotas 力求使用少量的代码来实现功能。例如这个 [Finding Wally](https://blog.clarifai.com/wheres-waldo-using-machine-learning-to-find-all-the-waldos) 游戏:

* [源码](https://mahotas.readthedocs.io/en/latest/wally.html)

### 8、SimpleITK

[ITK](https://itk.org/)(Insight Segmentation and Registration Toolkit)是一个为开发者提供普适性图像分析功能的开源、跨平台工具套件,[SimpleITK](http://www.simpleitk.org/) 则是基于 ITK 构建出来的一个简化层,旨在促进 ITK 在快速原型设计、教育、解释语言中的应用。SimpleITK 作为一个图像分析工具包,它也带有[大量的组件](https://itk.org/ITK/resources/resources.html),可以支持常规的滤波、图像分割、<ruby> 图像配准 <rt> registration </rt></ruby>功能。尽管 SimpleITK 使用 C++ 编写,但它也支持包括 Python 在内的大部分编程语言。

#### 资源

有很多 [Jupyter Notebooks](http://insightsoftwareconsortium.github.io/SimpleITK-Notebooks/) 用例可以展示 SimpleITK 在教育和科研领域中的应用,通过这些用例可以看到如何使用 Python 和 R 利用 SimpleITK 来实现交互式图像分析。

#### 示例

使用 Python + SimpleITK 实现的 CT/MR 图像配准过程:

* [源码](https://github.com/InsightSoftwareConsortium/SimpleITK-Notebooks/blob/master/Utilities/intro_animation.py)

### 9、pgmagick

[pgmagick](https://pypi.org/project/pgmagick/) 是使用 Python 封装的 GraphicsMagick 库。[GraphicsMagick](http://www.graphicsmagick.org/) 通常被认为是图像处理界的瑞士军刀,因为它强大而又高效的工具包支持对多达 88 种主流格式图像文件的读写操作,包括 DPX、GIF、JPEG、JPEG-2000、PNG、PDF、PNM、TIFF 等等。

#### 资源

pgmagick 的 [GitHub 仓库](https://github.com/hhatto/pgmagick)中有相关的安装说明、依赖列表,以及详细的[使用指引](https://pgmagick.readthedocs.io/en/latest/)。

#### 示例

图像缩放:

* [源码](https://pgmagick.readthedocs.io/en/latest/cookbook.html#scaling-a-jpeg-image)

边缘提取:

* [源码](https://pgmagick.readthedocs.io/en/latest/cookbook.html#edge-extraction)

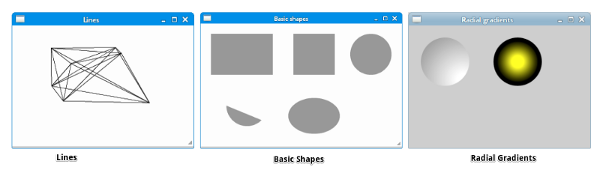

### 10、Pycairo

[Cairo](https://cairographics.org/) 是一个用于绘制矢量图的二维图形库,而 [Pycairo](https://pypi.org/project/pycairo/) 是用于 Cairo 的一组 Python 绑定。矢量图的优点在于做大小缩放的过程中不会丢失图像的清晰度。使用 Pycairo 可以在 Python 中调用 Cairo 的相关命令。

#### 资源

Pycairo 的 [GitHub 仓库](https://github.com/pygobject/pycairo)提供了关于安装和使用的详细说明,以及一份简要介绍 Pycairo 的[入门指南](https://pycairo.readthedocs.io/en/latest/tutorial.html)。

#### 示例

使用 Pycairo 绘制线段、基本图形、<ruby> 径向渐变 <rt> radial gradients </rt></ruby>:

* [源码](http://zetcode.com/gfx/pycairo/basicdrawing/)

### 总结

以上就是 Python 中的一些有用的图像处理库,无论你有没有听说过、有没有使用过,都值得试用一下并了解它们。

---

via: <https://opensource.com/article/19/3/python-image-manipulation-tools>

作者:[Parul Pandey](https://opensource.com/users/parul-pandey) 选题:[lujun9972](https://github.com/lujun9972) 译者:[HankChow](https://github.com/HankChow) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | Today's world is full of data, and images form a significant part of this data. However, before they can be used, these digital images must be processed—analyzed and manipulated in order to improve their quality or extract some information that can be put to use.

Common image processing tasks include displays; basic manipulations like cropping, flipping, rotating, etc.; image segmentation, classification, and feature extractions; image restoration; and image recognition. Python is an excellent choice for these types of image processing tasks due to its growing popularity as a scientific programming language and the free availability of many state-of-the-art image processing tools in its ecosystem.

This article looks at 10 of the most commonly used Python libraries for image manipulation tasks. These libraries provide an easy and intuitive way to transform images and make sense of the underlying data.

## 1. scikit-image

is an open source Python package that works with

**scikit**-image

[NumPy](http://docs.scipy.org/doc/numpy/reference/index.html#module-numpy)arrays. It implements algorithms and utilities for use in research, education, and industry applications. It is a fairly simple and straightforward library, even for those who are new to Python's ecosystem. The code is high-quality, peer-reviewed, and written by an active community of volunteers.

### Resources

scikit-image is very well [documented](http://scikit-image.org/docs/stable/user_guide.html) with a lot of examples and practical use cases.

### Usage

The package is imported as **skimage**, and most functions are found within the submodules.

Image filtering:

```

import matplotlib.pyplot as plt

%matplotlib inline

from skimage import data,filters

image = data.coins() # ... or any other NumPy array!

edges = filters.sobel(image)

plt.imshow(edges, cmap='gray')

```

Template matching using the [match_template](http://scikit-image.org/docs/dev/auto_examples/features_detection/plot_template.html#sphx-glr-auto-examples-features-detection-plot-template-py) function:

You can find more examples in the [gallery](https://scikit-image.org/docs/dev/auto_examples).

## 2. NumPy

[ NumPy](http://www.numpy.org/) is one of the core libraries in Python programming and provides support for arrays. An image is essentially a standard NumPy array containing pixels of data points. Therefore, by using basic NumPy operations, such as slicing, masking, and fancy indexing, you can modify the pixel values of an image. The image can be loaded using

**skimage**and displayed using Matplotlib.

### Resources

A complete list of resources and documentation is available on NumPy's [official documentation page](http://www.numpy.org/).

### Usage

Using Numpy to mask an image:

```

import numpy as np

from skimage import data

import matplotlib.pyplot as plt

%matplotlib inline

image = data.camera()

type(image)

numpy.ndarray #Image is a NumPy array:

mask = image < 87

image[mask]=255

plt.imshow(image, cmap='gray')

```

## 3. SciPy

** SciPy** is another of Python's core scientific modules (like NumPy) and can be used for basic image manipulation and processing tasks. In particular, the submodule

[(in SciPy v1.1.0) provides functions operating on n-dimensional NumPy arrays. The package currently includes functions for linear and non-linear filtering, binary morphology, B-spline interpolation, and object measurements.](https://docs.scipy.org/doc/scipy/reference/ndimage.html#module-scipy.ndimage)

**scipy.ndimage**### Resources

For a complete list of functions provided by the **scipy.ndimage** package, refer to the [documentation](https://docs.scipy.org/doc/scipy/reference/tutorial/ndimage.html#correlation-and-convolution).

### Usage

Using SciPy for blurring using a [Gaussian filter](https://docs.scipy.org/doc/scipy/reference/generated/scipy.ndimage.gaussian_filter.html):

```

from scipy import misc,ndimage

face = misc.face()

blurred_face = ndimage.gaussian_filter(face, sigma=3)

very_blurred = ndimage.gaussian_filter(face, sigma=5)

#Results

plt.imshow(<image to be displayed>)

```

## 4. PIL/Pillow

**PIL** (Python Imaging Library) is a free library for the Python programming language that adds support for opening, manipulating, and saving many different image file formats. However, its development has stagnated, with its last release in 2009. Fortunately, there is [ Pillow](https://python-pillow.org/), an actively developed fork of PIL, that is easier to install, runs on all major operating systems, and supports Python 3. The library contains basic image processing functionality, including point operations, filtering with a set of built-in convolution kernels, and color-space conversions.

### Resources

The [documentation](https://pillow.readthedocs.io/en/3.1.x/index.html) has instructions for installation as well as examples covering every module of the library.

### Usage

Enhancing an image in Pillow using ImageFilter:

```

from PIL import Image,ImageFilter

#Read image

im = Image.open('image.jpg')

#Display image

im.show()

from PIL import ImageEnhance

enh = ImageEnhance.Contrast(im)

enh.enhance(1.8).show("30% more contrast")

```

## 5. OpenCV-Python

**OpenCV** (Open Source Computer Vision Library) is one of the most widely used libraries for computer vision applications. [ OpenCV-Python](https://opencv-python-tutroals.readthedocs.io/en/latest/py_tutorials/py_setup/py_intro/py_intro.html) is the Python API for OpenCV. OpenCV-Python is not only fast, since the background consists of code written in C/C++, but it is also easy to code and deploy (due to the Python wrapper in the foreground). This makes it a great choice to perform computationally intensive computer vision programs.

### Resources

The [OpenCV2-Python-Guide](https://github.com/abidrahmank/OpenCV2-Python-Tutorials) makes it easy to get started with OpenCV-Python.

### Usage

Using *Image Blending using Pyramids* in OpenCV-Python to create an "Orapple":

## 6. SimpleCV

[ SimpleCV](http://simplecv.org/) is another open source framework for building computer vision applications. It offers access to several high-powered computer vision libraries such as OpenCV, but without having to know about bit depths, file formats, color spaces, etc. Its learning curve is substantially smaller than OpenCV's, and (as its tagline says), "it's computer vision made easy." Some points in favor of SimpleCV are:

- Even beginning programmers can write simple machine vision tests

- Cameras, video files, images, and video streams are all interoperable

### Resources

The official [documentation](http://examples.simplecv.org/en/latest/) is very easy to follow and has tons of examples and use cases to follow.

### Usage

## 7. Mahotas

** Mahotas** is another computer vision and image processing library for Python. It contains traditional image processing functions such as filtering and morphological operations, as well as more modern computer vision functions for feature computation, including interest point detection and local descriptors. The interface is in Python, which is appropriate for fast development, but the algorithms are implemented in C++ and tuned for speed. Mahotas' library is fast with minimalistic code and even minimum dependencies. Read its

[official paper](https://openresearchsoftware.metajnl.com/articles/10.5334/jors.ac/)for more insights.

### Resources

The [documentation](https://mahotas.readthedocs.io/en/latest/install.html) contains installation instructions, examples, and even some tutorials to help you get started using Mahotas easily.

### Usage

The Mahotas library relies on simple code to get things done. For example, it does a good job with the [Finding Wally](https://blog.clarifai.com/wheres-waldo-using-machine-learning-to-find-all-the-waldos) problem with a minimum amount of code.

Solving the Finding Wally problem:

## 8. SimpleITK

[ ITK](https://itk.org/) (Insight Segmentation and Registration Toolkit) is an "open source, cross-platform system that provides developers with an extensive suite of software tools for image analysis.

**is a simplified layer built on top of ITK, intended to facilitate its use in rapid prototyping, education, [and] interpreted languages." It's also an image analysis toolkit with a**

[SimpleITK](http://www.simpleitk.org/)[large number of components](https://itk.org/ITK/resources/resources.html)supporting general filtering operations, image segmentation, and registration. SimpleITK is written in C++, but it's available for a large number of programming languages including Python.

### Resources

There are a large number of [Jupyter Notebooks](http://insightsoftwareconsortium.github.io/SimpleITK-Notebooks/) illustrating the use of SimpleITK for educational and research activities. The notebooks demonstrate using SimpleITK for interactive image analysis using the Python and R programming languages.

### Usage

Visualization of a rigid CT/MR registration process created with SimpleITK and Python:

## 9. pgmagick

[ pgmagick](https://pypi.org/project/pgmagick/) is a Python-based wrapper for the GraphicsMagick library. The

[image processing system is sometimes called the Swiss Army Knife of image processing. Its robust and efficient collection of tools and libraries supports reading, writing, and manipulating images in over 88 major formats including DPX, GIF, JPEG, JPEG-2000, PNG, PDF, PNM, and TIFF.](http://www.graphicsmagick.org/)

**GraphicsMagick**### Resources

pgmagick's [GitHub repository](https://github.com/hhatto/pgmagick) has installation instructions and requirements. There is also a detailed [user guide](https://pgmagick.readthedocs.io/en/latest/).

### Usage

Image scaling:

Edge extraction:

## 10. Pycairo

[ Pycairo](https://pypi.org/project/pycairo/) is a set of Python bindings for the

[Cairo](https://cairographics.org/)graphics library. Cairo is a 2D graphics library for drawing vector graphics. Vector graphics are interesting because they don't lose clarity when resized or transformed. Pycairo can call Cairo commands from Python.

### Resources

The Pycairo [GitHub repository](https://github.com/pygobject/pycairo) is a good resource with detailed instructions on installation and usage. There is also a [getting started guide](https://pycairo.readthedocs.io/en/latest/tutorial.html), which has a brief tutorial on Pycairo.

### Usage

Drawing lines, basic shapes, and radial gradients with Pycairo:

## Conclusion

These are some of the useful and freely available image processing libraries in Python. Some are well known and others may be new to you. Try them out to get to know more about them!

## 2 Comments |

10,680 | iWant:一个去中心化的点对点共享文件的命令行工具 | https://www.ostechnix.com/iwant-decentralized-peer-peer-file-sharing-commandline-application/ | 2019-04-03T12:48:10 | [

"P2P",

"文件共享"

] | https://linux.cn/article-10680-1.html |

不久之前,我们编写了一个指南,内容是一个文件共享实用程序,名为 [transfer.sh](https://www.ostechnix.com/easy-fast-way-share-files-internet-command-line/),它是一个免费的 Web 服务,允许你在 Internet 上轻松快速地共享文件,还有 [PSiTransfer](https://www.ostechnix.com/psitransfer-simple-open-source-self-hosted-file-sharing-solution/),一个简单的开源自托管文件共享解决方案。今天,我们将看到另一个名为 “iWant” 的文件共享实用程序。它是一个基于命令行的自由开源的去中心化点对点文件共享应用程序。

你可能想知道,它与其它文件共享应用程序有什么不同?以下是 iWant 的一些突出特点。

* 它是一个命令行应用程序。这意味着你不需要消耗内存来加载 GUI 实用程序。你只需要一个终端。

* 它是去中心化的。这意味着你的数据不会在任何中心位置存储。因此,不会因为中心点失败而失败。

* iWant 允许中断下载,你可以在以后随时恢复。你不需要从头开始下载,它会从你停止的位置恢复下载。

* 共享目录中文件所作的任何更改(如删除、添加、修改)都会立即反映在网络中。

* 就像种子一样,iWant 从多个节点下载文件。如果任何节点离开群组或未能响应,它将继续从另一个节点下载。

* 它是跨平台的,因此你可以在 GNU/Linux、MS Windows 或者 Mac OS X 中使用它。

### 安装 iWant

iWant 可以使用 PIP 包管理器轻松安装。确保你在 Linux 发行版中安装了 pip。如果尚未安装,参考以下指南。

[如何使用 Pip 管理 Python 包](https://www.ostechnix.com/manage-python-packages-using-pip/)

安装 pip 后,确保你有以下依赖项:

* libffi-dev

* libssl-dev

比如说,在 Ubuntu 上,你可以使用以下命令安装这些依赖项:

```

$ sudo apt-get install libffi-dev libssl-dev

```

安装完所有依赖项后,使用以下命令安装 iWant:

```

$ sudo pip install iwant

```

现在我们的系统中已经有了 iWant,让我们来看看如何使用它来通过网络传输文件。

### 用法

首先,使用以下命令启动 iWant 服务器:

(LCTT 译注:虽然这个软件是叫 iWant,但是其命令名为 `iwanto`,另外这个软件至少一年没有更新了。)

```

$ iwanto start

```

第一次启动时,iWant 会询问想要分享和下载文件夹的位置,所以需要输入两个文件夹的位置。然后,选择要使用的网卡。

示例输出:

```

Shared/Download folder details looks empty..

Note: Shared and Download folder cannot be the same

SHARED FOLDER(absolute path):/home/sk/myshare

DOWNLOAD FOLDER(absolute path):/home/sk/mydownloads

Network interface available

1. lo => 127.0.0.1

2. enp0s3 => 192.168.43.2

Enter index of the interface:2

now scanning /home/sk/myshare

[Adding] /home/sk/myshare 0.0

Updating Leader 56f6d5e8-654e-11e7-93c8-08002712f8c1

[Adding] /home/sk/myshare 0.0

connecting to 192.168.43.2:1235 for hashdump

```

如果你看到类似上面的输出,你可以立即开始使用 iWant 了。

同样,在网络中的所有系统上启动 iWant 服务,指定有效的分享和下载文件夹的位置,并选择合适的网卡。

iWant 服务将继续在当前终端窗口中运行,直到你按下 `CTRL+C` 退出为止。你需要打开一个新选项卡或新的终端窗口来使用 iWant。

iWant 的用法非常简单,它的命令很少,如下所示。

* `iwanto start` – 启动 iWant 服务。

* `iwanto search <name>` – 查找文件。

* `iwanto download <hash>` – 下载一个文件。

* `iwanto share <path>` – 更改共享文件夹的位置。

* `iwanto download to <destination>` – 更改下载文件夹位置。

* `iwanto view config` – 查看共享和下载文件夹。

* `iwanto –version` – 显示 iWant 版本。

* `iwanto -h` – 显示帮助信息。

让我向你展示一些例子。

#### 查找文件

要查找一个文件,运行:

```

$ iwanto search <filename>

```

请注意,你无需指定确切的名称。

示例:

```

$ iwanto search command

```

上面的命令将搜索包含 “command” 字符串的所有文件。

我的 Ubuntu 系统会输出:

```

Filename Size Checksum

------------------------------------------- ------- --------------------------------

/home/sk/myshare/THE LINUX COMMAND LINE.pdf 3.85757 efded6cc6f34a3d107c67c2300459911

```

#### 下载文件

你可以在你的网络上的任何系统下载文件。要下载文件,只需提供文件的哈希(校验和),如下所示。你可以使用 `iwanto search` 命令获取共享的哈希值。

```

$ iwanto download efded6cc6f34a3d107c67c2300459911

```

文件将保存在你的下载位置,在本文中是 `/home/sk/mydownloads/` 位置。

```

Filename: /home/sk/mydownloads/THE LINUX COMMAND LINE.pdf

Size: 3.857569 MB

```

#### 查看配置

要查看配置,例如共享和下载文件夹的位置,运行:

```

$ iwanto view config

```

示例输出:

```

Shared folder:/home/sk/myshare

Download folder:/home/sk/mydownloads

```

#### 更改共享和下载文件夹的位置

你可以更改共享文件夹和下载文件夹。

```

$ iwanto share /home/sk/ostechnix

```

现在,共享位置已更改为 `/home/sk/ostechnix`。

同样,你可以使用以下命令更改下载位置:

```