id

int64 2.05k

16.6k

| title

stringlengths 5

75

| fromurl

stringlengths 19

185

| date

timestamp[s] | tags

sequencelengths 0

11

| permalink

stringlengths 20

37

| content

stringlengths 342

82.2k

| fromurl_status

int64 200

526

⌀ | status_msg

stringclasses 339

values | from_content

stringlengths 0

229k

⌀ |

|---|---|---|---|---|---|---|---|---|---|

7,743 | 一位跨平台开发者的自白 | https://opensource.com/business/16/5/oscon-interview-andreia-gaita | 2016-09-04T16:36:35 | [

"跨平台",

"开发"

] | https://linux.cn/article-7743-1.html |

[Andreia Gaita](https://twitter.com/sh4na) 在 OSCON 开源大会上发表了一个题为[跨平台开发者的自白](http://conferences.oreilly.com/oscon/open-source-us/public/schedule/detail/48702)的演讲。她长期从事于开源工作,并且为 [Mono](http://www.mono-project.com/) 工程(LCTT 译注:一个致力于开创 .NET 在 Linux 上使用的开源工程)做着贡献,主要以 C#/C++ 开发。Andreia 任职于 GitHub,她的工作是专注构建 Visual Studio 的 GitHub 扩展管理器。

我在她发表演讲前就迫不及待的想要问她一些关于跨平台开发的事,问问她作为一名跨平台开发者在这 16 年之中学习到了什么。

**在你开发跨平台代码中,你使用过的最简单的和最难的代码语言是什么?**

我很少讨论某种语言的好坏,更多是讨论是那些语言有哪些库和工具。语言的编译器、解释器以及构建系统决定了用它们做跨平台开发的难易程度(或者它们是否可能做跨平台开发),可用的 UI 库和对本地系统的访问能力决定了与该操作系统集成的紧密程度。按照我的观点,我认为 C# 最适合完成跨平台开发工作。这种语言自身包括了允许快速的本地调用和精确的内存映射的功能,如果你希望你的代码能够与系统和本地函数库进行交互就需要这些功能。而当我需要非常特殊的系统功能时,我就会切换到 C 或者 C++。

**你使用的跨平台开发工具或者抽象层有哪些?**

我的大部分跨平台工作都是为其它需要开发跨平台应用的人开发工具、库和<ruby> 绑定 <rp> ( </rp> <rt> binding </rt> <rp> ) </rp></ruby>,一般是用 MONO/C# 和 C/C++。在抽象的层面我用的不多,更多是在 glib 库和<ruby> 友元 <rp> ( </rp> <rt> friends </rt> <rp> ) </rp></ruby>方面。大多数时候,我用 Mono 去完成各种跨平台应用的,包括 UI,或者偶然在游戏开发中用到 Unity3D 的部分。我经常使用 Electron(LCTT 译注:Atom 编辑器的兄弟项目,可以用 Electron 开发桌面应用)。

**你接触过哪些构建系统?它们之间的区别是由于语言还是平台的不同?**

我试着选择适合我使用的语言的构建系统。那样,就会很少遇到让我头疼的问题(希望如此)。它需要支持平台和体系结构间的选择、构建输出结果位置可以智能些(多个并行构建),以及易配置性等。大多数时候,我的项目会结合使用 C/C++ 和 C#,我要从同一源代码同时构建不同的配置环境(调试、发布、Windows、OSX、Linux、Android、iOS 等等),这通常需要为每个构建的输出结果选择带有不同参数的不同编译器。构建系统可以帮我做到这一切而不用让我(太)费心。我时常尝试着用不同的构建系统,看看有些什么新的变化,但是最终,我还是回到了使用 makefile 的情况,并结合使用 shell 和批处理脚本或 Perl 脚本来完成工作(因为如果我希望用户来构建我的软件,我还是最好选择一种到处都可以用的命令行脚本语言)。

**你怎样平衡在这种使用统一的用户界面下提供原生的外观和体验的需求呢?**

跨平台的用户界面的实现很困难。在过去几年中我已经使用了一些跨平台 GUI,并且我认为这些事情上并没有最优解。基本上有两种选择。你可以选择一个跨平台工具去做一个并不是完全适合你所有支持的平台的 UI,但是代码库比较小,维护成本比较低。或者你可以选择去开发针对平台的 UI,那样看起来更原生,集成的也更好,但是需要更大的代码库和更高的维护成本。这种决定完全取决于 APP 的类型、它有多少功能、你有多少资源,以及你要把它运行在多少平台上?

最后,我认为用户比较接受这种“一个 UI 打通关”了,就比如 Electron 框架。我有个 Chromium + C + C# 的框架侧项目,有一天我希望可以用 C# 构建 Electron 型的 app,这样的话我就可以做到两全其美了。

**构建/打包系统的依赖性对你有影响吗 ?**

我依赖的使用方面很保守,我被崩溃的 ABI(LCTT 译注:应用程序二进制接口)、冲突的符号、以及丢失的包等问题困扰了太多次。我决定我要针对的操作系统版本,并选择最低的公有部分来使问题最小化。通常这就意味着有五种不同的 Xcode 和 OSX 框架库,要在同样的机器上相应安装五种不同的 Visual Studio 版本,多种 clang(LCTT 译注:C语言、C++、Object-C、C++ 语言的轻量级编译器)和 gcc 版本,一系列的运行着各种发行版的虚拟机。如果我不能确定我要使用的操作系统的包的状态,我有时就会静态连接库,有时会子模块化依赖以确保它们一直可用。大多时候,我会避免这些很棘手的问题,除非我非常需要使用他们。

**你使用持续集成(CI)、代码审查以及相关的工具吗?**

基本每天都用。这是保持高效的唯一方式。我在一个项目中做的第一件事情是配置跨平台构建脚本,保证每件事尽可能自动化完成。当你面向多平台开发的时候,持续集成是至关重要的。没有人能在一个机器上构建各种平台的不同组合,并且一旦你的构建过程没有包含所有的平台,你就不会注意到你搞砸的事情。在一个共享式的多平台代码库中,不同的人拥有不同的平台和功能,所以保证质量的唯一的方法是跨团队代码审查结合持续集成和其他分析工具。这不同于其他的软件项目,如果不使用相关的工具就会面临失败。

**你依赖于自动构建测试,或者倾向于在每个平台上构建并且进行本地测试吗?**

对于不包括 UI 的工具和库,我通常使用自动构建测试。如果有 UI,两种方法我都会用到——针对已有的 GUI 工具的可靠的、可脚本化的 UI 自动化少到几乎没有,所以我要么我去针对我要跨我所支持的平台创建 UI 自动化工具,要么手动进行测试。如果一个项目使用了定制的 UI 库(比如说一个类似 Unity3D 的 OpenGL UI),开发可编程的自动化工具并自动化大多数工作就相当容易。不过,没有什么东西会像人一样双击就测试出问题。

**如果你要做跨平台开发,你喜欢用跨编辑器的构建系统,比如在 Windows 上使用 Visual Studio,在 Linux 上使用 Qt Creator,在 Mac 上使用 XCode 吗?还是你更趋向于使用 Eclipse 这样的可以在所有平台上使用的单一平台?**

我喜欢使用跨编辑器的构建系统。我更喜欢在不同的IDE上保存项目文件(这样可以使增加 IDE 变得更容易),通过使用构建脚本让 IDE 在它们支持的平台上去构建。对于一个开发者来说编辑器是最重要的工具,学习它们是需要花费时间和精力的,而它们是不可相互替代的。我有我自己喜欢的编辑器和工具,每个人也可以使用他们最喜爱的工具。

**在跨平台开发的时候,你更喜欢使用什么样的编辑器、开发环境和 IDE 呢?**

跨平台开发者被限制在只能选择可以在多数平台上工作的所共有的不多选择之一。我爱用 Visual Studio,但是我不能依赖它完成除 Windows 平台之外的工作(你可能不想让 Windows 成为你的主要的交叉编译平台),所以我不会使用它作为我的主要 IDE。即使可以,跨平台开发者的核心技能也是尽可能的了解和使用大量的平台。这就意味着必须很熟悉它们——使用该平台上的编辑器和库,了解这种操作系统及其适用场景、运行方式以及它的局限性等。做这些事情就需要头脑清醒(我的捷径是加强记忆),我必须依赖跨平台的编辑器。所以我使用 Emacs 和 Sublime。

**你之前和现在最喜欢的跨平台项目是什么?**

我一直很喜欢 Mono,并且得心应手,其它的项目大部分都是以某种方式围绕着它进行的。Gluezilla 是我在多年前开发的一个 Mozilla <ruby> 绑定 <rp> ( </rp> <rt> binding </rt> <rp> ) </rp></ruby>,可以把 C# 开发的应用嵌入到 Web 浏览器页面中,并且看起来很有特色。我开发过一个 Winform 应用,它是在 linux 上开发的,它可以在 Windows 上运行在一个 Mozilla 浏览器页面里嵌入的 GTK 视图中。CppSharp 项目(以前叫做 Cxxi,更早时叫做 CppInterop)是一个我开始为 C++ 库生成 C# <ruby> 绑定 <rp> ( </rp> <rt> binding </rt> <rp> ) </rp></ruby>的项目,这样就可以在 C# 中调用、创建实例、子类化 C++ 类。这样,它在运行的时候就能够检测到所使用的平台,以及用来创建本地运行库的是什么编译器,并为它生成正确的 C# <ruby> 绑定 <rp> ( </rp> <rt> binding </rt> <rp> ) </rp></ruby>。这多么有趣啊。

**你怎样看跨平台开发的未来趋势呢?**

我们构建本地应用程序的方式已经改变了,我感觉在各种桌面操作系统的明显差异在慢慢变得模糊;所以构建跨平台的应用程序将会更加容易,而且对系统的集成也不需要完全本地化。不好的是,这可能意味着应用程序易用性更糟,并且在发挥操作系统特性方面所能做的更少。库、工具以及运行环境的跨平台开发是一种我们知道怎样做的更好,但是跨平台应用程序的开发仍然需要我们的努力。

---

via: <https://opensource.com/business/16/5/oscon-interview-andreia-gaita>

作者:[Marcus D. Hanwell](https://opensource.com/users/mhanwell) 译者:[vim-kakali](https://github.com/vim-kakali) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | [Andreia Gaita](https://twitter.com/sh4na) is giving a talk at this year's OSCON, titled [ Confessions of a cross-platform developer](http://conferences.oreilly.com/oscon/open-source-us/public/schedule/detail/48702). She's a long-time open source and

[Mono](http://www.mono-project.com/)contributor, and develops primarily in C#/C++. Andreia works at GitHub, where she's focused on building the GitHub Extension manager for Visual Studio.

I caught up with Andreia ahead of her talk to ask about cross-platform development and what she's learned in her 16 years as a cross-platform developer.

### What languages have you found easiest and hardest to develop cross-platform code for?

It's less about which languages are good and more about the libraries and tooling available for those languages. The compilers/interpreters/build systems available for languages determine how easy it is to do cross-platform work with them (or whether it's even possible), and the libraries available for UI and native system access determine how deep you can integrate with the OS. With that in mind, I found C# to be the best for cross-platform work. The language itself includes features that allow fast native calls and accurate memory mapping, which you really need if you want your code to talk to the OS and native libraries. When I need very specific OS integration, I switch to C or C++.

### What cross-platform toolkits/abstractions have you used?

Most of my cross-platform work has been developing tools, libraries and bindings for other people to develop cross-platform applications with, mostly in Mono/C# and C/C++. I don't get to use a lot of abstractions at that level, beyond glib and friends. I mostly rely on Mono for any cross-platform app that includes a UI, and Unity3D for the occasional game development. I play with Electron every now and then.

### What has been your approach to build systems, and how does this vary by language or platform?

I try to pick the build system that is most suited for the language(s) I'm using. That way, it'll (hopefully) give me less headaches. It needs to allow for platform and architecture selection, be smart about build artifact locations (for multiple parallel builds), and be decently configurable. Most of the time I have projects combining C/C++ and C# and I want to build all the different configurations at the same time from the same source tree (Debug, Release, Windows, OSX, Linux, Android, iOS, etc, etc.), and that usually requires selecting and invoking different compilers with different flags per output build artifact. So the build system has to let me do all of this without getting (too much) in my way. I try out different build systems every now and then, just to see what's new, but in the end, I end up going back to makefiles and a combination of either shell and batch scripts or Perl scripts for driving them (because if I want users to build my things, I'd better pick a command line script language that is available everywhere).

### How do you balance the desire for native look and feel with the need for uniform user interfaces?

Cross-platform UI is hard! I've implemented several cross-platform GUIs over the years, and it's the one thing for which I don't think there's an optimal solution. There's basically two options. You can pick a cross-platform GUI toolkit and do a UI that doesn't feel quite right in all the platforms you support, with a small codebase and low maintenance cost. Or you can choose to develop platform-specific UIs that will look and feel native and well integrated with a larger codebase and higher maintenance cost. The decision really depends on the type of app, how many features it has, how many resources you have, and how many platforms you're shipping to.

In the end, I think there's an increase in users' tolerance for "One UI To Rule Them All" with frameworks like Electron. I have a Chromium+C+C# framework side project that will one day hopefully allow me build Electron-style apps in C#, giving me the best of both worlds.

### Has building/packaging dependencies been an issue for you?

I'm very conservative about my use of dependencies, having been bitten so many times by breaking ABIs, clashing symbols, and missing packages. I decide which OS version(s) I'm targeting and pick the lowest common denominator release available of a dependency to minimize issues. That usually means having five different copies of Xcode and OSX Framework libraries, five different versions of Visual Studio installed side-to-side on the same machine, multiple clang and gcc versions, and a bunch of VMs running various other distros. If I'm unsure of the state of packages in the OS I'm targeting, I will sometimes link statically and sometimes submodule dependencies to make sure they're always available. And most of all, I avoid the bleeding edge unless I really, really need something there.

### Do you use continuous integration, code review, and related tools?

All the time! It's the only way to keep sane. The first thing I do on a project is set up cross-platform build scripts to ensure everything is automateable as early as possible. When you're targeting multiple platforms, CI is essential. It's impossible for everyone to build all the different combinations of platforms in one machine, and as soon as you're not building all of them you're going to break something without being aware of it. In a shared multi-platform codebase, different people own different platforms and features, so the only way to guarantee quality is to have cross-team code reviews combined with CI and other analysis tools. It's no different than other software projects, there's just more points of failure.

### Do you rely on automated build testing, or do you tend to build on each platform and test locally?

For tools and libraries that don't include UIs, I can usually get away with automated build testing. If there's a UI, then I need to do both—reliable, scriptable UI automation for existing GUI toolkits is rare to non-existent, so I would have to either invest in creating UI automation tools that work across all the platforms I want to support, or I do it manually. If a project uses a custom UI toolkit (like, say, an OpenGL UI like Unity3D does), then it's fairly easy to develop scriptable automation tools and automate most of that stuff. Still, there's nothing like the human ability to break things with a couple of clicks!

### If you are developing cross-platform, do you support cross-editor build systems so that you can use Visual Studio on Windows, Qt Creator on Linux, and XCode on Mac? Or do you tend toward supporting one platform such as Eclipse on all platforms?

I favor cross-editor build systems. I prefer generating project files for different IDEs (preferably in a way that makes it easier to add more IDEs), with build scripts that can drive builds from the IDEs for the platform they're on. Editors are the most important tool for a developer. It takes time and effort to learn them, and they're not interchangeable. I have my favorite editors and tools, and everyone else should be able to use their favorite tool, too.

### What is your preferred editor/development environment/IDE for cross-platform development?

The cross-platform developer is cursed with having to pick the lowest common denominator editor that works across the most platforms. I love Visual Studio, but I can't rely on it for anything except Windows work (and you really don't want to make Windows your primary cross-compiling platform), so I can't make it my primary IDE. Even if I could, an essential skill of cross-platform development is to know and use as many platforms as possible. That means really knowing them—using the platform's editors and libraries, getting to know the OS and its assumptions, behaviors, and limitations, etc. To do that and keep my sanity (and my shortcut muscle memory), I have to rely on cross-platform editors. So, I use Emacs and Sublime.

### What are some of your favorite past and current cross-platform projects?

Mono is my all-time favorite, hands down, and most of the others revolve around it in some way. Gluezilla was a Mozilla binding I did years ago to allow C# apps to embed web browser views, and that one was a doozy. At one point I had a Winforms app, built on Linux, running on Windows with an embedded GTK view in it that was running a Mozilla browser view. The CppSharp project (formerly Cxxi, formerly CppInterop) is a project I started to generate C# bindings for C++ libraries so that you could call, create instances of, and subclass C++ classes from C#. It was done in such a way that it would detect at runtime what platform you'd be running on and what compiler was used to create the native library and generate the correct C# bindings for it. That was fun!

### Where do you see cross-platform development heading in the future?

The way we build native applications is already changing, and I feel like the visual differences between the various desktop operating systems are going to become even more blurred so that it will become easier to build cross-platform apps that integrate reasonably well without being fully native. Unfortunately, that might mean applications will be worse in terms of accessibility and less innovative when it comes to using the OS to its full potential. Cross-platform development of tools, libraries, and runtimes is something that we know how to do well, but there's still a lot of work to do with cross-platform application development.

## 3 Comments |

7,744 | LFCS 系列第十三讲:如何配置并排除 GNU 引导加载程序(GRUB)故障 | http://www.tecmint.com/configure-and-troubleshoot-grub-boot-loader-linux/ | 2016-09-04T18:05:00 | [

"LFCS",

"Grub"

] | https://linux.cn/article-7744-1.html | 由于 LFCS 考试需求的变动已于 2016 年 2 月 2 日生效,因此我们向 [LFCS 系列](http://www.tecmint.com/sed-command-to-create-edit-and-manipulate-files-in-linux/) 添加了一些必要的话题。为了准备认证考试,我们也强烈推荐你去看看 [LFCE 系列](http://www.tecmint.com/installing-network-services-and-configuring-services-at-system-boot/)。

*LFCS 系列第十三讲:配置并排除 Grub 引导加载程序故障。*

本文将会向你介绍 GRUB 的知识,并会说明你为什么需要一个引导加载程序,以及它是如何给系统增加功能的。

[Linux 引导过程](http://www.tecmint.com/linux-boot-process/) 是从你按下你的电脑电源键开始,直到你拥有一个全功能的系统为止,整个过程遵循着这样的主要步骤:

* 1. 一个叫做 **POST**(**上电自检**)的过程会对你的电脑硬件组件做全面的检查。

* 2. 当 **POST** 完成后,它会把控制权转交给引导加载程序,接下来引导加载程序会将 Linux 内核(以及 **initramfs**)加载到内存中并执行。

* 3. 内核首先检查并访问硬件,然后运行初始化进程(主要以它的通用名 **init** 而为人熟知),接下来初始化进程会启动一些服务,最后完成系统启动过程。

在该系列的第七讲(“[SysVinit、Upstart 和 Systemd](/article-7365-1.html)”)中,我们介绍了现代 Linux 发行版使用的一些服务管理系统和工具。在继续学习之前,你可能想要回顾一下那一讲的知识。

### GRUB 引导装载程序介绍

在现代系统中,你会发现有两种主要的 **GRUB** 版本(一种是有时被称为 **GRUB Legacy** 的 **v1** 版本,另一种则是 **v2** 版本),虽说多数最新版本的发行版系统都默认使用了 **v2** 版本。如今,只有 **红帽企业版 Linux 6** 及其衍生系统仍在使用 **v1** 版本。

因此,在本指南中,我们将着重关注 **v2** 版本的功能。

不管 **GRUB** 的版本是什么,一个引导加载程序都允许用户:

1. 通过指定使用不同的内核来修改系统的行为;

2. 从多个操作系统中选择一个启动;

3. 添加或编辑配置区块来改变启动选项等。

如今,**GNU** 项目负责维护 **GRUB**,并在它们的网站上提供了丰富的文档。当你在阅读这篇指南时,我们强烈建议你看下 [GNU 官方文档](http://www.gnu.org/software/grub/manual/)。

当系统引导时,你会在主控制台看到如下的 **GRUB** 画面。最开始,你可以根据提示在多个内核版本中选择一个内核(默认情况下,系统将会使用最新的内核启动),并且可以进入 **GRUB** 命令行模式(使用 `c` 键),或者编辑启动项(按下 `e` 键)。

*GRUB 启动画面*

你会考虑使用一个旧版内核启动的原因之一是之前工作正常的某个硬件设备在一次升级后出现了“怪毛病(acting up)”(例如,你可以参考 AskUbuntu 论坛中的[这条链接](http://askubuntu.com/questions/82140/how-can-i-boot-with-an-older-kernel-version))。

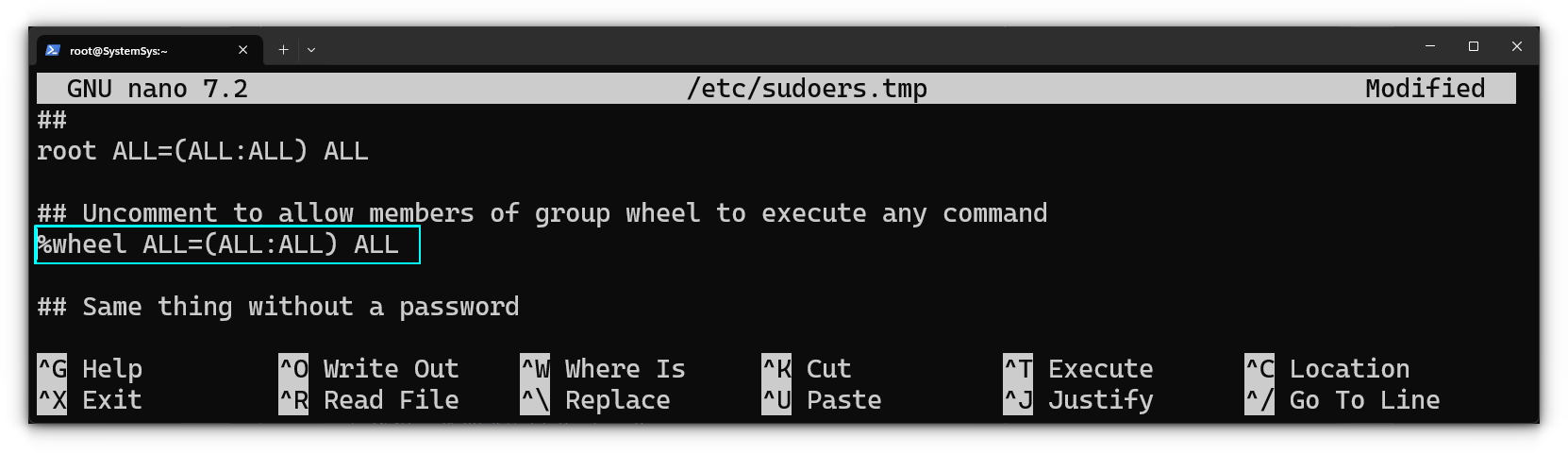

在启动时会从 `/boot/grub/grub.cfg` 或 `/boot/grub2/grub.cfg` 文件中读取**GRUB v2** 的配置文件,而 **GRUB v1** 使用的配置文件则来自 `/boot/grub/grub.conf` 或 `/boot/grub/menu.lst`。这些文件**不应该**直接手动编辑,而应通过 `/etc/default/grub` 的内容和 `/etc/grub.d` 目录中的文件来更新。

在 **CentOS 7** 上,当系统最初完成安装后,会生成如下的配置文件:

```

GRUB_TIMEOUT=5

GRUB_DISTRIBUTOR="$(sed 's, release .*$,,g' /etc/system-release)"

GRUB_DEFAULT=saved

GRUB_DISABLE_SUBMENU=true

GRUB_TERMINAL_OUTPUT="console"

GRUB_CMDLINE_LINUX="vconsole.keymap=la-latin1 rd.lvm.lv=centos_centos7-2/swap crashkernel=auto vconsole.font=latarcyrheb-sun16 rd.lvm.lv=centos_centos7-2/root rhgb quiet"

GRUB_DISABLE_RECOVERY="true"

```

除了在线文档外,你也可以使用下面的命令查阅 GNU GRUB 手册:

```

# info grub

```

如果你对 `/etc/default/grub` 文件中的可用选项特别感兴趣的话,你可以直接查阅配置一节的帮助文档:

```

# info -f grub -n 'Simple configuration'

```

使用上述命令,你会发现 `GRUB_TIMEOUT` 用于设置启动画面出现和系统自动开始启动(除非被用户中断)之间的时间。当该变量值为 `-1` 时,除非用户主动做出选择,否则不会开始启动。

当同一台机器上安装了多个操作系统或内核后,`GRUB_DEFAULT` 就需要用一个整数来指定 GRUB 启动画面默认选择启动的操作系统或内核条目。我们既可以通过上述启动画面查看启动条目列表,也可以使用下面的命令:

### 在 CentOS 和 openSUSE 系统上

```

# awk -F\' '$1=="menuentry " {print $2}' /boot/grub2/grub.cfg

```

### 在 Ubuntu 系统上

```

# awk -F\' '$1=="menuentry " {print $2}' /boot/grub/grub.cfg

```

如下图所示的例子中,如果我们想要使用版本为 `3.10.0-123.el7.x86_64` 的内核(第四个条目),我们需要将 `GRUB_DEFAULT` 设置为 `3`(条目从零开始编号),如下所示:

```

GRUB_DEFAULT=3

```

*使用旧版内核启动系统*

最后一个需要特别关注的 GRUB 配置变量是 `GRUB_CMDLINE_LINUX`,它是用来给内核传递选项的。我们可以在 [内核变量文件](https://www.kernel.org/doc/Documentation/kernel-parameters.txt) 和 [`man 7 bootparam`](http://man7.org/linux/man-pages/man7/bootparam.7.html) 中找到能够通过 GRUB 传递给内核的选项的详细文档。

我的 **CentOS 7** 服务器上当前的选项是:

```

GRUB_CMDLINE_LINUX="vconsole.keymap=la-latin1 rd.lvm.lv=centos_centos7-2/swap crashkernel=auto vconsole.font=latarcyrheb-sun16 rd.lvm.lv=centos_centos7-2/root rhgb quiet"

```

为什么你希望修改默认的内核参数或者传递额外的选项呢?简单来说,在很多情况下,你需要告诉内核某些由内核自身无法判断的硬件参数,或者是覆盖一些内核检测的值。

不久之前,就在我身上发生过这样的事情,当时我在自己已用了 10 年的老笔记本上尝试了衍生自 **Slackware** 的 **Vector Linux**。完成安装后,内核并没有检测出我的显卡的正确配置,所以我不得不通过 GRUB 传递修改过的内核选项来让它工作。

另外一个例子是当你需要将系统切换到单用户模式以执行维护工作时。为此,你可以直接在 `GRUB_CMDLINE_LINUX` 变量中直接追加 `single` 并重启即可:

```

GRUB_CMDLINE_LINUX="vconsole.keymap=la-latin1 rd.lvm.lv=centos_centos7-2/swap crashkernel=auto vconsole.font=latarcyrheb-sun16 rd.lvm.lv=centos_centos7-2/root rhgb quiet single"

```

编辑完 `/etc/default/grub` 之后,你需要运行 `update-grub` (在 **Ubuntu** 上)或者 `grub2-mkconfig -o /boot/grub2/grub.cfg` (在 **CentOS** 和 **openSUSE** 上)命令来更新 `grub.cfg` 文件(否则,改动会在系统启动时丢失)。

这条命令会处理早先提到的那些启动配置文件来更新 `grub.cfg` 文件。这种方法可以确保改动持久化,而在启动时刻通过 GRUB 传递的选项仅在当前会话期间有效。

### 修复 Linux GRUB 问题

如果你安装了第二个操作系统,或者由于人为失误而导致你的 GRUB 配置文件损坏了,依然有一些方法可以让你恢复并能够再次启动系统。

在启动画面中按下 `c` 键进入 GRUB 命令行模式(记住,你也可以按下 `e` 键编辑默认启动选项),并可以在 GRUB 提示中输入 `help` 命令获得可用命令:

*修复 Linux 的 Grub 配置问题*

我们将会着重关注 **ls** 命令,它会列出已安装的设备和文件系统,并且我们将会看看它查找到的东西。在下面的图片中,我们可以看到有 4 块硬盘(`hd0` 到 `hd3`)。

貌似只有 `hd0` 已经分区了(msdos1 和 msdos2 可以证明,这里的 1 和 2 是分区号,msdos 则是分区方案)。

现在我们来看看能否在第一个分区 `hd0`(**msdos1**)上找到 GRUB。这种方法允许我们启动 Linux,并且使用高级工具修复配置文件,或者如果有必要的话,干脆重新安装 GRUB:

```

# ls (hd0,msdos1)/

```

从高亮区域可以发现,`grub2` 目录就在这个分区:

*查找 Grub 配置*

一旦我们确信了 GRUB 位于 (**hd0, msdos1**),那就让我们告诉 GRUB 该去哪儿查找它的配置文件并指示它去尝试启动它的菜单:

```

set prefix=(hd0,msdos1)/grub2

set root=(hd0,msdos1)

insmod normal

normal

```

*查找并启动 Grub 菜单*

然后,在 GRUB 菜单中,选择一个条目并按下回车键以使用它启动。一旦系统成功启动后,你就可以运行 `grub2-install /dev/sdX` 命令修复问题了(将 `sdX` 改成你想要安装 GRUB 的设备)。然后启动信息将会更新,并且所有相关文件都会得到恢复。

```

# grub2-install /dev/sdX

```

其它更加复杂的情景及其修复建议都记录在 [Ubuntu GRUB2 故障排除指南](https://help.ubuntu.com/community/Grub2/Troubleshooting) 中。该指南中阐述的概念对于其它发行版也是有效的。

### 总结

本文向你介绍了 GRUB,并指导你可以在何处找到线上和线下的文档,同时说明了如何面对由于引导加载相关的问题而导致系统无法正常启动的情况。

幸运的是,GRUB 是文档支持非常丰富的工具之一,你可以使用我们在文中分享的资源非常轻松地获取已安装的文档或在线文档。

你有什么问题或建议吗?请不要犹豫,使用下面的评论框告诉我们吧。我们期待着来自你的回复!

---

via: <http://www.tecmint.com/configure-and-troubleshoot-grub-boot-loader-linux/>

作者:[Gabriel Cánepa](http://www.tecmint.com/author/gacanepa/) 译者:[ChrisLeeGit](https://github.com/chrisleegit) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,745 | 我的 Android 开发者之路以及我在其中学到了什么 | http://www.zdominguez.com/2016/08/winging-it-how-i-got-to-be-android-dev.html | 2016-09-05T19:21:03 | [

"开发"

] | https://linux.cn/article-7745-1.html | 大家都说所有的关系都需要经历两年、七年甚至十年的磨砺。我忘了是谁说的这句话,但肯定有人在几年前这么跟我说过。

下周是我来悉尼两周年,所以我想现在正是我写这篇文章的好时候。

去年五月份参加 I/O 年会的时候,我遇到了亚斯曼女士,她十分漂亮。她向我询问我是如何成长为一名安卓开发者的,当我说完我的经历时,她认为我应该写个博客记下来。所以亚斯曼,如你所愿,虽然迟了点,但好过没做。;)

### 故事的开始

如果有件事我可能希望你知道,那就是我发现自己有选择困难症。你最好的朋友是谁?你最喜欢的食物是什么?你应该给你的玩具熊猫命名吗?我连这些问题都不知道该怎么回答才好。所以你可以想象到,16 岁的、即将高中毕业的我对于专业选择根本就没有任何想法。那我最初申请的大学是?在交表给注册员前,我在她面前逐字掂量着写下这个打算申请的专业(商业经济学)。

可我最后去了另外一间学校,就读电子与通信工程。大一时我有一门计算机编程课程。但我很讨厌编程,十分地讨厌。关于编程的一切我都一无所知。我曾发誓再也不要写代码了。

我大学毕业后的第一份工作是在英特尔做产品工程师并在那呆了两年。我很迷茫,无所适从,整天长时间工作。这在我意料之中,身为成年人难道不该努力工作吗?可之后菲律宾的半导体行业开始呈现颓势,大批工厂纷纷倒闭,以前由我们维护一些产品被转移到其他分公司。我便决定去找另一份工作而不是等着被裁员,因为被裁员后我都不知道自己多久才能找到另一份工作。

### 现在呢?

我想留在城市里找到一份工作,但我不想呆在正在没落的半导体行业里了。但话说回来,我又不知道该做什么好。对了,我可是拿了毕业证书的工程师,所以从技术上来说我可以在电信运营商或电视台找到工作。可这种时候,如果想入职电信运营商,我应该在大学毕业之际就去他们那实习,这样更容易被录用。可惜我没有,所以我放弃了这个想法。虽然有很多软件开发人员的招聘信息,但我讨厌编程,所以我真的不知道怎么做才好。

接下来是我第一个幸运的机遇,我很幸运地遇到了信任我的上司,我也和她坦诚了我什么都不会。之后我不得不边工作边学习,一开始这个过程很漫长。无需多言,我在这份工作上学到了很多,也结识了很多很好的人,与我一起的是一群很厉害的同事(我们曾开发出安装在 SIM 卡上的 APP)。但更重要的是我开始踏上了软件开发的征途。

最后我做得更多是一些公司的琐事(十分无聊)直到项目完结。换句话说,我总在是在办公室里闲逛并坐等发薪。之后我发现这确实是在浪费时间,2009 年的时候,我不停地接触到关于谷歌的新系统 Android 的消息,并得知它的 SDK 已经公布!是时候尝试一波了。于是我安装了所有相关软件并着手 Android 开发。

### 事情变得有趣了

所以现在我能够构建一个在运行在仿真器的 Hello World 应用,在我看来意味着我有胜任安卓开发工作的能力。我加入了一个创业公司,并且再次坦诚我不知道该怎么做,我只是接触过一些;但如果你们愿意付薪水给我继续尝试,我们就可以成为朋友。然后我很幸运地遇到另一个机遇。

那时成为开发者是一件令人欣喜的事。StackOverflow 上的 Android 开发社区非常小,我们都在相互交流学习,说真的,我认为里面的所有人都很友好、很豪迈(注 1)!

我最后去了一家企业,这家企业的移动开发团队在马尼拉、悉尼、纽约都设有办公地点。而我是马尼拉办公地点的第一个安卓开发人员,但那时我很习惯,并没有在意。

在那里我认识了最后令我永远感激的引荐我参与 Domain 项目的人。Domain 项目不管在个人或职业上对我来说都意味深重。我和一支很有才华的团队一起共事,也从没见过一个公司能如此执着于一款产品。Domain 让我实现了参加 I/O 年会的梦。与他们共事后我懂得了很多之前没想到的可爱特性(注 2)。这是又一个幸运的机遇,我是说最大限度地利用它。

### 然后呢?

我想说的是,虽然这些年都在晃荡,但至少我很诚实,对吧?如上就是我所学到的全部东西。说一句「我不懂」没什么可怕的。有时候我们是该装懂,但更多时候我们需要坦诚地接受这样一个事实:我们还不懂。

别害怕尝试新事物,不管它让你感觉多害怕。我知道说比做简单。但总有一些东西能让你鼓起勇气动手去尝试的(注3)。Lundagin mo, baby!(LCTT 译注:一首歌名)

注 1: 我翻阅着以前在 StackOverflow 提的问题,认真想想,如果现在我问他们这些,估计会收到很多「你是谁啊,傻瓜」的评论。我不知道是不是因为我老了,而且有些愤世妒俗。但关键是,我们有缘在同一个社区中,所以大家相互之间友善些,好吗?

注 2: 这一点写在另一篇文章里了。

注 3: 我还清晰地记得第一次申请 Android 开发职位的情形:我写完求职信后又通读了一遍,提交前鼠标在发送按钮上不断徘徊,深呼吸之后我趁改变主意之前把它发出去了。

---

via: <http://www.zdominguez.com/2016/08/winging-it-how-i-got-to-be-android-dev.html>

作者:[Zarah Dominguez](https://plus.google.com/102371834744366149197) 译者:[JianhuanZhuo](https://github.com/JianhuanZhuo) 校对:[PurlingNayuki](https://github.com/PurlingNayuki)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 302 | Found | null |

7,746 | LFCS 系列第十四讲: Linux 进程资源用量监控和按用户设置进程限制 | http://www.tecmint.com/monitor-linux-processes-and-set-process-limits-per-user/ | 2016-09-05T20:00:31 | [

"进程",

"LFCS"

] | https://linux.cn/article-7746-1.html | 由于 2016 年 2 月 2 号开始启用了新的 LFCS 考试要求,我们在已经发表的 [LFCS 系列](http://www.tecmint.com/sed-command-to-create-edit-and-manipulate-files-in-linux/) 基础上增加了一些必要的主题。为了准备考试,同时也建议你看看 [LFCE 系列](http://www.tecmint.com/installing-network-services-and-configuring-services-at-system-boot/) 文章。

*第十四讲: 监控 Linux 进程并为每个用户设置进程限制*

每个 Linux 系统管理员都应该知道如何验证硬件、资源和主要进程的完整性和可用性。另外,基于每个用户设置资源限制也是其中一项必备技能。

在这篇文章中,我们会介绍一些能够确保系统硬件和软件正常工作的方法,这些方法能够避免潜在的会导致生产环境下线或钱财损失的问题发生。

### 报告 Linux 进程统计信息

你可以使用 **mpstat** 单独查看每个处理器或者系统整体的活动,可以是每次一个快照或者动态更新。

为了使用这个工具,你首先需要安装 **sysstat**:

```

# yum update && yum install sysstat [基于 CentOS 的系统]

# aptitutde update && aptitude install sysstat [基于 Ubuntu 的系统]

# zypper update && zypper install sysstat [基于 openSUSE 的系统]

```

你可以在 [在 Linux 中学习 Sysstat 和其中的工具 mpstat、pidstat、iostat 和 sar](http://www.tecmint.com/sysstat-commands-to-monitor-linux/) 了解更多和 sysstat 和其中的工具相关的信息。

安装完 **mpstat** 之后,就可以使用它生成处理器统计信息的报告。

你可以使用下面的命令每隔 2 秒显示所有 CPU(用 `-P` ALL 表示)的 CPU 利用率(`-u`),共显示 **3** 次。

```

# mpstat -P ALL -u 2 3

```

**示例输出:**

```

Linux 3.19.0-32-generic (tecmint.com) Wednesday 30 March 2016 _x86_64_ (4 CPU)

11:41:07 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

11:41:09 IST all 5.85 0.00 1.12 0.12 0.00 0.00 0.00 0.00 0.00 92.91

11:41:09 IST 0 4.48 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 94.53

11:41:09 IST 1 2.50 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 97.00

11:41:09 IST 2 6.44 0.00 0.99 0.00 0.00 0.00 0.00 0.00 0.00 92.57

11:41:09 IST 3 10.45 0.00 1.99 0.00 0.00 0.00 0.00 0.00 0.00 87.56

11:41:09 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

11:41:11 IST all 11.60 0.12 1.12 0.50 0.00 0.00 0.00 0.00 0.00 86.66

11:41:11 IST 0 10.50 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 88.50

11:41:11 IST 1 14.36 0.00 1.49 2.48 0.00 0.00 0.00 0.00 0.00 81.68

11:41:11 IST 2 2.00 0.50 1.00 0.00 0.00 0.00 0.00 0.00 0.00 96.50

11:41:11 IST 3 19.40 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 79.60

11:41:11 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

11:41:13 IST all 5.69 0.00 1.24 0.00 0.00 0.00 0.00 0.00 0.00 93.07

11:41:13 IST 0 2.97 0.00 1.49 0.00 0.00 0.00 0.00 0.00 0.00 95.54

11:41:13 IST 1 10.78 0.00 1.47 0.00 0.00 0.00 0.00 0.00 0.00 87.75

11:41:13 IST 2 2.00 0.00 1.00 0.00 0.00 0.00 0.00 0.00 0.00 97.00

11:41:13 IST 3 6.93 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 92.57

Average: CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

Average: all 7.71 0.04 1.16 0.21 0.00 0.00 0.00 0.00 0.00 90.89

Average: 0 5.97 0.00 1.16 0.00 0.00 0.00 0.00 0.00 0.00 92.87

Average: 1 9.24 0.00 1.16 0.83 0.00 0.00 0.00 0.00 0.00 88.78

Average: 2 3.49 0.17 1.00 0.00 0.00 0.00 0.00 0.00 0.00 95.35

Average: 3 12.25 0.00 1.16 0.00 0.00 0.00 0.00 0.00 0.00 86.59

```

要查看指定的 **CPU(**在下面的例子中是 **CPU 0)**,可以使用:

```

# mpstat -P 0 -u 2 3

```

**示例输出:**

```

Linux 3.19.0-32-generic (tecmint.com) Wednesday 30 March 2016 _x86_64_ (4 CPU)

11:42:08 IST CPU %usr %nice %sys %iowait %irq %soft %steal %guest %gnice %idle

11:42:10 IST 0 3.00 0.00 0.50 0.00 0.00 0.00 0.00 0.00 0.00 96.50

11:42:12 IST 0 4.08 0.00 0.00 2.55 0.00 0.00 0.00 0.00 0.00 93.37

11:42:14 IST 0 9.74 0.00 0.51 0.00 0.00 0.00 0.00 0.00 0.00 89.74

Average: 0 5.58 0.00 0.34 0.85 0.00 0.00 0.00 0.00 0.00 93.23

```

上面命令的输出包括这些列:

* `CPU`: 整数表示的处理器号或者 all 表示所有处理器的平均值。

* `%usr`: 运行在用户级别的应用的 CPU 利用率百分数。

* `%nice`: 和 `%usr` 相同,但有 nice 优先级。

* `%sys`: 执行内核应用的 CPU 利用率百分比。这不包括用于处理中断或者硬件请求的时间。

* `%iowait`: 指定(或所有)CPU 的空闲时间百分比,这表示当前 CPU 处于 I/O 操作密集的状态。更详细的解释(附带示例)可以查看[这里](http://veithen.github.io/2013/11/18/iowait-linux.html)。

* `%irq`: 用于处理硬件中断的时间所占百分比。

* `%soft`: 和 `%irq` 相同,但是是软中断。

* `%steal`: 虚拟机非自主等待(时间片窃取)所占时间的百分比,即当虚拟机在竞争 CPU 时所从虚拟机管理程序那里“赢得”的时间。应该保持这个值尽可能小。如果这个值很大,意味着虚拟机正在或者将要停止运转。

* `%guest`: 运行虚拟处理器所用的时间百分比。

* `%idle`: CPU 没有运行任何任务所占时间的百分比。如果你观察到这个值很小,意味着系统负载很重。在这种情况下,你需要查看详细的进程列表、以及下面将要讨论的内容来确定这是什么原因导致的。

运行下面的命令使处理器处于极高负载,然后在另一个终端执行 mpstat 命令:

```

# dd if=/dev/zero of=test.iso bs=1G count=1

# mpstat -u -P 0 2 3

# ping -f localhost # Interrupt with Ctrl + C after mpstat below completes

# mpstat -u -P 0 2 3

```

最后,和 “正常” 情况下 **mpstat** 的输出作比较:

*Linux 处理器相关统计信息报告*

正如你在上面图示中看到的,在前面两个例子中,根据 `%idle` 的值可以判断 **CPU 0** 负载很高。

在下一部分,我们会讨论如何识别资源饥饿型进程,如何获取更多和它们相关的信息,以及如何采取恰当的措施。

### Linux 进程报告

我们可以使用有名的 `ps` 命令,用 `-eo` 选项(根据用户定义格式选中所有进程) 和 `--sort` 选项(指定自定义排序顺序)按照 CPU 使用率排序列出进程,例如:

```

# ps -eo pid,ppid,cmd,%cpu,%mem --sort=-%cpu

```

上面的命令只会显示 `PID`、`PPID`、和进程相关的命令、 CPU 使用率以及 RAM 使用率,并按照 CPU 使用率降序排序。创建 .iso 文件的时候运行上面的命令,下面是输出的前面几行:

*根据 CPU 使用率查找进程*

一旦我们找到了感兴趣的进程(例如 `PID=2822` 的进程),我们就可以进入 `/proc/PID`(本例中是 `/proc/2822`) 列出目录内容。

这个目录就是进程运行的时候保存多个关于该进程详细信息的文件和子目录的目录。

#### 例如:

* `/proc/2822/io` 包括该进程的 IO 统计信息(IO 操作时的读写字符数)。

* `/proc/2822/attr/current` 显示了进程当前的 SELinux 安全属性。

* `/proc/2822/cgroup` 如果启用了 CONFIG*CGROUPS 内核设置选项,这会显示该进程所属的控制组(简称 cgroups),你可以使用下面命令验证是否启用了 CONFIG*CGROUPS:

```

# cat /boot/config-$(uname -r) | grep -i cgroups

```

如果启用了该选项,你应该看到:

```

CONFIG_CGROUPS=y

```

根据 [红帽企业版 Linux 7 资源管理指南](https://access.redhat.com/documentation/en-US/Red_Hat_Enterprise_Linux/7/html/Resource_Management_Guide/index.html) 第一到四章的内容、[openSUSE 系统分析和调优指南](https://doc.opensuse.org/documentation/leap/tuning/html/book.sle.tuning/cha.tuning.cgroups.html) 第九章、[Ubuntu 14.04 服务器文档 Control Groups 章节](https://help.ubuntu.com/lts/serverguide/cgroups.html),你可以使用 `cgroups` 管理每个进程允许使用的资源数目。

`/proc/2822/fd` 这个目录包含每个打开的描述进程的文件的符号链接。下面的截图显示了 tty1(第一个终端) 中创建 **.iso** 镜像进程的相关信息:

*查找 Linux 进程信息*

上面的截图显示 **stdin**(文件描述符 **0**)、**stdout**(文件描述符 **1**)、**stderr**(文件描述符 **2**) 相应地被映射到 **/dev/zero**、 **/root/test.iso** 和 **/dev/tty1**。

更多关于 `/proc` 信息的可以查看 Kernel.org 维护的 “`/proc` 文件系统” 和 Linux 开发者手册。

### 在 Linux 中为每个用户设置资源限制

如果你不够小心、让任意用户使用不受限制的进程数,最终你可能会遇到意外的系统关机或者由于系统进入不可用的状态而被锁住。为了防止这种情况发生,你应该为用户可以启动的进程数目设置上限。

你可以在 **/etc/security/limits.conf** 文件末尾添加下面一行来设置限制:

```

* hard nproc 10

```

第一个字段可以用来表示一个用户、组或者所有人`(*)`, 第二个字段强制限制可以使用的进程数目(nproc) 为 **10**。退出并重新登录就可以使设置生效。

然后,让我们来看看非 root 用户(合法用户或非法用户) 试图引起 shell fork 炸弹 (参见 [WiKi](https://en.wikipedia.org/wiki/Fork_bomb)) 时会发生什么。如果我们没有设置限制, shell fork 炸弹会无限制地启动函数的两个实例,然后无限循环地复制任意一个实例。最终导致你的系统卡死。

但是,如果使用了上面的限制,fort 炸弹就不会成功,但用户仍然会被锁在外面直到系统管理员杀死相关的进程。

*运行 Shell Fork 炸弹*

**提示**: `limits.conf` 文件中可以查看其它 **ulimit** 可以更改的限制。

### 其它 Linux 进程管理工具

除了上面讨论的工具, 一个系统管理员还可能需要:

**a)** 通过使用 **renice** 调整执行优先级(系统资源的使用)。这意味着内核会根据分配的优先级(众所周知的 “**niceness**”,它是一个范围从 `-20` 到 `19` 的整数)给进程分配更多或更少的系统资源。

这个值越小,执行优先级越高。普通用户(而非 root)只能调高他们所有的进程的 niceness 值(意味着更低的优先级),而 root 用户可以调高或调低任何进程的 niceness 值。

renice 命令的基本语法如下:

```

# renice [-n] <new priority> <UID, GID, PGID, or empty> identifier

```

如果 new priority 后面的参数没有(为空),默认就是 PID。在这种情况下,**PID=identifier** 的进程的 niceness 值会被设置为 `<new priority>`。

**b)** 需要的时候中断一个进程的正常执行。这也就是通常所说的[“杀死”进程](http://www.tecmint.com/kill-processes-unresponsive-programs-in-ubuntu/)。实质上,这意味着给进程发送一个信号使它恰当地结束运行并以有序的方式释放任何占用的资源。

按照下面的方式使用 **kill** 命令[杀死进程](http://www.tecmint.com/find-and-kill-running-processes-pid-in-linux/):

```

# kill PID

```

另外,你也可以使用 [pkill](http://www.tecmint.com/how-to-kill-a-process-in-linux/) 结束指定用户`(-u)`、指定组`(-G)` 甚至有共同的父进程 ID `(-P)` 的所有进程。这些选项后面可以使用数字或者名称表示的标识符。

```

# pkill [options] identifier

```

例如:

```

# pkill -G 1000

```

会杀死组 `GID=1000` 的所有进程。而

```

# pkill -P 4993

```

会杀死 `PPID 是 4993` 的所有进程。

在运行 `pkill` 之前,先用 `pgrep` 测试结果、或者使用 `-l` 选项列出进程名称是一个很好的办法。它需要和 `pkill` 相同的参数、但是只会返回进程的 PID(而不会有其它操作),而 `pkill` 会杀死进程。

```

# pgrep -l -u gacanepa

```

用下面的图片说明:

*在 Linux 中查找用户运行的进程*

### 总结

在这篇文章中我们探讨了一些监控资源使用的方法,以便验证 Linux 系统中重要硬件和软件组件的完整性和可用性。

我们也学习了如何在特殊情况下采取恰当的措施(通过调整给定进程的执行优先级或者结束进程)。

我们希望本篇中介绍的概念能对你有所帮助。如果你有任何疑问或者评论,可以使用下面的联系方式联系我们。

---

via: <http://www.tecmint.com/monitor-linux-processes-and-set-process-limits-per-user/>

作者:[Gabriel Cánepa](http://www.tecmint.com/author/gacanepa/) 译者:[ictlyh](https://github.com/ictlyh) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,748 | GitHub 上十个最流行的安全项目 | http://news.softpedia.com/news/the-top-10-most-popular-security-projects-on-github-507934.shtml | 2016-09-06T12:37:07 | [

"安全",

"GitHub"

] | https://linux.cn/article-7748-1.html | 开源正在走向胜利,虽然这一天或许会来的晚一点,但是开源终将胜利。在网络安全社区里,尽管许多公司以商业软件的方式牢牢把握着自己的代码不放,但是也有很多安全方面的开源项目可供专业的安全人员使用。

搜寻这些安全相关的开源软件最好的地方显然是 GitHub。你可以使用该网站上的搜索功能来找到这些有用的工具,但是有一个地方可以让你找到那些安全方面最流行的项目,那就是 GitHub 的展示区,可能知道它的人不多。

从 2014 年开始,GitHub 展示区就会按照分类陈列这些最流行的项目。在展示区中,项目以其所获得的<ruby> 星标数 <rp> ( </rp> <rt> stars </rt> <rp> ) </rp></ruby>排名,这个列表会不断更新当前最流行的项目。

展示区包含的“安全”分类中包含了 24 个项目,这里我们列出了在 GitHub 上排名前十的安全项目。

### 1. osquery - 来自 Facebook

[osquery](https://github.com/facebook/osquery) 将操作系统表示为一个高性能的关系型数据库。这可以让你通过基于 SQL 的查询来获取操作系统数据。通过 osquery,将运行中的进程、加载的内核模块、打开的网络连接、浏览器插件、硬件事件或文件哈希等抽象为 SQL 数据表。

### 2. Metasploit Framework - 来自 Rapid7

[Metasploit Framework](https://github.com/rapid7/metasploit-framework) 是一个针对远程目标主机开发和执行漏洞利用代码的工具。

### 3. Infer - 来自 Facebook

Facebook [Infer](https://github.com/facebook/infer) 是一个静态分析工具。用它来分析 Objective-C、Java 或 C 代码,可以列出其中潜在的缺陷。在代码上传到手机设备之前,可以用 Infer 来找到那些致命缺陷,可以防止出现崩溃或性能下降。

### 4. Brakeman - 来自 PresidentBeef

[Brakeman](https://github.com/presidentbeef/brakeman) 是一个开源的静态分析工具,它可以检查 Ruby on Rails 应用的安全漏洞。

### 5. Radare2 - 来自 Radare 项目

[Radare](https://github.com/radare/radare2) 是一个取证工具,是一个可编程的命令行十六进制编辑器,可以打开磁盘文件。它也支持二进制分析、反汇编代码、调试程序、连接到远程 gdb 服务器等等功能。

### 6. OS X Auditor - 来自 Jean-Philippe Teissier

[OS X Auditor](https://github.com/jipegit/OSXAuditor) 是一个自由的 Mac OS X 计算机取证工具,它可以解析各种类型的文件,获取其中的可疑内容。

### 7. BeEF - 来自 BeEF 项目

[BeEF](https://github.com/beefproject/beef) 简单的来说就是一个<ruby> 浏览器利用框架 <rp> ( </rp> <rt> Browser Exploitation Framework </rt> <rp> ) </rp></ruby>。它是一个针对浏览器的脆弱性测试工具。

### 8. Cuckoo - 来自 Cuckoo Sandbox 项目

[Cuckoo Sandbox](https://github.com/cuckoosandbox/cuckoo) 是一个自动的恶意软件动态分析系统。简单的来说,就是你可以将任何可疑的文件丢给它,只需要几秒钟,Cuckoo 就可以给出在隔离的环境中执行的大致结果。

### 9. Scumblr - 来自 Netflix

[Scumblr](https://github.com/Netflix/Scumblr) 是一个 Web 应用,它可以周期性地进行检查,并根据检查结果采取不同的处置方法。

### 10. Moloch - 来自 AOL

[Moloch](https://github.com/aol/moloch) 是一个开源的、大规模的,抓包、索引并存储进数据库的系统。它提供了一个简单的 Web 界面,可以用来查看、检索和导出所捕获的数据包。它支持 API,可以直接下载 PCAP 数据和 JSON 格式的会话数据。Moloch 并不是用来替换 IDS 的,而是用来配合它们以标准的 PCAP 格式存储并索引所有的网络数据,从而可以快速访问。Moloch 可以跨系统部署,并可以处理高达每秒 10 Gb 的流量。

以上就是现在 GitHub 上最流行的安全相关的开源项目。你可以经常去展示区看看有无新的流行项目出现。

| 301 | Moved Permanently | null |

7,749 | Azure SQL 数据库已经支持 JSON | https://azure.microsoft.com/en-us/blog/json-support-is-generally-available-in-azure-sql-database/ | 2016-09-06T13:43:55 | [

"JSON",

"Azure"

] | https://linux.cn/article-7749-1.html | 我们很高兴地宣布你现在可以在 Azure SQL 中查询及存储关系型数据或者 JSON 了、Azure SQL 数据库提供了读取 JSON 文本数据的简单的内置函数,将 JSON 文本转化成表,以及将表的数据转化成 JSON。

你可以使用 JSON 函数来从 JSON 文本中提取值([JSON\_VALUE](https://msdn.microsoft.com/en-us/library/dn921898.aspx))、提取对象([JSON\_QUERY](https://msdn.microsoft.com/en-us/library/dn921884.aspx)), 更新JSON 中的值([JSON\_MODIFY](https://msdn.microsoft.com/en-us/library/dn921892.aspx)),并且验证 JSON 文本的正确性([ISJSON](https://msdn.microsoft.com/en-us/library/dn921896.aspx))。[OPENJSON](https://msdn.microsoft.com/en-us/library/dn921885.aspx) 函数让你可以将 JSON 文本转化成表结构。最后,JSON 功能函数可以让你很简单地从 SQL 查询中使用 [FOR JSON](https://msdn.microsoft.com/en-us/library/dn921882.aspx) 从句来获得 JSON 文本结果。

### 你可以用 JSON 做什么?

Azure SQL 数据库中的 JSON 可以让您构建并与现代 web、移动设备和 HTML5/单页应用、诸如 Azure DocumentDB 等包含 JSON 格式化数据的 NoSQL 存储等交换数据,分析来自不同系统和服务的日志和消息。现在你可以轻易地将 Azure SQL 数据库与任何使用使用 JSON 的服务集成。

#### 轻易地开放数据给现代框架和服务

你有没有在使用诸如 REST 或者 Azure App 使用 JSON 来交换数据的服务?你有使用诸如 AngularJS、ReactJS、D3 或者 JQuery 等使用 JSON 的组件或框架么?使用新的 JSON 功能函数,你可以轻易地格式化存储在 Azure SQL 数据库中的数据,并将它用在任何现代服务或者应用中。

#### 轻松采集 JSON 数据

你有在使用移动设备、传感器、如 Azure Stream Analytics 或者 Insight 这样产生 JSON 的服务、如 Azure DocumentDB 或者 MongoDB 这样存储 JSON 的系统么?你需要在 Azure SQL 数据中使用熟悉的 SQL 语句来查询并分析 JSON 数据么?现在你可以轻松采集 JSON 数据并存储到 Azure SQL 数据库中,并且可以使用任何 Azure SQL 数据库支持的语言或者工具来查询和分析加载的数据。

#### 简化你的数据模型

你需要同时存储及查询数据库中关系型及半结构化的数据么?你需简化像 NoSQL 平台下的数据模型么?现在你可以在一张表中同时存储结构化数据及非结构化数据了。在 Azure SQL 数据库中,你可以同时从关系型及 NoSQL 的世界中使用最好的方法来调整你的数据模型。Azure SQL 数据库让你可以使用 Transact-SQL 语言来查询关系及 JSON 数据。程序和工具将不会在从表中取出的值及 JSON 文本中提取的值看出差别。

### 下一步

要学习如何在你的应用中集成 JSON,查看我们的[开始学习](https://azure.microsoft.com/en-us/documentation/articles/sql-database-json-features/)页面或者 [Channel 9的视频](https://channel9.msdn.com/Shows/Data-Exposed/SQL-Server-2016-and-JSON-Support)。要了解不同的情景下如何集成 JSON,观看 Channel 9 的视频或者在这些 [JSON 分类文章](http://blogs.msdn.com/b/sqlserverstorageengine/archive/tags/json/)中查找你感兴趣的使用情景。

我们将持续增加新的 JSON 特性并让 JSON 支持的更好。请敬请关注。

---

via: <https://azure.microsoft.com/en-us/blog/json-support-is-generally-available-in-azure-sql-database/>

作者:[Jovan Popovic](https://azure.microsoft.com/en-us/blog/author/jovanpop/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | We are happy to announce that you can now query and store both relational and textual data formatted in JavaScript Object Notation (JSON) using Azure SQL Database. Azure SQL Database provides simple built-in functions that read data from JSON text, transform JSON text into table, and format data from SQL tables as JSON.

You can use JSON functions that enable you to extract value from JSON text ([JSON_VALUE](https://msdn.microsoft.com/en-us/library/dn921898.aspx)), extract object from JSON ([JSON_QUERY](https://msdn.microsoft.com/en-us/library/dn921884.aspx)), update some value in JSON text ([JSON_MODIFY](https://msdn.microsoft.com/en-us/library/dn921892.aspx)), and verify that JSON text is properly formatted ([ISJSON](https://msdn.microsoft.com/en-us/library/dn921896.aspx)). [OPENJSON](https://msdn.microsoft.com/en-us/library/dn921885.aspx) function enables you to convert JSON text into a table structure. Finally, JSON functionalities enable you to easily format results of any SQL query as JSON text using the [FOR JSON](https://msdn.microsoft.com/en-us/library/dn921882.aspx) clause.

## What can you do with JSON?

JSON in Azure SQL Database enables you to build and exchange data with modern web, mobile, and HTM5/JavaScript single-page applications, NoSql stores such as Azure DocumentDB that contain data formatted as JSON, and to analyze logs and messages collected from different systems and services. Now you can easily integrate your Azure SQL Database with any service that uses JSON.

#### Easily expose your data to modern frameworks and services

Do you use services that exchange data in JSON format, such as REST services or Azure App Services? Do you have components or frameworks that use JSON, such as Angular JS, ReactJS, D3, or JQuery? With new JSON functionalities, you can easily format data stored in Azure SQL Database as JSON and expose it to any modern service or application.

#### Easy ingestion of JSON data

Are you working with mobile devices or sensors, services that produce JSON such as Azure Stream Analytics or Application Insight, or systems that store data in JSON format such as Azure DocumentDB or MongoDB? Do you need to query and analyze JSON data using well-known SQL language or tools that work with Azure SQL Database? Now, you can easily ingest JSON data and store it into Azure SQL Database, and use any language or tool that works with Azure SQL Database to query and analyze loaded information.

#### Simplify your data models

Do you need to store and query both relational and semi-structured data in your database? Do you need to simplify your data models like in NoSQL data platforms? Now you can combine structured relational data with schema-less data stored as JSON text in the same table. In Azure SQL Database you can use the best approaches both from relational and NoSQL worlds to tune your data model. Azure SQL Database enables you to query both relational and JSON data with the standard Transact-SQL language. Applications and tools would not see any difference between values taken from table columns and the values extracted from JSON text.

## Next steps

To learn how to integrate JSON in your application, check out our [Getting Started](https://azure.microsoft.com/en-us/documentation/articles/sql-database-json-features/) page or [Channel 9 video](https://channel9.msdn.com/Shows/Data-Exposed/SQL-Server-2016-and-JSON-Support). To learn about various scenarios that show how to integrate JSON in your application, see demos in this [Channel 9 video](https://www.google.rs/url?sa=t&rct=j&q=&esrc=s&source=web&cd=2&ved=0ahUKEwjJpffGwf3LAhWkNJoKHcZKCsQQFgggMAE&url=https%3A%2F%2Fchannel9.msdn.com%2FEvents%2FDataDriven%2FSQLServer2016%2FJSON-as-a-bridge-betwen-NoSQL-and-relational-worlds&usg=AFQjCNG-exMKrF1Qdk3Xx5LrD-57LC7_sw&sig2=7xZJPQDAlUDh67qlwbbcrQ&cad=rja) or find some scenario that might be interesting for your use case in these [JSON Blog posts](https://blogs.msdn.com/b/sqlserverstorageengine/archive/tags/json/).

Stay tuned because we will constantly add new JSON features and make JSON support even better. |

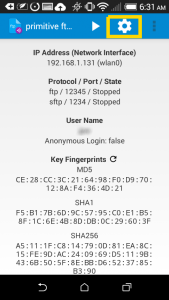

7,751 | 如何在 CentOS 7 用 cPanel 配置 Nginx 反向代理 | http://linoxide.com/linux-how-to/set-nginx-reverse-proxy-centos-7-cpanel/ | 2016-09-07T06:34:00 | [

"Nginx",

"Web",

"反向代理"

] | /article-7751-1.html |

Nginx 是最快和最强大的 Web 服务器之一,以其高性能和低资源占用率而闻名。它既可以被安装为一个独立的 Web 服务器,也可以安装成反向代理 Web 服务器。在这篇文章,我将讨论在安装了 cPanel 管理系统的 Centos 7 服务器上安装 Nginx 作为 Apache 的反向代理服务器。

Nginx 作为前端服务器用反向代理为静态文件提供服务,Apache 作为后端为动态文件提供服务。这个设置将整体提高服务器的性能。

让我们过一遍在已经安装好 cPanel 11.52 的 CentOS 7 x86\_64 服务器上配置 Nginx 作为反向代理的安装过程。

首先,我们需要安装 EPEL 库来启动这个进程

### 第一步: 安装 EPEL 库

```

root@server1 [/usr]# yum -y install epel-release

Loaded plugins: fastestmirror, tsflags, universal-hooks

Loading mirror speeds from cached hostfile

* EA4: 66.23.237.210

* base: mirrors.linode.com

* extras: mirrors.linode.com

* updates: mirrors.linode.com

Resolving Dependencies

--> Running transaction check

---> Package epel-release.noarch 0:7-5 will be installed

--> Finished Dependency Resolution

Dependencies Resolved

========================================================================================

Package Arch Version Repository Size

========================================================================================

Installing:

epel-release noarch 7-5 extras 14 k

```

### 第二步: 可以安装 nDeploy 的 CentOS RPM 库来安装我们所需的 nDeploy Web 类软件和 Nginx 插件

```

root@server1 [/usr]# yum -y install http://rpm.piserve.com/nDeploy-release-centos-1.0-1.noarch.rpm

Loaded plugins: fastestmirror, tsflags, universal-hooks

nDeploy-release-centos-1.0-1.noarch.rpm | 1.7 kB 00:00:00

Examining /var/tmp/yum-root-ei5tWJ/nDeploy-release-centos-1.0-1.noarch.rpm: nDeploy-release-centos-1.0-1.noarch

Marking /var/tmp/yum-root-ei5tWJ/nDeploy-release-centos-1.0-1.noarch.rpm to be installed

Resolving Dependencies

--> Running transaction check

---> Package nDeploy-release-centos.noarch 0:1.0-1 will be installed

--> Finished Dependency Resolution

Dependencies Resolved

========================================================================================

Package Arch Version Repository Size

========================================================================================

Installing:

nDeploy-release-centos noarch 1.0-1 /nDeploy-release-centos-1.0-1.noarch 110

```

### 第三步:安装 nDeploy 和 Nginx nDeploy 插件

```

root@server1 [/usr]# yum --enablerepo=ndeploy install nginx-nDeploy nDeploy

Loaded plugins: fastestmirror, tsflags, universal-hooks

epel/x86_64/metalink | 9.9 kB 00:00:00

epel | 4.3 kB 00:00:00

ndeploy | 2.9 kB 00:00:00

(1/4): ndeploy/7/x86_64/primary_db | 14 kB 00:00:00

(2/4): epel/x86_64/group_gz | 169 kB 00:00:00

(3/4): epel/x86_64/primary_db | 3.7 MB 00:00:02

Dependencies Resolved

========================================================================================

Package Arch Version Repository Size

========================================================================================

Installing:

nDeploy noarch 2.0-11.el7 ndeploy 80 k

nginx-nDeploy x86_64 1.8.0-34.el7 ndeploy 36 M

Installing for dependencies:

PyYAML x86_64 3.10-11.el7 base 153 k

libevent x86_64 2.0.21-4.el7 base 214 k

memcached x86_64 1.4.15-9.el7 base 84 k

python-inotify noarch 0.9.4-4.el7 base 49 k

python-lxml x86_64 3.2.1-4.el7 base 758 k

Transaction Summary

========================================================================================

Install 2 Packages (+5 Dependent packages)

```

通过以上这些步骤,我们完成了在我们的服务器上 Nginx 插件的安装。现在我们可以配置 Nginx 作为反向代理和为已有的 cPanel 用户账户创建虚拟主机,为此我们可以运行如下脚本。

### 第四步:启动 Nginx 作为默认的前端 Web 服务器,并创建默认的配置文件

```

root@server1 [/usr]# /opt/nDeploy/scripts/cpanel-nDeploy-setup.sh enable

Modifying apache http and https port in cpanel

httpd restarted successfully.

Created symlink from /etc/systemd/system/multi-user.target.wants/nginx.service to /usr/lib/systemd/system/nginx.service.

Created symlink from /etc/systemd/system/multi-user.target.wants/ndeploy_watcher.service to /usr/lib/systemd/system/ndeploy_watcher.service.

Created symlink from /etc/systemd/system/multi-user.target.wants/ndeploy_backends.service to /usr/lib/systemd/system/ndeploy_backends.service.

ConfGen:: saheetha

ConfGen:: satest

```

你可以看到这个脚本将修改 Apache 的端口从 80 到另一个端口来让 Nginx 作为前端 Web 服务器,并为现有的 cPanel 用户创建虚拟主机配置文件。一旦完成,确认 Apache 和 Nginx 的状态。

#### Apache 状态:

```

root@server1 [/var/run/httpd]# systemctl status httpd

● httpd.service - Apache Web Server

Loaded: loaded (/usr/lib/systemd/system/httpd.service; enabled; vendor preset: disabled)

Active: active (running) since Mon 2016-01-18 06:34:23 UTC; 12s ago

Process: 25606 ExecStart=/usr/sbin/apachectl start (code=exited, status=0/SUCCESS)

Main PID: 24760 (httpd)

CGroup: /system.slice/httpd.service

‣ 24760 /usr/local/apache/bin/httpd -k start

Jan 18 06:34:23 server1.centos7-test.com systemd[1]: Starting Apache Web Server...

Jan 18 06:34:23 server1.centos7-test.com apachectl[25606]: httpd (pid 24760) already running

Jan 18 06:34:23 server1.centos7-test.com systemd[1]: Started Apache Web Server.

```

#### Nginx 状态:

```

root@server1 [~]# systemctl status nginx

● nginx.service - nginx-nDeploy - high performance web server

Loaded: loaded (/usr/lib/systemd/system/nginx.service; enabled; vendor preset: disabled)

Active: active (running) since Sun 2016-01-17 17:18:29 UTC; 13h ago

Docs: http://nginx.org/en/docs/

Main PID: 3833 (nginx)

CGroup: /system.slice/nginx.service

├─ 3833 nginx: master process /usr/sbin/nginx -c /etc/nginx/nginx.conf

├─25473 nginx: worker process

├─25474 nginx: worker process

└─25475 nginx: cache manager process

Jan 17 17:18:29 server1.centos7-test.com systemd[1]: Starting nginx-nDeploy - high performance web server...

Jan 17 17:18:29 server1.centos7-test.com nginx[3804]: nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

Jan 17 17:18:29 server1.centos7-test.com nginx[3804]: nginx: configuration file /etc/nginx/nginx.conf test is successful

Jan 17 17:18:29 server1.centos7-test.com systemd[1]: Started nginx-nDeploy - high performance web server.

```

Nginx 作为前端服务器运行在 80 端口,Apache 配置被更改为监听 http 端口 9999 和 https 端口 4430。请看他们的情况:

```

root@server1 [/usr/local/src]# netstat -plan | grep httpd

tcp 0 0 0.0.0.0:4430 0.0.0.0:* LISTEN 17270/httpd

tcp 0 0 0.0.0.0:9999 0.0.0.0:* LISTEN 17270/httpd

tcp6 0 0 :::4430 :::* LISTEN 17270/httpd

tcp6 0 0 :::9999 :::* LISTEN 17270/httpd

```

```

root@server1 [/usr/local/src]# netstat -plan | grep nginx

tcp 0 0 127.0.0.1:80 0.0.0.0:* LISTEN 17802/nginx: master

tcp 0 0 45.79.183.73:80 0.0.0.0:* LISTEN 17802/nginx: master

```

为已有用户创建的虚拟主机的配置文件在 “**/etc/nginx/sites-enabled”**。 这个文件路径包含了 Nginx 主要配置文件。

```

root@server1 [/etc/nginx/sites-enabled]# ll | grep .conf

-rw-r--r-- 1 root root 311 Jan 17 09:02 saheetha.com.conf

-rw-r--r-- 1 root root 336 Jan 17 09:02 saheethastest.com.conf

```

#### 一个域名的示例虚拟主机:

```

server {

listen 45.79.183.73:80;

#CPIPVSIX:80;

# ServerNames

server_name saheetha.com www.saheetha.com;

access_log /usr/local/apache/domlogs/saheetha.com main;

access_log /usr/local/apache/domlogs/saheetha.com-bytes_log bytes_log;

include /etc/nginx/sites-enabled/saheetha.com.include;

}

```

我们可以启动浏览器查看网站来确定 Web 服务器的工作状态。安装后,请阅读服务器上的 web 服务信息。

```

root@server1 [/home]# ip a | grep -i eth0

3: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP qlen 1000

inet 45.79.183.73/24 brd 45.79.183.255 scope global dynamic eth0

root@server1 [/home]# nginx -v

nginx version: nginx/1.8.0

```

Nginx 将会为任何最新在 cPanel 中创建的账户创建虚拟主机。通过这些简单的的步骤,我们能够在一台 CentOS 7 / cPanel 的服务器上配置 Nginx 作为反向代理。

### Nginx 作为反向代理的优势

1. 便于安装和配置。

2. 效率高、性能好。

3. 防止 Ddos 攻击。

4. 支持使用 .htaccess 作为 PHP 的重写规则。

我希望这篇文章对你们有用。感谢你看它。我非常高兴收到你的宝贵意见和建议,并进一步改善。

---

via: <http://linoxide.com/linux-how-to/set-nginx-reverse-proxy-centos-7-cpanel/>

作者:[Saheetha Shameer](http://linoxide.com/author/saheethas/) 译者:[bestony](https://github.com/bestony) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| null | HTTPConnectionPool(host='linoxide.com', port=80): Max retries exceeded with url: /linux-how-to/set-nginx-reverse-proxy-centos-7-cpanel/ (Caused by ConnectTimeoutError(<urllib3.connection.HTTPConnection object at 0x7b83275814e0>, 'Connection to linoxide.com timed out. (connect timeout=10)')) | null |

7,752 | 对比 Android 和 iPhone 的优缺点 | http://www.datamation.com/mobile-wireless/android-vs.-iphone-pros-and-cons.html | 2016-09-08T08:46:00 | [

"iPhone",

"Android"

] | https://linux.cn/article-7752-1.html |

>

> 当我们比较 Android 与 iPhone 的时候,很显然 Android 具有一定的优势,而 iPhone 则在一些关键方面更好。但是,究竟哪个比较好呢?

>

>

>

对 Android 与 iPhone 比较是个个人的问题。

就好比我来说,我两个都用。我深知这两个平台的优缺点。所以,我决定分享我关于这两个移动平台的观点。另外,然后谈谈我对新的 Ubuntu 移动平台的印象和它的优势。

### iPhone 的优点

虽然这些天我是个十足的 Android 用户,但我必须承认 iPhone 在某些方面做的是不错。首先,苹果公司在他们的设备更新方面有更好的成绩。这对于运行着 iOS 的旧设备来说尤其是这样。反观 Android ,如果不是谷歌亲生的 Nexus,它最好也不过是一个更高端的运营商支持的手机,你将发现它们的更新少的可怜或者根本没有。

其中 iPhone 做得很好的另一个领域是应用程序的可用性。展开来说,iPhone 应用程序几乎总是有一个简洁的外观。这并不是说 Android 应用程序就是丑陋的,而是,它们可能只是没有像 iOS 上一样的保持不变的操控习惯和一以贯之的用户体验。两个典型的例子, [Dark Sky](http://darkskyapp.com/) (天气)和 [Facebook Paper](https://www.facebook.com/paper/) 很好表现了 iOS 独有的布局。

再有就是备份过程。 Android 可以备份,默认情况下是备份到谷歌。但是对应用数据起不了太大作用。对比 iPhone ,iCloud 基本上可以对你的 iOS 设备进行了完整备份。

### iPhone 令我失望的地方

对 iPhone 来说,最无可争辩的问题是它的硬件限制要比软件限制更大,换句话来说,就是存储容量问题。

你看,对于大多数 Android 手机,我可以买一个容量较小的手机,然后以后可以添加 SD 卡。这意味着两件事:第一,我可以使用 SD 卡来存储大量的媒体文件。其次,我甚至可以用 SD 卡来存储“一些”我的应用程序。而苹果完全不能这么做。

另一个 iPhone 让我失望的地方是它提供的选择很少。备份您的设备?希望你喜欢 iTunes 或 iCloud 吧。但对一些像我一样用 Linux 的人,那就意味着,我唯一的选择便是使用 iCloud。

要公平的说,如果你愿意越狱,你的 iPhone 还有一些其他解决方案的,但这并不是这篇文章所讲的。 Android 的 解锁 root 也一样。本文章针对的是两个平台的原生设置。

最后,让我们不要忘记这件看起来很小的事—— [iTunes 会删掉用户的音乐](https://blog.vellumatlanta.com/2016/05/04/apple-stole-my-music-no-seriously/),因为它认为和苹果音乐的内容重复了……或者因为一些其它的类似规定。这不是 iPhone 特有的情况?我不同意,因为那些音乐最终就是在 iPhone 上没有了。我能十分肯定地这么说,是因为不管在哪里我都不会说这种谎话。

### Android 的优点

Android 给我最大的好处就是 iPhone 所提供不了的:选择。这包括对应用程序、设备以及手机是整体如何工作的选择。

我爱桌面小工具!对于 iPhone 用户来说,它们也许看上去很蠢。但我可以告诉你,它们可以让我不用打开应用程序就可以看到所需的数据,而无需额外的麻烦。另一个类似的功能,我喜欢安装定制的桌面界面,而不是我的手机默认的那个!

最后,我可以通过像 [Airdroid](https://www.airdroid.com/) 和 [Tasker](http://tasker.dinglisch.net/) 这样的工具给我的智能手机添加计算机级的完整功能。AirDroid 可以让我把我的 Android 手机当成带有一个文件管理和通信功能的计算机——这可以让我可以轻而易举的使用鼠标和键盘。Tasker 更厉害,我可以用它让我手机根据环境变得可联系或不可联系,当我设置好了之后,当我到会议室之后我的手机就会自己进入会议模式,甚至变成省电模式。我还可以设置它当我到达特定的目的地时自动启动某个应用程序。

### Android 让我失望的地方

Android 备份选项仅限于特定的用户数据,而不是手机的完整克隆。如果不解锁 root,要么你只能听之任之,要么你必须用 Android SDK 来解决。期望普通用户会解锁 root 或运行 SDK 来完成备份(我的意思是一切都备份)显然是一个笑话。

是的,谷歌的备份服务会备份谷歌应用程序的数据、以及其他相关的自定义设置。但它是远不及我们所看到的苹果服务一样完整。为了完成类似于苹果那样的功能,我发现你就要么必须解锁 root ,要么将其连接到一个在 PC 机上使用一些不知道是什么的软件来干这个。

不过,公平的说,我知道使用 Nexus 的人能从该设备特有的[完整备份服务](https://support.google.com/nexus/answer/2819582?hl=en)中得到帮助。对不起,但是谷歌的默认备份方案是不行的。对于通过在 PC 上使用 adb (Android Debug Bridge) 来备份也是一样的——不会总是如预期般的恢复。

等吧,它会变好的。经过了很多失败的失望和挫折之后,我发现有一个应用程序,看起来它“可能”提供了一点点微小的希望,它叫 Helium 。它不像我发现的其他应用程序那样拥有误导性的和令人沮丧的局限性,[Helium](https://play.google.com/store/apps/details?id=com.koushikdutta.backup&hl=en) 最初看起来像是谷歌应该一直提供的备份应用程序——注意,只是“看起来像”。可悲的是,它绊了我一跤。第一次运行时,我不仅需要将它连接到我的计算机上,甚至使用他们提供的 Linux 脚本都不工作。在删除他们的脚本后,我弄了一个很好的老式 adb 来备份到我的 Linux PC 上。你可能要知道的是:你需要在开发工具里打开一箩筐东西,而且如果你运行 Twilight 应用的话还要关闭它。当 adb 的备份选项在我的手机上不起作用时,我花了一点时间把这个搞好了。

最后,Android 为非 root 用户也提供了可以轻松备份一些如联系人、短信等简单东西的选择。但是,要深度手机备份的话,以我经验还是通过有线连接和 adb。

### Ubuntu 能拯救我们吗?

在手机领域,通过对这两大玩家之间的优劣比较,我们很期望从 Ubuntu 看到更好的表现。但是,迄今为止,它的表现相当低迷。

我喜欢开发人员基于这个操作系统正在做的那些努力,我当然想在 iPhone 和 Android 手机之外有第三种选择。但是不幸的是,它在手机和平板上并不受欢迎,而且由于硬件的低端以及在 YouTube 上的糟糕的演示,有很多不好的传闻。

公平来说,我在以前也用过 iPhone 和 Android 的低端机,所以这不是对 Ubuntu 的挖苦。但是它要表现出准备与 iPhone 和 Android 相竞争的功能生态时,那就另说了,这还不是我现在特别感兴趣的东西。在以后的日子里,也许吧,我会觉得 Ubuntu 手机可以满足我的需要了。

### Android 与 iPhone 之争:为什么 Android 将终究赢得胜利

忽视 Android 那些痛苦的缺点,它起码给我了选择。它并没有把我限制在只有两种备份数据的方式上。是的,一些 Android 的限制事实上是由于它的关注点在于让我选择如何处理我的数据。但是,我可以选择我自己的设备,想加内存就加内存。Android 可以我让做很多很酷的东西,而 iPhone 根本就没有能力这些事情。

从根本上来说, Android 给非 root 用户提供了访问手机功能的更大自由。无论是好是坏,这是人们想要的一种自由。现在你们其中有很多 iPhone 的粉丝应该感谢像 [libimobiledevice](http://www.libimobiledevice.org/) 这样项目带来的影响。看看苹果阻止 Linux 用户所做的事情……然后问问你自己:作为一个 Linux 用户这真的值得吗?

发表下评论吧,分享你对 iPhone 、Android 或 Ubuntu 的看法。

---

via: <http://www.datamation.com/mobile-wireless/android-vs.-iphone-pros-and-cons.html>

作者:[Matt Hartley](http://www.datamation.com/author/Matt-Hartley-3080.html) 译者:[jovov](https://github.com/jovov) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,753 | 用 Python 实现 Python 解释器 | http://aosabook.org/en/500L/a-python-interpreter-written-in-python.html | 2016-09-08T14:16:18 | [

"Python",

"解释器"

] | https://linux.cn/article-7753-1.html | *Allison 是 Dropbox 的工程师,在那里她维护着这个世界上最大的 Python 客户端网络之一。在去 Dropbox 之前,她是 Recurse Center 的协调人, 是这个位于纽约的程序员深造机构的作者。她在北美的 PyCon 做过关于 Python 内部机制的演讲,并且她喜欢研究奇怪的 bug。她的博客地址是 [akaptur.com](http://akaptur.com)。*

**

### 介绍

Byterun 是一个用 Python 实现的 Python 解释器。随着我对 Byterun 的开发,我惊喜地的发现,这个 Python 解释器的基础结构用 500 行代码就能实现。在这一章我们会搞清楚这个解释器的结构,给你足够探索下去的背景知识。我们的目标不是向你展示解释器的每个细节---像编程和计算机科学其他有趣的领域一样,你可能会投入几年的时间去深入了解这个主题。

Byterun 是 Ned Batchelder 和我完成的,建立在 Paul Swartz 的工作之上。它的结构和主要的 Python 实现(CPython)差不多,所以理解 Byterun 会帮助你理解大多数解释器,特别是 CPython 解释器。(如果你不知道你用的是什么 Python,那么很可能它就是 CPython)。尽管 Byterun 很小,但它能执行大多数简单的 Python 程序(这一章是基于 Python 3.5 及其之前版本生成的字节码的,在 Python 3.6 中生成的字节码有一些改变)。

#### Python 解释器

在开始之前,让我们限定一下“Pyhton 解释器”的意思。在讨论 Python 的时候,“解释器”这个词可以用在很多不同的地方。有的时候解释器指的是 Python REPL,即当你在命令行下敲下 `python` 时所得到的交互式环境。有时候人们会或多或少的互换使用 “Python 解释器”和“Python”来说明从头到尾执行 Python 代码的这一过程。在本章中,“解释器”有一个更精确的意思:Python 程序的执行过程中的最后一步。

在解释器接手之前,Python 会执行其他 3 个步骤:词法分析,语法解析和编译。这三步合起来把源代码转换成<ruby> 代码对象 <rp> ( </rp> <rt> code object </rt> <rp> ) </rp></ruby>,它包含着解释器可以理解的指令。而解释器的工作就是解释代码对象中的指令。

你可能很奇怪执行 Python 代码会有编译这一步。Python 通常被称为解释型语言,就像 Ruby,Perl 一样,它们和像 C,Rust 这样的编译型语言相对。然而,这个术语并不是它看起来的那样精确。大多数解释型语言包括 Python 在内,确实会有编译这一步。而 Python 被称为解释型的原因是相对于编译型语言,它在编译这一步的工作相对较少(解释器做相对多的工作)。在这章后面你会看到,Python 的编译器比 C 语言编译器需要更少的关于程序行为的信息。

#### Python 的 Python 解释器

Byterun 是一个用 Python 写的 Python 解释器,这点可能让你感到奇怪,但没有比用 C 语言写 C 语言编译器更奇怪的了。(事实上,广泛使用的 gcc 编译器就是用 C 语言本身写的)你可以用几乎任何语言写一个 Python 解释器。

用 Python 写 Python 既有优点又有缺点。最大的缺点就是速度:用 Byterun 执行代码要比用 CPython 执行慢的多,CPython 解释器是用 C 语言实现的,并做了认真优化。然而 Byterun 是为了学习而设计的,所以速度对我们不重要。使用 Python 最大优势是我们可以*仅仅*实现解释器,而不用担心 Python 运行时部分,特别是对象系统。比如当 Byterun 需要创建一个类时,它就会回退到“真正”的 Python。另外一个优势是 Byterun 很容易理解,部分原因是它是用人们很容易理解的高级语言写的(Python !)(另外我们不会对解释器做优化 —— 再一次,清晰和简单比速度更重要)

### 构建一个解释器

在我们考察 Byterun 代码之前,我们需要从高层次对解释器结构有一些了解。Python 解释器是如何工作的?

Python 解释器是一个<ruby> 虚拟机 <rp> ( </rp> <rt> virtual machine </rt> <rp> ) </rp></ruby>,是一个模拟真实计算机的软件。我们这个虚拟机是<ruby> 栈机器 <rp> ( </rp> <rt> stack machine </rt> <rp> ) </rp></ruby>,它用几个栈来完成操作(与之相对的是<ruby> 寄存器机器 <rp> ( </rp> <rt> register machine </rt> <rp> ) </rp></ruby>,它从特定的内存地址读写数据)。

Python 解释器是一个<ruby> 字节码解释器 <rp> ( </rp> <rt> bytecode interpreter </rt> <rp> ) </rp></ruby>:它的输入是一些称作<ruby> 字节码 <rp> ( </rp> <rt> bytecode </rt> <rp> ) </rp></ruby>的指令集。当你写 Python 代码时,词法分析器、语法解析器和编译器会生成<ruby> 代码对象 <rp> ( </rp> <rt> code object </rt> <rp> ) </rp></ruby>让解释器去操作。每个代码对象都包含一个要被执行的指令集 —— 它就是字节码 —— 以及还有一些解释器需要的信息。字节码是 Python 代码的一个<ruby> 中间层表示 <rp> ( </rp> <rt> intermediate representation </rt> <rp> ) </rp></ruby>:它以一种解释器可以理解的方式来表示源代码。这和汇编语言作为 C 语言和机器语言的中间表示很类似。

#### 微型解释器

为了让说明更具体,让我们从一个非常小的解释器开始。它只能计算两个数的和,只能理解三个指令。它执行的所有代码只是这三个指令的不同组合。下面就是这三个指令:

* `LOAD_VALUE`

* `ADD_TWO_VALUES`

* `PRINT_ANSWER`

我们不关心词法、语法和编译,所以我们也不在乎这些指令集是如何产生的。你可以想象,当你写下 `7 + 5`,然后一个编译器为你生成那三个指令的组合。如果你有一个合适的编译器,你甚至可以用 Lisp 的语法来写,只要它能生成相同的指令。

假设

```

7 + 5

```

生成这样的指令集:

```

what_to_execute = {

"instructions": [("LOAD_VALUE", 0), # the first number

("LOAD_VALUE", 1), # the second number

("ADD_TWO_VALUES", None),

("PRINT_ANSWER", None)],

"numbers": [7, 5] }

```

Python 解释器是一个<ruby> 栈机器 <rp> ( </rp> <rt> stack machine </rt> <rp> ) </rp></ruby>,所以它必须通过操作栈来完成这个加法(见下图)。解释器先执行第一条指令,`LOAD_VALUE`,把第一个数压到栈中。接着它把第二个数也压到栈中。然后,第三条指令,`ADD_TWO_VALUES`,先把两个数从栈中弹出,加起来,再把结果压入栈中。最后一步,把结果弹出并输出。

`LOAD_VALUE`这条指令告诉解释器把一个数压入栈中,但指令本身并没有指明这个数是多少。指令需要一个额外的信息告诉解释器去哪里找到这个数。所以我们的指令集有两个部分:指令本身和一个常量列表。(在 Python 中,字节码就是我们所称的“指令”,而解释器“执行”的是代码对象。)

为什么不把数字直接嵌入指令之中?想象一下,如果我们加的不是数字,而是字符串。我们可不想把字符串这样的东西加到指令中,因为它可以有任意的长度。另外,我们这种设计也意味着我们只需要对象的一份拷贝,比如这个加法 `7 + 7`, 现在常量表 `"numbers"`只需包含一个`[7]`。

你可能会想为什么会需要除了`ADD_TWO_VALUES`之外的指令。的确,对于我们两个数加法,这个例子是有点人为制作的意思。然而,这个指令却是建造更复杂程序的轮子。比如,就我们目前定义的三个指令,只要给出正确的指令组合,我们可以做三个数的加法,或者任意个数的加法。同时,栈提供了一个清晰的方法去跟踪解释器的状态,这为我们增长的复杂性提供了支持。

现在让我们来完成我们的解释器。解释器对象需要一个栈,它可以用一个列表来表示。它还需要一个方法来描述怎样执行每条指令。比如,`LOAD_VALUE`会把一个值压入栈中。

```

class Interpreter:

def __init__(self):

self.stack = []

def LOAD_VALUE(self, number):

self.stack.append(number)

def PRINT_ANSWER(self):

answer = self.stack.pop()

print(answer)

def ADD_TWO_VALUES(self):

first_num = self.stack.pop()

second_num = self.stack.pop()

total = first_num + second_num

self.stack.append(total)

```

这三个方法完成了解释器所理解的三条指令。但解释器还需要一样东西:一个能把所有东西结合在一起并执行的方法。这个方法就叫做 `run_code`,它把我们前面定义的字典结构 `what-to-execute` 作为参数,循环执行里面的每条指令,如果指令有参数就处理参数,然后调用解释器对象中相应的方法。

```

def run_code(self, what_to_execute):

instructions = what_to_execute["instructions"]

numbers = what_to_execute["numbers"]

for each_step in instructions:

instruction, argument = each_step

if instruction == "LOAD_VALUE":

number = numbers[argument]

self.LOAD_VALUE(number)

elif instruction == "ADD_TWO_VALUES":

self.ADD_TWO_VALUES()

elif instruction == "PRINT_ANSWER":

self.PRINT_ANSWER()

```

为了测试,我们创建一个解释器对象,然后用前面定义的 7 + 5 的指令集来调用 `run_code`。

```

interpreter = Interpreter()

interpreter.run_code(what_to_execute)

```

显然,它会输出 12。

尽管我们的解释器功能十分受限,但这个过程几乎和真正的 Python 解释器处理加法是一样的。这里,我们还有几点要注意。

首先,一些指令需要参数。在真正的 Python 字节码当中,大概有一半的指令有参数。像我们的例子一样,参数和指令打包在一起。注意指令的参数和传递给对应方法的参数是不同的。

第二,指令`ADD_TWO_VALUES`不需要任何参数,它从解释器栈中弹出所需的值。这正是以基于栈的解释器的特点。

记得我们说过只要给出合适的指令集,不需要对解释器做任何改变,我们就能做多个数的加法。考虑下面的指令集,你觉得会发生什么?如果你有一个合适的编译器,什么代码才能编译出下面的指令集?

```

what_to_execute = {

"instructions": [("LOAD_VALUE", 0),

("LOAD_VALUE", 1),

("ADD_TWO_VALUES", None),

("LOAD_VALUE", 2),

("ADD_TWO_VALUES", None),

("PRINT_ANSWER", None)],

"numbers": [7, 5, 8] }

```

从这点出发,我们开始看到这种结构的可扩展性:我们可以通过向解释器对象增加方法来描述更多的操作(只要有一个编译器能为我们生成组织良好的指令集就行)。

##### 变量

接下来给我们的解释器增加变量的支持。我们需要一个保存变量值的指令 `STORE_NAME`;一个取变量值的指令`LOAD_NAME`;和一个变量到值的映射关系。目前,我们会忽略命名空间和作用域,所以我们可以把变量和值的映射直接存储在解释器对象中。最后,我们要保证`what_to_execute`除了一个常量列表,还要有个变量名字的列表。

```

>>> def s():

... a = 1

... b = 2

... print(a + b)

# a friendly compiler transforms `s` into:

what_to_execute = {

"instructions": [("LOAD_VALUE", 0),

("STORE_NAME", 0),

("LOAD_VALUE", 1),

("STORE_NAME", 1),

("LOAD_NAME", 0),

("LOAD_NAME", 1),

("ADD_TWO_VALUES", None),

("PRINT_ANSWER", None)],

"numbers": [1, 2],

"names": ["a", "b"] }

```

我们的新的实现在下面。为了跟踪哪个名字绑定到哪个值,我们在`__init__`方法中增加一个`environment`字典。我们也增加了`STORE_NAME`和`LOAD_NAME`方法,它们获得变量名,然后从`environment`字典中设置或取出这个变量值。

现在指令的参数就有两个不同的意思,它可能是`numbers`列表的索引,也可能是`names`列表的索引。解释器通过检查所执行的指令就能知道是那种参数。而我们打破这种逻辑 ,把指令和它所用何种参数的映射关系放在另一个单独的方法中。

```

class Interpreter:

def __init__(self):

self.stack = []

self.environment = {}

def STORE_NAME(self, name):

val = self.stack.pop()

self.environment[name] = val

def LOAD_NAME(self, name):

val = self.environment[name]

self.stack.append(val)

def parse_argument(self, instruction, argument, what_to_execute):

""" Understand what the argument to each instruction means."""

numbers = ["LOAD_VALUE"]

names = ["LOAD_NAME", "STORE_NAME"]

if instruction in numbers:

argument = what_to_execute["numbers"][argument]

elif instruction in names:

argument = what_to_execute["names"][argument]

return argument

def run_code(self, what_to_execute):

instructions = what_to_execute["instructions"]

for each_step in instructions:

instruction, argument = each_step

argument = self.parse_argument(instruction, argument, what_to_execute)

if instruction == "LOAD_VALUE":

self.LOAD_VALUE(argument)

elif instruction == "ADD_TWO_VALUES":

self.ADD_TWO_VALUES()

elif instruction == "PRINT_ANSWER":

self.PRINT_ANSWER()

elif instruction == "STORE_NAME":

self.STORE_NAME(argument)

elif instruction == "LOAD_NAME":

self.LOAD_NAME(argument)

```

仅仅五个指令,`run_code`这个方法已经开始变得冗长了。如果保持这种结构,那么每条指令都需要一个`if`分支。这里,我们要利用 Python 的动态方法查找。我们总会给一个称为`FOO`的指令定义一个名为`FOO`的方法,这样我们就可用 Python 的`getattr`函数在运行时动态查找方法,而不用这个大大的分支结构。`run_code`方法现在是这样:

```

def execute(self, what_to_execute):

instructions = what_to_execute["instructions"]

for each_step in instructions:

instruction, argument = each_step

argument = self.parse_argument(instruction, argument, what_to_execute)

bytecode_method = getattr(self, instruction)

if argument is None:

bytecode_method()

else:

bytecode_method(argument)

```

### 真实的 Python 字节码

现在,放弃我们的小指令集,去看看真正的 Python 字节码。字节码的结构和我们的小解释器的指令集差不多,除了字节码用一个字节而不是一个名字来代表这条指令。为了理解它的结构,我们将考察一个函数的字节码。考虑下面这个例子:

```

>>> def cond():

... x = 3

... if x < 5:

... return 'yes'

... else:

... return 'no'

...

```

Python 在运行时会暴露一大批内部信息,并且我们可以通过 REPL 直接访问这些信息。对于函数对象`cond`,`cond.__code__`是与其关联的代码对象,而`cond.__code__.co_code`就是它的字节码。当你写 Python 代码时,你永远也不会想直接使用这些属性,但是这可以让我们做出各种恶作剧,同时也可以看看内部机制。

```

>>> cond.__code__.co_code # the bytecode as raw bytes

b'd\x01\x00}\x00\x00|\x00\x00d\x02\x00k\x00\x00r\x16\x00d\x03\x00Sd\x04\x00Sd\x00

\x00S'

>>> list(cond.__code__.co_code) # the bytecode as numbers

[100, 1, 0, 125, 0, 0, 124, 0, 0, 100, 2, 0, 107, 0, 0, 114, 22, 0, 100, 3, 0, 83,

100, 4, 0, 83, 100, 0, 0, 83]

```

当我们直接输出这个字节码,它看起来完全无法理解 —— 唯一我们了解的是它是一串字节。很幸运,我们有一个很强大的工具可以用:Python 标准库中的`dis`模块。

`dis`是一个字节码反汇编器。反汇编器以为机器而写的底层代码作为输入,比如汇编代码和字节码,然后以人类可读的方式输出。当我们运行`dis.dis`,它输出每个字节码的解释。

```

>>> dis.dis(cond)

2 0 LOAD_CONST 1 (3)

3 STORE_FAST 0 (x)

3 6 LOAD_FAST 0 (x)

9 LOAD_CONST 2 (5)

12 COMPARE_OP 0 (<)

15 POP_JUMP_IF_FALSE 22

4 18 LOAD_CONST 3 ('yes')

21 RETURN_VALUE

6 >> 22 LOAD_CONST 4 ('no')

25 RETURN_VALUE

26 LOAD_CONST 0 (None)

29 RETURN_VALUE

```

这些都是什么意思?让我们以第一条指令`LOAD_CONST`为例子。第一列的数字(`2`)表示对应源代码的行数。第二列的数字是字节码的索引,告诉我们指令`LOAD_CONST`在位置 0 。第三列是指令本身对应的人类可读的名字。如果第四列存在,它表示指令的参数。如果第五列存在,它是一个关于参数是什么的提示。

考虑这个字节码的前几个字节:[100, 1, 0, 125, 0, 0]。这 6 个字节表示两条带参数的指令。我们可以使用`dis.opname`,一个字节到可读字符串的映射,来找到指令 100 和指令 125 代表的是什么:

```

>>> dis.opname[100]

'LOAD_CONST'

>>> dis.opname[125]

'STORE_FAST'

```

第二和第三个字节 —— 1 、0 ——是`LOAD_CONST`的参数,第五和第六个字节 —— 0、0 —— 是`STORE_FAST`的参数。就像我们前面的小例子,`LOAD_CONST`需要知道的到哪去找常量,`STORE_FAST`需要知道要存储的名字。(Python 的`LOAD_CONST`和我们小例子中的`LOAD_VALUE`一样,`LOAD_FAST`和`LOAD_NAME`一样)。所以这六个字节代表第一行源代码`x = 3` (为什么用两个字节表示指令的参数?如果 Python 使用一个字节,每个代码对象你只能有 256 个常量/名字,而用两个字节,就增加到了 256 的平方,65536个)。

#### 条件语句与循环语句

到目前为止,我们的解释器只能一条接着一条的执行指令。这有个问题,我们经常会想多次执行某个指令,或者在特定的条件下跳过它们。为了可以写循环和分支结构,解释器必须能够在指令中跳转。在某种程度上,Python 在字节码中使用`GOTO`语句来处理循环和分支!让我们再看一个`cond`函数的反汇编结果:

```

>>> dis.dis(cond)

2 0 LOAD_CONST 1 (3)

3 STORE_FAST 0 (x)

3 6 LOAD_FAST 0 (x)

9 LOAD_CONST 2 (5)

12 COMPARE_OP 0 (<)

15 POP_JUMP_IF_FALSE 22

4 18 LOAD_CONST 3 ('yes')

21 RETURN_VALUE

6 >> 22 LOAD_CONST 4 ('no')

25 RETURN_VALUE

26 LOAD_CONST 0 (None)

29 RETURN_VALUE

```

第三行的条件表达式`if x < 5`被编译成四条指令:`LOAD_FAST`、 `LOAD_CONST`、 `COMPARE_OP`和 `POP_JUMP_IF_FALSE`。`x < 5`对应加载`x`、加载 5、比较这两个值。指令`POP_JUMP_IF_FALSE`完成这个`if`语句。这条指令把栈顶的值弹出,如果值为真,什么都不发生。如果值为假,解释器会跳转到另一条指令。

这条将被加载的指令称为跳转目标,它作为指令`POP_JUMP`的参数。这里,跳转目标是 22,索引为 22 的指令是`LOAD_CONST`,对应源码的第 6 行。(`dis`用`>>`标记跳转目标。)如果`X < 5`为假,解释器会忽略第四行(`return yes`),直接跳转到第6行(`return "no"`)。因此解释器通过跳转指令选择性的执行指令。

Python 的循环也依赖于跳转。在下面的字节码中,`while x < 5`这一行产生了和`if x < 10`几乎一样的字节码。在这两种情况下,解释器都是先执行比较,然后执行`POP_JUMP_IF_FALSE`来控制下一条执行哪个指令。第四行的最后一条字节码`JUMP_ABSOLUT`(循环体结束的地方),让解释器返回到循环开始的第 9 条指令处。当 `x < 10`变为假,`POP_JUMP_IF_FALSE`会让解释器跳到循环的终止处,第 34 条指令。

```

>>> def loop():

... x = 1

... while x < 5:

... x = x + 1

... return x

...

>>> dis.dis(loop)

2 0 LOAD_CONST 1 (1)

3 STORE_FAST 0 (x)

3 6 SETUP_LOOP 26 (to 35)

>> 9 LOAD_FAST 0 (x)

12 LOAD_CONST 2 (5)

15 COMPARE_OP 0 (<)

18 POP_JUMP_IF_FALSE 34

4 21 LOAD_FAST 0 (x)

24 LOAD_CONST 1 (1)

27 BINARY_ADD

28 STORE_FAST 0 (x)

31 JUMP_ABSOLUTE 9

>> 34 POP_BLOCK

5 >> 35 LOAD_FAST 0 (x)

38 RETURN_VALUE

```

#### 探索字节码

我希望你用`dis.dis`来试试你自己写的函数。一些有趣的问题值得探索:

* 对解释器而言 for 循环和 while 循环有什么不同?

* 能不能写出两个不同函数,却能产生相同的字节码?

* `elif`是怎么工作的?列表推导呢?

### 帧

到目前为止,我们已经知道了 Python 虚拟机是一个栈机器。它能顺序执行指令,在指令间跳转,压入或弹出栈值。但是这和我们期望的解释器还有一定距离。在前面的那个例子中,最后一条指令是`RETURN_VALUE`,它和`return`语句相对应。但是它返回到哪里去呢?

为了回答这个问题,我们必须再增加一层复杂性:<ruby> 帧 <rp> ( </rp> <rt> frame </rt> <rp> ) </rp></ruby>。一个帧是一些信息的集合和代码的执行上下文。帧在 Python 代码执行时动态地创建和销毁。每个帧对应函数的一次调用 —— 所以每个帧只有一个代码对象与之关联,而一个代码对象可以有多个帧。比如你有一个函数递归的调用自己 10 次,这会产生 11 个帧,每次调用对应一个,再加上启动模块对应的一个帧。总的来说,Python 程序的每个作用域都有一个帧,比如,模块、函数、类定义。

帧存在于<ruby> 调用栈 <rp> ( </rp> <rt> call stack </rt> <rp> ) </rp></ruby>中,一个和我们之前讨论的完全不同的栈。(你最熟悉的栈就是调用栈,就是你经常看到的异常回溯,每个以"File 'program.py'"开始的回溯对应一个帧。)解释器在执行字节码时操作的栈,我们叫它<ruby> 数据栈 <rp> ( </rp> <rt> data stack </rt> <rp> ) </rp></ruby>。其实还有第三个栈,叫做<ruby> 块栈 <rp> ( </rp> <rt> block stack </rt> <rp> ) </rp></ruby>,用于特定的控制流块,比如循环和异常处理。调用栈中的每个帧都有它自己的数据栈和块栈。

让我们用一个具体的例子来说明一下。假设 Python 解释器执行到下面标记为 3 的地方。解释器正处于`foo`函数的调用中,它接着调用`bar`。下面是帧调用栈、块栈和数据栈的示意图。我们感兴趣的是解释器先从最底下的`foo()`开始,接着执行`foo`的函数体,然后到达`bar`。

```

>>> def bar(y):

... z = y + 3 # <--- (3) ... and the interpreter is here.

... return z

...

>>> def foo():

... a = 1

... b = 2

... return a + bar(b) # <--- (2) ... which is returning a call to bar ...

...

>>> foo() # <--- (1) We're in the middle of a call to foo ...

3

```

现在,解释器处于`bar`函数的调用中。调用栈中有 3 个帧:一个对应于模块层,一个对应函数`foo`,另一个对应函数`bar`。(见上图)一旦`bar`返回,与它对应的帧就会从调用栈中弹出并丢弃。

字节码指令`RETURN_VALUE`告诉解释器在帧之间传递一个值。首先,它把位于调用栈栈顶的帧中的数据栈的栈顶值弹出。然后把整个帧弹出丢弃。最后把这个值压到下一个帧的数据栈中。

当 Ned Batchelder 和我在写 Byterun 时,很长一段时间我们的实现中一直有个重大的错误。我们整个虚拟机中只有一个数据栈,而不是每个帧都有一个。我们写了很多测试代码,同时在 Byterun 和真正的 Python 上运行,希望得到一致结果。我们几乎通过了所有测试,只有一样东西不能通过,那就是<ruby> 生成器 <rp> ( </rp> <rt> generators </rt> <rp> ) </rp></ruby>。最后,通过仔细的阅读 CPython 的源码,我们发现了错误所在(感谢 Michael Arntzenius 对这个 bug 的洞悉)。把数据栈移到每个帧就解决了这个问题。

回头在看看这个 bug,我惊讶的发现 Python 真的很少依赖于每个帧有一个数据栈这个特性。在 Python 中几乎所有的操作都会清空数据栈,所以所有的帧公用一个数据栈是没问题的。在上面的例子中,当`bar`执行完后,它的数据栈为空。即使`foo`公用这一个栈,它的值也不会受影响。然而,对应生成器,它的一个关键的特点是它能暂停一个帧的执行,返回到其他的帧,一段时间后它能返回到原来的帧,并以它离开时的相同状态继续执行。

### Byterun

现在我们有足够的 Python 解释器的知识背景去考察 Byterun。

Byterun 中有四种对象。

* `VirtualMachine`类,它管理高层结构,尤其是帧调用栈,并包含了指令到操作的映射。这是一个比前面`Inteprter`对象更复杂的版本。

* `Frame`类,每个`Frame`类都有一个代码对象,并且管理着其他一些必要的状态位,尤其是全局和局部命名空间、指向调用它的整的指针和最后执行的字节码指令。

* `Function`类,它被用来代替真正的 Python 函数。回想一下,调用函数时会创建一个新的帧。我们自己实现了`Function`,以便我们控制新的`Frame`的创建。

* `Block`类,它只是包装了块的 3 个属性。(块的细节不是解释器的核心,我们不会花时间在它身上,把它列在这里,是因为 Byterun 需要它。)

#### `VirtualMachine` 类

每次程序运行时只会创建一个`VirtualMachine`实例,因为我们只有一个 Python 解释器。`VirtualMachine` 保存调用栈、异常状态、在帧之间传递的返回值。它的入口点是`run_code`方法,它以编译后的代码对象为参数,以创建一个帧为开始,然后运行这个帧。这个帧可能再创建出新的帧;调用栈随着程序的运行而增长和缩短。当第一个帧返回时,执行结束。

```

class VirtualMachineError(Exception):

pass

class VirtualMachine(object):

def __init__(self):

self.frames = [] # The call stack of frames.

self.frame = None # The current frame.

self.return_value = None

self.last_exception = None

def run_code(self, code, global_names=None, local_names=None):

""" An entry point to execute code using the virtual machine."""

frame = self.make_frame(code, global_names=global_names,

local_names=local_names)

self.run_frame(frame)

```

#### `Frame` 类

接下来,我们来写`Frame`对象。帧是一个属性的集合,它没有任何方法。前面提到过,这些属性包括由编译器生成的代码对象;局部、全局和内置命名空间;前一个帧的引用;一个数据栈;一个块栈;最后执行的指令指针。(对于内置命名空间我们需要多做一点工作,Python 在不同模块中对这个命名空间有不同的处理;但这个细节对我们的虚拟机不重要。)

```

class Frame(object):

def __init__(self, code_obj, global_names, local_names, prev_frame):

self.code_obj = code_obj

self.global_names = global_names

self.local_names = local_names

self.prev_frame = prev_frame

self.stack = []

if prev_frame:

self.builtin_names = prev_frame.builtin_names

else:

self.builtin_names = local_names['__builtins__']

if hasattr(self.builtin_names, '__dict__'):

self.builtin_names = self.builtin_names.__dict__

self.last_instruction = 0

self.block_stack = []

```

接着,我们在虚拟机中增加对帧的操作。这有 3 个帮助函数:一个创建新的帧的方法(它负责为新的帧找到名字空间),和压栈和出栈的方法。第四个函数,`run_frame`,完成执行帧的主要工作,待会我们再讨论这个方法。

```

class VirtualMachine(object):

[... 删节 ...]

# Frame manipulation

def make_frame(self, code, callargs={}, global_names=None, local_names=None):

if global_names is not None and local_names is not None:

local_names = global_names

elif self.frames:

global_names = self.frame.global_names

local_names = {}

else:

global_names = local_names = {

'__builtins__': __builtins__,

'__name__': '__main__',

'__doc__': None,

'__package__': None,

}

local_names.update(callargs)

frame = Frame(code, global_names, local_names, self.frame)

return frame

def push_frame(self, frame):

self.frames.append(frame)

self.frame = frame

def pop_frame(self):

self.frames.pop()

if self.frames:

self.frame = self.frames[-1]

else:

self.frame = None

def run_frame(self):

pass

# we'll come back to this shortly

```

#### `Function` 类

`Function`的实现有点曲折,但是大部分的细节对理解解释器不重要。重要的是当调用函数时 —— 即调用 `__call__`方法 —— 它创建一个新的`Frame`并运行它。

```

class Function(object):

"""

Create a realistic function object, defining the things the interpreter expects.

"""

__slots__ = [

'func_code', 'func_name', 'func_defaults', 'func_globals',

'func_locals', 'func_dict', 'func_closure',

'__name__', '__dict__', '__doc__',

'_vm', '_func',

]

def __init__(self, name, code, globs, defaults, closure, vm):

"""You don't need to follow this closely to understand the interpreter."""

self._vm = vm

self.func_code = code

self.func_name = self.__name__ = name or code.co_name

self.func_defaults = tuple(defaults)

self.func_globals = globs

self.func_locals = self._vm.frame.f_locals

self.__dict__ = {}

self.func_closure = closure

self.__doc__ = code.co_consts[0] if code.co_consts else None

# Sometimes, we need a real Python function. This is for that.

kw = {

'argdefs': self.func_defaults,

}

if closure:

kw['closure'] = tuple(make_cell(0) for _ in closure)

self._func = types.FunctionType(code, globs, **kw)

def __call__(self, *args, **kwargs):

"""When calling a Function, make a new frame and run it."""

callargs = inspect.getcallargs(self._func, *args, **kwargs)

# Use callargs to provide a mapping of arguments: values to pass into the new

# frame.

frame = self._vm.make_frame(

self.func_code, callargs, self.func_globals, {}

)

return self._vm.run_frame(frame)

def make_cell(value):

"""Create a real Python closure and grab a cell."""

# Thanks to Alex Gaynor for help with this bit of twistiness.

fn = (lambda x: lambda: x)(value)

return fn.__closure__[0]

```

接着,回到`VirtualMachine`对象,我们对数据栈的操作也增加一些帮助方法。字节码操作的栈总是在当前帧的数据栈。这些帮助函数让我们的`POP_TOP`、`LOAD_FAST`以及其他操作栈的指令的实现可读性更高。

```

class VirtualMachine(object):

[... 删节 ...]

# Data stack manipulation

def top(self):

return self.frame.stack[-1]

def pop(self):

return self.frame.stack.pop()

def push(self, *vals):

self.frame.stack.extend(vals)

def popn(self, n):

"""Pop a number of values from the value stack.

A list of `n` values is returned, the deepest value first.

"""

if n:

ret = self.frame.stack[-n:]

self.frame.stack[-n:] = []

return ret

else:

return []

```

在我们运行帧之前,我们还需两个方法。

第一个方法,`parse_byte_and_args` 以一个字节码为输入,先检查它是否有参数,如果有,就解析它的参数。这个方法同时也更新帧的`last_instruction`属性,它指向最后执行的指令。一条没有参数的指令只有一个字节长度,而有参数的字节有3个字节长。参数的意义依赖于指令是什么。比如,前面说过,指令`POP_JUMP_IF_FALSE`,它的参数指的是跳转目标。`BUILD_LIST`,它的参数是列表的个数。`LOAD_CONST`,它的参数是常量的索引。

一些指令用简单的数字作为参数。对于另一些,虚拟机需要一点努力去发现它含意。标准库中的`dis`模块中有一个备忘单,它解释什么参数有什么意思,这让我们的代码更加简洁。比如,列表`dis.hasname`告诉我们`LOAD_NAME`、 `IMPORT_NAME`、`LOAD_GLOBAL`,以及另外的 9 个指令的参数都有同样的意义:对于这些指令,它们的参数代表了代码对象中的名字列表的索引。

```

class VirtualMachine(object):

[... 删节 ...]

def parse_byte_and_args(self):

f = self.frame

opoffset = f.last_instruction

byteCode = f.code_obj.co_code[opoffset]

f.last_instruction += 1

byte_name = dis.opname[byteCode]

if byteCode >= dis.HAVE_ARGUMENT:

# index into the bytecode

arg = f.code_obj.co_code[f.last_instruction:f.last_instruction+2]

f.last_instruction += 2 # advance the instruction pointer

arg_val = arg[0] + (arg[1] * 256)

if byteCode in dis.hasconst: # Look up a constant

arg = f.code_obj.co_consts[arg_val]

elif byteCode in dis.hasname: # Look up a name

arg = f.code_obj.co_names[arg_val]

elif byteCode in dis.haslocal: # Look up a local name

arg = f.code_obj.co_varnames[arg_val]

elif byteCode in dis.hasjrel: # Calculate a relative jump

arg = f.last_instruction + arg_val

else:

arg = arg_val

argument = [arg]

else:

argument = []

return byte_name, argument

```

下一个方法是`dispatch`,它查找给定的指令并执行相应的操作。在 CPython 中,这个分派函数用一个巨大的 switch 语句实现,有超过 1500 行的代码。幸运的是,我们用的是 Python,我们的代码会简洁的多。我们会为每一个字节码名字定义一个方法,然后用`getattr`来查找。就像我们前面的小解释器一样,如果一条指令叫做`FOO_BAR`,那么它对应的方法就是`byte_FOO_BAR`。现在,我们先把这些方法当做一个黑盒子。每个指令方法都会返回`None`或者一个字符串`why`,有些情况下虚拟机需要这个额外`why`信息。这些指令方法的返回值,仅作为解释器状态的内部指示,千万不要和执行帧的返回值相混淆。

```

class VirtualMachine(object):

[... 删节 ...]

def dispatch(self, byte_name, argument):

""" Dispatch by bytename to the corresponding methods.

Exceptions are caught and set on the virtual machine."""

# When later unwinding the block stack,

# we need to keep track of why we are doing it.

why = None

try:

bytecode_fn = getattr(self, 'byte_%s' % byte_name, None)

if bytecode_fn is None:

if byte_name.startswith('UNARY_'):

self.unaryOperator(byte_name[6:])

elif byte_name.startswith('BINARY_'):

self.binaryOperator(byte_name[7:])

else:

raise VirtualMachineError(

"unsupported bytecode type: %s" % byte_name

)

else:

why = bytecode_fn(*argument)

except:

# deal with exceptions encountered while executing the op.

self.last_exception = sys.exc_info()[:2] + (None,)

why = 'exception'

return why

def run_frame(self, frame):

"""Run a frame until it returns (somehow).

Exceptions are raised, the return value is returned.

"""

self.push_frame(frame)

while True:

byte_name, arguments = self.parse_byte_and_args()

why = self.dispatch(byte_name, arguments)

# Deal with any block management we need to do

while why and frame.block_stack:

why = self.manage_block_stack(why)

if why:

break

self.pop_frame()