id

int64 2.05k

16.6k

| title

stringlengths 5

75

| fromurl

stringlengths 19

185

| date

timestamp[s] | tags

sequencelengths 0

11

| permalink

stringlengths 20

37

| content

stringlengths 342

82.2k

| fromurl_status

int64 200

526

⌀ | status_msg

stringclasses 339

values | from_content

stringlengths 0

229k

⌀ |

|---|---|---|---|---|---|---|---|---|---|

7,335 | 珠海全志公司的 Linux 内核遗留了后门 | http://arstechnica.com/security/2016/05/chinese-arm-vendor-left-developer-backdoor-in-kernel-for-android-pi-devices/ | 2016-05-13T15:49:51 | [

"全志",

"后门"

] | https://linux.cn/article-7335-1.html |

据外媒 arstechnica 报道,一家中国的芯片级系统厂商全志(allwinner) 在其开发的产品中携带的内核里[遗留了一个 root 后门](http://forum.armbian.com/index.php/topic/1108-security-alert-for-allwinner-sun8i-h3a83th8/http://forum.armbian.com/index.php/topic/1108-security-alert-for-allwinner-sun8i-h3a83th8/)。全志的处理器芯片用在很多低端的 Android 平板、机顶盒、基于 ARM 的 PC 等等之上。而这个后门非常容易获得,只需要给一个未见于文档的调试进程发送一个字符串“rootmydevice” 即可获取该设备的 root 权限。

该后门可能是开发人员调试后忘记移除的。全志公司在知道此消息后,已经从其公司的 Github 账户上[删除了相关文件](https://github.com/allwinner-zh/linux-3.4-sunxi/blob/master/arch/arm/mach-sunxi/sunxi-debug.c#L41)。

该公司使用的内核 linux-3.4-sunxi,原先用于支持全志的 ARM 芯片平板上的 Android,它也有一个[社区版本](https://linux-sunxi.org/Linux_Kernel)。该内核也用来移植到各种全志芯片的设备上,包括<ruby> 桔子派 <rp> ( </rp> <rt> Orange Pi </rt> <rp> ) </rp></ruby>、<ruby> 香蕉派 <rp> ( </rp> <rt> Banana Pi </rt> <rp> ) </rp></ruby>等与<ruby> 树莓派 <rp> ( </rp> <rt> Raspberry Pi </rt> <rp> ) </rp></ruby>兼容的开发板。

| 301 | Moved Permanently | null |

7,337 | Linux 是世界上最大的软件开发项目 | http://www.cio.com/article/3069529/linux/linux-is-the-largest-software-development-project-on-the-planet-greg-kroah-hartman.html | 2016-05-14T11:30:00 | [

"内核",

"Kroah-Hartman"

] | https://linux.cn/article-7337-1.html | Greg Kroah-Hartman 是 Linux 内核社区的二号人物(第一位显然是 Linus Torvalds),他在设备驱动方面做了许多工作,他也是当前 Linux 内核稳定分支的负责人。

在本周柏林举办的 CoreOS Fest 上,Kroah-Hartman 做了一场讲演介绍了 Linux 内核项目是如何的巨大。之后我找了个机会邀请他聊了聊内核和安全方面的话题。

我们的话题先从代码方面开始,Kroah-Hartman 说刚刚于两个月前发布 4.5 版已经包含了 2100 万行代码!

可能很多人觉得在那么小的设备上运行这么多的代码有点夸张,事实上,并不是所有的 2100 万行代码都运行在他们的设备上,只有需要的部分才会运行在里面。正如 Kroah-Hartman 说的,“你不会全部用到它们。在内核里面包含了各种硬件的驱动。我的笔记本上运行的内核代码大概有 160 万行,而你的电话可能运行了 250 万行代码。”

这里面,内核的核心部分是一定算在其中的,而它只占整个 Linux 内核代码的 5%,而剩下的还有 35% 是网络部分,40% 是设备驱动。

比代码规模更让人印象深刻的是它的参与人数规模,去年就有大约 4000 名开发人员参与了开发,至少 440 个公司向内核提交了贡献,这使得 Linux 成为了世界上最大的软件项目!Kroah-Hartman 说:“这是计算机有史以来最大的软件开发项目,无论是使用它的人数、开发它的人数,还是与之相关的公司数量,规模都很大。”

*Greg Kroah-Hartman 在 CoreOS Fest, Berlin 的讲演*

每天,平均有超过 10800 行的代码增加, 5300 行代码被删除,并且还有 1875 行代码被修改,也就是说每秒钟都有超过 8 行代码的变化!

这是非常大的数量,这意味着 Linux 内核不像其它的技术,它在不断的变化,变得越来越好。

Kroah-Hartman 说,“当我第一次参与这个项目时,我们每个小时可以完成 2.5 个变更。每个人都这么说,‘哦,天哪,我们不可能更快了,那不现实’。微软和苹果也说,‘你赢了’,他们一字一顿的说,‘我们比不上,你们干的比任何人都要快,我们是望尘莫及啊’。而我们的开发速度越来越快,我们每次都会更快一些。”

但是,如果你的公司的发展依靠着 Linux,那这个变化速度看起来就很可怕。Kroah-Hartman 解释了为什么会有这么多变更:“我们提交了很多变更,但是不是因为我们为变更而变更的,那可需要很多的工作。我们其实很懒,我们做这么多的变更的原因是因为我们必须做,是因为这个世界不断变化而需要我们做这么多的变更。那种‘你做了个东西,然后啥也不用管,将它丢在一边就好了’的模式已经不可行了,因为这个东西已经连通了世界,而世界每时每刻在变化。事物都在互相作用,所以你必须跟着进化。如果你的操作系统不能改变,那它就没用了,这毋庸置疑。如果你的设备不能跟着与之互动的世界变化,那它同样也没用,这也毋庸置疑。所以,你可以看看那些不能与时俱进的操作系统,根本没有人用它们。”

为了做到这些变更,Linux 内核社区需要做到两点。首先,我们要有个按时间进行的发布计划。其次,我们需要小步快跑。我们完成一个发布就要开始下一个发布的开发。下一个发布的第一个 RC 版本里面就要包含进去所有开发人员丢进去的各种东西,包括各种新的东西、新的功能,而且它们需要经过严格考验。当所有的东西都测试良好,我们才会放出第一个 RC 版本,之后的 RC 版本就是各种问题的修复。这样,我们就能在一个分支的 7-8 个 RC 版本之后赶走所有发现的问题。

当我们准备好发布一个新的内核发布版本时,它已经经过了详尽的测试。但是仍然有问题时,人们使用的稳定版怎么修复问题呢,他们可不想在产品环境中使用 RC 版本,那么他们怎么修复问题?在 15 年前,内核社区就找到了解决方案,而这就是 Kroah-Hartman 的任务,他会对稳定版本进行分支,比如说 4.2 版,它的问题修复版本会以 4.2.1 、4.2.2、4.2.3 等等发布。

“这个版本规则就是它必须是一个问题修复版,而且它必须是一个正确的版本号或者是新的设备 ID,它必须出现在 Linux 内核代码树上。在我将它放到稳定分支之前,它就必须出现在 Linux 内核代码树上。这可以确保人们运行我们的稳定内核时,如果跳到一个新的分支版本时,不会发生中断,没有什么不一样的变化。这就是规则,而且一直以来运作良好。”Kroah-Hartman 说。

而当下一个新的分支(4.3)出来时,Kroah-Hartman 就会从当前的分支(4.2)离开而去维护 4.3。这样内核社区就完美的保证了当新的版本发布时任何事情都很连贯。

“每个版本我每周都会做一次发布,每周会对稳定分支打 100 到 150 个补丁。这很多,许多东西都变化了,也修复了许多东西。而这就是我们做的——稳定的分支。当 4.3 发布时,最好的事情是我解脱了,我说,‘啊!4.2,我再也不要见到你了’,然后我就跑到新的分支了,因为我们的工作,这一切都可以继续发展下去,所有人都很满意。”

| 301 | Moved Permanently | null |

7,343 | Debian 团队澄清其与 ZFS 的许可证冲突是如何绕开的 | http://news.softpedia.com/news/debian-project-clarifies-the-implementation-of-zfs-for-linux-in-debian-gnu-linux-504090.shtml | 2016-05-16T15:42:00 | [

"ZFS",

"Debian"

] | https://linux.cn/article-7343-1.html | 之前,我们报道过 [Debian 中支持了 ZFS 文件系统](/article-7341-1.html)的新闻。Debian 社区对此表示了欢迎,但是也有人指出,ZFS 支持之所以迟迟不能加入到 Debian 中是由于 ZFS 许可证与 <ruby> Debian 自由软件指南 <rp> ( </rp> <rt> Debian Free Software Guidelines </rt> <rp> ) </rp></ruby>之间的冲突。

今天早些时候,我们联系到了 Debian 公关团队的 Donald Norwood,他告诉我们, ZFS for Linux 没有放到 Debian GNU/Linux 的主软件仓库中,而是放到了另外一个名为 “contrib”的仓库中。

“ZFS 放到了 /contrib/ 下,而没有放到 /main/ 下,原因是因为当前的 ZFS 许可证同 <ruby> Debian 自由软件指南 <rp> ( </rp> <rt> Debian Free Software Guidelines </rt> <rp> ) </rp></ruby>存在冲突。因此,用户可以从其中下载源代码编译而不是直接下载二进制。”,Donald Norwood 说。

### Debian 中的 ZFS 实现与 Ubuntu 中的那个不同

似乎有些人误解 Debian GNU/Linux 中的 ZFS 实现是来自 Ubuntu 16.04 中的 ZFS 实现,而据 <ruby> Software Freedom Conservancy <rp> ( </rp> <rt> 自由软件管理委员会 </rt> <rp> ) </rp></ruby> 称,[Ubuntu 中的 ZFS 实现违反了 GPL 许可证](https://sfconservancy.org/blog/2016/feb/25/zfs-and-linux/)。Debian 的 ZFS 软件包虽然[包含了一些来自 Ubuntu 的补丁](https://tracker.debian.org/news/767790),但是是以源代码的方式提供的,所以实质上绕开了 GPL 许可证的冲突。(注:据网友指正,此处语言有修饰。)

如果你想在你的 Debian GNU/Linux 中体验一下 ZFS,你可以从 contrib 仓库中下载最新的 zfs-linux 软件包。

更多关于 Debian 中的 ZFS 的细节,可以查看[此处](https://bits.debian.org/2016/05/what-does-it-mean-that-zfs-is-in-debian.html)。

| 301 | Moved Permanently | null |

7,344 | Linux 4.6 内核发布,引入 OrangeFS 和 USB 3.1 SSP 支持 | http://news.softpedia.com/news/linux-kernel-4-6-officially-released-introduces-orangefs-usb-3-1-ssp-support-504088.shtml | 2016-05-16T16:21:13 | [

"Linux",

"内核"

] | https://linux.cn/article-7344-1.html | 今天,美国时间 5 月 15 日, Linus Torvalds [宣布了](http://lkml.iu.edu/hypermail/linux/kernel/1605.1/05030.html) Linux 4.6 内核的正式发布。

经过了两个月的开发,历经了 7 个 RC 版本,Linux 4.6 内核终于发布了最终产品版本,带来了一些引人关注的新功能、更新的驱动程序以及一些安全改进。

“好在我不用中断 RC 周期,上周我们如预期的收到了几个修复,但是没有什么出乎意料的事情。所以, 4.6 就按照正常的计划发布了,这也意味着我明天就可以启动 4.7 的合并窗口啦。” Linus Torvalds 说。

### Linux 4.6 内核的新功能

Linux 4.6 内核的最引人注目的新功能是 OrangeFS 分布式文件系统、支持 USB 3.1 SuperSpeed Plus (SSP) 协议、提供了高达 10Gbps 的传输速度、改进了 <ruby> OOM 任务处理器 <rp> ( </rp> <rt> Out Of Memory task killer </rt> <rp> ) </rp></ruby>的可靠性、并支持了 Intel 内存保护键。

此外,Linux 4.6 内核也带有<ruby> 内核连接多路转接器 <rp> ( </rp> <rt> Kernel Connection Multiplexor </rt> <rp> ) </rp></ruby>、一个用于加速应用层协议的新部件、802.1AE MAC 级加密支持(MACsec)、OCFS2 文件系统的在线 inode 检查器、支持 BARMAN V 协议、支持 pNFS SCSI 布局。

最后,Linux 4.6 内核也包括了对 cgroup 名字空间和 dma-buf 的支持、一个新打造的 ioctl 专门用于管理 CPU 和 GPU 之间的缓存关联性。当然,也更新了不少驱动程序、修复了许多问题。

| 301 | Moved Permanently | null |

7,353 | Linux 内核里的数据结构——基数树 | https://github.com/0xAX/linux-insides/blob/master/DataStructures/radix-tree.md | 2016-05-18T08:56:00 | [

"基数树",

"字典树"

] | https://linux.cn/article-7353-1.html | ### <ruby> 基数树 <rp> ( </rp> <rt> Radix tree </rt> <rp> ) </rp></ruby>

正如你所知道的,Linux内核提供了许多不同的库和函数,它们实现了不同的数据结构和算法。在这部分,我们将研究其中一种数据结构——<ruby> <a href="http://en.wikipedia.org/wiki/Radix_tree"> 基数树 </a> <rp> ( </rp> <rt> Radix tree </rt> <rp> ) </rp></ruby>。在 Linux 内核中,有两个文件与基数树的实现和API相关:

* [include/linux/radix-tree.h](https://github.com/torvalds/linux/blob/master/include/linux/radix-tree.h)

* [lib/radix-tree.c](https://github.com/torvalds/linux/blob/master/lib/radix-tree.c)

让我们先说说什么是 `基数树` 吧。基数树是一种 <ruby> 压缩的字典树 <rp> ( </rp> <rt> compressed trie </rt> <rp> ) </rp></ruby> ,而[字典树](http://en.wikipedia.org/wiki/Trie)是实现了关联数组接口并允许以 `键值对` 方式存储值的一种数据结构。这里的键通常是字符串,但可以使用任意数据类型。字典树因为它的节点而与 `n叉树` 不同。字典树的节点不存储键,而是存储单个字符的标签。与一个给定节点关联的键可以通过从根遍历到该节点获得。举个例子:

```

+-----------+

| |

| " " |

| |

+------+-----------+------+

| |

| |

+----v------+ +-----v-----+

| | | |

| g | | c |

| | | |

+-----------+ +-----------+

| |

| |

+----v------+ +-----v-----+

| | | |

| o | | a |

| | | |

+-----------+ +-----------+

|

|

+-----v-----+

| |

| t |

| |

+-----------+

```

因此在这个例子中,我们可以看到一个有着两个键 `go` 和 `cat` 的 `字典树` 。压缩的字典树也叫做 `基数树` ,它和 `字典树` 的不同之处在于,所有只有一个子节点的中间节点都被删除。

Linux 内核中的基数树是把值映射到整形键的一种数据结构。[include/linux/radix-tree.h](https://github.com/torvalds/linux/blob/master/include/linux/radix-tree.h)文件中的以下结构体描述了基数树:

```

struct radix_tree_root {

unsigned int height;

gfp_t gfp_mask;

struct radix_tree_node __rcu *rnode;

};

```

这个结构体描述了一个基数树的根,它包含了3个域成员:

* `height` - 树的高度;

* `gfp_mask` - 告知如何执行动态内存分配;

* `rnode` - 孩子节点指针.

我们第一个要讨论的字段是 `gfp_mask` :

底层内核的内存动态分配函数以一组标志作为 `gfp_mask` ,用于描述如何执行动态内存分配。这些控制分配进程的 `GFP_` 标志拥有以下值:( `GF_NOIO` 标志)意味着睡眠以及等待内存,( `__GFP_HIGHMEM` 标志)意味着高端内存能够被使用,( `GFP_ATOMIC` 标志)意味着分配进程拥有高优先级并不能睡眠等等。

* `GFP_NOIO` - 睡眠等待内存

* `__GFP_HIGHMEM` - 高端内存能够被使用;

* `GFP_ATOMIC` - 分配进程拥有高优先级并且不能睡眠;

等等。

下一个字段是`rnode`:

```

struct radix_tree_node {

unsigned int path;

unsigned int count;

union {

struct {

struct radix_tree_node *parent;

void *private_data;

};

struct rcu_head rcu_head;

};

/* For tree user */

struct list_head private_list;

void __rcu *slots[RADIX_TREE_MAP_SIZE];

unsigned long tags[RADIX_TREE_MAX_TAGS][RADIX_TREE_TAG_LONGS];

};

```

这个结构体包含的信息有父节点中的偏移以及到底端(叶节点)的高度、子节点的个数以及用于访问和释放节点的字段成员。这些字段成员描述如下:

* `path` - 父节点中的偏移和到底端(叶节点)的高度

* `count` - 子节点的个数;

* `parent` - 父节点指针;

* `private_data` - 由树的用户使用;

* `rcu_head` - 用于释放节点;

* `private_list` - 由树的用户使用;

`radix_tree_node` 的最后两个成员—— `tags` 和 `slots` 非常重要且令人关注。Linux 内核基数树的每个节点都包含了一组<ruby> 指针槽 <rp> ( </rp> <rt> slots </rt> <rp> ) </rp></ruby>,槽里存储着指向数据的指针。在Linux内核基数树的实现中,空槽存储的是 `NULL` 。Linux内核中的基数树也支持<ruby> 标签 <rp> ( </rp> <rt> tags </rt> <rp> ) </rp></ruby>,它与 `radix_tree_node` 结构体的 `tags` 字段相关联。有了标签,我们就可以对基数树中存储的记录以单个<ruby> 比特位 <rp> ( </rp> <rt> bit </rt> <rp> ) </rp></ruby>进行设置。

既然我们了解了基数树的结构,那么该是时候看一下它的API了。

### Linux内核基数树API

我们从结构体的初始化开始。有两种方法初始化一个新的基数树。第一种是使用 `RADIX_TREE` 宏:

```

RADIX_TREE(name, gfp_mask);

```

正如你所看到的,我们传递了 `name` 参数,所以通过 `RADIX_TREE` 宏,我们能够定义和初始化基数树为给定的名字。`RADIX_TREE` 的实现很简单:

```

#define RADIX_TREE(name, mask) \

struct radix_tree_root name = RADIX_TREE_INIT(mask)

#define RADIX_TREE_INIT(mask) { \

.height = 0, \

.gfp_mask = (mask), \

.rnode = NULL, \

}

```

在 `RADIX_TREE` 宏的开始,我们使用给定的名字定义 `radix_tree_root` 结构体实例,并使用给定的 mask 调用 `RADIX_TREE_INIT` 宏。 而 `RADIX_TREE_INIT` 宏则是使用默认值和给定的mask对 `radix_tree_root` 结构体进行了初始化。

第二种方法是手动定义`radix_tree_root`结构体,并且将它和mask传给 `INIT_RADIX_TREE` 宏:

```

struct radix_tree_root my_radix_tree;

INIT_RADIX_TREE(my_tree, gfp_mask_for_my_radix_tree);

```

`INIT_RADIX_TREE` 宏的定义如下:

```

#define INIT_RADIX_TREE(root, mask) \

do { \

(root)->height = 0; \

(root)->gfp_mask = (mask); \

(root)->rnode = NULL; \

} while (0)

```

和`RADIX_TREE_INIT`宏所做的初始化工作一样,`INIT_RADIX_TREE` 宏使用默认值和给定的 mask 完成初始化工作。

接下来是用于向基数树插入和删除数据的两个函数:

* `radix_tree_insert`;

* `radix_tree_delete`;

第一个函数 `radix_tree_insert` 需要3个参数:

* 基数树的根;

* 索引键;

* 插入的数据;

`radix_tree_delete` 函数需要和 `radix_tree_insert` 一样的一组参数,但是不需要传入要删除的数据。

基数树的搜索以两种方法实现:

* `radix_tree_lookup`;

* `radix_tree_gang_lookup`;

* `radix_tree_lookup_slot`.

第一个函数`radix_tree_lookup`需要两个参数:

* 基数树的根;

* 索引键;

这个函数尝试在树中查找给定的键,并返回和该键相关联的记录。第二个函数 `radix_tree_gang_lookup` 有以下的函数签名:

```

unsigned int radix_tree_gang_lookup(struct radix_tree_root *root,

void **results,

unsigned long first_index,

unsigned int max_items);

```

它返回的是记录的个数。 `results` 中的结果,按键排序,并从第一个索引开始。返回的记录个数将不会超过 `max_items` 的值。

最后一个函数`radix_tree_lookup_slot`将会返回包含数据的指针槽。

### 链接

* [Radix tree](http://en.wikipedia.org/wiki/Radix_tree)

* [Trie](http://en.wikipedia.org/wiki/Trie)

---

via: <https://github.com/0xAX/linux-insides/blob/master/DataStructures/radix-tree.md>

作者:[0xAX] 译者:[cposture](https://github.com/cposture) 校对:[Mr小眼儿](https://github.com/tinyeyeser)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 404 | Not Found | null |

7,354 | 点评五款用于 Linux 编程的内存调试器 | http://www.computerworld.com/article/3003957/linux/review-5-memory-debuggers-for-linux-coding.html | 2016-05-19T09:36:00 | [

"调试",

"Mtrace",

"Dmalloc",

"Memwatch",

"Electric Fence",

"gdb"

] | https://linux.cn/article-7354-1.html |

>

> Credit: [Moini](https://openclipart.org/detail/132427/penguin-admin)

>

>

>

作为一个程序员,我知道我肯定会犯错误——怎么可能不犯错!程序员也是人啊。有的错误能在编码过程中及时发现,而有些却得等到软件测试了才能显露出来。然而,还有一类错误并不能在这两个阶段被解决,这就导致软件不能正常运行,甚至是提前终止。

如果你还没猜出是那种错误,我说的就是和内存相关的错误。手动调试这些错误不仅耗时,而且很难发现并纠正。值得一提的是,这种错误很常见,特别是在用 C/C++ 这类允许[手动管理内存](https://en.wikipedia.org/wiki/Manual_memory_management)的语言编写的软件里。

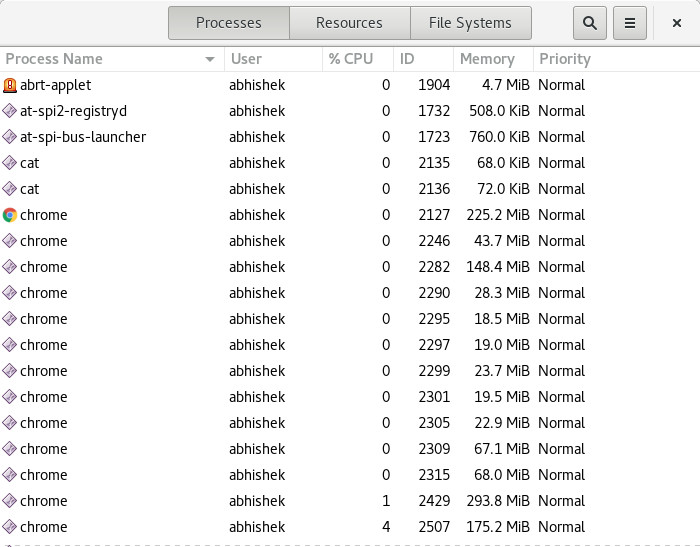

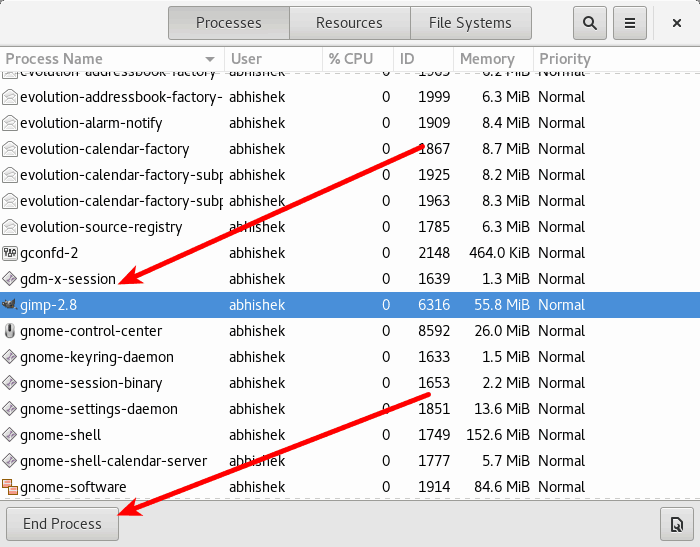

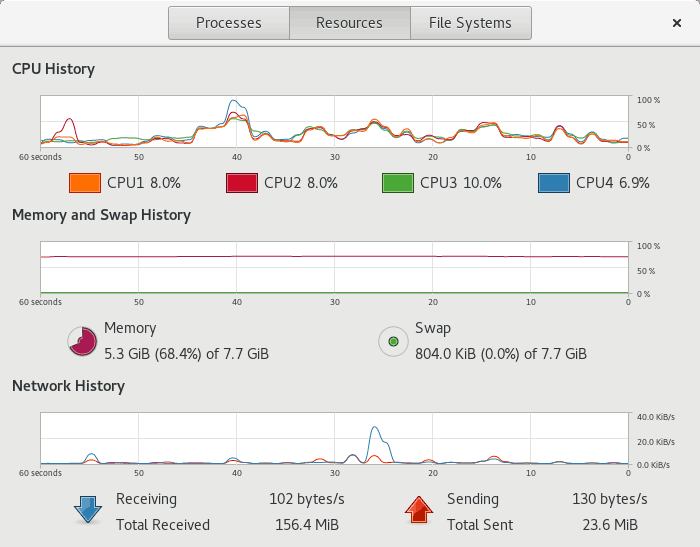

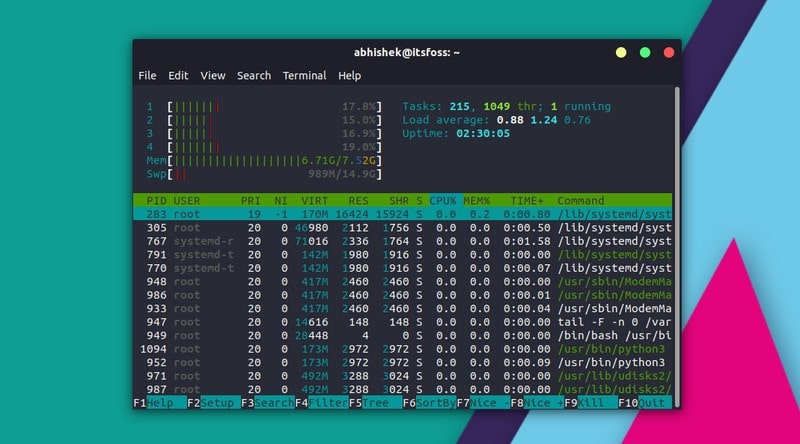

幸运的是,现在有一些编程工具能够帮你在软件程序中找到这些和内存相关的错误。在这些工具集中,我评估了五款支持 Linux 的、流行的、自由开源的内存调试器: Dmalloc 、 Electric Fence 、 Memcheck 、 Memwatch 以及 Mtrace 。在日常编码中,我已经用过这五个调试器了,所以这些评估是建立在我的实际体验之上的。

### [Dmalloc](http://dmalloc.com/)

**开发者**:Gray Watson

**评估版本**:5.5.2

**支持的 Linux 版本**:所有种类

**许可**: CC 3.0

Dmalloc 是 Gray Watson 开发的一款内存调试工具。它是作为库来实现的,封装了标准内存管理函数如`malloc()` , `calloc()` , `free()`等,使程序员得以检测出有问题的代码。

*Dmalloc*

如同工具的网页所示,这个调试器提供的特性包括内存泄漏跟踪、<ruby> <a href="https://www.owasp.org/index.php/Double_Free"> 重复释放内存 </a> <rp> ( </rp> <rt> double free </rt> <rp> ) </rp></ruby>错误跟踪、以及<ruby> <a href="https://stuff.mit.edu/afs/sipb/project/gnucash-test/src/dmalloc-4.8.2/dmalloc.html#Fence-Post%20Overruns"> 越界写入 </a> <rp> ( </rp> <rt> fence-post write </rt> <rp> ) </rp></ruby>检测。其它特性包括报告错误的文件/行号、通用的数据统计记录。

#### 更新内容

5.5.2 版本是一个 [bug 修正发行版](http://dmalloc.com/releases/notes/dmalloc-5.5.2.html),修复了几个有关构建和安装的问题。

#### 有何优点

Dmalloc 最大的优点就是高度可配置性。比如说,你可以配置它以支持 C++ 程序和多线程应用。 Dmalloc 还提供一个有用的功能:运行时可配置,这表示在 Dmalloc 执行时,可以轻易地启用或者禁用它提供的一些特性。

你还可以配合 [GNU Project Debugger (GDB)](http://www.gnu.org/software/gdb/)来使用 Dmalloc ,只需要将`dmalloc.gdb`文件(位于 Dmalloc 源码包中的 contrib 子目录里)的内容添加到你的主目录中的`.gdbinit`文件里即可。

另外一个让我对 Dmalloc 爱不释手的优点是它有大量的资料文献。前往官网的 [Documentation 栏目](http://dmalloc.com/docs/),可以获取所有关于如何下载、安装、运行、怎样使用库,和 Dmalloc 所提供特性的细节描述,及其生成的输出文件的解释。其中还有一个章节介绍了一般问题的解决方法。

#### 注意事项

跟 Mtrace 一样, Dmalloc 需要程序员改动他们的源代码。比如说你可以(也是必须的)添加头文件`dmalloc.h`,工具就能汇报产生问题的调用的文件或行号。这个功能非常有用,因为它节省了调试的时间。

除此之外,还需要在编译你的程序时,把 Dmalloc 库(编译 Dmalloc 源码包时产生的)链接进去。

然而,还有点更麻烦的事,需要设置一个环境变量,命名为`DMALLOC_OPTION`,以供工具在运行时配置内存调试特性,比如定义输出文件的路径。可以手动为该环境变量分配一个值,不过初学者可能会觉得这个过程有点困难,因为该值的一部分用来表示要启用的 Dmalloc 特性——以十六进制值的累加值表示。[这里](http://dmalloc.com/docs/latest/online/dmalloc_26.html#SEC32)有详细介绍。

一个比较简单方法设置这个环境变量是使用 [Dmalloc 实用指令](http://dmalloc.com/docs/latest/online/dmalloc_23.html#SEC29),这是专为这个目的设计的方法。

#### 总结

Dmalloc 真正的优势在于它的可配置选项。而且高度可移植,曾经成功移植到多种操作系统如 AIX 、 BSD/OS 、 DG/UX 、 Free/Net/OpenBSD 、 GNU/Hurd 、 HPUX 、 Irix 、 Linux 、 MS-DOG 、 NeXT 、 OSF 、 SCO 、 Solaris 、 SunOS 、 Ultrix 、 Unixware 甚至 Unicos(运行在 Cray T3E 主机上)。虽然使用 Dmalloc 需要学习许多知识,但是它所提供的特性值得为之付出。

### [Electric Fence](https://launchpad.net/ubuntu/+source/electric-fence/2.2.3)

**开发者**:Bruce Perens

**评估版本**:2.2.3

**支持的 Linux 版本**:所有种类

**许可**:GPL v2

Electric Fence 是 Bruce Perens 开发的一款内存调试工具,它以库的形式实现,你的程序需要链接它。Electric Fence 能检测出[堆](https://en.wikipedia.org/wiki/Memory_management#Dynamic_memory_allocation)内存溢出和访问已经释放的内存。

*Electric Fence*

顾名思义, Electric Fence 在每个所申请的缓存边界建立了虚拟围栏,这样一来任何非法的内存访问都会导致[段错误](https://en.wikipedia.org/wiki/Segmentation_fault)。这个调试工具同时支持 C 和 C++ 程序。

#### 更新内容

2.2.3 版本修复了工具的构建系统,使得 `-fno-builtin-malloc` 选项能真正传给 [GNU Compiler Collection (GCC)](https://en.wikipedia.org/wiki/GNU_Compiler_Collection)。

#### 有何优点

我喜欢 Electric Fence 的首要一点是它不同于 Memwatch 、 Dmalloc 和 Mtrace ,不需要对你的源码做任何的改动,你只需要在编译的时候把它的库链接进你的程序即可。

其次, Electric Fence 的实现保证了产生越界访问的第一个指令就会引起段错误。这比在后面再发现问题要好多了。

不管是否有检测出错误, Electric Fence 都会在输出产生版权信息。这一点非常有用,由此可以确定你所运行的程序已经启用了 Electric Fence 。

#### 注意事项

另一方面,我对 Electric Fence 真正念念不忘的是它检测内存泄漏的能力。内存泄漏是 C/C++ 软件最常见也是最不容易发现的问题之一。不过, Electric Fence 不能检测出栈溢出,而且也不是线程安全的。

由于 Electric Fence 会在用户分配内存区的前后分配禁止访问的虚拟内存页,如果你过多的进行动态内存分配,将会导致你的程序消耗大量的额外内存。

Electric Fence 还有一个局限是不能明确指出错误代码所在的行号。它所能做只是在检测到内存相关错误时产生段错误。想要定位错误的行号,需要借助 [GDB](http://www.gnu.org/software/gdb/)这样的调试工具来调试启用了 Electric Fence 的程序。

最后一点,尽管 Electric Fence 能检测出大部分的缓冲区溢出,有一个例外是,如果所申请的缓冲区大小不是系统字长的倍数,这时候溢出(即使只有几个字节)就不能被检测出来。

#### 总结

尽管局限性较大, Electric Fence 的易用性仍然是加分项。只要链接一次程序, Electric Fence 就可以在监测出内存相关问题的时候报警。不过,如同前面所说, Electric Fence 需要配合像 GDB 这样的源码调试器使用。

### [Memcheck](http://valgrind.org/docs/manual/mc-manual.html)

**开发者**:[Valgrind 开发团队](http://valgrind.org/info/developers.html)

**评估版本**:3.10.1

**支持的 Linux 发行版**:所有种类

**许可**:GPL

[Valgrind](http://valgrind.org/) 是一个提供好几款调试和分析 Linux 程序性能的工具的套件。虽然 Valgrind 能和不同语言——Java 、 Perl 、 Python 、 Assembly code 、 ortran 、 Ada 等——编写的程序一起工作,但是它主要还是针对使用 C/C++ 所编写的程序。

Memcheck ,一款内存错误检测器,是其中最受欢迎的工具。它能够检测出如内存泄漏、无效的内存访问、未定义变量的使用以及堆内存分配和释放相关的问题等诸多问题。

#### 更新内容

[工具套件( 3.10.1 )](http://valgrind.org/docs/manual/dist.news.html)主要修复了 3.10.0 版本发现的 bug 。除此之外,“从主干开发版本向后移植的一些补丁,修复了缺失的 AArch64 ARMv8 指令和系统调用”。

#### 有何优点

同其它所有 Valgrind 工具一样, Memcheck 也是命令行程序。它的操作非常简单:通常我们会使用诸如 `prog arg1 arg2` 格式的命令来运行程序,而 Memcheck 只要求你多加几个值即可,如 `valgrind --leak-check=full prog arg1 arg2` 。

*Memcheck*

(注意:因为 Memcheck 是 Valgrind 的默认工具,所以在命令行执行命令时无需提及 Memcheck。但是,需要在编译程序之初带上 `-g` 参数选项,这一步会添加调试信息,使得 Memcheck 的错误信息会包含正确的行号。)

我真正倾心于 Memcheck 的是它提供了很多命令行选项(如上所述的`--leak-check`选项),如此不仅能控制工具运转还可以控制它的输出。

举个例子,可以开启`--track-origins`选项,以查看程序源码中未初始化的数据;可以开启`--show-mismatched-frees`选项让 Memcheck 匹配内存的分配和释放技术。对于 C 语言所写的代码, Memcheck 会确保只能使用`free()`函数来释放内存,`malloc()`函数来申请内存。而对 C++ 所写的源码, Memcheck 会检查是否使用了`delete`或`delete[]`操作符来释放内存,以及`new`或者`new[]`来申请内存。

Memcheck 最好的特点,尤其是对于初学者来说,是它会给用户建议使用哪个命令行选项能让输出更加有意义。比如说,如果你不使用基本的`--leak-check`选项, Memcheck 会在输出时给出建议:“使用 --leak-check=full 重新运行以查看更多泄漏内存细节”。如果程序有未初始化的变量, Memcheck 会产生信息:“使用 --track-origins=yes 以查看未初始化变量的定位”。

Memcheck 另外一个有用的特性是它可以创建<ruby> <a href="http://valgrind.org/docs/manual/mc-manual.html#mc-manual.suppfiles"> 抑制文件 </a> <rp> ( </rp> <rt> suppression files </rt> <rp> ) </rp></ruby>,由此可以略过特定的不能修正的错误,这样 Memcheck 运行时就不会每次都报警了。值得一提的是, Memcheck 会去读取默认抑制文件来忽略系统库(比如 C 库)中的报错,这些错误在系统创建之前就已经存在了。可以选择创建一个新的抑制文件,或是编辑现有的文件(通常是`/usr/lib/valgrind/default.supp`)。

Memcheck 还有高级功能,比如可以使用[定制内存分配器](http://stackoverflow.com/questions/4642671/c-memory-allocators)来[检测内存错误](http://valgrind.org/docs/manual/mc-manual.html#mc-manual.mempools)。除此之外, Memcheck 提供[监控命令](http://valgrind.org/docs/manual/mc-manual.html#mc-manual.monitor-commands),当用到 Valgrind 内置的 gdbserver ,以及[客户端请求](http://valgrind.org/docs/manual/mc-manual.html#mc-manual.clientreqs)机制(不仅能把程序的行为告知 Memcheck ,还可以进行查询)时可以使用。

#### 注意事项

毫无疑问, Memcheck 可以节省很多调试时间以及省去很多麻烦。但是它使用了很多内存,导致程序执行变慢([由文档可知](http://valgrind.org/docs/manual/valgrind_manual.pdf),大概会花费 20 至 30 倍时间)。

除此之外, Memcheck 还有其它局限。根据用户评论, Memcheck 很明显不是[线程安全](http://sourceforge.net/p/valgrind/mailman/message/30292453/)的;它不能检测出 [静态缓冲区溢出](https://msdn.microsoft.com/en-us/library/ee798431%28v=cs.20%29.aspx);还有就是,一些 Linux 程序如 [GNU Emacs](http://www.computerworld.com/article/2484425/linux/5-free-linux-text-editors-for-programming-and-word-processing.html?nsdr=true&page=2) 目前还不能配合 Memcheck 工作。

如果有兴趣,可以在[这里](http://valgrind.org/docs/manual/manual-core.html#manual-core.limits)查看 Valgrind 局限性的详细说明。

#### 总结

无论是对于初学者还是那些需要高级特性的人来说, Memcheck 都是一款便捷的内存调试工具。如果你仅需要基本调试和错误检查, Memcheck 会非常容易上手。而当你想要使用像抑制文件或者监控指令这样的特性,就需要花一些功夫学习了。

虽然罗列了大量的局限性,但是 Valgrind(包括 Memcheck )在它的网站上声称全球有[成千上万程序员](http://valgrind.org/info/)使用了此工具。开发团队称收到来自超过 30 个国家的用户反馈,而这些用户的工程代码有的高达两千五百万行。

### [Memwatch](http://www.linkdata.se/sourcecode/memwatch/)

**开发者**:Johan Lindh

**评估版本**:2.71

**支持的 Linux 发行版**:所有种类

**许可**:GNU GPL

Memwatch 是由 Johan Lindh 开发的内存调试工具,虽然它扮演的主要角色是内存泄漏检测器,但是(根据网页介绍)它也具有检测其它如[内存重复释放和错误释放](http://www.cecalc.ula.ve/documentacion/tutoriales/WorkshopDebugger/007-2579-007/sgi_html/ch09.html)、缓冲区溢出和下溢、[野指针](http://c2.com/cgi/wiki?WildPointer)写入等等内存相关问题的能力。

Memwatch 支持用 C 语言所编写的程序。也可以在 C++ 程序中使用它,但是这种做法并不提倡(由 Memwatch 源码包随附的 Q&A 文件中可知)。

#### 更新内容

这个版本添加了`ULONG_LONG_MAX`以区分 32 位和 64 位程序。

#### 有何优点

跟 Dmalloc 一样, Memwatch 也有优秀的文档资料。参考 USING 文件,可以学习如何使用 Memwatch ,可以了解 Memwatch 是如何初始化、如何清理以及如何进行 I/O 操作,等等。还有一个 FAQ 文件,旨在帮助用户解决使用过程遇到的一般问题。最后还有一个`test.c`文件提供工作案例参考。

*Memwatch*

不同于 Mtrace , Memwatch 产生的日志文件(通常是`memwatch.log`)是人类可阅读的格式。而且, Memwatch 每次运行时总会把内存调试结果拼接到输出该文件的末尾。如此便可在需要之时轻松查看之前的输出信息。

同样值得一提的是当你执行了启用 Memwatch 的程序, Memwatch 会在[标准输出](https://en.wikipedia.org/wiki/Standard_streams#Standard_output_.28stdout.29)中产生一个单行输出,告知发现了错误,然后你可以在日志文件中查看输出细节。如果没有产生错误信息,就可以确保日志文件不会写入任何错误,多次运行的话确实能节省时间。

另一个我喜欢的优点是 Memwatch 还提供了在源码中获取其输出信息的方式,你可以获取信息,然后任由你进行处理(参考 Memwatch 源码中的`mwSetOutFunc()`函数获取更多有关的信息)。

#### 注意事项

跟 Mtrace 和 Dmalloc 一样, Memwatch 也需要你往你的源文件里增加代码:你需要把`memwatch.h`这个头文件包含进你的代码。而且,编译程序的时候,你需要连同`memwatch.c`一块编译;或者你可以把已经编译好的目标模块包含起来,然后在命令行定义`MEMWATCH`和`MW_STDIO`变量。不用说,想要在输出中定位行号, -g 编译器选项也少不了。

此外, Memwatch 缺少一些特性。比如 Memwatch 不能检测出对一块已经被释放的内存进行写入操作,或是在分配的内存块之外的进行读取操作。而且, Memwatch 也不是线程安全的。还有一点,正如我在开始时指出,在 C++ 程序上运行 Memwatch 的结果是不能预料的。

#### 总结

Memcheck 可以检测很多内存相关的问题,在处理 C 程序时是非常便捷的调试工具。因为源码小巧,所以可以从中了解 Memcheck 如何运转,有需要的话可以调试它,甚至可以根据自身需求扩展升级它的功能。

### [Mtrace](http://www.gnu.org/software/libc/manual/html_node/Tracing-malloc.html)

**开发者**: Roland McGrath 和 Ulrich Drepper

**评估版本**: 2.21

**支持的 Linux 发行版**:所有种类

**许可**:GNU GPL

Mtrace 是 [GNU C 库](https://www.gnu.org/software/libc/)中的一款内存调试工具,同时支持 Linux 上的 C 和 C++ 程序,可以检测由函数`malloc()`和`free()`不匹配的调用所引起的内存泄漏问题。

*Mtrace*

Mtrace 实际上是实现了一个名为`mtrace()`的函数,它可以跟踪程序中所有 malloc/free 调用,并在用户指定的文件中记录相关信息。文件以一种机器可读的格式记录数据,所以有一个 Perl 脚本——同样命名为 mtrace ——用来把文件转换并为人类可读格式。

#### 更新内容

[Mtrace 源码](https://sourceware.org/git/?p=glibc.git;a=history;f=malloc/mtrace.c;h=df10128b872b4adc4086cf74e5d965c1c11d35d2;hb=HEAD)和 [Perl 文件](https://sourceware.org/git/?p=glibc.git;a=history;f=malloc/mtrace.pl;h=0737890510e9837f26ebee2ba36c9058affb0bf1;hb=HEAD)同 GNU C 库( 2.21 版本)一起释出,除了更新版权日期,其它别无改动。

#### 有何优点

Mtrace 最好的地方是它非常简单易学。你只需要了解在你的源码中如何以及何处添加 `mtrace()` 及对应的 `muntrace()` 函数,还有如何使用 Mtrace 的 Perl 脚本。后者非常简单,只需要运行指令`mtrace <program-executable> <log-file-generated-upon-program-execution>`(例子见开头截图最后一条指令)。

Mtrace 另外一个优点是它的可伸缩性,这体现在不仅可以使用它来调试完整的程序,还可以使用它来检测程序中独立模块的内存泄漏。只需在每个模块里调用`mtrace()`和`muntrace()`即可。

最后一点,因为 Mtrace 会在`mtrace()`——在源码中添加的函数——执行时被触发,因此可以很灵活地[使用信号](http://webcache.googleusercontent.com/search?q=cache:s6ywlLtkSqQJ:www.gnu.org/s/libc/manual/html_node/Tips-for-the-Memory-Debugger.html+&cd=1&hl=en&ct=clnk&gl=in&client=Ubuntu)动态地(在程序执行时)使能 Mtrace 。

#### 注意事项

因为`mtrace()`和`mauntrace()`函数 —— 声明在`mcheck.h`文件中,所以必须在源码中包含此头文件 —— 的调用是 Mtrace 工作的基础(`mauntrace()`函数并非[总是必要](http://www.gnu.org/software/libc/manual/html_node/Using-the-Memory-Debugger.html#Using-the-Memory-Debugger)),因此 Mtrace 要求程序员至少改动源码一次。

需要注意的是,在编译程序的时候带上 -g 选项( [GCC](http://linux.die.net/man/1/gcc) 和 [G++](http://linux.die.net/man/1/g++) 编译器均有提供),才能使调试工具在输出结果时展示正确的行号。除此之外,有些程序(取决于源码体积有多大)可能会花很长时间进行编译。最后,带 -g 选项编译会增加了可执行文件的大小(因为提供了额外的调试信息),因此记得程序需要在测试结束后,不带 -g 选项重新进行编译。

使用 Mtrace ,你需要掌握 Linux 环境变量的基本知识,因为在程序执行之前,需要把用户把环境变量`MALLOC_TRACE`的值设为指定的文件(`mtrace()`函数将会记录全部信息到其中)路径。

Mtrace 在检测内存泄漏和试图释放未经过分配的内存方面存在局限。它不能检测其它内存相关问题如非法内存访问、使用未初始化内存。而且,[有人抱怨](https://sourceware.org/ml/libc-help/2014-05/msg00008.html) Mtrace 不是[线程安全](https://en.wikipedia.org/wiki/Thread_safety)的。

### 总结

不言自明,我在此讨论的每款内存调试器都有其优点和局限。所以,哪一款适合你取决于你所需要的特性,虽然有时候容易安装和使用也是一个决定因素。

要想捕获软件程序中的内存泄漏, Mtrace 最适合不过了。它还可以节省时间。由于 Linux 系统已经预装了此工具,对于不能联网或者不可以下载第三方调试调试工具的情况, Mtrace 也是极有助益的。

另一方面,相比 Mtrace , Dmalloc 不仅能检测更多错误类型,还提供更多特性,比如运行时可配置、 GDB 集成。而且, Dmalloc 不像这里所说的其它工具,它是线程安全的。更不用说它的详细资料了,这让 Dmalloc 成为初学者的理想选择。

虽然 Memwatch 的资料比 Dmalloc 的更加丰富,而且还能检测更多的错误种类,但是你只能在 C 语言写就的程序中使用它。一个让 Memwatch 脱颖而出的特性是它允许在你的程序源码中处理它的输出,这对于想要定制输出格式来说是非常有用的。

如果改动程序源码非你所愿,那么使用 Electric Fence 吧。不过,请记住, Electric Fence 只能检测两种错误类型,而此二者均非内存泄漏。还有就是,需要基本了解 GDB 以最大化发挥这款内存调试工具的作用。

Memcheck 可能是其中综合性最好的了。相比这里提及的其它工具,它能检测更多的错误类型,提供更多的特性,而且不需要你的源码做任何改动。但请注意,基本功能并不难上手,但是想要使用它的高级特性,就必须学习相关的专业知识了。

---

via: <http://www.computerworld.com/article/3003957/linux/review-5-memory-debuggers-for-linux-coding.html>

作者:[Himanshu Arora](http://www.computerworld.com/author/Himanshu-Arora/) 译者:[soooogreen](https://github.com/soooogreen) 校对:[PurlingNayuki](https://github.com/PurlingNayuki),[ezio](https://github.com/oska874)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,355 | 5 个很适合在课堂上演示的树莓派项目 | https://opensource.com/education/15/12/5-great-raspberry-pi-projects-classroom | 2016-05-20T10:14:00 | [

"树莓派"

] | https://linux.cn/article-7355-1.html |

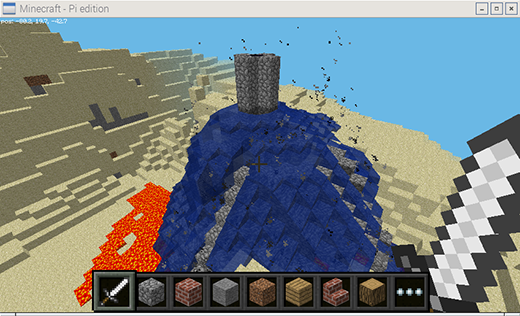

### 1. 我的世界: Pi

*源于 Raspberry Pi 基金会. [CC BY-SA 4.0](https://creativecommons.org/licenses/by-sa/4.0/)*

“我的世界”是世界上几乎每一个青少年都特别喜欢的一款游戏,而且它成功抓住了年轻人眼球,成为目前最能激发年轻人创造力的游戏之一。这个树莓派版本自带的我的世界不仅仅是一个具有创造性的建筑游戏,还是一个具有编程接口,可以通过 Python 与之交互的版本。

我的世界:Pi 版对于老师来说是一个教授学生解决问题和编写代码完成任务的好方式。你可以使用 Python API 创建一个房子,并且一直跟随这你的脚步移动,在所到之处建造一座桥,让天空落下熔岩雨滴,在空中显示温度,以及其它你可以想象到的一切东西。

详情请见 "[我的世界: Pi 入门](https://opensource.com/life/15/5/getting-started-minecraft-pi)"

### 2. 反应游戏和交通灯

*源于 [Low Voltage Labs](http://lowvoltagelabs.com/). [CC BY-SA 4.0](https://creativecommons.org/licenses/by-sa/4.0/)*

使用树莓派可以很轻松地进行物理计算,只需要连接几个 LED 和按钮到开发板上的 GPIO 接口,再用几行代码你就可以按下按钮来开灯。一旦你了解了如何使用代码来完成这些基本的操作,接下来就可以根据你的想象来做其它事情了。

如果你知道如何让一个灯闪烁,你就可以控制三个灯闪烁。挑选三个和交通灯一样颜色的 LED 灯,然后编写控制交通灯的代码。如果你知道如何使用按钮触发事件,那么你就可以模拟一个行人过马路。同时你可以参考其它已经完成的交通灯附件,比如[PI-TRAFFIC](http://lowvoltagelabs.com/products/pi-traffic/), [PI-STOP](http://4tronix.co.uk/store/index.php?rt=product/product&product_id=390), [Traffic HAT](https://ryanteck.uk/hats/1-traffichat-0635648607122.html),等等。

代码并不是全部——这只是一个演练,让你理解现实世界里系统是如何完成设计的。计算思维是一个让你终身受用的技能。

*源于 Raspberry Pi 基金会. [CC BY-SA 4.0](https://creativecommons.org/licenses/by-sa/4.0/)*

接下来试着接通两个按钮和 LED 灯的电源,实现一个双玩家的反应游戏 —— 让 LED 灯随机时间点亮,然后看是谁抢先按下按钮。

要想了解更多可以看看 [GPIO Zero recipes](http://pythonhosted.org/gpiozero/recipes/)。你所需要的资料都可以在 [CamJam EduKit 1](http://camjam.me/?page_id=236) 找到。

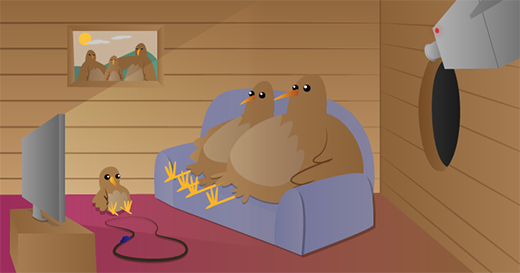

### 3. Sense HAT 电子宠物

Astro Pi —— 一个增强版的树莓派 —— 将在 12 月问世,但是你并没有错过亲手把玩这个硬件的机会。Sense HAT 是使用在 Astro Pi 的一个传感器扩展板,现在已经开放购买了。你可以使用它来进行数据搜集、科学实验,游戏等等。可以看看下面树莓派的 Carrie Anne 拍摄的 Gurl Geek Diaries 的视频,里面演示了一种很棒的入门途径——在 Sense HAT 屏幕上自己设计一个生动的像素宠物:[视频](https://youtu.be/gfRDFvEVz-w)(墙外)。

>

> 详见 "[探索 Sense HAT](https://opensource.com/life/15/10/exploring-raspberry-pi-sense-hat)."

>

>

>

### 4. 红外鸟笼

*源于 Raspberry Pi 基金会. [CC BY-SA 4.0](https://creativecommons.org/licenses/by-sa/4.0/)*

让整个班级都可以参与进来的好主意是在鸟笼里放置一个树莓派和夜视镜头,以及一些红外线灯,这样子你就可以在黑暗中看见鸟笼里的情况了,然后使用树莓派通过网络串流视频。然后就可以等待小鸟归笼了,你可以在不打扰的情况下近距离观察小窝里的它们了。

要了解更多有关红外线和光谱的知识,以及如何校准摄像头焦点和使用软件控制摄像头,可以访问 [打造一个红外鸟笼](https://www.raspberrypi.org/learning/infrared-bird-box/)。

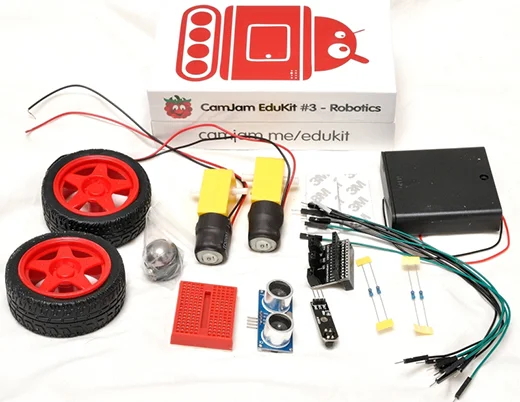

### 5. 机器人

*源于 Raspberry Pi 基金会. [CC BY-SA 4.0](https://creativecommons.org/licenses/by-sa/4.0/)*

只需要一个树莓派、很少的几个电机和电机控制器,你就可以自己动手制作一个机器人。可以制作的机器人有很多种,从简单的由几个轮子和自制底盘拼凑的简单小车,到由游戏控制器驱动、具有自我意识、配备了传感器,安装了摄像头的金属小马。

要学习如何控制不同的电机,可以使用 RTK 电机驱动开发板入门或者使用配置了电机、轮子和传感器的 CamJam 机器人开发套件——具有很大的价值和大量的学习潜力。

或者,如果你还想了解更多核心内容,可以试试 PiBorg 的 [4Borg](https://www.piborg.org/4borg)(£99/$150)和 [DiddyBorg](https://www.piborg.org/diddyborg)(£180/$273),或者购买 Metal 版 DoodleBorg (£250/$380),然后构建一个最小版本的 [DoodleBorg tank](https://www.piborg.org/doodleborg)(非卖品)。

详情可见 [机器人装备表](http://camjam.me/?page_id=1035#worksheets)。

---

via: <https://opensource.com/education/15/12/5-great-raspberry-pi-projects-classroom>

作者:[Ben Nuttall](https://opensource.com/users/bennuttall) 译者:[ezio](https://github.com/oska874) 校对:[Caroline](https://github.com/carolinewuyan)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | ## 1. Minecraft Pi

Courtesy of the Raspberry Pi Foundation. CC BY-SA 4.0.

Minecraft is the favorite game of pretty much every teenager in the world—and it's one of the most creative games ever to capture the attention of young people. The version that comes with every Raspberry Pi is not only a creative thinking building game, but comes with a programming interface allowing for additional interaction with the Minecraft world through Python code.

Minecraft: Pi Edition is a great way for teachers to engage students with problem solving and writing code to perform tasks. You can use the Python API to build a house and have it follow you wherever you go, build a bridge wherever you walk, make it rain lava, show the temperature in the sky, and anything else your imagination can create.

Read more in "[Getting Started with Minecraft Pi](https://opensource.com/life/15/5/getting-started-minecraft-pi)."

## 2. Reaction game and traffic lights

Courtesy of Low Voltage Labs. CC BY-SA 4.0.

It's really easy to get started with physical computing on Raspberry Pi—just connect up LEDs and buttons to the GPIO pins, and with a few lines of code you can turn lights on and control things with button presses. Once you know the code to do the basics, it's down to your imagination as to what you do next!

If you know how to flash one light, you can flash three. Pick out three LEDs in traffic light colors and you can code the traffic light sequence. If you know how to use a button to a trigger an event, then you have a pedestrian crossing! Also look out for great pre-built traffic light add-ons like [PI-TRAFFIC](http://lowvoltagelabs.com/products/pi-traffic/), [PI-STOP](http://4tronix.co.uk/store/index.php?rt=product/product&product_id=390), [Traffic HAT](https://ryanteck.uk/hats/1-traffichat-0635648607122.html), and more.

It's not always about the code—this can be used as an exercise in understanding how real world systems are devised. Computational thinking is a useful skill in any walk of life.

Courtesy of the Raspberry Pi Foundation. CC BY-SA 4.0.

Next, try wiring up two buttons and an LED and making a two-player reaction game—let the light come on after a random amount of time and see who can press the button first!

To learn more, check out [GPIO Zero recipes](http://pythonhosted.org/gpiozero/recipes/). Everything you need is in [CamJam EduKit 1](http://camjam.me/?page_id=236).

## 3. Sense HAT Pixel Pet

The Astro Pi—an augmented Raspberry Pi—is going to space this December, but you haven't missed your chance to get your hands on the hardware. The Sense HAT is the sensor board add-on used in the Astro Pi mission and it's available for anyone to buy. You can use it for data collection, science experiments, games and more. Watch this Gurl Geek Diaries video from Raspberry Pi's Carrie Anne for a great way to get started—by bringing to life an animated pixel pet of your own design on the Sense HAT display:

Learn more in "[Exploring the Sense HAT](https://opensource.com/life/15/10/exploring-raspberry-pi-sense-hat)."

## 4. Infrared bird box

Courtesy of the Raspberry Pi Foundation. CC BY-SA 4.0.

A great exercise for the whole class to get involved with—place a Raspberry Pi and the NoIR camera module inside a bird box along with some infra-red lights so you can see in the dark, then stream video from the Pi over the network or on the internet. Wait for birds to nest and you can observe them without disturbing them in their habitat.

Learn all about infrared and the light spectrum, and how to adjust the camera focus and control the camera in software.

Learn more in "[Make an infrared bird box](https://www.raspberrypi.org/learning/infrared-bird-box/)."

## 5. Robotics

Courtesy of Low Voltage Labs. CC BY-SA 4.0.

With a Raspberry Pi and as little as a couple of motors and a motor controller board, you can build your own robot. There is a vast range of robots you can make, from basic buggies held together by sellotape and a homemade chassis, all the way to self-aware, sensor-laden metallic stallions with camera attachments driven by games controllers.

Learn how to control individual motors with something straightforward like the RTK Motor Controller Board (£8/$12), or dive into the new CamJam robotics kit (£17/$25) which comes with motors, wheels and a couple of sensors—great value and plenty of learning potential.

Alternatively, if you'd like something more hardcore, try PiBorg's [4Borg](https://www.piborg.org/4borg) (£99/$150) or [DiddyBorg](https://www.piborg.org/diddyborg) (£180/$273) or go the whole hog and treat yourself to their DoodleBorg Metal edition (£250/$380)—and build a mini version of their infamous [DoodleBorg tank](https://www.piborg.org/doodleborg) (unfortunately not for sale).

Check out the [CamJam robotics kit worksheets](http://camjam.me/?page_id=1035#worksheets).

## 5 Comments |

7,356 | Docker 1.11 采纳了开源容器项目(OCP)组件 | http://www.infoworld.com/article/3055966/open-source-tools/docker-111-adopts-open-container-project-components.html | 2016-05-18T10:50:00 | [

"Docker",

"OCP"

] | https://linux.cn/article-7356-1.html |

>

> Docker 在<ruby> 开放容器项目 <rp> ( </rp> <rt> Open Container Project,OCP </rt> <rp> ) </rp></ruby>中的参与度达成圆满,最新构建的 Docker 采用了 Docker 贡献给 OCP 的组件。

>

>

>

新发布的 [Docker 1.11](https://blog.docker.com/2016/04/docker-engine-1-11-runc/) 的最大新闻并不是它的功能,而是它使用了在 OCP 支持下的标准化的组件版本。

去年,Docker 贡献了它的 [runC](http://runc.io/) 核心给 OCP 作为构建构建容器工具的基础。同样还有 [containerd](https://containerd.tools/),作为守护进程或者服务端用于控制 runC 的实例。Docker 1.11 现在使用的就是这个捐赠和公开的版本。

Docker 此举挑战了它的容器生态仍[主要由 Docker 自身决定](http://www.infoworld.com/article/2876801/application-virtualization/docker-reorganization-grows-up.html)这个说法。它并不是为了作秀才将容器规范和运行时细节贡献给 OCP。它希望项目将来的开发越开放和广泛越好。

*Docker 1.11 已经用贡献给 OCP 的 runC 和 containerd 进行了重构。runC 如果需要的话可以换成另外一个。*

runC 的[两位主要提交者](https://github.com/opencontainers/runc/graphs/contributors)来自 Docker,但是来自 Virtuozzo(Parallels fame)、OpenShift、Project Atomic、华为、GE Healthcare、Suse Linux 也都是提交人员里面的常客。

Docker 1.11 中一个更明显的变化是先前 Docker runtime 在 Docker 中是唯一可用的,并且评论家认为这个会限制用户的选择。runC runtime 现在是可替换的;虽然 Docker 在发布时将 runC 作为默认引擎,但是任何兼容的引擎都可以用来替换它。(Docker 同样希望它可以不用杀死并重启现在运行的容器,但是这个作为今后的改进规划。)

Docker 正在将基于 OCP 的开发流程作为内部创建其产品的更好方式。在它发布 1.11 的[官方博客中称](https://blog.docker.com/2016/04/docker-engine-1-11-runc/):“将 Docker 切分成独立的工具意味着更专注的维护者,最终会有更好的软件质量。”

除了修复长期以来存在的问题和确保 Docker 的 runC/containerd 跟上步伐,Docker 还在 Docker 1.11 中加入了一些改进。Docker Engine 现在支持 VLAN 和 IPv6 服务发现,并且会自动在多个相同别名容器间执行 DNS 轮询负载均衡。

---

via: <http://www.infoworld.com/article/3055966/open-source-tools/docker-111-adopts-open-container-project-components.html>

作者:[Serdar Yegulalp](http://www.infoworld.com/author/Serdar-Yegulalp/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,360 | SUSE Linux 企业版的实时补丁将带来无中断的服务 | http://news.softpedia.com/news/suse-linux-enterprise-live-patching-promises-100-uptime-for-businesses-504167.shtml | 2016-05-19T09:15:00 | [

"实时补丁",

"热补丁",

"SUSE"

] | https://linux.cn/article-7360-1.html | 开源先锋及 SUSE Linux 的创造者 SUSE 公司宣布推出 SUSE Linux 企业版的<ruby> <a href="https://www.suse.com/products/live-patching/"> 实时补丁 </a> <rp> ( </rp> <rt> Live Patching </rt> <rp> ) </rp></ruby>。

SUSE 是首批为基于 Linux 内核的操作系统提供实时补丁的开源公司之一。实时补丁技术是在 Linux 4.0 系列内核中实现的一种技术,发布于一年前。

但是,只有很少的 GNU/Linux 操作系统在其架构内支持了实时补丁功能,因为看起来该技术大多会用于企业用户,大型公司并不希望由于内核升级而导致业务中断。

从今天开始,所有运行 SAP NetWeaver 技术平台、SAP HANA 平台以及其它的 SAP(<ruby> 系统应用产品 <rp> ( </rp> <rt> Systems Applications Products </rt> <rp> ) </rp></ruby>)应用的 SUSE 用户都可以使用 [SUSE Linux 企业版实时补丁](https://www.suse.com/products/live-patching/)了,这可以帮助他们节约开销,业务永不停顿。

“依赖于实时数据和分析的服务日益竞争激烈,而保持应用服务器可持续访问很关键”,SUSE 战略联盟与市场总裁 Michael Miller 说道,“我们认为业务将不应该由于服务器更新而停顿。”

### 实时内核补丁可以让业务免受停机困扰

在过去,在那些需要高度安全的 IT 环境中,许多业务由于例行的停机维护而造成了大量损失。但是现在这一切都将改变,因为 SUSE Linux 企业版实时补丁,可以让企业级 Linux 用户应用内核补丁而不需要重启服务器。

SUSE Linux 企业版实时补丁也对于重要的 SAP 商业应用非常关键,比如那些运行 SAP HANA 的企业。该技术内建于内核之中,可以让 SUSE Linux 用户更新其正在运行的 Linux 内核,而不需要中断服务或由于重启服务器导致 SAP HANA 平台关闭。

| 301 | Moved Permanently | null |

7,365 | LFCS 系列第七讲:通过 SysVinit、Systemd 和 Upstart 管理系统自启动进程和服务 | http://www.tecmint.com/linux-boot-process-and-manage-services/ | 2016-05-20T10:01:00 | [

"LFCS",

"SysVinit",

"Systemd",

"Upstart"

] | https://linux.cn/article-7365-1.html | 几个月前, Linux 基金会宣布 LFCS (Linux 基金会认证系统管理员) 认证诞生了,这个令人兴奋的新计划定位于让来自全球各地的初级到中级的 Linux 系统管理员得到认证。这其中包括维护已经在运行的系统和服务的能力、第一手的问题查找和分析能力、以及决定何时向开发团队提交问题的能力。

*第七讲: Linux 基金会认证系统管理员*

下面的视频简要介绍了 Linux 基金会认证计划。

本讲是系列教程中的第七讲,在这篇文章中,我们会介绍如何管理 Linux 系统自启动进程和服务,这是 LFCS 认证考试要求的一部分。

### 管理 Linux 自启动进程

Linux 系统的启动程序包括多个阶段,每个阶段由一个不同的图示块表示。下面的图示简要总结了启动过程以及所有包括的主要组件。

*Linux 启动过程*

当你按下你机器上的电源键时,存储在主板 EEPROM 芯片中的固件初始化 POST(通电自检) 检查系统硬件资源的状态。POST 结束后,固件会搜索并加载位于第一块可用磁盘上的 MBR 或 EFI 分区的第一阶段引导程序,并把控制权交给引导程序。

#### MBR 方式

MBR 是位于 BIOS 设置中标记为可启动磁盘上的第一个扇区,大小是 512 个字节。

* 前面 446 个字节:包括可执行代码和错误信息文本的引导程序

* 接下来的 64 个字节:四个分区(主分区或扩展分区)中每个分区一条记录的分区表。其中,每条记录标示了每个一个分区的状态(是否活跃)、大小以及开始和结束扇区。

* 最后 2 个字节: MBR 有效性检查的魔法数。

下面的命令对 MBR 进行备份(在本例中,/dev/sda 是第一块硬盘)。结果文件 mbr.bkp 在分区表被破坏、例如系统不可引导时能排上用场。

当然,为了后面需要的时候能使用它,我们需要把它保存到别的地方(例如一个 USB 设备)。该文件能帮助我们重新恢复 MBR,这只在我们操作过程中没有改变硬盘驱动布局时才有效。

**备份 MBR**

```

# dd if=/dev/sda of=mbr.bkp bs=512 count=1

```

*在 Linux 中备份 MBR*

**恢复 MBR**

```

# dd if=mbr.bkp of=/dev/sda bs=512 count=1

```

*在 Linux 中恢复 MBR*

#### EFI/UEFI 方式

对于使用 EFI/UEFI 方式的系统, UEFI 固件读取它的设置来决定从哪里启动哪个 UEFI 应用。(例如, EFI 分区位于哪块磁盘或分区。

接下来,加载并运行第二阶段引导程序(又名引导管理器)。GRUB[GRand Unified Boot] 是 Linux 中最常使用的引导管理器。今天大部分使用的系统中都能找到它两个中的其中一个版本。

* GRUB 有效配置文件: /boot/grub/menu.lst(旧发行版, EFI/UEFI 固件不支持)。

* GRUB2 配置文件: 通常是 /etc/default/grub。

尽管 LFCS 考试目标没有明确要求了解 GRUB 内部知识,但如果你足够大胆并且不怕把你的系统搞乱(为了以防万一,你可以先在虚拟机上进行尝试)你可以运行:

```

# update-grub

```

为了使更改生效,你需要以 root 用户修改 GRUB 的配置。

首先, GRUB 加载默认的内核以及 initrd 或 initramfs 镜像。补充一句,initrd 或者 initramfs 帮助完成硬件检测、内核模块加载、以及发现挂载根目录文件系统需要的设备。

一旦真正的根目录文件系统启动,为了显示用户界面,内核就会执行系统和服务管理器(init 或 systemd,进程号 PID 一般为 1)开始普通用户态的引导程序。

init 和 systemd 都是管理其它守护进程的守护进程(后台进程),它们总是最先启动(系统引导时),最后结束(系统关闭时)。

*Systemd 和 Init*

### 自启动服务(SysVinit)

Linux 中运行等级通过控制运行哪些服务来以不同方式使用系统。换句话说,运行等级控制着当前执行状态下可以完成什么任务(以及什么不能完成)。

传统上,这个启动过程是基于起源于 System V Unix 的形式,通过执行脚本启动或者停止服务从而使机器进入指定的运行等级(换句话说,是一个不同的系统运行模式)。

在每个运行等级中,独立服务可以设置为运行、或者在运行时关闭。一些主流发行版的最新版本中,已经移除了标准的 System V,而用一个称为 systemd(表示系统守护进程)的新服务和系统管理器代替,但为了兼容性,通常也支持 sysv 命令。这意味着你可以在基于 systemd 的发行版中运行大部分有名的 sysv 初始化工具。

* 推荐阅读: [Linux 为什么用 ‘systemd’ 代替 ‘init’](http://www.tecmint.com/systemd-replaces-init-in-linux/)

除了启动系统进程,init 还会查看 /etc/inittab 来决定进入哪个运行等级。

| Runlevel | Description |

| --- | --- |

| 0 | 停止系统。运行等级 0 是一个用于快速关闭系统的特殊过渡状态。 |

| 1 | 别名为 s 或 S,这个运行等级有时候也称为维护模式。在这个运行等级启动的服务由于发行版不同而不同。通常用于正常系统操作损坏时低级别的系统维护。 |

| 2 | 多用户。在 Debian 系统及其衍生版中,这是默认的运行等级,还包括了一个图形化登录(如果有的话)。在基于红帽的系统中,这是没有网络的多用户模式。 |

| 3 | 在基于红帽的系统中,这是默认的多用户模式,运行除了图形化环境以外的所有东西。基于 Debian 的系统中通常不会使用这个运行等级以及等级 4 和 5。 |

| 4 | 通常默认情况下不使用,可用于自定制。 |

| 5 | 基于红帽的系统中,支持 GUI 登录的完全多用户模式。这个运行等级和等级 3 类似,但是有可用的 GUI 登录。 |

| 6 | 重启系统。 |

要在运行等级之间切换,我们只需要使用 init 命令更改运行等级:init N(其中 N 是上面列出的一个运行等级)。 请注意这并不是运行中的系统切换运行等级的推荐方式,因为它不会给已经登录的用户发送警告(因而导致他们丢失工作以及进程异常终结)。

相反,应该用 shutdown 命令重启系统(它首先发送警告信息给所有已经登录的用户,并锁住任何新的登录;然后再给 init 发送信号切换运行等级)但是,首先要在 /etc/inittab 文件中设置好默认的运行等级(系统引导到的等级)。

因为这个原因,按照下面的步骤切当地切换运行等级。以 root 用户在 /etc/inittab 中查找下面的行。

```

id:2:initdefault:

```

并用你喜欢的文本编辑器,例如 vim(本系列的 [LFCS 系列第二讲:如何安装和使用纯文本编辑器 vi/vim](/article-7165-1.html)),更改数字 2 为想要的运行等级。

然后,以 root 用户执行

```

# shutdown -r now

```

最后一个命令会重启系统,并使它在下一次引导时进入指定的运行等级,并会执行保存在 /etc/rc[runlevel].d 目录中的脚本以决定应该启动什么服务、不应该启动什么服务。例如,在下面的系统中运行等级 2。

*在 Linux 中更改运行等级*

#### 使用 chkconfig 管理服务

为了在启动时启动或者停用系统服务,我们可以在 CentOS / openSUSE 中使用 [chkconfig 命令](http://www.tecmint.com/chkconfig-command-examples/),在 Debian 及其衍生版中使用 sysv-rc-conf 命令。这个工具还能告诉我们对于一个指定的运行等级预先配置的状态是什么。

* 推荐阅读: [如何在 Linux 中停止和停用不想要的服务](http://www.tecmint.com/remove-unwanted-services-from-linux/)

列出某个服务的运行等级配置。

```

# chkconfig --list [service name]

# chkconfig --list postfix

# chkconfig --list mysqld

```

*列出运行等级配置*

从上图中我们可以看出,当系统进入运行等级 2 到 5 的时候就会启动 postfix,而默认情况下运行等级 2 到 4 时会运行 mysqld。现在假设我们并不希望如此。

例如,我们希望运行等级为 5 时也启动 mysqld,运行等级为 4 或 5 时关闭 postfix。下面分别针对两种情况进行设置(以 root 用户执行以下命令)。

**为特定运行等级启用服务**

```

# chkconfig --level [level(s)] service on

# chkconfig --level 5 mysqld on

```

**为特定运行等级停用服务**

```

# chkconfig --level [level(s)] service off

# chkconfig --level 45 postfix off

```

*启用/停用服务*

我们在基于 Debian 的系统中使用 sysv-rc-conf 完成类似任务。

#### 使用 sysv-rc-conf 管理服务

配置服务自动启动时进入指定运行等级,同时禁止启动时进入其它运行等级。

1. 我们可以用下面的命令查看启动 mdadm 时的运行等级。

```

# ls -l /etc/rc[0-6].d | grep -E 'rc[0-6]|mdadm'

```

*查看运行中服务的运行等级*

2. 我们使用 sysv-rc-conf 设置防止 mdadm 在运行等级2 之外的其它等级启动。只需根据需要(你可以使用上下左右按键)选中或取消选中(通过空格键)。

```

# sysv-rc-conf

```

*Sysv 运行等级配置*

然后输入 q 退出。

3. 重启系统并从步骤 1 开始再操作一遍。

```

# ls -l /etc/rc[0-6].d | grep -E 'rc[0-6]|mdadm'

```

*验证服务运行等级*

从上图中我们可以看出 mdadm 配置为只在运行等级 2 上启动。

### 那关于 systemd 呢?

systemd 是另外一个被多种主流 Linux 发行版采用的服务和系统管理器。它的目标是允许系统启动时多个任务尽可能并行(而 sysvinit 并非如此,sysvinit 一般比较慢,因为它每次只启动一个进程,而且会检查彼此之间是否有依赖,在启动其它服务之前还要等待守护进程启动),充当运行中系统动态资源管理的角色。

因此,服务只在需要的时候启动,而不是系统启动时毫无缘由地启动(为了防止消耗系统资源)。

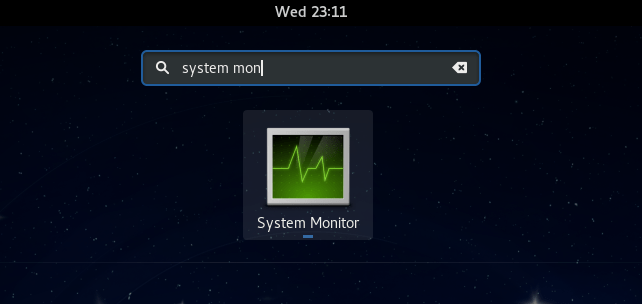

要查看你系统中运行的原生 systemd 服务和 Sysv 服务,可以用以下的命令。

```

# systemctl

```

*查看运行中的进程*

LOAD 一列显示了单元(UNIT 列,显示服务或者由 systemd 维护的其它进程)是否正确加载,ACTIVE 和 SUB 列则显示了该单元当前的状态。

**显示服务当前状态的信息**

当 ACTIVE 列显示某个单元状态并非活跃时,我们可以使用以下命令查看具体原因。

```

# systemctl status [unit]

```

例如,上图中 media-samba.mount 处于失败状态。我们可以运行:

```

# systemctl status media-samba.mount

```

*查看服务状态*

我们可以看到 media-samba.mount 失败的原因是 host dev1 上的挂载进程无法找到 //192.168.0.10/gacanepa 上的共享网络。

### 启动或停止服务

一旦 //192.168.0.10/gacanepa 上的共享网络可用,我们可以再来尝试启动、停止以及重启 media-samba.mount 单元。执行每次操作之后,我们都执行 systemctl stats media-samba.mout 来查看它的状态。

```

# systemctl start media-samba.mount

# systemctl status media-samba.mount

# systemctl stop media-samba.mount

# systemctl restart media-samba.mount

# systemctl status media-samba.mount

```

*启动停止服务*

**启用或停用某服务随系统启动**

使用 systemd 你可以在系统启动时启用或停用某服务

```

# systemctl enable [service] # 启用服务

# systemctl disable [service] # 阻止服务随系统启动

```

启用或停用某服务随系统启动包括在 /etc/systemd/system/multi-user.target.wants 目录添加或者删除符号链接。

*启用或停用服务*

你也可以用下面的命令查看某个服务的当前状态(启用或者停用)。

```

# systemctl is-enabled [service]

```

例如,

```

# systemctl is-enabled postfix.service

```

另外,你可以用下面的命令重启或者关闭系统。

```

# systemctl reboot

# systemctl shutdown

```

### Upstart

基于事件的 Upstart 是 /sbin/init 守护进程的替代品,它仅为在需要那些服务的时候启动服务而生,(或者当它们在运行时管理它们),以及处理发生的实践,因此 Upstart 优于基于依赖的 sysvinit 系统。

一开始它是为 Ubuntu 发行版开发的,但在红帽企业版 Linux 6.0 中得到使用。尽管希望它能在所有 Linux 发行版中替代 sysvinit,但它已经被 systemd 超越。2014 年 2 月 14 日,Mark Shuttleworth(Canonical Ltd. 创建者)发布声明之后的 Ubuntu 发行版采用 systemd 作为默认初始化守护进程。

由于 Sysv 启动脚本已经流行很长时间了,很多软件包中都包括了 Sysv 启动脚本。为了兼容这些软件, Upstart 提供了兼容模式:它可以运行保存在常用位置(/etc/rc.d/rc?.d, /etc/init.d/rc?.d, /etc/rc?.d或其它类似的位置)的Sysv 启动脚本。因此,如果我们安装了一个还没有 Upstart 配置脚本的软件,仍然可以用原来的方式启动它。

另外,如果我们还安装了类似 [chkconfig](http://www.tecmint.com/chkconfig-command-examples/) 的工具,你还可以和在基于 sysvinit 的系统中一样用它们管理基于 Sysv 的服务。

Upstart 脚本除了支持 Sysv 启动脚本,还支持基于多种方式启动或者停用服务;例如, Upstart 可以在一个特定硬件设备连接上的时候启动一个服务。

使用 Upstart以及它原生脚本的系统替换了 /etc/inittab 文件和 /etc/init 目录下和运行等级相关的以 .conf 作为后缀的 Sysv 启动脚本目录。

这些 \*.conf 脚本(也称为任务定义)通常包括以下几部分:

* 进程描述

* 进程的运行等级或者应该触发它们的事件

* 应该停止进程的运行等级或者触发停止进程的事件

* 选项

* 启动进程的命令

例如,

```

# My test service - Upstart script demo description "Here goes the description of 'My test service'" author "Dave Null <[email protected]>"

# Stanzas

#

# Stanzas define when and how a process is started and stopped

# See a list of stanzas here: http://upstart.ubuntu.com/wiki/Stanzas#respawn

# When to start the service

start on runlevel [2345]

# When to stop the service

stop on runlevel [016]

# Automatically restart process in case of crash

respawn

# Specify working directory

chdir /home/dave/myfiles

# Specify the process/command (add arguments if needed) to run

exec bash backup.sh arg1 arg2

```

要使更改生效,你要让 upstart 重新加载它的配置文件。

```

# initctl reload-configuration

```

然后用下面的命令启动你的任务。

```

$ sudo start yourjobname

```

其中 yourjobname 是之前 yourjobname.conf 脚本中添加的任务名称。

关于 Upstart 更完整和详细的介绍可以参考该项目网站的 “[Cookbook](http://upstart.ubuntu.com/cookbook/)” 栏目。

### 总结

了解 Linux 启动进程对于你进行错误处理、调整计算机系统以及根据需要运行服务非常有用。

在这篇文章中,我们分析了你按下电源键启动机器的一刻到你看到完整的可操作用户界面这段时间发生了什么。我希望你能像我一样把它们放在一起阅读。欢迎在下面留下你的评论或者疑问。我们总是期待听到读者的回复。

---

via: <http://www.tecmint.com/linux-boot-process-and-manage-services/>

作者:[Gabriel Cánepa](http://www.tecmint.com/author/gacanepa/) 译者:[ictlyh](http://mutouxiaogui.cn/blog/) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,370 | 震惊:2/3 被黑的网站隐藏着后门 | http://news.softpedia.com/news/two-in-three-hacked-websites-hide-a-backdoor-504242.shtml | 2016-05-21T10:34:00 | [

"入侵",

"后门"

] | https://linux.cn/article-7370-1.html | 网络安全公司 Sucuri 的安全专家说,他们在调查中发现有 68% 的被黑网站存在着隐藏的<ruby> 后门 <rp> ( </rp> <rt> backdoor </rt> <rp> ) </rp></ruby>脚本。这些后门脚本会给入侵者提供再次进入秘密通道,即便系统管理员改变了口令或应用了安全补丁,只要没有完全的清理整个系统,后门就会依旧存在。

从他们发布的[网站被黑报告](https://sucuri.net/website-security/Reports/Sucuri-Website-Hacked-Report-2016Q1.pdf) 2016 Q1 版中可以看到,全部取样的 11485 个网站中,有 4900 个网站发现了后门。

在这些被入侵的网站中,后门是最严重的问题,其次是恶意软件(通过浏览器端的代码进行<ruby> 挂马攻击 <rp> ( </rp> <rt> drive-by download </rt> <rp> ) </rp></ruby>),占比 60%。

第三名是 <ruby> SEO 垃圾 <rp> ( </rp> <rt> SEO spam </rt> <rp> ) </rp></ruby>,大约 32% 的网站存在该问题。SEO 垃圾通常会秘密嵌入到页面中,浏览者看不见,而对于搜索引擎的爬虫可见。

### 挂马攻击和 SEO 垃圾也很流行

SEO 垃圾可以帮助恶意攻击者提升其网站的搜索引擎排名,而对被感染的网站来说,则会受到搜索引擎的惩罚和排名下降。

这些受益的恶意攻击者通常会将 SEO 垃圾放到感染网站的源代码中、数据库中,或者通过 .htaccess 重定向实现。多数情况下,SEO 垃圾被用在药品方面,也有给成人内容或在线游戏提供的。

与去年相比,后门脚本比例略有降低,SEO 垃圾有小幅提升,而恶意软件感染则相较前些年增幅最大,从 2014 年的 41% 增加到了 2016 年的 60%!作为对比,后门脚本则从2014年的 59% 到 2015 年的 73%,现在回落到 68%;SEO 垃圾从 20% 到 28%,到了2016 年就增加到了 28%。

| 301 | Moved Permanently | null |

7,372 | 使用 arch-ppa 创建你自己的 Arch Linux 软件库 | http://news.softpedia.com/news/new-tool-promises-to-help-you-create-your-own-arch-linux-package-repositories-504257.shtml | 2016-05-22T09:35:00 | [

"软件仓库",

"Arch Linux",

"arch-ppa"

] | https://linux.cn/article-7372-1.html | 是不是觉得 AUR 软件库维护太复杂?那么我们来给你介绍一个新工具,可以让你很方便的维护一个你自己的 Arch Linux 软件仓库。

我们在互联网上发现了一个叫做 arch-ppa 的工具,它刚刚发布到 GitHub 上才几周,它作者 Ryan McGuire 说这个工具可以帮助你创建和维护一个安全可靠的个人 Arch Linux 软件仓库。

你可以把 arch-ppa 想象成一个 Arch Linux 下的 PPA(<ruby> 个人软件包存档 <rp> ( </rp> <rt> Personal Package Archive </rt> <rp> ) </rp></ruby>),就像 Ubuntu Linux 中常用的各种 PPA 一样。它存放在你自己的本地设备上,也可以放到远程服务器上以便你可以把你的软件包分发给成千上万的 Arch Linux 用户们。

### 因为 AUR 不安全,才有了 arch-ppa

arch-ppa 的开发者 Ryan McGuire 说他创建这个工具可以让 Arch Linux 的个人软件包生态系统更加的安全可靠,现在官方支持的 AUR(<ruby> <a href="https://aur.archlinux.org/"> Arch 用户软件库 </a> <rp> ( </rp> <rt> Arch User Repository </rt></ruby>)可以让任何人懂得 AUR 的人都可以上载新软件和维护它。

现在的情况是,如果你从 AUR 安装一个由你我维护这样的用户所维护的软件包,会触发一个大大的警告,是否接受该警告并安装取决于你自己。幸运的是, AUR 是由一群负责任的 Arch Linux 用户所维护的,他们一旦发现了恶意软件就会马上删除。

“这就是我为什么不喜欢类似 yaourt 或 pacaur 这样的 AUR 辅助程序。用这些辅助程序来使用 AUR 需要你经常查看它下载的 PKGBUILD 文件,才能让你可以确保不会安装了类似病毒或木马这样的东西以及从某个不知道来源的 URL 下载东西。” Ryan McGuire 说。

而这就是 arch-ppa 可以发挥用途的地方,AUR 软件包维护者希望开发一个好用的工具来帮助人工创建软件仓库,以便他们可以在一个安全可靠的环境中分发 Arch Linux 软件包。但是,要求就是你需要有一台服务器。

AUR 在 Arch Linux 用户群体里已经使用了很久,如果你想建立一个你自己的 Arch Linux 软件包归档,那么你应该试试 arch-ppa。具体情况请进一步访问该项目的 [GitHub 主页](https://github.com/EnigmaCurry/arch-ppa)。

| 301 | Moved Permanently | null |

7,378 | 使用 SystemBack 备份/还原你的 Ubuntu/Linux Mint | http://www.noobslab.com/2015/11/backup-system-restore-point-your.html | 2016-05-23T11:10:00 | [

"备份",

"还原",

"Systemback"

] | https://linux.cn/article-7378-1.html | 对于任何一款允许用户还原电脑到之前状态(包括文件系统,安装的应用,以及系统设置)的操作系统来说,系统还原功能都是必备功能,它可以恢复系统故障以及其他的问题。

有的时候安装一个程序或者驱动可能让你的系统黑屏。系统还原则可以让你电脑里面的系统文件(LCTT 译注:是系统文件,并非普通文件,详情请看**注意**部分)和程序恢复到之前工作正常时候的状态,进而让你远离那让人头痛的排障过程了,而且它也不会影响你的文件,照片或者其他数据。

简单的系统备份还原工具 [Systemback](https://launchpad.net/systemback) 可以让你很容易地创建系统备份以及用户配置文件。一旦遇到问题,你可以简单地恢复到系统先前的状态。它还有一些额外的特征包括系统复制,系统安装以及Live系统创建。

**截图**

**注意**:使用系统还原不会还原你自己的文件、音乐、电子邮件或者其他任何类型的私人文件。对不同用户来讲,这既是优点又是缺点。坏消息是它不会还原你意外删除的文件,不过你可以通过一个文件恢复程序来解决这个问题。如果你的计算机没有创建还原点,那么系统恢复就无法奏效,所以这个工具就无法帮助你(还原系统)。如果你尝试恢复这样的问题,你将需要移步到另外的步骤来进行故障排除。

>

> 适用于 Ubuntu 15.10 Wily/16.04/15.04 Vivid/14.04 Trusty/Linux Mint 14.x/其他Ubuntu衍生版,打开终端,将下面这些命令复制过去:

>

>

>

终端命令:

```

sudo add-apt-repository ppa:nemh/systemback

sudo apt-get update

sudo apt-get install systemback

```

大功告成。

---

via: <http://www.noobslab.com/2015/11/backup-system-restore-point-your.html>

译者:[DongShuaike](https://github.com/DongShuaike) 校对:[Caroline](https://github.com/carolinewuyan)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,380 | Ubuntu 的 Mir 显示服务器将支持 Vulkan | http://news.softpedia.com/news/vulkan-support-might-be-implemented-in-ubuntu-linux-s-mir-display-server-soon-504359.shtml | 2016-05-23T16:42:38 | [

"Vulkan",

"Mir",

"Unity"

] | https://linux.cn/article-7380-1.html | 很多人可能已经知道,Canonical 正在积极开发它的 Unity 用户界面,并将其用在 Ubuntu 桌面上。

Unity 8 是流行的 GNU/Linux 操作系统 Ubuntu 的下一代 Unity 桌面环境,Canonical 创始人 Mark Shuttleworth 之前说它马上就可以用了,并在即将到来的 Ubuntu 16.10 中会默认安装。

默认安装并不代表着它是默认桌面,Unity 7 仍将是 Ubuntu 16.10 的主要桌面环境。Ubuntu 16.10 将在今年的 10 月 20 日揭晓。当然,新的 Unity 8 环境在该版本发布后就可以直接切换使用了,不需要用户自己额外安装软件。

Canonical 已经在它的 Ubuntu 智能手机和平板上使用 Unity 8 用户界面获得了巨大成功,Unity 8 是由 Canonical 开发的 Mir 显示服务器所支撑的。现在这些新技术正在移植到 Ubuntu 桌面上,新功能请求也提交到了 Launchpad 上了。

### Mir 0.24 中完全支撑 Vulkan

Mir 当前版本是 0.22.1,但是据 Emanuele Antonio Faraone 在 2016 年 1 月[提交的功能请求](https://bugs.launchpad.net/mir/+bug/1539896),希望 Ubuntu 开发人员能够在 Mir 显示服务器和 Ubuntu 的系统镜像中完全支持 Vulkan 库的这一想法,已经得到了 Canonical 的首肯,看起来就快成为了现实。

>

> Vulkan 是一个跨平台的 2D 和 3D 绘图应用程序接口(API),最早由 Khronos Group 在2015年游戏开发者大会(GDC)上发表。就像 OpenGL,Vulkan 针对实时 3D 程序(如电子游戏)设计,Vulkan 并计划提供高性能和低 CPU 管理负担(overhead),这也是 Direct3D 12 和 AMD 的 Mantle 的目标。Vulkan 兼容 Mantle 的一个分支,并使用了 Mantle 的一些组件。

>

>

>

“过去几周已经初步集成了 Vulkan(Mesa),但是使用了一些私有头文件,” Mir 显示服务器项目负责人 Cemil Azizoglu 说,“还需要发布一些新的的 Mir 接口,当它们发布到开发主干上后,然后就可以准备放到正式版本了(0.24)。”

在写作此文时,Canonical 已经将完全支持 Vulkan API 作为当前正在开发的 [Mir 0.24](https://launchpad.net/mir/0.24) 的里程碑目标了。不过从上面的引述可以看到,Mir 中的 Vulkan 支持还需要不少开发工作。

| 301 | Moved Permanently | null |

7,383 | systemd 230 发布,其 DNS 解析器默认支持 DNSSEC | http://news.softpedia.com/news/systemd-230-launches-with-dnssec-enabled-by-default-in-systemd-resolved-more-504339.shtml | 2016-05-24T08:26:00 | [

"systemd",

"DNSSEC"

] | https://linux.cn/article-7383-1.html | Zbigniew Jędrzejewski-Szmek [宣布](https://lists.freedesktop.org/archives/systemd-devel/2016-May/036583.html) systemd 发布了 230 版本,这是一个主要更新版本。上个版本 systemd 229 发布于大约三个月前。

本次更新主要的关注点是其 DNS 解析服务 systemd-resolved,现在它可以使用 DNSSEC 来校验解析结果了。正如你所知道的,systemd 的“魔爪”已经伸向了 GNU/Linux 中除了内核以外的各个基础部分,比如 DNS 解析器就是一个例子,它用于为系统内的 DNS 解析请求提供服务。在本次更新中,当使用“allow-downgrade”模式时,它会默认打开 DNSSEC 扩展。DNSSEC 是一个用于校验 DNS 解析数据是否安全的扩展,对于防范 DNS 欺诈有重要作用,只是到目前为止还有不少 DNS 服务器尚未支持,所以,你也可以在编译时通过增加“--with-default-dnssec=no”编译参数来关闭它。

“我们建议下游维护人员在开发期间打开该功能,并将发现的问题报告给上游,”Zbigniew Jędrzejewski-Szmek 说,“我们非常希望得到 DNSSEC 校验器的反馈,不管是哪种反馈。不过要注意,DNSSEC 支持可能在下游发行版的稳定版本中关闭,因为它可能会导致和一些 DNS 服务器及网络的不兼容。”

当然,systemd-resolved 并不是 systemd 初始化系统中唯一得到改进的部件,其它的部件也有不少改变。

systemd 230 不久之后将会进入到各个以 systemd 作为默认的初始化系统的 Linux 发行版之中。

| 301 | Moved Permanently | null |

7,385 | 《道德经》之项目管理 | https://opensource.com/open-organization/16/2/tao-project-management | 2016-05-24T15:58:00 | [

"项目管理",

"道德经"

] | https://linux.cn/article-7385-1.html |

《[道德经](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html)》,[被认为](https://en.wikipedia.org/wiki/Tao_Te_Ching)是由圣人[老子](http://plato.stanford.edu/entries/laozi/)于公元前六世纪时所编写,是现存最为广泛翻译的经文之一。从[宗教](https://en.wikipedia.org/wiki/Taoism)到[关于约会的有趣电影](http://www.imdb.com/title/tt0234853/)等方方面面,它都深深地影响着它们,作者们借用它来做隐喻,以解释各种各样的事情(甚至是[编程](http://www.mit.edu/%7Exela/tao.html))。

在思考有关开放性组织的项目管理时,我的脑海中便立马浮现出上面的这段文字。

这听起来可能会有点奇怪。若要理解我的这种想法从何而来,你应该读读 **《开放性组织:点燃激情提升执行力》** 这本书,它是红帽公司总裁、首席执行官 Jim Whitehurst 所写的一本有关企业文化和新领导力范式的宣言。在这本书中,Jim(还有来自其他红帽人的一点帮助)解释了传统组织机构(一种 “自上而下” 的方式,来自高层的决策被传达到员工,而员工通过晋升和薪酬来激励)和开放性组织机构(一种 自下而上 的方式,领导专注于激励和鼓励,员工被充分授权以各尽其能)之间的差异。

在开放性组织中的员工都是被激情、目标和参与感所激励,这个观点正是我认为项目管理者所应该关注的。

要解释这一切,我将从**道德经**上寻找依据。

### 不要让工作职衔框住自身

>

> <ruby> 道,可道也, <rp> ( </rp> <rt> The tao that can be told </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 非恒道也。 <rp> ( </rp> <rt> is not the eternal Tao </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 名,可名也, <rp> ( </rp> <rt> The name that can be named </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 非恒名也。 <rp> ( </rp> <rt> is not the eternal Name. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> “无”,名天地之始; <rp> ( </rp> <rt> The unnameable is the eternally real. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> “有”,名万物之母。 <rp> ( </rp> <rt> Naming is the origin of all particular things. </rt> <rp> ) </rp></ruby>

>

>

> [第一章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html)

>

>

>

项目管理到底是什么?作为一个项目管理者应该做些什么呢?

如您所想,项目管理者的一部分工作就是管理项目:收集需求、与项目相关人员沟通、设置项目优先级、安排任务、帮助团队解决困扰。许多机构都可以教你如何做好项目管理,并且这些技能你值得拥有。

然而,在开放性组织中,字面上的项目管理技能仅仅只是项目管理者需要做到的一小部分,这些组织需要更多其他的东西:即勇气。如果你擅长于管理项目(或者是真的擅长于任何工作),那么你就进入了舒适区。这时候就是需要鼓起勇气开始尝试冒险之时。

您有勇气跨出舒适区吗?向权威人士提出挑战性的问题,可能会引发对方的不快,但也可能会开启一个更好的方法,您有勇气这样做吗?有确定需要做的下一件事,然后真正去完成它的勇气吗?有主动去解决因为交流的鸿沟而遗留下来的问题的勇气吗?有去尝试各种事情的勇气吗?有失败的勇气吗?

道德经的开篇(上面引用的)就表明<ruby> 词语 <rp> ( </rp> <rt> words </rt> <rp> ) </rp></ruby>、<ruby> 标签 <rp> ( </rp> <rt> labels </rt> <rp> ) </rp></ruby>、<ruby> 名字 <rp> ( </rp> <rt> names </rt> <rp> ) </rp></ruby>这些是有限制的,当然也包括工作职衔。在开放性组织中,项目经理不仅仅是执行管理项目所需的机械任务,而且要帮助团队完成组织的使命,尽管这已经被限定了。

### 联系起合适的人

>

> <ruby> 三十辐共一轂, <rp> ( </rp> <rt> We join spokes together in a wheel, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 当其无, <rp> ( </rp> <rt> but it is the center hole </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 有车之用。 <rp> ( </rp> <rt> that makes the wagon move. </rt> <rp> ) </rp></ruby>

>

>

> [第十一章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html#38)

>

>

>

当我过渡到项目管理的工作时,我必须学会的最为困难的一课是:并不是所有解决方案都是可完全地接受,甚至有的连预期都达不到。这对我来说是全新的一页。我**喜欢**全部都能解决。但作为项目管理者,我的角色更多的是与人沟通--使得那些确实有解决方案的人可以更高效地合作。

这并不是逃避责任或者不负责。这意味着可以很舒适的说,“我不知道,但我会给你找出答案”,然后就可迅速地结束这个循环。

想像一下马车的车轮,如果没有毂中的孔洞所提供的稳定性和方向,辐条便会失去支持,车轮也会散架。在一个开放性的组织中,项目管理者可以通过把合适的人凝聚在一起,培养正确的讨论话题来帮助团队保持持续向前的动力。

### 信任你的团队

>

> <ruby> 太上,不知有之; <rp> ( </rp> <rt> When the Master governs, the people are hardly aware that he exists. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 其次,亲而誉之; <rp> ( </rp> <rt> Next best is a leader who is loved. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 其次,畏之; <rp> ( </rp> <rt> Next, one who is feared. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 其次,侮之。 <rp> ( </rp> <rt> The worst is one who is despised. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 信不足焉, <rp> ( </rp> <rt> If you don't trust the people, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 有不信焉。 <rp> ( </rp> <rt> you make them untrustworthy. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 悠兮,其贵言。 <rp> ( </rp> <rt> The Master doesn't talk, he acts. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 功成事遂, <rp> ( </rp> <rt> When his work is done, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 百姓皆谓:“我自然”。 <rp> ( </rp> <rt> the people say, "Amazing: we did it, all by ourselves!" </rt> <rp> ) </rp></ruby>

>

>

> [第十七章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html#17)

>

>

>

[Rebecca Fernandez](https://opensource.com/users/rebecca) 曾经告诉我开放性组织的领导与其它组织的领导者最大的不同点在于,我们不是去取得别人的信任,而是信任别人。

开放性组织会雇佣那些非常聪明的,且对公司正在做的事情充满激情的人来做工作。为了能使他们能更好的工作,我们会提供其所需,并尊重他们的工作方式。

至于原因,我认为从道德经中摘出的上面一段就说的很清楚。

### 顺其自然

>

> <ruby> 上德无为而无以为; <rp> ( </rp> <rt> The Master does nothing yet he leaves nothing undone. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 下德为之而有以为。 <rp> ( </rp> <rt> The ordinary man is always doing things, yet many more are left to be done. </rt> <rp> ) </rp></ruby>

>

>

> [第三十八章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html#38)

>

>

>

你认识那类总是极其忙碌的人吗?认识那些因为有太多事情要做而看起来疲倦和压抑的人吗?

不要成为那样的人。

我知道说比做容易。帮助我没有成为那类人的最重要的东西是:我时刻记着*大家都很忙*这件事。我没有一个那样无聊的同事。

但总需要有人成为在狂风暴雨中仍保持镇定的人。总需要有人能够宽慰团队告诉他们一切都会好起来,我们将在现实和一天中工作时间有限的情况下,找到方法使得任务能够完成(因为事实就是这样的,而且我们必须这样)。

成为那样的人吧。

对于上面这段道德经所说的,我的理解是那些总是谈论他或她正在做什么的人实际上并**没有时间**去做他们谈论的事。如果相比于你周围的人,你能把你的工作做的毫不费劲,那就说明你的工作做对了。

### 做一名文化传教士

>

> <ruby> 上士闻道, <rp> ( </rp> <rt> When a superior man hears of the Tao, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 勤而行之; <rp> ( </rp> <rt> he immediately begins to embody it. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 中士闻道, <rp> ( </rp> <rt> When an average man hears of the Tao, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 若存若亡; <rp> ( </rp> <rt> he half believes it, half doubts it. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 下士闻道, <rp> ( </rp> <rt> When a foolish man hears of the Tao, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 大笑之。 <rp> ( </rp> <rt> he laughs out loud. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 不笑不足以為道。 <rp> ( </rp> <rt> If he didn't laugh,it wouldn't be the Tao. </rt> <rp> ) </rp></ruby>

>

>

> [第四十一章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html#41)

>

>

>

去年秋天,我和一群联邦雇员参加了一堂 MBA 的商业准则课程。当我开始介绍我们公司的文化、价值和伦理框架时,我得到的直接印象是:我的同学和教授都认为我就像一个天真可爱的小姑娘,做着许多关于公司应该如何运作的[甜美白日梦](https://opensource.com/open-organization/15/9/reflections-open-organization-starry-eyed-dreamer)。他们告诉我事情不可能是他们看起来的那样,他们还告诉我应该进一步考察。

所以我照做了。

然而我发现的是:事情**恰好**是他们看起来的那样。

在开放性组织,关于企业文化,人们应该随着企业的成长而时时维护那些文化,以使它随时精神焕发,充满斗志。我(和其它开源组织的成员)并不想过着如我同学们所描述的那样,“为生活而工作”。我需要有激情、有目标,需要明白自己的日常工作是如何对那些我所坚信的东西做贡献的。

作为一个项目管理者,你可能会认为在你的团队中,你的工作对培养你们公司的企业文化没有多少帮助。然而你的工作正是孕育文化本身。

### <ruby> Kaizen <rp> ( </rp> <rt> 持续改善 </rt> <rp> ) </rp></ruby>

>

> <ruby> 为学日益, <rp> ( </rp> <rt> In pursuit of knowledge,every day something is added. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 为道日损。 <rp> ( </rp> <rt> In the practice of the Tao,every day something is dropped. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 损之又损, <rp> ( </rp> <rt> Less and less do you need to force things, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 以至于无为。 <rp> ( </rp> <rt> until finally you arrive at non-action. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 无为而无不为。 <rp> ( </rp> <rt> When nothing is done,nothing is left undone. </rt> <rp> ) </rp></ruby>

>

>

> [第四十八章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html#48)

>

>

>

项目管理的常规领域都太过于专注最新、最强大的的工具,但对于应该使用哪种工具,这个问题的答案总是一致的:“最简单的”。

例如,我将任务列表放在桌面的一个文本文件中,因为它很单纯,不会受到不必要的干扰。您想介绍给团队的,无论是何种工具、流程和程序都应该是能提高效率,排除障碍的,而不是引入额外的复杂性。所以与其专注于工具,还不如专注于要使用这些工具来解决的**问题**。

作为一个项目经理,我最喜爱的部分是在敏捷世界中,我有自由抛弃那些没有成效的东西的权利。这与 [kaizen](https://www.kaizen.com/about-us/definition-of-kaizen.html) 的概念相关,或叫 “持续改进”。不要害怕尝试和失败。失败是我们在探索什么能够起作用,什么不能起作用的过程中所用的标签,这是提高的唯一方式。

最好的过程都不是一蹴而就的。作为项目管理者,你应该通过支持他们,而不是强迫他们去做某些事来帮助你的团队。

### 实践

>

> <ruby> 天下皆谓我“道”大, <rp> ( </rp> <rt> Some say that my teaching is nonsense. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 似不肖。 <rp> ( </rp> <rt> Others call it lofty but impractical. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 夫唯大, <rp> ( </rp> <rt> But to those who have looked inside themselves, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 故似不肖。 <rp> ( </rp> <rt> this nonsense makes perfect sense. </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 若肖, <rp> ( </rp> <rt> And to those who put it into practice, </rt> <rp> ) </rp></ruby>

>

>

> <ruby> 久矣其细也夫! <rp> ( </rp> <rt> this loftiness has roots that go deep. </rt> <rp> ) </rp></ruby>

>

>

> [第六十七章](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html#67)

>

>

>

我相信开放性组织正在做的事。开放性组织在管理领域的工作几乎与他们提供的产品和服务一样重要。我们有机会以身作则,激发他人的激情和目的,创造激励和充分授权的工作环境。

我鼓励你们找到办法把这些想法融入到自己的项目和团队中,看看会发生什么。了解你们组织的使命,知晓你的项目是如何为这个使命做贡献的。鼓起勇气,尝试某些看起来没有多少成效的事,同时不要忘记和我们的社区分享你所学到的经验,这样我们就可以继续改进。

---

via: <https://opensource.com/open-organization/16/2/tao-project-management>

作者:[Allison Matlack](https://opensource.com/users/amatlack) 译者:[runningwater](https://github.com/runningwater) 校对:[FSSlc](https://github.com/FSSlc)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | The [Tao Te Ching](http://acc6.its.brooklyn.cuny.edu/%7Ephalsall/texts/taote-v3.html), [believed to have been written](https://en.wikipedia.org/wiki/Tao_Te_Ching) by the sage [Lao Tzu](http://plato.stanford.edu/entries/laozi/) in the 6th century BCE, is among the most widely translated texts in existence. It has inspired everything from [religions](https://en.wikipedia.org/wiki/Taoism) to [funny movies about dating](http://www.imdb.com/title/tt0234853/), and authors have used it as a metaphor to explain all kinds of things (even [programming](http://www.mit.edu/%7Exela/tao.html)).

This text is what immediately comes to my mind when thinking about project management in open organizations.

That might sound strange. But to understand where I'm coming from, you should start by reading *The Open Organization: Igniting Passion and Performance*, Red Hat president and CEO Jim Whitehurst's manifesto on corporate culture and the new leadership paradigm. In this book, Jim (with a little help from other Red Hatters) explains the difference between conventional organizations (a "top-down" approach, with decisions coming down from central command to employees motivated by promotion and pay) and open organizations (a bottom-up approach, with leaders focused on inspiring purpose and passion so employees are empowered to be and do their best).

This concept—that employees in open organizations are motivated by passion, purpose, and engagement—plays directly into where I think project managers should focus.

And to explain, I'll return to the *Tao Te Ching*.

## Don't let your job title define you

The tao that can be told

is not the eternal Tao

The name that can be named

is not the eternal Name.The unnameable is the eternally real.

Naming is the origin

of all particular things. [[1]]

What exactly is *project management*? And what does a project manager *do*?

As you might expect, part of being a project manager is *managing projects*: gathering requirements, managing stakeholder communication, setting priority, scheduling tasks, helping the team resolve blockers. Many [institutions](http://www.pmi.org/certification/project-management-professional-pmp.aspx) can teach you how to manage projects very well, and these are good skills to have.

However, *literally* managing projects is only part of what project managers in open organizations do. These organizations require something more: *Courage*. If you're good at managing projects (or if you're good at any job, really), then you can start to feel safe in your routine. That's when you know you need to find the courage to take a risk.

Do you have the courage to step outside of your comfort zone? The courage to ask important people challenging questions that might raise eyebrows, but that might also uncover a better way forward? The courage to identify the next thing that needs to be done—then the courage to go and do it? The courage to call out communication gaps and take initiative to fix them? The courage to try things? The courage to fail?

The opening passage of the *Tao Te Ching* (which I cited above) suggests that words, labels, and names are limiting. That includes job titles. In open organizations, project managers don't just perform the rote tasks required to manage projects. They help teams *accomplish the organization's mission*, however defined.

## Connect the right people

We join spokes together in a wheel,

but it is the center hole

that makes the wagon move. [[11]]

One of the most difficult lessons I had to learn as I transitioned into project management was that not having all the answers was perfectly acceptable, even expected. That was new for me. I *like* having all the answers. But as a project manager, my role is more about *connecting* people—so the ones who *do* have the answers can collaborate efficiently.

This does not mean dodging responsibility or ownership. This means being comfortable saying, "I don't know, but I will find out for you," and closing that loop as quickly as possible.

Picture a wagon wheel. Without the stability and direction provided by the center hole, the spokes would fall and the wheel collapse in on itself. Project managers in an open organization can help a team maintain forward momentum by bringing the right people together and cultivating the right discussions.

## Trust your team

When the Master governs, the people

are hardly aware that he exists.

Next best is a leader who is loved.

Next, one who is feared.

The worst is one who is despised.If you don't trust the people,

you make them untrustworthy.The Master doesn't talk, he acts.

When his work is done,

the people say, "Amazing:

we did it, all by ourselves!" [[17]]

[Rebecca Fernandez](https://opensource.com/users/rebecca) once told me that what differentiates leaders in open organizations is not the trust people have *in them*, but the trust *they have* in other people.

Open organizations do a great job hiring smart people who are passionate about what their companies are doing. In order for them to do their best work, we have to give them what they need and then get out of their way.

Here, I think the above passage from the *Tao Te Ching* speaks for itself.

## Be effortless

The Master does nothing

yet he leaves nothing undone.

The ordinary man is always doing things,

yet many more are left to be done. [[38]]

Do you know the type of person who is always extremely busy? The one who seems frazzled and stressed with too many things to do?

Don't be that person.

I know that's easier said than done. The thing that most helps me keep from being that person is remembering that we are all extremely busy. I don't have a single co-worker who is bored.

But someone needs to be the calm in the middle of the storm. Someone needs to be the person who reassures the team that everything is going to be okay, that we'll find a way to get things done within the parameters dictated by reality and the number of business hours in a day (because that's the truth, and we have to).

Be *that* person.

What this passage of the *Tao Te Ching* says to me is that the person who's always talking about what she or he is doing has *no time to actually do those things*. If you can make your job seem effortless to those around you, then you're doing your job right.

## Be a culture coach

When a superior man hears of the Tao,

he immediately begins to embody it.

When an average man hears of the Tao,

he half believes it, half doubts it.

When a foolish man hears of the Tao,

he laughs out loud.

If he didn't laugh,

it wouldn't be the Tao. [[41]]

Last fall, I enrolled an MBA business ethics class with a bunch of federal employees. When I started describing my company's culture, values, and ethics framework, I got the direct impression that both my classmates and my professor thought I was a naive young lady with [a lot of lovely daydreams](https://opensource.com/open-organization/15/9/reflections-open-organization-starry-eyed-dreamer) about how companies should run. They told me things couldn't possibly be as they seemed. They said I should investigate further.

So I did.

And here's what I found: Things are *exactly* as they seem.

In open organizations, culture *matters*. Maintaining that culture as an organization grows makes it possible to wake up and look forward to going to work in the morning. I (and other members of open organizations) don't want to "work to live," as my classmates described it. I need to feel a passion and purpose, to understand how the work I do on a daily basis directly contributes to something I believe in.

As a project manager, you might think that your job has nothing to do with cultivating your company's culture on your team. However, it's your job to embody it.

## Kaizen

In pursuit of knowledge,

every day something is added.

In the practice of the Tao,

every day something is dropped.

Less and less do you need to force things,

until finally you arrive at non-action. When nothing is done,

nothing is left undone. [[48]]

The general field of project management is too focused on the latest and greatest tools. But the answer to the question of which tool you should use is always the same: "the simplest."

For example, I keep my running to-do list in a text file on my desktop because it serves its purpose without unnecessary distractions. Whatever tools, processes, and procedures you introduce to a team should increase efficiency and remove obstacles, not introduce additional complexity. So instead of focusing on the tools, focus on the *problem(s)* you're using those tools to solve.

My favorite part of being a project manager in an Agile world is having the freedom to throw out what doesn't work. This is related to the concept of [kaizen](https://www.kaizen.com/about-us/definition-of-kaizen.html), or "continuous improvement." Don't be afraid to try and fail. Failing is the label we've put on the process of learning what works and what doesn't. But it's the only way to improve.

The best processes arise organically. As a project manager, you can help your team by supporting them and not trying to force them into anything.

## Practice

Some say that my teaching is nonsense.

Others call it lofty but impractical.

But to those who have looked inside themselves,

this nonsense makes perfect sense.

And to those who put it into practice,

this loftiness has roots that go deep. [[67]]

I believe in what open organizations are doing. What open organizations are doing for the field of management is almost as important as the actual products and services they offer. We have an opportunity to lead by example, to inspire passion and purpose in others, to create working environments that inspire and empower.

I encourage you to find ways to incorporate some of these ideas into your own projects and teams to see what happens. Learn about your organization's mission and how your projects contribute to it. Have courage, expect to try some things that won't work, and don't forget to share the lessons you learn with our community so we can continue to improve.

## 3 Comments |

7,397 | Ubuntu 的 snap 软件包封装真的安全吗? | http://itsfoss.com/snap-package-securrity-issue/ | 2016-05-28T09:44:00 | [

"snap"

] | https://linux.cn/article-7397-1.html | 最近发布的 [Ubuntu 16.04 LTS 版本带来了一些新功能](http://itsfoss.com/features-ubuntu-1604/),其中之一就是对 [ZFS 格式文件系统的支持](http://itsfoss.com/oracle-canonical-lawsuit/)。另一个值得广为讨论的特性就是 Snap 软件包格式。不过,据 [CoreOS](https://en.wikipedia.org/wiki/CoreOS) 的开发者之一所述,Snap 软件包并不像声称的那样安全。

### 什么是 Snap 软件包?

Snap 软件包的灵感来自容器。这种新的封装格式允许[开发人员为运行于 Ubuntu 长期支持版本 (LTS)之上的应用程序发布更新](https://insights.ubuntu.com/2016/04/13/snaps-for-classic-ubuntu/)。这就可以让用户虽然运行着稳定版本的操作系统,但却能够让应用程序保持最新的状态。之所以能够这样,是因为软件包本身就包含了程序运行的所有依赖。这可以防止依赖的软件更新后软件挂掉。

snap 软件包的另外一个优势是应用与系统的其它部分是隔离的。这意味着如果你改变了 snap 软件包的一些东西,它不会影响到系统的其它部分。这也可以防止其它的应用访问你的隐私信息,从而使骇客根据难以获取你的数据。

### 然而……

据 [Matthew Garrett](https://mjg59.dreamwidth.org/l) 的说法,Snap 软件包不能完全兑现上述承诺。Garret 作为 Linux 内核的开发人员和 CoreOS 的安全性方面的开发者,我想他一定知道自己在说些什么。

[据 Garret 说](https://mjg59.dreamwidth.org/42320.html), “仅需要克服一点点困难,安装的任何 Snap 格式的软件包就完全能够将你所有的私有数据复制到任何地方”。

[ZDnet](http://www.zdnet.com/article/linux-expert-matthew-garrett-ubuntu-16-04s-new-snap-format-is-a-security-risk/) 的报道:

>

> “为了证明自己的观点,他在 Snap 中构建了一个仅用于验证其原理的用于破坏的软件包,它首先会显示一个可爱的泰迪熊,然后将会记录 Firefox 的键盘按键事件,并且能够窃取 SSH 私钥。这个仅用于验证原理的软件包实际上注入的是一个无害的命令,但是却能够修改成一个窃取 SSH 密钥的 cURL 会话。”

>

>

>

### 但是稍等……

难道 Snap 真的有安全缺陷?事实上却不是!

Garret 自己也说,此问题仅出现在使用 X11 窗口系统上,而对于那些使用 Mir 的移动设备无效。所以这个缺陷是 X11 的而不是 Snap 的。

>

> X11 是如何信任应用程序的,这是一个众所周知的安全风险。Snap 并没有更改 X11 的信任模型。所以一个应用程序能够看到其它应用程序的行为并不是这种新的封装格式的缺点,而是 X11 的。

>

>

>

Garrett 实际上想表达的只是,当 Canonical 歌颂 Snap 和它的安全性时,Snap 应用程序并不是完全沙盒化的。和其他二进制文件一样,它们也存在风险。

请牢记 Ubuntu 16.04 当前还在使用 X11 而不是 Mir 的事实,从未知的源下载和安装 Snap 格式的软件包也许还是有风险的,然而其它不也是如此嘛?!

相关链接: [如何在 Ubuntu 16.04 中使用 Snap 软件包](http://itsfoss.com/use-snap-packages-ubuntu-16-04/)。期待您分享关于 Snap 格式及其安全性的观点。

---

via: <http://itsfoss.com/snap-package-securrity-issue/>

作者:[John Paul](http://itsfoss.com/author/john/) 译者:[dongfengweixiao](https://github.com/dongfengweixiao) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,399 | Intel 展示了可在大屏幕显示 Linux 系统的低端 Android 手机 | http://www.theregister.co.uk/2016/02/23/move_over_continuum_intel_shows_android_smartphone_powering_bigscreen_linux/ | 2016-05-28T09:25:00 | [

"手机",

"android"

] | https://linux.cn/article-7399-1.html |

在世界移动大会 **MWC16** 上 Intel 展示了称之为“大屏体验”的一款的 Android 智能手机,它在插入一个外部显示后运行了一个完整的 Linux 桌面。

这个概念大体上与微软在 Windows 10 手机中的 Continuum 相似,但是 Continuum 面向的是高端设备,Intel 的项目面向的是低端智能机和新兴市场。

在巴塞罗那的这场大会上展示的是拥有 Atom x3、2GB RAM 和 16GB 存储以及支持外部显示的的 SoFIA(Intel 架构的智能或功能手机)智能机原型。插上键盘、鼠标和显示,它就变成了一台桌面 Linux,并可以选择在大屏幕的一个窗口中显示 Android 桌面。

Intel 的拓荒小组(Path Finding Group)经理 Nir Metzer 告诉我们:“Android 基于 Linux 内核,因此我们运行在一个内核上,我们有一个 Android 栈和一个 Linux 栈,并且我们共享同一个环境,因此文件系统是相同的。电话是全功能的。”

Metzer 说:“我有一个多窗口环境。只要我插入显示器后就可以使用电子表格,我可以进行拖放操作,播放音频。在一个低端平台实现这一切是一个挑战。”

现在当连上外部显示器时设备的屏幕显示是空白的,但是 Metzer 说下个版本的 Atom X3 会支持双显示。

其使用的 Linux 版本是由 Intel 维护的。Metzer 说:“我们需要将 Linux 和 Android 保持一致。框架是预安装的,不是一个可以下载的应用。”

英特尔在移动世界大会上向手机制造商们推销这一想法,但却没有实际说希望购买该设备的消费者。Metzer 说:“芯片已经准备好了,已经为量产准备好了。明天就可以进入生产。但是这要看商业需求。”

---

via: <http://www.theregister.co.uk/2016/02/23/move_over_continuum_intel_shows_android_smartphone_powering_bigscreen_linux/>

作者:[Tim Anderson](http://www.theregister.co.uk/Author/2878) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

7,400 | 推荐五篇 OpenStack 的新指南 | https://opensource.com/business/16/4/master-openstack-new-tutorials | 2016-05-29T09:37:00 | [

"OpenStack"

] | /article-7400-1.html |

回顾这周的 OpenStack 峰会,我仍然回味着开源云生态系统的浩瀚无垠,有那么多需要了解的项目及概念才能获得成功。不过我们很幸运,因为有许多资源让我们跟随着项目的脚步。除了[官方文档](http://docs.openstack.org/)外,我们还有许多来自第三方提供的培训和认证、个人分享,以及许多社区贡献的学习资源。

为了让我们保持获得最新消息,每个月我们将会整合发布 OpenStack 社区的最新教程、指导和小贴士等。下面是我们过去几个月最棒的发布分享。

* 首先,如果你正在寻找一个靠谱实惠的 OpenStack 测试实验室, Intel NUC 是最值得考虑的平台。麻雀虽小,五脏俱全,通过指导文章,可以很轻松的按照教程在 NUC 上使用 [TripleO 部署 OpenStack](http://acksyn.org/posts/2016/03/tripleo-on-nucs/) ,并且还可以轻松避开一些常见的古怪问题。

* 当你已经运行的一段时间 OpenStack 后,你会发现在你的云系统上许多组件生成了大量日志。其中一些是可以安全删除的,而你需要一个管理这些日志的方案。参考在部署生产 9 个月后使用 Celiometer 管理日志的[一些思考](http://silverskysoft.com/open-stack-xwrpr/2016/03/long-term-openstack-usage-summary/)。

* 对于 OpenStack 基础设施项目的新手,想要提交补丁到 OpenStack 是相当困难的。入口在哪里,测试怎么做,我的提交步骤是怎么样的?可以通过 Arie Bregman 的这篇[博客文章](http://abregman.com/2016/03/05/openstack-infra-jenkins-jobs/)快速了解整个提交过程。

* 突发计算节点失效,不知道是硬件还是软件问题。不过好消息是 OpenStack 提供了一套非常简单的迁移计划可以让你迁移当机节点到别的主机。然而,迁移过程中使用的命令令许多人感到困惑。可以通过[这篇文章](http://www.danplanet.com/blog/2016/03/03/evacuate-in-nova-one-command-to-confuse-us-all/)来理解 migrate 和 evacuate 命令的不同。

* 网络功能虚拟化技术需要 OpenStack 之外的一些功能,而用户可能不熟悉它们。例如, SR-IOV 和 PCI 直通是最大限度地提高物理硬件性能的方式。可以学习[部署步骤](https://trickycloud.wordpress.com/2016/03/28/openstack-for-nfv-applications-sr-iov-and-pci-passthrough/)以使 OpenStack 的性能最大化。

这些文章基本涵盖了本月(译者注: 4 月)推送,如果你还需要更多文章,可以检索过去推送的 [OpenStack 文献](https://opensource.com/resources/openstack-tutorials)来获取更多资源。如果有你认为我们应该推荐的新教程,请在评论中告诉我们,谢谢。

---

via: <https://opensource.com/business/16/4/master-openstack-new-tutorials>

作者:[Jason Baker](https://opensource.com/users/jason-baker) 译者:[VicYu/Vic020](http://vicyu.net) 校对:[PurlingNayuki](https://github.com/PurlingNayuki)