id

int64 2.05k

16.6k

| title

stringlengths 5

75

| fromurl

stringlengths 19

185

| date

timestamp[s] | tags

sequencelengths 0

11

| permalink

stringlengths 20

37

| content

stringlengths 342

82.2k

| fromurl_status

int64 200

526

⌀ | status_msg

stringclasses 339

values | from_content

stringlengths 0

229k

⌀ |

|---|---|---|---|---|---|---|---|---|---|

8,034 | 监控微服务的五原则 | http://thenewstack.io/five-principles-monitoring-microservices/ | 2016-12-14T08:34:00 | [

"微服务",

"监控"

] | https://linux.cn/article-8034-1.html |

我们对微服务的需求可以归纳为一个词:速度。这种更快提供功能完善且可靠的软件的需求,彻底改变了软件开发模式。毫无疑问,这个改变对软件管理,包括系统监控的方式,都产生了影响。在这篇文章里,我们将重点关注放在有效地监控产品环境中的微服务所需做出的主要改变。我们将为这一新的软件架构拟定 5 条指导性原则来调整你的监控方法。

监控是微服务控制系统的关键部分,你的软件越复杂,那么你就越难了解其性能及问题排障。鉴于软件交付发生的巨大改变,监控系统同样需要进行彻底的改造,以便在微服务环境下表现更好。下面我们将介绍监控微服务的 5 条原则,如下:

1. 监控容器及其里面的东西。

2. 在服务性能上做监控,而不是容器性能。

3. 监控弹性和多地部署的服务。

4. 监控 API。

5. 将您的监控映射到您的组织结构。

利用这 5 条原则,你可以在向微服务前进的道路上,建立更有效的对微服务的监控。这些原则,可以让你应对随着微服务而来的技术变化和组织变化。

### 微服务监控的原则

#### 1、监控容器及其里面的东西

容器因构建微服务而凸显其重要性,容器的速度、可移植性和隔离特性让开发者很容易就爱上了微服务模型。容器的好处已经写的够多了,毋庸赘述。

容器对于其外围的系统来说就像是黑盒子。这对于开发来说大有裨益,从开发环境到生产环境,甚至从开发者的笔记本到云端,为它们带来高度的可移植性。但是当运行起来后,监控和解决服务问题时,这个黑盒子让常规的方法难以奏效了,我们会想:容器里到底在运行着什么?程序和代码运行性能如何?它有什么重要的输出指标吗?从 DevOps 的视角,你需要对容器有更深的了解而不是仅仅知道有一些容器的存在。

非容器环境下衡量的典型做法,是让一个代理程序运行在主机或者虚机上的用户空间里,但这并不适用于容器。因为容器的优点是小,将各种进程分离开来,并尽可能的减少依赖关系。

而且,从规模上看,成千上万的监测代理,对即使是一个中等大小的部署都是一个昂贵的资源浪费和管理的噩梦。对于容器有两个潜在的解决方案:1)要求你的开发人员直接监控他们的代码,或者2)利用一个通用的内核级的检测方法来查看主机上的所有应用程序和容器活动。这里我们不会深入说明,但每一种方法都有其优点和缺点。

#### 2、 利用业务流程系统提醒服务性能

理解容器容器中的运行数据并不容易,一个单一容器相比组成一个功能或服务的容器聚合,测量复杂度要低得多。

这特别适用于应用程序级别的信息,比如哪个请求拥有最短响应时间,或者哪些 URL 遇到最多的错误,但它同样也适用于架构级别的监测,比如哪个服务的容器使用 CPU 资源超过了事先分配的资源数。

越来越多的软件部署需要一个<ruby> 编排系统 <rt> orchestration system </rt></ruby>,将应用程序的逻辑规划转化到物理的容器中。常见的编排系统包括 Kubernetes、Mesosphere DC/OS 和 Docker Swarm。团队可以用一个编排系统来(1)定义微服务(2)理解部署的每个服务的当前状态。你可以认为编排系统甚至比容器还重要。容器是短暂的,只有满足你的服务需求才会存在。

DevOps 团队应该将告警重点放到运行特征上,以尽可能贴近监控服务的体验。如果应用受到了影响,这些告警是评估事态的第一道防线。但是获得这些告警并不容易,除非你的监控系统是基于原生于容器的。

<ruby> <a href="https://techcrunch.com/2016/04/27/lets-define-container-native/"> 原生容器 </a> <rt> Container-native </rt></ruby>解决方案利用<ruby> 编排元数据 <rt> orchestration metadata </rt></ruby>来动态聚合容器和应用程序数据,并按每个服务计算监控度量。根据您的编排工具,您可能想在不同层次进行深入检测。比如,在 Kubernetes 里,你通常有 Namespace、ReplicaSet、Pod 和一些其他容器。聚合这些不同的层,对排除逻辑故障是很有必要的,与构成服务的容器的物理部署无关。

#### 3、 监控<ruby> 弹性 <rt> Elastic </rt></ruby>和<ruby> 多地部署 <rt> Multi-Location </rt></ruby>的服务

弹性服务不是一个新概念,但是它在原生容器环境中的变化速度比在虚拟环境中快的多。迅速的变化会严重影响检测系统的正常运行。

监测传统的系统经常需要根据软件部署,手动调整检查指标。这种调整可以是具体的,如定义要捕获的单个指标,或基于应用程序在一个特定的容器中的操作配置要收集的数据。在小规模上(比如几十个容器)我们可以接受,但是再大规模就难以承受了。微服务的集中监控必须能够自由的随弹性服务而增长和缩减,无需人工干预。

比如,如果 DevOps 团队必须手动定义容器包含哪个服务需要监控,他们毫无疑问会失手,因为 Kubernetes 或者 Mesos 每天都会定期创建新的容器。同样,如果代码发布并置于生产环境时要求运维团队安装一个<ruby> 定制的状态端点 <rt> custom stats endpoint </rt></ruby>,也给开发者从 Docker 仓库获取基础镜像带来更多的挑战。

在生产环境中,建立面向跨越多个数据中心或多个云的复杂部署的监控,比如,如果你的服务跨越私有数据中心和 AWS,那么亚马逊的 AWS CloudWatch 就很难做到这一点。这就要求我们建立一个跨不同地域的监控系统,并可在动态的原生容器环境下运行。

#### 4、 监控 API

在微服务环境中,API 接口是通用的。本质上,它们是将服务暴露给其它团队的唯一组件。事实上,API 的响应和一致性可以看作是“内部 SLA”,即使还没有定义一个正式的 SLA(服务等级协议)。

因此,API 接口的监控也是必要的。API 监控可以有不同的形式,但是很显然它绝对不是简单的二进制上下检查。例如,了解像时间函数这样的最常使用的<ruby> 端点 <rt> endpoint </rt></ruby>是有价值的。这使得团队可以看到服务使用的变化,无论是由于设计变更或用户的改变。

你也可以记录服务最缓慢的端点,这些可能揭示出重大的问题,或者至少指向需要在系统中做优化的区域。

最后,跟踪系统服务响应的能力是另一个很重要的能力,它主要是开发者使用,也能帮助你了解整体用户体验,同时将信息基于底层和应用程序视角分成两大部分。

#### 5、 将您的监控映射到您的组织结构

这篇文章着重在微服务和监控上,像其他科技文章一样,这是因为很多人都关注此层面。

对于那些熟悉<ruby> <a href="https://en.wikipedia.org/wiki/Conway%27s_law"> 康威定律 </a> <rt> Conway’s law </rt></ruby>的人来说,系统的设计是基于开发团队的组织结构。创造更快,更敏捷的软件的压力推动了团队去思考重新调整他们的开发组织和管理它的规则。

所以,如果他们想从这个新的软件架构(微服务)上获益,他们的团队必须将微服务映射到团队自身中。也就是说,他们需要更小的更松散耦合的团队,可以选择自己的方向只要能够满足整个需求即可。在每一个团队中,对于开发语言的使用,bug 的提交甚至工作职责都会有更大的控制能力。

DevOps 团队对此可以启用一个监控平台:让每一个微服务团队可以有自己的警报,度量指标,和控制面板,同时也要给出整体系统的视图。

### 总结

让微服务流行起来的是快捷。开发组织要想更快的为客户提供更多的功能,然后微服务技术就来了,架构转向微服务并且容器的流行让快捷开发成为可能,所有相关的进程理所当然的搭上了这辆火车。

最后,基本的监控原则需要适应伴随微服务而来的技术和结构。越早认识到这种转变的开发团队,能更早更容易的适应微服务这一新的架构。

---

via: <http://thenewstack.io/five-principles-monitoring-microservices/>

作者:[Apurva Dave](http://thenewstack.io/author/apurvadave/) ,[Loris Degioanni](http://thenewstack.io/author/lorisdegioanni/) 译者:[jiajia9linuxer](https://github.com/jiajia9linuxer) 校对:[jasminepeng](https://github.com/jasminepeng)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,037 | 用数据科学搭建一个实时推荐引擎 | https://neo4j.com/blog/real-time-recommendation-engine-data-science/ | 2016-12-14T16:57:56 | [

"推荐",

"聚类",

"算法",

"Neo4j",

"图数据库"

] | https://linux.cn/article-8037-1.html | 编者注:本文是 2016 年 4 月 Nicole Whilte 在欧洲 [GraphConnect](http://graphconnect.com/) 时所作。这儿我们快速回顾一下她所涉及的内容:

* 图数据库推荐基础

* 社会化推荐

* 相似性推荐

* 集群推荐

今天我们将要讨论的内容是数据科学和<ruby> 图推荐 <rp> ( </rp> <rt> graph recommendations </rt> <rp> ) </rp></ruby>:

我在 [Neo4j](http://neo4j.com/product/) 任职已经两年了,但实际上我已经使用 Neo4j 和 [Cypher](http://neo4j.com/blog/why-database-query-language-matters/#cypher) 工作三年了。当我首次发现这个特别的<ruby> 图数据库 <rp> ( </rp> <rt> graph database </rt> <rp> ) </rp></ruby>的时候,我还是一个研究生,那时候我在奥斯丁的德克萨斯大学攻读关于社交网络的统计学硕士学位。

[实时推荐引擎](https://neo4j.com/use-cases/real-time-recommendation-engine/)是 Neo4j 中最广泛的用途之一,也是使它如此强大并且容易使用的原因之一。为了探索这个东西,我将通过使用示例数据集来阐述如何将统计学方法并入这些引擎中。

第一个很简单 - 将 Cypher 用于社交推荐。接下来,我们将看一看相似性推荐,这涉及到可被计算的相似性度量,最后探索的是集群推荐。

### 图数据库推荐基础

下面的数据集包含所有达拉斯 Fort Worth 国际机场的餐饮场所,达拉斯 Fort Worth 国际机场是美国主要的机场枢纽之一:

我们把节点标记成黄色并按照出入口和航站楼给它们的位置建模。同时我们也按照食物和饮料的主类别将地点分类,其中一些包括墨西哥食物、三明治、酒吧和烤肉。

让我们做一个简单的推荐。我们想要在机场的某一确定地点找到一种特定食物,大括号中的内容表示是的用户输入,它将进入我们的假想应用程序中。

这个英文句子表示成 Cypher 查询:

这将提取出该类别中用户所请求的所有地点、航站楼和出入口。然后我们可以计算出用户所在位置到出入口的准确距离,并以升序返回结果。再次说明,这个非常简单的 Cypher 推荐仅仅依据的是用户在机场中的位置。

### <ruby> 社交推荐 <rp> ( </rp> <rt> Social Recommendations </rt> <rp> ) </rp></ruby>

让我们来看一下社交推荐。在我们的假想应用程序中,用户可以登录并且可以用和 Facebook 类似的方式标记自己“喜好”的地点,也可以在某地签到。

考虑位于我们所研究的第一个模型之上的数据模型,现在让我们在下面的分类中找到用户的朋友喜好的航站楼里面离出入口最近的餐饮场所:

`MATCH` 子句和我们第一次 Cypher 查询的 `MATCH` 子句相似,只是现在我们依据喜好和朋友来匹配:

前三行是完全一样的,但是现在要考虑的是那些登录的用户,我们想要通过 `:FRIENDS_WITH` 这一关系来找到他们的朋友。仅需通过在 Cypher 中增加一些行内容,我们现在已经把社交层面考虑到了我们的推荐引擎中。

再次说明,我们仅仅显示了用户明确请求的类别,并且这些类别中的地点与用户进入的地方是相同的航站楼。当然,我们希望按照登录并做出请求的用户来滤过这些目录,然后返回地点的名字、位置以及所在目录。我们也要显示出有多少朋友已经“喜好”那个地点以及那个地点到出入口的确切距离,然后在 `RETURN` 子句中同时返回所有这些内容。

### <ruby> 相似性推荐 <rp> ( </rp> <rt> Similarity Recommendations </rt> <rp> ) </rp></ruby>

现在,让我们看一看相似性推荐引擎:

和前面的数据模型相似,用户可以标记“喜好”的地点,但是这一次他们可以用 1 到 10 的整数给地点评分。这是通过前期在 Neo4j 中增加一些属性到关系中建模实现的。

这将允许我们找到其他相似的用户,比如以上面的 Greta 和 Alice 为例,我们已经查询了他们共同喜好的地点,并且对于每一个地点,我们可以看到他们所设定的权重。大概地,我们可以通过他们的评分来确定他们之间的相似性大小。

现在我们有两个向量:

现在让我们按照<ruby> 欧几里得距离 <rp> ( </rp> <rt> Euclidean distance </rt> <rp> ) </rp></ruby>的定义来计算这两个向量之间的距离:

我们把所有的数字带入公式中计算,然后得到下面的相似度,这就是两个用户之间的“距离”:

你可以很容易地在 Cypher 中计算两个特定用户的“距离”,特别是如果他们仅仅同时“喜好”一个很小的地点子集。再次说明,这儿我们依据两个用户 Alice 和 Greta 来进行匹配,并尝试去找到他们同时“喜好”的地点:

他们都有对最后找到的地点的 `:LIKES` 关系,然后我们可以在 Cypher 中很容易的计算出他们之间的欧几里得距离,计算方法为他们对各个地点评分差的平方求和再开平方根。

在两个特定用户的例子中上面这个方法或许能够工作。但是,在实时情况下,当你想要通过和实时数据库中的其他用户比较,从而由一架飞机上的一个用户推断相似用户时,这个方法就不一定能够工作。不用说,至少它不能够很好的工作。

为了找到解决这个问题的好方法,我们可以预先计算好距离并存入实际关系中:

当遇到一个很大的数据集时,我们需要成批处理这件事,在这个很小的示例数据集中,我们可以按照所有用户的<ruby> 迪卡尔乘积 <rp> ( </rp> <rt> Cartesian product </rt> <rp> ) </rp></ruby>和他们共同“喜好”的地点来进行匹配。当我们使用 `WHERE id(u1) < id(u2)` 作为 Cypher 询问的一部分时,它只是来确定我们在左边和右边没有找到相同的对的一个技巧。

通过用户之间的欧几里得距离,我们创建了他们之间的一种关系,叫做 `:DISTANCE`,并且设置了一个叫做 `euclidean` 的欧几里得属性。理论上,我们可以也通过用户间的一些关系来存储其他相似度从而获取不同的相似度,因为在确定的环境下某些相似度可能比其他相似度更有用。

在 Neo4j 中,的确是对关系属性建模的能力使得完成像这样的事情无比简单。然而,实际上,你不会希望存储每一个可能存在的单一关系,因为你仅仅希望返回离他们“最近”的一些人。

因此你可以根据一些临界值来存入前几个,从而你不需要构建完整的连通图。这允许你完成一些像下面这样的实时的数据库查询,因为我们已经预先计算好了“距离”并存储在了关系中,在 Cypher 中,我们能够很快的攫取出数据。

在这个查询中,我们依据地点和类别来进行匹配:

再次说明,前三行是相同的,除了登录用户以外,我们找出了和他们有 `:DISTANCE` 关系的用户。这是我们前面查看的关系产生的作用 - 实际上,你只需要存储处于前几位的相似用户 `:DISTANCE` 关系,因此你不需要在 `MATCH` 子句中攫取大量用户。相反,我们只攫取和那些用户“喜好”的地方有 `:DISTANCE` 关系的用户。

这允许我们用少许几行内容表达较为复杂的模型。我们也可以攫取 `:LIKES` 关系并把它放入到变量中,因为后面我们将使用这些权重来评分。

在这儿重要的是,我们可以依据“距离”大小将用户按照升序进行排序,因为这是一个距离测度。同时,我们想要找到用户间的最小距离因为距离越小表明他们的相似度最大。

通过其他按照欧几里得距离大小排序好的用户,我们得到用户评分最高的三个地点并按照用户的平均评分高低来推荐这些地点。换句话说,我们先找出一个活跃用户,然后依据其他用户“喜好”的地点找出和他最相似的其他用户,接下来按照这些相似用户的平均评分把那些地点排序在结果的集合中。

本质上,我们通过把所有评分相加然后除以收集的用户数目来计算出平均分,然后按照平均评分的升序进行排序。其次,我们按照出入口距离排序。假想地,我猜测应该会有交接点,因此你可以按照出入口距离排序然后再返回名字、类别、出入口和航站楼。

### <ruby> 集群推荐 <rp> ( </rp> <rt> Cluster Recommendations </rt> <rp> ) </rp></ruby>

我们最后要讲的一个例子是集群推荐,在 Cypher 中,这可以被想像成一个作为临时解决方案的离线计算工作流。这可能完全基于在[欧洲 GraphConnect 上宣布的新方法](https://neo4j.com/blog/neo4j-3-0-massive-scale-developer-productivity/),但是有时你必须进行一些 Cypher 2.3 版本所没有的算法逼近。

在这儿你可以使用一些统计软件,把数据从 Neo4j 取出然后放入像 Apache Spark、R 或者 Python 这样的软件中。下面是一段把数据从 Neo4j 中取出的 R 代码,运行该程序,如果正确,写下程序返回结果的给 Neo4j,可以是一个属性、节点、关系或者一个新的标签。

通过持续把程序运行结果放入到图表中,你可以在一个和我们刚刚看到的查询相似的实时查询中使用它:

下面是用 R 来完成这件事的一些示例代码,但是你可以使用任何你最喜欢的软件来做这件事,比如 Python 或 Spark。你需要做的只是登录并连接到图表。

在下面的例子中,我基于用户的相似性把他们聚合起来。每个用户作为一个观察点,然后得到他们对每一个目录评分的平均值。

假定用户对酒吧类评分的方式和一般的评分方式相似。然后我攫取出喜欢相同类别中的地点的用户名、类别名、“喜好”关系的平均权重,比如平均权重这些信息,从而我可以得到下面这样一个表格:

因为我们把每一个用户都作为一个观察点,所以我们必须巧妙的处理每一个类别中的数据,这些数据的每一个特性都是用户对该类中餐厅评分的平均权重。接下来,我们将使用这些数据来确定用户的相似性,然后我将使用<ruby> 聚类 <rp> ( </rp> <rt> clustering </rt> <rp> ) </rp></ruby>算法来确定在不同集群中的用户。

在 R 中这很直接:

在这个示例中我们使用<ruby> K-均值 <rp> ( </rp> <rt> k-means </rt> <rp> ) </rp></ruby>聚类算法,这将使你很容易攫取集群分配。总之,我通过运行聚类算法然后分别得到每一个用户的集群分配。

Bob 和 David 在一个相同的集群中 - 他们在集群二中 - 现在我可以实时查看哪些用户被放在了相同的集群中。

接下来我把集群分配写入 CSV 文件中,然后存入图数据库:

我们只有用户和集群分配,因此 CSV 文件只有两列。 `LOAD CSV` 是 Cypher 中的内建语法,它允许你从一些其他文件路径或者 URL 调用 CSV ,并给它一个别名。接下来,我们将匹配图数据库中存在的用户,从 CSV 文件中攫取用户列然后合并到集群中。

我们在图表中创建了一个新的标签节点:`Cluster ID`, 这是由 K-平均聚类算法给出的。接下来我们创建用户和集群间的关系,通过创建这个关系,当我们想要找到在相同集群中的实际推荐用户时,就会很容易进行查询。

我们现在有了一个新的集群标签,在相同集群中的用户和那个集群存在关系。新的数据模型看起来像下面这样,它比我们前面探索的其他数据模型要更好:

现在让我们考虑下面的查询:

通过这个 Cypher 查询,我们在更远处找到了在同一个集群中的相似用户。由于这个原因,我们删除了“距离”关系:

在这个查询中,我们取出已经登录的用户,根据用户-集群关系找到他们所在的集群,找到他们附近和他们在相同集群中的用户。

我们把这些用户分配到变量 `c1` 中,然后我们得到其他被我取别名为 `neighbor` 变量的用户,这些用户和那个相同集群存在着用户-集群关系,最后我们得到这些附近用户“喜好”的地点。再次说明,我把“喜好”放入了变量 r 中,因为我们需要从关系中攫取权重来对结果进行排序。

在这个查询中,我们所做的改变是,不使用相似性距离,而是攫取在相同集群中的用户,然后对类别、航站楼以及我们所攫取的登录用户进行声明。我们收集所有的权重:来自附近用户“喜好”地点的“喜好”关系,得到的类别,确定的距离值,然后把它们按升序进行排序并返回结果。

在这些例子中,我们可以进行一个相当复杂的处理并且将其放到图数据库中,然后我们就可以使用实时算法结果-聚类算法和集群分配的结果。

我们更喜欢的工作流程是更新这些集群分配,更新频率适合你自己就可以,比如每晚一次或每小时一次。当然,你可以根据直觉来决定多久更新一次这些集群分配是可接受的。

---

via: <https://neo4j.com/blog/real-time-recommendation-engine-data-science/>

作者:[Nicole White](https://neo4j.com/blog/contributor/nicole-white/) 译者:[ucasFL](https://github.com/ucasFL) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | *Editor’s Note: This presentation was given by Nicole White at*– What we’re going to be talking about today is data science and graph recommendations:

[GraphConnect Europe](https://graphconnect.com/)in April 2016. Here’s a quick review of what she covered:I’ve been with

[Neo4j](https://neo4j.com/product/)for two years now, but have been working with Neo4j and

[Cypher](https://neo4j.com/blog/why-database-query-language-matters/#cypher)for three. I discovered this particular graph database when I was a grad student at the University of Texas Austin studying for a masters in statistics with a focus on social networks.

[Real-time recommendation engines](https://neo4j.com/use-cases/real-time-recommendation-engine/)are one of the most common use cases for Neo4j, and one of the things that makes it so powerful and easy to use. To explore this, I’ll explain how to incorporate statistical methods into these recommendations by using example datasets.

The first will be simple – entirely in Cypher with a focus on social recommendations. Next we’ll look at the similarity recommendation, which involves similarity metrics that can be calculated, and finally a clustering recommendation.

### Basic Graph-Powered Recommendations

The following dataset includes food and drink places in the Dallas Fort Worth International Airport, one of the major airport hubs in the United States:

We have place nodes in yellow and are modeling their location in terms of gate and terminal. And we are also categorizing the place in terms of major categories for food and drink. Some include Mexican food, sandwiches, bars and barbecue.

Let’s do a simple recommendation. We want to find a specific type of food in a certain location in the airport, and the curled brackets represent user inputs which are being entered into our hypothetical app:

This English sentence maps really well as a Cypher query:

This is going to pull all the places in the category, terminal and gate the user has requested. Then we get the absolute distance of the place to gate where the user is, and return the results in ascending order. Again, a very simple Cypher recommendation to a user based just on their location in the airport.

### Social Recommendations

Let’s look at a social recommendation. In our hypothetical app, we have users who can log in and “like” places in a way similar to Facebook and can also check into places:

Consider this data model on top of the first model that we explored, and now let’s find food and drink places in the following categories closest to some gate in whatever terminal that user’s friends like:

The

`MATCH`

clause is very similar to the `MATCH`

clause of our first Cypher query, except now we are matching on likes and friends:The first three lines are the same, but for the user in question – the user that’s “logged in” – we want to find their friends through the

`:FRIENDS_WITH`

relationship along with the places those friends liked. With just a few added lines of Cypher, we are now taking a social aspect into account for our recommendation engine.Again, we’re only showing categories that the user explicitly asked for that are in the same terminals the user is in. And, of course, we want to filter this by the user who is logged in and making this request, and it returns the name of the place along with its location and category. We are also accounting for how many friends have liked that place and the absolute value of the distance of the place from the gate, all returned in the

`RETURN`

clause.### Similarity Recommendation

Now let’s take a look at a similarity recommendation engine:

Similarly to our earlier data model, we have users who can like places, but this time they can also rate places with an integer between one and 10. This is easily modeled in Neo4j by adding a property to the relationship.

This allows us to find other similar users, like in the example of Greta and Alice. We’ve queried the places they’ve mutually liked, and for each of those places, we can see the weights they have assigned. Presumably, we can use these numbers to determine how similar they are to each other:

Now we have two vectors:

And now let’s apply Euclidean distance to find the distance between those two vectors:

And when we plug in all the numbers, we get the following similarity metric, which is really the distance metric between the two users:

You can do this between two specific users easily in Cypher, especially if they’ve only mutually liked a small subset of places. Again, here we’re matching on two users, Alice and Greta, and are trying to find places they’ve mutually liked:

They both have to have a

`:LIKES`

relationship to the place for it to be found in this result, and then we can easily calculate the Euclidean distance between them with the square root of the sum of their squared differences in Cypher.While this may work in an example with two specific people, it doesn’t necessarily work in real time when you’re trying to infer similar users from another user on the fly, by comparing them against every other user in the database in real time. Needless to say, this doesn’t work very well.

To find a way around this, we pre-compute this calculation and store it in an actual relationship:

While in large datasets we would do this in batches, in this small example dataset, we can match on a Cartesian product of all the users and places they’ve mutually liked. When we use

`WHERE id(u1) < id(u2)`

as part of our Cypher query, this is just a trick to ensure we’re not finding the same pair twice on both the left and the right.Then with their Euclidean distance and themselves, we’re going to create a relationship between them called

`:DISTANCE`

and set a Euclidean property called `euclidean`

. In theory, we could also store other similarity metrics on some relationship between users to capture different similarity metrics, since some might be more useful than others in certain contexts.And it’s really this ability to model properties on relationships in Neo4j that makes things like this incredibly easy. However, in practice you don’t want to store every single relationship that can possibly exist because you’ll only want to return the top few people of their neighbors.

So you can just store the top in according to some threshold so you don’t have this fully connected graph. This allows you to perform

[graph database](https://neo4j.com/blog/why-graph-databases-are-the-future/#definition)queries like the below in real time, because we’ve pre-computed it and stored it on the relationship, and in Cypher we’ll be able to grab that very quickly:

In this query, we’re matching on places and categories:

Again, the first three lines are the same, except that for the logged-in user, we’re getting users who have a

`:DISTANCE`

relationship to them. This is where what we went over earlier comes into play – in practice you should only store the top `:DISTANCE`

relationships to users who are similar to them so you’re not grabbing a huge volume of users in this `MATCH`

clause. Instead, we’re grabbing users who have a `:DISTANCE`

relationship to them where those users like that place.This has allowed us to express a somewhat complicated pattern in just a few lines. We’re also grabbing the

`:LIKES`

relationship and putting it on a variable because we’re going to use those weights later to apply a rating.What’s important here is that we’re ordering those users by their distance ascending, because it is a distance metric, and we want the lowest distances because that indicates they are the most similar.

With those other users ordered by the Euclidean distance, we’re going to collect the top three users’ ratings and use those as our average score to recommend these places. In other words, we’ve taken an active user, found users who are most similar to them based on the places they’ve liked, and then averaged the scores those similar users have given to rank those places in a result set.

We’re essentially taking an average here by adding it up and dividing by the number of elements in the collection, and we’re ordering by that average ascending. Then secondarily, we’re ordering by the gate distance. Hypothetically, there could be ties I suppose, and then you order by the gate distance and then returning the name, category, gate and terminal.

### Cluster Recommendations

Our final example is going to be a cluster recommendation, which can be thought of as a workflow of offline computing that may be required as a workaround in Cypher. This may now be obsolete based on

[the new procedures announced at GraphConnect Europe](https://neo4j.com/blog/neo4j-3-0-massive-scale-developer-productivity/), but sometimes you have to do certain algorithmic approaches that Cypher version 2.3 doesn’t expose.

This is where you can use some form of statistical software, pull data out of Neo4j into a software such as Apache Spark, R or Python. Below is an example of R code for pulling data out of Neo4j, running an algorithm, and then – if appropriate – writing the results of that algorithm back into Neo4j as either a property, node, relationship or a new label.

By persisting the results of that algorithm into the graph, you can use it in real-time with queries similar to the ones we just went over:

Below is some example code for how you do this in R, but you can easily do the same thing with whatever software you’re most comfortable with, such as Python or Spark. All you have to do is log in and connect to the graph.

In the following example, I’ve clustered users together based on their similarities. Each user is represented as an observation, and I want to get the average rating that they’ve given each category:

Presumably, users who rate the bar category in similar ways are similar in general. Here I’m grabbing the names of users who like places in the same category, the category name, and the average weight of the “likes” relationships, as average weight, and that’s going to give me a table like this:

Because we want each user to be an observation, we will have to manipulate the data where each feature is the average weight rating they’ve given restaurants within that category, per category. We’ll then use this to determine how similar they are, and I’m going to use a clustering algorithm to determine users being in different clusters.

In R this is very straightforward:

For this demonstration we are using k-means, which allows you to easily grab cluster assignments. In summary, I ran a clustering algorithm and now for each user I have a cluster assignment.

Bob and David are in the same cluster – they’re in cluster two – and now I’ll be able to see in real time which users have been determined to be in the same cluster.

Next we write it into a CSV, which we then load into the graph:

We have users and cluster assignments, so the CSV will only have two columns.

`LOAD CSV`

is a syntax that’s built into Cypher that allows you to call a CSV from some file path or URL and alias it as something. Then we’ll match on the users that already exist in the graph, grab the user column out of that CSV, and merge on the cluster. Here we’re creating a new labeled node in the graph, the

`Cluster ID`

, which was given by k-means. Next we create relationships between the user and the cluster, which allows us to easily query when we get to the actual recommendation users who are in the same cluster.Now we have a new label cluster where users who are in the same cluster have a relationship to that cluster. Below is what our new data model looks like, which is on top of the other data models we explored:

Now let’s consider the following query:

With this Cypher query, we’re going beyond similar users to users in the same cluster. At this point we’ve also deleted those distance relationships:

In this query, we’ve taken the user who’s logged in, finding their cluster based on the user-cluster relationship, and finding their neighbors who are in that same cluster.

We’ve assigned that to some variable

`cl`

, and we’re getting other users – which I’ve aliased as a `neighbor`

variable – who have a user-cluster relationship to that same cluster, and then we’re getting the places that neighbor has liked. Again, we’re putting the “likes” on a variable, `r`

, because we’re going want to grab weights off of the relationship to order our results.All we’ve changed in the query is that instead of using the similarity distance, we’re grabbing users in the same cluster, asserting categories, asserting the terminal and asserting that we’re only grabbing the user who is logged in. We’re collecting all those weights of the

`:LIKES`

relationships from their neighbors liking places, getting the category, the absolute value of the distance, ordering that in descending order, and returning those results.In these examples we’ve been able to take a pretty involved process and persist it in the graph, and then used the results of that algorithm – the results of the clustering algorithm and the clustering assignments – in real time.

Our preferred workflow is to update these clustering assignments however frequently you see fit — for example, nightly or hourly. And, of course, you can use intuition to figure out how often is acceptable to be updating these cluster assignments.

**Inspired by Nicole’s talk? Click below to register for**

[GraphConnect San Francisco](https://graphconnect.com/?ref=blog)and get even more presentations, talks and workshops from the world’s leading graph technology experts.[Get My Ticket](https://graphconnect.com/?ref=blog) |

8,038 | Linux 中的 DTrace :BPF 进入 4.9 内核 | http://www.brendangregg.com/blog/2016-10-27/dtrace-for-linux-2016.html | 2016-12-15T12:22:00 | [

"性能",

"跟踪",

"DTrace",

"BPF"

] | https://linux.cn/article-8038-1.html |

>

> 本文作者 [Brendan Gregg](http://www.brendangregg.com/) 目前是 Netflix 的高级性能架构师 ,他在那里做大规模计算机性能设计、分析和调优。他是《Systems Performance》等技术书的作者,因在系统管理员方面的成绩,获得过 2013年 USENIX LISA 大奖。他之前是 SUN 公司是性能领头人和内核工程师,研究存储和网络性能。他也发明和开发过一大波性能分析工具,很多已集成到操作系统中了 。

>

>

>

随着 BPF 追踪系统(基于时间采样)最后一个主要功能被合并至 Linux 4.9-rc1 版本的内核中,现在 Linux 内核拥有类似 DTrace 的原生追踪功能。DTrace 是 Solaris 系统中的高级追踪器。对于长期使用 DTrace 的用户和专家,这将是一个振奋人心的里程碑!现在在 Linux 系统上,你可以在生产环境中使用安全的、低负载的定制追踪系统,通过执行时间的柱状图和频率统计等信息,分析应用的性能以及内核。

用于 Linux 的追踪项目有很多,但是这个最终被合并进 Linux 内核的技术从一开始就根本不是一个追踪项目:它是最开始是用于<ruby> 伯克利包过滤器 <rp> ( </rp> <rt> Berkeley Packet Filter </rt> <rp> ) </rp></ruby>(BPF)的增强功能。这些补丁允许 BPF 重定向数据包,从而创建软件定义网络(SDN)。久而久之,对事件追踪的支持就被添加进来了,使得程序追踪可用于 Linux 系统。

尽管目前 BPF 没有像 DTrace 一样的高级语言,但它所提供的前端已经足够让我创建很多 BPF 工具了,其中有些是基于我以前的 [DTraceToolkit](https://github.com/opendtrace/toolkit)。这个帖子将告诉你怎么去用这些 BPF 提供的前端工具,以及畅谈这项技术将会何去何从。

### 示例

我已经将基于 BPF 的追踪工具添加到了开源的 [bcc](https://github.com/iovisor/bcc) 项目里(感谢 PLUMgrid 公司的 Brenden Blanco 带领 bcc 项目的发展)。详见 [bcc 安装](https://github.com/iovisor/bcc/blob/master/INSTALL.md) 手册。它会在 `/usr/share/bcc/tools` 目录下添加一系列工具,包括接下来的那些工具。

捕获新进程:

```

# execsnoop

PCOMM PID RET ARGS

bash 15887 0 /usr/bin/man ls

preconv 15894 0 /usr/bin/preconv -e UTF-8

man 15896 0 /usr/bin/tbl

man 15897 0 /usr/bin/nroff -mandoc -rLL=169n -rLT=169n -Tutf8

man 15898 0 /usr/bin/pager -s

nroff 15900 0 /usr/bin/locale charmap

nroff 15901 0 /usr/bin/groff -mtty-char -Tutf8 -mandoc -rLL=169n -rLT=169n

groff 15902 0 /usr/bin/troff -mtty-char -mandoc -rLL=169n -rLT=169n -Tutf8

groff 15903 0 /usr/bin/grotty

```

硬盘 I/O 延迟的柱状图:

```

# biolatency -m

Tracing block device I/O... Hit Ctrl-C to end.

^C

msecs : count distribution

0 -> 1 : 96 |************************************ |

2 -> 3 : 25 |********* |

4 -> 7 : 29 |*********** |

8 -> 15 : 62 |*********************** |

16 -> 31 : 100 |**************************************|

32 -> 63 : 62 |*********************** |

64 -> 127 : 18 |****** |

```

追踪慢于 5 毫秒的 ext4 常见操作:

```

# ext4slower 5

Tracing ext4 operations slower than 5 ms

TIME COMM PID T BYTES OFF_KB LAT(ms) FILENAME

21:49:45 supervise 3570 W 18 0 5.48 status.new

21:49:48 supervise 12770 R 128 0 7.55 run

21:49:48 run 12770 R 497 0 16.46 nsswitch.conf

21:49:48 run 12770 R 1680 0 17.42 netflix_environment.sh

21:49:48 run 12770 R 1079 0 9.53 service_functions.sh

21:49:48 run 12772 R 128 0 17.74 svstat

21:49:48 svstat 12772 R 18 0 8.67 status

21:49:48 run 12774 R 128 0 15.76 stat

21:49:48 run 12777 R 128 0 7.89 grep

21:49:48 run 12776 R 128 0 8.25 ps

21:49:48 run 12780 R 128 0 11.07 xargs

21:49:48 ps 12776 R 832 0 12.02 libprocps.so.4.0.0

21:49:48 run 12779 R 128 0 13.21 cut

[...]

```

追踪新建的 TCP 活跃连接(`connect()`):

```

# tcpconnect

PID COMM IP SADDR DADDR DPORT

1479 telnet 4 127.0.0.1 127.0.0.1 23

1469 curl 4 10.201.219.236 54.245.105.25 80

1469 curl 4 10.201.219.236 54.67.101.145 80

1991 telnet 6 ::1 ::1 23

2015 ssh 6 fe80::2000:bff:fe82:3ac fe80::2000:bff:fe82:3ac 22

```

通过跟踪 `getaddrinfo()`/`gethostbyname()` 库的调用来追踪 DNS 延迟:

```

# gethostlatency

TIME PID COMM LATms HOST

06:10:24 28011 wget 90.00 www.iovisor.org

06:10:28 28127 wget 0.00 www.iovisor.org

06:10:41 28404 wget 9.00 www.netflix.com

06:10:48 28544 curl 35.00 www.netflix.com.au

06:11:10 29054 curl 31.00 www.plumgrid.com

06:11:16 29195 curl 3.00 www.facebook.com

06:11:25 29404 curl 72.00 foo

06:11:28 29475 curl 1.00 foo

```

按类别划分 VFS 操作的时间间隔统计:

```

# vfsstat

TIME READ/s WRITE/s CREATE/s OPEN/s FSYNC/s

18:35:32: 231 12 4 98 0

18:35:33: 274 13 4 106 0

18:35:34: 586 86 4 251 0

18:35:35: 241 15 4 99 0

```

对一个给定的 PID,通过内核和用户堆栈轨迹来追踪 CPU 处理之外的时间(由内核进行统计):

```

# offcputime -d -p 24347

Tracing off-CPU time (us) of PID 24347 by user + kernel stack... Hit Ctrl-C to end.

^C

[...]

ffffffff810a9581 finish_task_switch

ffffffff8185d385 schedule

ffffffff81085672 do_wait

ffffffff8108687b sys_wait4

ffffffff81861bf6 entry_SYSCALL_64_fastpath

--

00007f6733a6b64a waitpid

- bash (24347)

4952

ffffffff810a9581 finish_task_switch

ffffffff8185d385 schedule

ffffffff81860c48 schedule_timeout

ffffffff810c5672 wait_woken

ffffffff8150715a n_tty_read

ffffffff815010f2 tty_read

ffffffff8122cd67 __vfs_read

ffffffff8122df65 vfs_read

ffffffff8122f465 sys_read

ffffffff81861bf6 entry_SYSCALL_64_fastpath

--

00007f6733a969b0 read

- bash (24347)

1450908

```

追踪 MySQL 查询延迟(通过 USDT 探针):

```

# mysqld_qslower `pgrep -n mysqld`

Tracing MySQL server queries for PID 14371 slower than 1 ms...

TIME(s) PID MS QUERY

0.000000 18608 130.751 SELECT * FROM words WHERE word REGEXP '^bre.*n$'

2.921535 18608 130.590 SELECT * FROM words WHERE word REGEXP '^alex.*$'

4.603549 18608 24.164 SELECT COUNT(*) FROM words

9.733847 18608 130.936 SELECT count(*) AS count FROM words WHERE word REGEXP '^bre.*n$'

17.864776 18608 130.298 SELECT * FROM words WHERE word REGEXP '^bre.*n$' ORDER BY word

```

监测 pam 库并使用多种追踪工具观察登录请求:

```

# trace 'pam:pam_start "%s: %s", arg1, arg2'

TIME PID COMM FUNC -

17:49:45 5558 sshd pam_start sshd: root

17:49:47 5662 sudo pam_start sudo: root

17:49:49 5727 login pam_start login: bgregg

```

bcc 项目里的很多工具都有帮助信息(`-h` 选项),并且都应该包含有示例的 man 页面和文本文件。

### 必要性

2014 年,Linux 追踪程序就有一些内核相关的特性(来自 `ftrace` 和 `pref_events`),但是我们仍然要转储并报告进程数据,这种几十年前的老技术有很多的限制。你不能频繁地访问进程名、函数名、堆栈轨迹或内核中的任意的其它数据。你不能在将变量保存到一个监测事件里,又在另一个事件里访问它们,这意味着你不能在你需要的地方计算延迟(或者说时间增量)。你也不能创建一个内核内部的延迟柱状图,也不能追踪 USDT 探针,甚至不能写个自定义的程序。DTrace 可以做到所有这些,但仅限于 Solaris 或 BSD 系统。在 Linux 系统中,有些不在主线内核的追踪器,比如 SystemTap 就可以满足你的这些需求,但它也有自身的不足。(理论上说,你可以写一个基于探针的内核模块来满足需求-但实际上没人这么做。)

2014 年我加入了 Netflix cloud performance 团队。做了这么久的 DTrace 方面的专家,转到 Linux 对我来说简直不可思议。但我确实这么做了,而且遇到了巨大的挑战:在应用快速变化、采用微服务架构和分布式系统的情况下,调优 Netflix cloud。有时要用到系统追踪,而我之前是用的 DTrace。在 Linux 系统上可没有 DTrace,我就开始用 Linux 内核内建的 `ftrace` 和 `perf_events` 工具,构建了一个追踪工具([perf-tools](https://github.com/brendangregg/perf-tools))。这些工具很有用,但有些工作还是没法完成,尤其是延迟柱状图以及堆栈踪迹计数。我们需要的是内核追踪的可程序化。

### 发生了什么?

BPF 将程序化的功能添加到现有的内核追踪工具中(`tracepoints`、`kprobes`、`uprobes`)。在 Linux 4.x 系列的内核里,这些功能大大加强了。

时间采样是最主要的部分,它被 Linux 4.9-rc1 所采用([patchset](https://lkml.org/lkml/2016/9/1/831))。十分感谢 Alexei Starovoitov(在 Facebook 致力于 BPF 的开发),他是这些 BPF 增强功能的主要开发者。

Linux 内核现在内建有以下这些特性(自 2.6 版本到 4.9 版本之间增加):

* 内核级的动态追踪(BPF 对 `kprobes` 的支持)

* 用户级的动态追踪(BPF 对 `uprobes` 的支持)

* 内核级的静态追踪(BPF 对 `tracepoints` 的支持)

* 时间采样事件(BPF 的 `pref_event_open`)

* PMC 事件(BPF 的 `pref_event_open`)

* 过滤器(通过 BPF 程序)

* 调试输出(`bpf_trace_printk()`)

* 按事件输出(`bpf_perf_event_output()`)

* 基础变量(全局的和每个线程的变量,基于 BPF 映射)

* 关联数组(通过 BPF 映射)

* 频率计数(基于 BPF 映射)

* 柱状图(2 的冥次方、线性及自定义,基于 BPF 映射)

* 时间戳和时间增量(`bpf_ktime_get_ns()`,和 BPF 程序)

* 内核态的堆栈轨迹(BPF 栈映射)

* 用户态的堆栈轨迹 (BPF 栈映射)

* 重写 ring 缓存(`pref_event_attr.write_backward`)

我们采用的前端是 bcc,它同时提供 Python 和 lua 接口。bcc 添加了:

* 用户级静态追踪(基于 `uprobes` 的 USDT 探针)

* 调试输出(Python 中调用 `BPF.trace_pipe()` 和 `BPF.trace_fields()` 函数 )

* 按事件输出(`BPF_PERF_OUTPUT` 宏和 `BPF.open_perf_buffer()`)

* 间隔输出(`BPF.get_table()` 和 `table.clear()`)

* 打印柱状图(`table.print_log2_hist()`)

* 内核级的 C 结构体导航(bcc 重写器映射到 `bpf_probe_read()` 函数)

* 内核级的符号解析(`ksym()`、 `ksymaddr()`)

* 用户级的符号解析(`usymaddr()`)

* BPF 跟踪点支持(通过 `TRACEPOINT_PROBE`)

* BPF 堆栈轨迹支持(包括针对堆栈框架的 `walk` 方法)

* 其它各种辅助宏和方法

* 例子(位于 `/examples` 目录)

* 工具(位于 `/tools` 目录)

* 教程(`/docs/tutorial*.md`)

* 参考手册(`/docs/reference_guide.md`)

直到最新也是最主要的特性被整合进来,我才开始写这篇文章,现在它在 4.9-rc1 内核中。我们还需要去完成一些次要的东西,还有另外一些事情要做,但是现在我们所拥有的已经值得欢呼了。现在 Linux 拥有了内建的高级追踪能力。

### 安全性

设计 BPF 及其增强功能时就考虑到生产环境级安全,它被用在大范围的生产环境里。不过你想的话,你还是可以找到一个挂起内核的方法。这种情况是偶然的,而不是必然,类似的漏洞会被快速修复,尤其是当 BPF 合并入了 Linux。因为 Linux 可是公众的焦点。

在开发过程中我们碰到了一些非 BPF 的漏洞,它们需要被修复:rcu 不可重入,这可能导致内核由于 funccount 挂起,在 4.6 内核版本中这个漏洞被 “bpf: map pre-alloc” 补丁集所修复,旧版本内核的漏洞 bcc 有个临时处理方案。还有一个是 uprobe 的内存计算问题,这导致 uprobe 分配内存失败,在 4.8 内核版本这个漏洞由 “uprobes: Fix the memcg accounting” 补丁所修复,并且该补丁还将被移植到之前版本的内核中(例如,它现在被移植到了 4.4.27 和 4.4.0-45.66 版本中)。

### 为什么 Linux 追踪用了这么久才加进来?

首要任务被分到了若干追踪器中间:这些不是某个追踪器单个的事情。想要了解更多关于这个或其它方面的问题,可以看一看我在 2014 年 [tracing summit 上的讲话](http://www.slideshare.net/brendangregg/from-dtrace-to-linux)。我忽视了部分方案的反面影响:有些公司发现其它追踪器(SystemTap 和 LTTng)能满足他们的需求,尽管他们乐于听到 BPF 的开发进程,但考虑到他们现有的解决方案,帮助 BPF 的开发就不那么重要了。

BPF 仅在近两年里在追踪领域得到加强。这一过程原本可以更快的,但早期缺少全职从事于 BPF 追踪的工程师。Alexei Starovoitov (BPF 领导者),Brenden Blanco (bcc 领导者),我还有其它一些开发者,都有其它的事情要做。我在 Netflix 公司花了大量时间(志愿地),大概有 7% 的时间是花在 BPF 和 bcc 上。某种程度上这不是我的首要任务,因为我还有自己的工作(包括我的 perf-tools,一个可以工作在旧版本内核上的程序)。

现在BPF 追踪器已经推出了,已经有科技公司开始寻找会 BPF 的人了。但我还是推荐 [Netflix 公司](http://www.brendangregg.com/blog/2016-03-30/working-at-netflix-2016.html)。(如果你为了 BPF 而要聘请我,那我还是十分乐于待在 Netflix 公司的!)

### 使用简单

DTrace 和 bcc/BPF 现在的最大区别就是哪个更好使用。这取决于你要用 BPF 追踪做什么了。如果你要

* **使用 BPF 工具/度量**:应该是没什么区别的。工具的表现都差不多,图形用户界面都能取得类似度量指标。大部分用户通过这种方式使用 BPF。

* **开发工具/度量**:bcc 的开发可难多了。DTrace 有一套自己的简单语言,D 语音,和 awk 语言相似,而 bcc 使用已有的语言(C 语言,Python 和 lua)及其类库。一个用 C 和 Python 写的 bcc 工具与仅仅用 D 语言写出来的工具相比,可能要多十多倍行数的代码,或者更多。但是很多 DTrace 工具用 shell 封装来提供参数和差错检查,会让代码变得十分臃肿。编程的难处是不同的:重写 bcc 更需要巧妙性,这导致某些脚本更加难开发。(尤其是 `bpf_probe_read()` 这类的函数,需要了解更多 BPF 的内涵知识)。当计划改进 bcc 时,这一情形将得到改善。

* **运行常见的命令**:十分相近。通过 `dtrace` 命令,DTrace 能做很多事,但 bcc 有各种工具,`trace`、`argdist`、`funccount`、`funclatency` 等等。

* **编写自定义的特殊命令**:使用 DTrace 的话,这就没有必要了。允许定制消息快速传递和系统快速响应,DTrace 的高级分析很快。而 bcc 现在受限于它的多种工具以及它们的适用范围。

简单来说,如果你只使用 BPF 工具的话,就不必关注这些差异了。如果你经验丰富,是个开发者(像我一样),目前 bcc 的使用更难一些。

举一个 bcc 的 Python 前端的例子,下面是追踪硬盘 I/O 并打印出 I/O 大小的柱状图代码:

```

from bcc import BPF

from time import sleep

# load BPF program

b = BPF(text="""

#include <uapi/linux/ptrace.h>

#include <linux/blkdev.h>

BPF_HISTOGRAM(dist);

int kprobe__blk_account_io_completion(struct pt_regs *ctx, struct request *req)

{

dist.increment(bpf_log2l(req->__data_len / 1024));

return 0;

}

""")

# header

print("Tracing... Hit Ctrl-C to end.")

# trace until Ctrl-C

try:

sleep(99999999)

except KeyboardInterrupt:

print

# output

b["dist"].print_log2_hist("kbytes")

```

注意 Python 代码中嵌入的 C 语句(`text=`)。

这就完成了任务,但仍有改进的空间。好在我们有时间去做:人们使用 Linux 4.9 并能用上 BPF 还得好几个月呢,所以我们有时间来制造工具和前端。

### 高级语言

前端越简单,比如高级语言,所改进的可能就越不如你所期望的。绝大多数人使用封装好的工具(和图形界面),仅有少部分人能写出这些工具。但我不反对使用高级语言,比如 SystemTap,毕竟已经开发出来了。

```

#!/usr/bin/stap

/*

* opensnoop.stp Trace file open()s. Basic version of opensnoop.

*/

probe begin

{

printf("\n%6s %6s %16s %s\n", "UID", "PID", "COMM", "PATH");

}

probe syscall.open

{

printf("%6d %6d %16s %s\n", uid(), pid(), execname(), filename);

}

```

如果拥有整合了语言和脚本的 SystemTap 前端与高性能的内置在内核中的 BPF 后端,会不会令人满意呢?RedHat 公司的 Richard Henderson 已经在进行相关工作了,并且发布了 [初代版本](https://lkml.org/lkml/2016/6/14/749)!

这是 [ply](https://wkz.github.io/ply/),一个完全新颖的 BPF 高级语言:

```

#!/usr/bin/env ply

kprobe:SyS_*

{

$syscalls[func].count()

}

```

这也是一份承诺。

尽管如此,我认为工具开发者的实际难题不是使用什么语言:而是要了解要用这些强大的工具做什么?

### 如何帮助我们

* **推广**:BPF 追踪器目前还没有什么市场方面的进展。尽管有公司了解并在使用它(Facebook、Netflix、Github 和其它公司),但要广为人知尚需时日。你可以分享关于 BPF 的文章和资源给业内的其它公司来帮助我们。

* **教育**:你可以撰写文章,发表演讲,甚至参与 bcc 文档的编写。分享 BPF 如何解决实际问题以及为公司带来收益的实例。

* **解决 bcc 的问题**:参考 [bcc issue list](https://github.com/iovisor/bcc/issues),这包含了错误和需要的特性。

* **提交错误**:使用 bcc/BPF,提交你发现的错误。

* **创造工具**:有很多可视化的工具需要开发,但请不要太草率,因为大家会先花几个小时学习使用你做的工具,所以请尽量把工具做的直观好用(参考我的[文档](https://github.com/iovisor/bcc/blob/master/CONTRIBUTING-SCRIPTS.md))。就像 Mike Muuss 提及到他自己的 [ping](http://ftp.arl.army.mil/%7Emike/ping.html) 程序:“要是我早知道这是我一生中最出名的成就,我就多开发一两天,添加更多选项。”

* **高级语言**:如果现有的 bcc 前端语言让你很困扰,或许你能弄门更好的语言。要是你想将这门语言内建到 bcc 里面,你需要使用 libbcc。或者你可以帮助 SystemTap BPF 或 ply 的工作。

* **整合图形界面**:除了 bcc 可以使用的 CLI 命令行工具,怎么让这些信息可视呢?延迟热点图,火焰图等等。

### 其它追踪器

那么 SystemTap、ktap、sysdig、LTTng 等追踪器怎么样呢?它们有个共同点,要么使用了 BPF,要么在自己的领域做得更好。会有单独的文章介绍它们自己。

至于 DTrace ?我们公司目前还在基于 FreeBSD 系统的 CDN 中使用它。

### 更多 bcc/BPF 的信息

我已经写了一篇《[bcc/BPF 工具最终用户教程](https://github.com/iovisor/bcc/blob/master/docs/tutorial.md)》,一篇《[bcc Python 开发者教程](https://github.com/iovisor/bcc/blob/master/docs/tutorial_bcc_python_developer.md)》,一篇《[bcc/BPF 参考手册](https://github.com/iovisor/bcc/blob/master/docs/reference_guide.md)》,并提供了一些有用的[工具](https://github.com/iovisor/bcc/tree/master/tools),每一个工具都有一个 [example.txt](https://github.com/iovisor/bcc/tree/master/tools) 文件和 [man page](https://github.com/iovisor/bcc/tree/master/man/man8)。我之前写过的关于 bcc 和 BPF 的文章有:

* [eBPF: One Small Step](http://www.brendangregg.com/blog/2015-05-15/ebpf-one-small-step.html) (后来就叫做 BPF)

* [bcc: Taming Linux 4.3+ Tracing Superpowers](http://www.brendangregg.com/blog/2015-09-22/bcc-linux-4.3-tracing.html)

* [Linux eBPF Stack Trace Hack](http://www.brendangregg.com/blog/2016-01-18/ebpf-stack-trace-hack.html) (现在官方支持追踪堆栈了)

* [Linux eBPF Off-CPU Flame Graph](http://www.brendangregg.com/blog/2016-01-20/ebpf-offcpu-flame-graph.html)

* [Linux Wakeup and Off-Wake Profiling](http://www.brendangregg.com/blog/2016-02-01/linux-wakeup-offwake-profiling.html)

* [Linux Chain Graph Prototype](http://www.brendangregg.com/blog/2016-02-05/ebpf-chaingraph-prototype.html)

* [Linux eBPF/bcc uprobes](http://www.brendangregg.com/blog/2016-02-08/linux-ebpf-bcc-uprobes.html)

* [Linux BPF Superpowers](http://www.brendangregg.com/blog/2016-03-05/linux-bpf-superpowers.html)

* [Ubuntu Xenial bcc/BPF](http://www.brendangregg.com/blog/2016-06-14/ubuntu-xenial-bcc-bpf.html)

* [Linux bcc Tracing Security Capabilities](http://www.brendangregg.com/blog/2016-10-01/linux-bcc-security-capabilities.html)

* [Linux MySQL Slow Query Tracing with bcc/BPF](http://www.brendangregg.com/blog/2016-10-04/linux-bcc-mysqld-qslower.html)

* [Linux bcc ext4 Latency Tracing](http://www.brendangregg.com/blog/2016-10-06/linux-bcc-ext4dist-ext4slower.html)

* [Linux bcc/BPF Run Queue (Scheduler) Latency](http://www.brendangregg.com/blog/2016-10-08/linux-bcc-runqlat.html)

* [Linux bcc/BPF Node.js USDT Tracing](http://www.brendangregg.com/blog/2016-10-12/linux-bcc-nodejs-usdt.html)

* [Linux bcc tcptop](http://www.brendangregg.com/blog/2016-10-15/linux-bcc-tcptop.html)

* [Linux 4.9's Efficient BPF-based Profiler](http://www.brendangregg.com/blog/2016-10-21/linux-efficient-profiler.html)

我在 Facebook 的 Performance@Scale [Linux BPF Superpowers](http://www.brendangregg.com/blog/2016-03-05/linux-bpf-superpowers.html) 大会上发表过一次演讲。十二月份,我将在 Boston 发表关于 BPF/bcc 在 [USENIX LISA](https://www.usenix.org/conference/lisa16) 方面的演讲和教程。

### 致谢

* Van Jacobson 和 Steve McCanne,他们创建了最初用作过滤器的 BPF 。

* Barton P. Miller,Jeffrey K. Hollingsworth,and Jon Cargille,发明了动态追踪,并发表论文《Dynamic Program Instrumentation for Scalable Performance Tools》,可扩展高性能计算协议 (SHPCC),于田纳西州诺克斯维尔市,1994 年 5 月发表。

* kerninst (ParaDyn, UW-Madison),展示了动态跟踪的价值的早期动态跟踪工具(上世纪 90 年代后期)

* Mathieu Desnoyers (在 LTTng),内核的主要开发者,主导 tracepoints 项目。

* IBM 开发的作为 DProbes 一部分的 kprobes,DProbes 在 2000 年时曾与 LTT 一起提供 Linux 动态追踪,但没有整合到一起。

* Bryan Cantrill, Mike Shapiro, and Adam Leventhal (Sun Microsystems),DTrace 的核心开发者,DTrace 是一款很棒的动态追踪工具,安全而且简单(2004 年)。对于动态追踪技术,DTrace 是科技的重要转折点:它很安全,默认安装在 Solaris 以及其它以可靠性著称的系统里。

* 来自 Sun Microsystems 的各部门的许多员工,促进了 DTrace,为我们带来了高级系统追踪的意识。

* Roland McGrath (在 Red Hat),utrace 项目的主要开发者,utrace 变成了后来的 uprobes。

* Alexei Starovoitov (PLUMgrid, 后来是 Facebook),加强版 BPF(可编程内核部件)的主要开发者。

* 那些帮助反馈、提交代码、测试以及针对增强版 BPF 补丁(请在 lkml 搜索 BPF)的 Linux 内核工程师: Wang Nan、 Daniel Borkmann、 David S. Miller、 Peter Zijlstra 以及其它很多人。

* Brenden Blanco (PLUMgrid),bcc 的主要开发者。

* Sasha Goldshtein (Sela) 开发了 bcc 中的跟踪点支持,和功能最强大的 bcc 工具 trace 及 argdist,帮助 USDT 项目的开发。

* Vicent Martí 和其它 Github 上的工程师,为 bcc 编写了基于 lua 的前端,帮助 USDT 部分项目的开发。

* Allan McAleavy、 Mark Drayton,和其他的改进 bcc 的贡献者。

感觉 Netflix 提供的环境和支持,让我能够编写 BPF 和 bcc 跟踪器并完成它们。我已经编写了多年的追踪工具(使用 TNF/prex、DTrace、SystemTap、ktap、ftrace、perf,现在是 bcc/BPF),并写书、博客以及评论,

最后,感谢 [Deirdré](http://www.brendangregg.com/blog/2016-07-23/deirdre.html) 编辑了另外一篇文章。

### 总结

Linux 没有 DTrace(语言),但它现在有了,或者说拥有了 DTraceTookit(工具)。

通过增强内置的 BPF 引擎,Linux 4.9 内核拥有了用来支持现代化追踪的最后一项能力。内核支持这一最难的部分已经做完了。今后的任务包括更多的命令行执行工具,以及高级语言和图形用户界面。

对于性能分析产品的客户,这也是一件好事:你能查看延迟柱状图和热点图,CPU 处理和 CPU 之外的火焰图,拥有更好的时延断点和更低耗的工具。在用户空间按包跟踪和处理是没有效率的方式。

那么你什么时候会升级到 Linux 4.9 呢?一旦官方发布,新的性能测试工具就来了:`apt-get install bcc-tools` 。

开始享受它吧!

Brendan

---

via: <http://www.brendangregg.com/blog/2016-10-27/dtrace-for-linux-2016.html>

作者:[Brendan Gregg](http://www.brendangregg.com/) 译者:[GitFuture](https://github.com/GitFuture) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 302 | Found | null |

8,039 | httpstat:一个检查网站性能的 curl 统计分析工具 | http://www.tecmint.com/httpstat-curl-statistics-tool-check-website-performance/ | 2016-12-16T08:11:00 | [

"httpstat",

"curl"

] | https://linux.cn/article-8039-1.html | httpstat 是一个 Python 脚本,它以美妙妥善的方式反映了 curl 统计分析,它是一个单一脚本,兼容 Python 3 ,在用户的系统上不需要安装额外的软件(依赖)。

从本质上来说它是一个 cURL 工具的封装,意味着你可以在 URL 后使用几个有效的 cURL 选项,但是不包括 `-w`、 `-D`、 `-o`、 `-s` 和 `-S` 选项,这些已经被 httpstat 使用了。

*httpstat Curl 统计分析工具*

你可以看到上图的一个 ASCII 表显示了每个过程消耗多长时间,对我来说最重要的一步是“<ruby> 服务器处理 <rp> ( </rp> <rt> server processing </rt> <rp> ) </rp></ruby>” – 如果这个数字很高,那么你需要[优化你网站服务器来加速访问速度](http://www.tecmint.com/apache-performance-tuning/)。

网站或服务器优化你可以查看我们的文章:

1. [5 个优化 Apache Web 服务器性能的技巧](http://www.tecmint.com/apache-performance-tuning/)

2. [使 Apache 和 Nginx 性能提升 10 倍](http://www.tecmint.com/install-mod_pagespeed-to-boost-apache-nginx-performance/)

3. [如何使用 Gzip 模块提高 Nginx 性能](http://www.tecmint.com/increase-nginx-performance-enable-gzip-compression-module/)

4. [15 个优化 MySQL/MariaDB 性能的建议](/article-5730-1.html)

使用下面安装说明和用法来获取 httpstat 检查出你的网站速度。

### 在 Linux 系统中安装 httpstat

你可以使用两种合理的方法安装 httpstat :

1. 使用 [wget 命令](/article-4129-1.html)直接从它的 Github 仓库获取如下:

```

$ wget -c https://raw.githubusercontent.com/reorx/httpstat/master/httpstat.py

```

1. 使用 `pip`(这个方法允许 httpstat 作为命令安装到你的系统中)像这样:

```

$ sudo pip install httpstat

```

注:确保 `pip` 包已经在系统上安装了,如果没使用你的发行版包管理器 [yum](/article-2272-1.html) 或 [apt](/article-7364-1.html)安装它。

### 在 Linux 中如何使用 httpstat

`httpstat` 可以根据你安装它的方式来使用,如果你直接下载了它,进入下载目录使用下面的语句运行它:

```

$ python httpstat.py url cURL_options

```

如果你使用 `pip` 来安装它,你可以作为命令来执行它,如下表:

```

$ httpstat url cURL_options

```

查看 `httpstat` 帮助页,命令如下:

```

$ python httpstat.py --help

或

$ httpstat --help

```

`httpstat` 帮助:

```

Usage: httpstat URL [CURL_OPTIONS]

httpstat -h | --help

httpstat --version

Arguments:

URL url to request, could be with or without `http(s)://` prefix

Options:

CURL_OPTIONS any curl supported options, except for -w -D -o -S -s,

which are already used internally.

-h --help show this screen.

--version show version.

Environments:

HTTPSTAT_SHOW_BODY Set to `true` to show response body in the output,

note that body length is limited to 1023 bytes, will be

truncated if exceeds. Default is `false`.

HTTPSTAT_SHOW_IP By default httpstat shows remote and local IP/port address.

Set to `false` to disable this feature. Default is `true`.

HTTPSTAT_SHOW_SPEED Set to `true` to show download and upload speed.

Default is `false`.

HTTPSTAT_SAVE_BODY By default httpstat stores body in a tmp file,

set to `false` to disable this feature. Default is `true`

HTTPSTAT_CURL_BIN Indicate the curl bin path to use. Default is `curl`

from current shell $PATH.

HTTPSTAT_DEBUG Set to `true` to see debugging logs. Default is `false`

```

从上面帮助命令的输出,你可以看出 `httpstat` 已经具备了一些可以影响其行为的环境变量。

使用它们,只需输出适当的值的这些变量到 `.bashrc` 或 `.zshrc` 文件。

例如:

```

export HTTPSTAT_SHOW_IP=false

export HTTPSTAT_SHOW_SPEED=true

export HTTPSTAT_SAVE_BODY=false

export HTTPSTAT_DEBUG=true

```

你一旦添加完它们,保存文件然后运行下面的命令使改变生效:

```

$ source ~/.bashrc

```

你可以指定使用 cURL 执行文件的路径,默认使用的是当前 shell 的 [$PATH 环境变量](http://www.tecmint.com/set-unset-environment-variables-in-linux/)。

下面是一些展示 `httpstat` 如何工作的例子。

```

$ python httpstat.py google.com

或

$ httpstat google.com

```

*httpstat – 展示网站统计分析*

接下来的命令中:

1. `-X` 命令标记指定一个客户与 HTTP 服务器连接的请求方法。

2. `--data-urlencode` 这个选项将会把数据(这里是 a=b)按 URL 编码的方式编码后再提交。

3. `-v` 开启详细模式。

```

$ python httpstat.py httpbin.org/post -X POST --data-urlencode "a=b" -v

```

*httpstat – 定制提交请求*

你可以查看 cURL 的帮助获取更多有用的高级选项,或者浏览 `httpstat` 的 Github 仓库: <https://github.com/reorx/httpstat>

这篇文章中,我们讲述了一个有效的工具,它以简单和整洁方式来查看 cURL 统计分析。如果你知道任何类似的工具,别犹豫,让我们知道,你也可以问问题或评论这篇文章或 httpstat,通过下面反馈。

---

via: <http://www.tecmint.com/httpstat-curl-statistics-tool-check-website-performance/>

作者:[Aaron Kili](http://www.tecmint.com/author/aaronkili/) 译者:[wyangsun](https://github.com/wyangsun) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 组织编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,040 | 修复 Ubuntu 中“Unable to lock the administration directory (/var/lib/dpkg/)”的 | http://www.tecmint.com/fix-unable-to-lock-the-administration-directory-var-lib-dpkg-lock | 2016-12-16T09:42:00 | [

"apt-get",

"apt"

] | https://linux.cn/article-8040-1.html |

在 Ubuntu 或者它的衍生版如 Linux Mint(我已经作为日常工作使用的系统)中使用 [apt-get 命令](/article-4933-1.html)或者其相对更新的[APT 管理工具](/article-7364-1.html)时,你可能会在命令行中看到一个 `unable to lock the administration directory (/var/lib/dpkg/) is another process using it` 的错误。

这个错误尤其对那些对这个错误原因不了解的 Linux(Ubuntu)新手而言更加恼人。

下面是一个例子,展示了出现在 Ubuntu 16.10 上的文件锁定错误:

```

tecmint@TecMint:~$ sudo apt install neofetch

[sudo] password for tecmint:

E: Could not get lock /var/lib/dpkg/lock - open (11: Resource temporarily unavailable)

E: Unable to lock the administration directory (/var/lib/dpkg), is another process using it?

```

下面的输出是另外一个可能显示的错误:

```

E: Could not get lock /var/lib/apt/lists/lock - open (11: Resource temporarily unavailable)

E: Unable to lock directory /var/lib/apt/lists/

E: Could not get lock /var/lib/dpkg/lock - open (11: Resource temporarily unavailable)

E: Unable to lock the administration directory (/var/lib/dpkg/), is another process using it?

```

你将来遇到这个错误该怎么去解决?有好几种方法处理这个错误,但是本篇中我们会用两种或许是最简单和最有效的方法来解决它。

### 1、找出并杀掉所有 apt-get 或者 apt 进程

运行下面的命令来[生成所有含有 apt 的进程列表](http://www.tecmint.com/find-linux-processes-memory-ram-cpu-usage/),你可以使用 `ps` 和 [grep 命令](http://www.tecmint.com/linux-grep-commands-character-classes-bracket-expressions/)并用管道组合来得到含有 apt 或者 apt-get 的进程。

```

$ ps -A | grep apt

```

[](http://www.tecmint.com/wp-content/uploads/2016/11/find-apt-processes.png)

*找出 apt 以及 apt-get 进程*

你可以看到上面命令输出的每个 apt-get 或者 apt 进程,使用下面的命令[杀掉每个进程](http://www.tecmint.com/find-and-kill-running-processes-pid-in-linux/)。

上面截图中的第一列是进程 ID(PID)。

```

$ sudo kill -9 processnumber

或者

$ sudo kill -SIGKILL processnumber

```

比如,下面命令中的`9`是 `SIGKILL` 的信号数,它会杀掉第一个 apt 进程:

```

$ sudo kill -9 13431

或者

$ sudo kill -SIGKILL 13431

```

### 2、 删除锁定的文件

锁定的文件会阻止 Linux 系统中某些文件或者数据的访问,这个概念也存在于 Windows 或者其他的操作系统中。

一旦你运行了 apt-get 或者 apt 命令,锁定文件将会创建于 `/var/lib/apt/lists/`、`/var/lib/dpkg/`、`/var/cache/apt/archives/` 中。

这有助于运行中的 apt-get 或者 apt 进程能够避免被其它需要使用相同文件的用户或者系统进程所打断。当该进程执行完毕后,锁定文件将会删除。

重要提醒:万一你在没有看到 apt-get 或者 apt 进程的情况下在上面两个不同的文件夹中看到了锁定文件,这是因为进程由于某个原因被杀掉了,因此你需要删除锁定文件来避免该错误。

首先运行下面的命令来移除 `/var/lib/dpkg/` 文件夹下的锁定文件:

```

$ sudo rm /var/lib/dpkg/lock

```

之后像下面这样强制重新配置软件包:

```

$ sudo dpkg --configure -a

```

也可以删除 `/var/lib/apt/lists/` 以及缓存文件夹下的锁定文件:

```

$ sudo rm /var/lib/apt/lists/lock

$ sudo rm /var/cache/apt/archives/lock

```

接下来,更新你的软件包源列表:

```

$ sudo apt update

或者

$ sudo apt-get update

```

总结一下,对于 Ubuntu(以及它的衍生版)用户在使用 apt-get 或者 apt 也叫 [aptitude 命令](http://www.tecmint.com/difference-between-apt-and-aptitude/)时遇到的问题,我们已经用两种方法来解决了。

你有什么可以分享出来的有效的方法来处理这个错误么?在下面的评论区联系我们。

除此之外,你可能还希望了解[如何找出并杀掉运行的进程](http://www.tecmint.com/find-and-kill-running-processes-pid-in-linux/),你可以阅读这篇[用 kill、pkill、killall 来中止进程](http://www.tecmint.com/how-to-kill-a-process-in-linux/)指南来了解。

---

via: <http://www.tecmint.com/fix-unable-to-lock-the-administration-directory-var-lib-dpkg-lock>

作者:[Aaron Kili](http://www.tecmint.com/author/aaronkili/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 组织编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,041 | 如何在 Linux 中复制文件到多个目录中 | http://www.tecmint.com/copy-file-to-multiple-directories-in-linux/ | 2016-12-17T15:10:00 | [

"cp"

] | https://linux.cn/article-8041-1.html | [在学习 Linux 的过程中](http://www.tecmint.com/free-online-linux-learning-guide-for-beginners/),对于新手而言总是会使用几个命令来完成一个简单的任务。对正在熟悉使用终端的人这是很容易理解的行为。然而,如果你想要成为一个老手,学习我说的“快捷命令”会显著减少时间浪费。

在本篇中,我们会用一个简单的方法在 Linux 中用一个命令来将目录复制到多个文件夹中。

在 Linux 中,[cp 命令](http://www.tecmint.com/advanced-copy-command-shows-progress-bar-while-copying-files/)常被用于从一个文件夹中复制文件到另一个文件夹中,最简单的语法如下:

```

# cp [options….] source(s) destination

```

另外,你也可以使用[高级复制命令](http://www.tecmint.com/advanced-copy-command-shows-progress-bar-while-copying-files/),它可以在复制[大的文件或文件夹](http://www.tecmint.com/find-top-large-directories-and-files-sizes-in-linux/)时显示进度条。

看下下面的命令,通常你会使用两个不同的命令来将相同的文件复制到不同的文件夹中:

```

# cp -v /home/aaronkilik/bin/sys_info.sh /home/aaronkilik/test

# cp -v /home/aaronkilik/bin/sys_info.sh /home/aaronkilik/tmp

```

*复制文件到多个文件夹中*

假设你想要复制一个特定文件到 5 个或者更多的文件夹中,这意味着你需要输入 5 次或者更多的cp命令么?

要摆脱这个问题,你可以用 cp 命令与 [echo命令](http://www.tecmint.com/echo-command-in-linux/)、管道、xargs 命令一起使用:

```

# echo /home/aaronkilik/test/ /home/aaronkilik/tmp | xargs -n 1 cp -v /home/aaronkilik/bin/sys_info.sh

```

上面的命令中,目录的路径(dir1、dir2、dir3...dirN)被管道作为输入到 xargs 命令中,含义是:

1. `-n 1` - 告诉 xargs 命令每个命令行最多使用一个参数,并发送到 cp 命令中。

2. `cp` – 用于复制文件。

3. `-v` – 启用详细模式来显示更多复制细节。

*在 Linux 中复制文件到多个位置中*

试试阅读 `cp`、 `echo` 和 `xargs` 的 man 页面来找出所有有用和高级的用法信息:

```

$ man cp

$ man echo

$ man xargs

```

就是这样了,你可以在下面的评论区给我们发送主题相关的问题或者反馈。你也可以阅读有关 [progress 命令](http://www.tecmint.com/progress-monitor-check-progress-of-linux-commands/)来帮助监控运行中的(cp、mv、dd、[tar](http://www.tecmint.com/18-tar-command-examples-in-linux/) 等等)的进度。

---

作者简介:

Aaron Kili 是一个 Linux 及 F.O.S.S 热衷者,即将成为 Linux 系统管理员、web 开发者,目前是 TecMint 的内容创作者,他喜欢用电脑工作,并坚信分享知识。

---

via: <http://www.tecmint.com/copy-file-to-multiple-directories-in-linux/>

作者:[Aaron Kili](http://www.tecmint.com/author/aaronkili/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,042 | 慢动作输出 Linux 命令结果并用彩色显示 | http://www.tecmint.com/add-colors-to-command-output-terminal-linux/ | 2016-12-18T09:21:00 | [

"lolcat"

] | https://linux.cn/article-8042-1.html | 本篇中,我们会展示一个很酷及简单的方法在屏幕中显示彩色的输出,并且可以为了某个原因减慢输出的速度。

[lolcat 命令](/article-5798-1.html)可以满足上面的需求。它基本上通过与 [cat 命令](http://www.tecmint.com/13-basic-cat-command-examples-in-linux/)类似的方式将文件或标准输入定向到标准输出来运行,覆盖某个命令的默认屏幕输出颜色,并为其添加彩色。

### 如何在 Linux 中安装 lolcat 程序

lolcat 可以在大多数现代 Linux 发行版的默认仓库中得到,但是可用的版本有点老。你可以使用下面的指导来从 git 仓库中安装最新的 lolcat 版本。

* [安装 lolcat 来在 Linux 中显示彩色输出](/article-5798-1.html)

lolcat 安装后,基本的 lolcat 语法是:

```

$ lolcat [options] [files] ...

```

有几个选项可以控制它的行为,下面是一些我们在本指导中会强调的几个最重要的标志:

1. `-a` - 将每行输出都显示动态效果。

2. `-d` – 指定动画效果间隔(显示下一行之前的帧),默认是 12。

3. `-s` – 它指定了动画效果的速度(帧速-每秒的显示帧数),默认是 20。

4. `-f` – 强制显示彩色以防止标准输出不是 tty。

你可以在 lolcat 的 man 页可以找到更多的选项:

```

$ man lolcat

```

### 如何在 Linux 中使用 lolcat

要使用 lolcat,直接将相关命令的输出通过管道给 lolcat,即可见证魔法。

比如:

```

$ ls -l | lolcat -as 25

```

除此之外你也可以改变默认速度,在下面的命令中,我们会使用一个相对较慢的速度,每秒显示 10 帧:

```

$ ls -l | lolcat -as 10

```

你可以使用任何命令结合 lolcat 在 Linux 终端中输出彩色结果,比如 `ps`、`date` 和 `cal`:

```

$ ps | lolcat

$ date | lolcat

$ cal | lolcat

```

本篇中,我们了解了如何显著降低屏幕输出的速度,并显示彩色效果。

通常上,你可以在下面的评论栏中留下任何关于本篇的问题或评论。最后,你可以留下任何你发现的有用命令。

---

via: <http://www.tecmint.com/add-colors-to-command-output-terminal-linux/>

作者:[Aaron Kili](http://www.tecmint.com/author/aaronkili/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,043 | 安卓编年史(13):Android 2.2 Froyo——更快更华丽 | http://arstechnica.com/gadgets/2016/10/building-android-a-40000-word-history-of-googles-mobile-os/13/ | 2016-12-18T15:45:00 | [

"Android",

"安卓编年史"

] | https://linux.cn/article-8043-1.html |

### Android 2.2 Froyo——更快更华丽

[安卓 2.2](http://arstechnica.com/information-technology/2010/07/android-22-froyo/) 在 2010 年 5 月,也就是 2.1 发布后的四个月后亮相。Froyo(冻酸奶)的亮点主要是底层优化,只为更快的速度。Froyo 最大的改变是增加了 JIT 即时编译。JIT 自动在运行时将 java 字节码转换为原生码,这会给系统全面带来显著的性能改善。

浏览器同样得到了性能改善,这要感谢整合了来自 Chrome 的 V8 Javascript 引擎。这是安卓浏览器从 Chrome 借鉴的许多特性中的第一个,最终系统内置的浏览器会被移动版 Chrome 彻底替代掉。在那之前,安卓团队还是需要提供一个浏览器。从 Chrome 借鉴特性是条升级的捷径。

在谷歌专注于让它的平台更快的同时,苹果正在让它的平台更全面。这位谷歌的竞争对手在一个月前发布了 10 英寸的 iPad,先行进入了平板时代。尽管有些搭载 Froyo 和 Gingerbread 的安卓平板发布,但谷歌的官方回应——安卓 3.0 Honeycomb(蜂巢)以及摩托罗拉 Xoom——在 9 个月后才来到。

*Froyo 底部添加了双图标停靠栏以及全局搜索。 [Ron Amadeo 供图]*

Froyo 主屏幕最大的变化是底部的新停靠栏,电话和浏览器图标填充了先前抽屉按钮左右的空白空间。这些新图标都是现有图标的白色定制版本,并且用户没办法自己设置图标。

默认布局移除了所有图标,屏幕上只留下一个使用提示小部件,引导你点击启动器图标以访问你的应用。谷歌搜索小部件得到了一个谷歌 logo,它同时也是个按钮。点击它可以打开一个搜索界面,你可以限制搜索范围是在互联网、应用或是联系人之内。

*下载页面有了“更新所有”按钮,这是个 Flash 应用,一个 flash 驱动的一切皆有可能的网站,以及“移动到 SD”按钮。 [[Ryan Paul](http://arstechnica.com/information-technology/2010/07/android-22-froyo/) 供图]*

还有一些优秀的新功能加入了 Froyo,安卓市场加入了更多的下载控制。有个新的“更新所有”按钮固定在了下载页面底部。谷歌还添加了自动更新特性,只要应用权限没有改变就能够自动安装应用;尽管如此,自动更新默认是关闭的。

第二张图展示了 Adobe Flash 播放器,它是 Froyo 独有的。这个应用作为插件加入了浏览器,让浏览器能够有“完整的网络”体验。在 2010 年,这意味着网页充满了 Flash 导航和视频。Flash 是安卓相比于 iPhone 最大的不同之一。史蒂夫·乔布斯展开了一场对抗 Flash 的圣战,声称它是一个被淘汰的、充满 bug 的软件,并且苹果不会允许它在 iOS 存在。所以安卓接纳了 Flash 并且让它在安卓上运行,给予用户在安卓上拥有接近可用的 flash 实现。

在那时,Flash 甚至能够让桌面电脑崩溃,所以在移动设备上一直保持打开状态会带来可怕的体验。为了解决这个问题,安卓浏览器上的 Flash 可以设置为“按需打开”——除非用户点击 Flash 占位图标,否则不会加载 Flash 内容。对 Flash 的支持将会持续到安卓 4.1,Adobe 在那时放弃并且结束了这个项目。Flash 从头到尾从未在安卓上完美运行过。而 Flash在 iPhone 这个最流行的移动设备上的缺失,推动了互联网最终放弃了这个平台。

最后一张图片显示的是新增的移动应用到 SD 卡功能,在那个手机只有 512 MB内置存储的时代,这个功能十分的必要的。

*驾驶模式应用。相机现在可以旋转了。 [Ron Amadeo 供图]*

相机应用终于更新支持纵向模式了。相机设置被从抽屉中移出,变成一条半透明的按钮带,放在了快门按钮和其他控制键旁边。这个新设计看起来从 Cooliris 相册中获得了许多灵感,半透明的、有弹性的聊天气泡弹出窗口。看到更现代的Cooliris 风格 UI 设计被嫁接到皮革装饰的相机应用确实十分奇怪——从审美上来说一点都不搭。

*半残缺的 Facebook 应用是个常见的 2x3 导航页面的优秀范例。谷歌 Goggles 被包含了进来但同样是残缺的。 [Ron Amadeo 供图]*

不像在安卓 2.0 和 2.1 中包含的 Facebook 客户端,2.2 版本的仍然部分能够工作并且可以登录 Facebook 服务器。Facebook 应用是谷歌那时候设计指南的优秀范例,它建议应用拥有一个含有 3x2 图标方阵的导航页并作为应用主页。

这是谷歌的第一个标准化尝试,将导航元素从菜单按钮里移到屏幕上,以便用户找到它们。这个设计很实用,但它在打开应用和使用应用之间增加了额外的障碍。谷歌不久后会意识到当用户打开一个应用,显示应用内容而不是中间导航页是个更好的主意。以 Facebook 为例,打开应用直接打开信息订阅会更合适。并且不久后应用设计将会把导航降级到二层位置——先是作为顶部的标签之一,后来谷歌放在了“导航抽屉”,一个含有应用所有功能位置的滑出式面板。

还有个预装到 Froyo 的应用是谷歌 Goggles,一个视觉搜索应用,它会尝试辨别图片上的主体。它在辨别艺术品、地标以及条形码时很实用,但差不多也就这些了。最先的两个设置屏幕,以及相机界面,这是应用里仅有的现在还能运行的了。由于客户端太旧了,实际上你如今并不能完成一个搜索。应用里也没什么太多可看的,也就一个会返回搜索结果页的相机界面而已。

*Twitter 应用,一个充满动画的谷歌和 Twitter 的合作成果。 [Ron Amadeo 供图]*

Froyo 拥有首个安卓 Twitter 应用,实际上它是谷歌和 Twitter 的合作成果。那时,Twitter 应用是安卓应用阵容里的大缺憾之一。开发者们更偏爱 iPhone,加上苹果占领先机和严格的设计要求,App Store 里可选择的应用远比安卓的有优势。但是谷歌需要一个 Twitter 应用,所以它和 Twitter 合作组建团队让第一个版本问世。

这个应用代表了谷歌的新设计语言,这意味着它有个中间导航页以及对动画要求的“技术演示”。Twitter 应用甚至比 Cooliris 相册用的动画效果还多——所有东西一直都在动。所有页面顶部和底部的云朵以不同速度持续滚动,底部的 Twitter 小鸟拍动它的翅膀并且左右移动它的头。

Twitter 应用实际上有点 Action Bar 早期前身的特性,在安卓 3.0 中引入了一条顶部对齐的连续控制条。沿着所有屏幕的顶部有条拥有 Twitter 标志以及如搜索、刷新和发推这样的按钮的蓝色横栏。它和后来的 Action Bar 之间大的区别在于 Twitter / 谷歌这里的设计的右上角缺少“上一级”按钮,实际上它在应用里用了完整的第二个栏位显示你当前所在位置。在上面的第二张图里,你可以看到整条带有“Tweets”标签的专用于显示位置的栏(当然,还有持续滚动的云朵)。第二个栏的 Twitter 标志扮演着另一个导航元素,有时候在当前部分显示额外的下拉区域,有时候显示整个顶级快捷方式集合。

2.3 Tweet 流看起来和今天的并没有什么不同,除了隐藏的操作按钮(回复,转推等),都在右对齐的箭头按钮里。它们弹出来的是一个聊天气泡菜单,看起来就像导航弹窗。仿 Action Bar 在发推页面有重要作用。它安置着 twitter 标志,剩余字数统计,以及添加照片、拍照,以及提到联系人按钮。

Twitter 应用甚至还有一对主屏幕小部件,大号的那个占据 8 格,提供了发推栏、更新按钮、一条推文,以及左右箭头来查看更多的推文。小号的显示一条推文以及回复按钮。点击大号的小部件的发推栏立即打开了“新推文”主窗口,这让“更新”按钮变得没有价值。

*Google Talk 和新 USB 对话框。 [Ron Amadeo 供图]*

其他部分,Google Talk(以及没有截图的短信应用)从暗色主题变成了浅色主题,这让它们看起来和现在的更接近现代的应用。USB 存储界面会在你设备接入电脑的时候从一个简单的对话框进入全屏界面。这个界面现在有个一个异形安卓机器人 / USB 闪存盘混合体,而不是之前的纯文字设计。

尽管安卓 2.2 在用户互动方式上没有什么新特性,但大的 UI 调整会在下两个版本到来。然而在所有的 UI 工作之前,谷歌希望先改进安卓的核心部分。

### **语音操作——口袋里的超级电脑**

2010 年 8 月,作为语音搜索应用的一项新功能,“[语音命令](http://arstechnica.com/gadgets/2010/08/google-beefs-up-voice-search-mobile-sync/)”登陆了安卓市场。语音命令允许用户向他们的手机发出语音命令,然后安卓会试着去理解他们并完成任务。像“导航至[地址]”这样的命令会打开谷歌地图并且开始逐向导航至你所陈述的目的地。你还可以仅仅通过语音来发送短信或电子邮件、拨打电话、打开网站、获取方向,或是在地图上查看一个地点。

语音命令是谷歌新应用设计哲学的顶峰。语音命令是那时候最先进的语音控制软件,秘密在于谷歌并不在设备上做任运算。一般来说,语音识别是 CPU 密集型任务。实际上,许多语音识别程序仍然有“速度与准确性”设置,用户可以选择他们愿意为语音识别算法运行等待的时间——更多的 CPU 处理意味着更加准确。

谷歌的创新在于没有劳烦手机上能力有限的处理器来进行语音识别运算。当说出一个命令时,用户的声音会被打包并通过互联网发送到谷歌云服务器。在那里,谷歌超算中心的超级计算机分析并解释语音,然后发送回手机。这是很长的一段旅程,但互联网最终还是有足够快的速度在一两秒内完成像这样的任务。

很多人抛出词语“云计算”来表达“所有东西都被存储在服务器上”,但这才是真正的云计算。谷歌在云端进行这些巨量的运算操作,又因为在这个问题上投入了看似荒唐的 CPU 资源数目,所以语音识别准确性的唯一限制就是算法本身了。软件不需要由每个用户独立“训练”,因为所有使用语音操作的人无时不刻都在训练它。借助互联网的力量,安卓在你的口袋里放了一部超级电脑,同时相比于已有的解决方案,把语音识别这个工作量从口袋大小的电脑转移到房间大小的电脑上大大提高了准确性。

语音识别作为谷歌的项目已经有一段时间了,它的出现都是因为一个 800 号码。[1-800-GOOG-411](http://arstechnica.com/business/2007/04/google-rolls-out-free-411-service/)是个谷歌从 2007 年 4 月起开通的免费电话信息服务。它就像 411 信息服务一样工作了多年——用户可以拨打这个号码询问电话号码——但是谷歌免费提供这项服务。查询过程中没有人工的干预,411 服务由语音识别和文本语音转换引擎驱动。在人们教谷歌如何去听之后,又用了三年才有实现语音命令的可能。

语音识别是谷歌长远思考的极佳范例——公司并不怕在一个可能成不了商业产品的项目上投资多年。今天,语音识别驱动的产品遍布谷歌。它被用在谷歌搜索应用的输入,安卓的语音输入,以及 Google.com。同时它还是 Google Glass 和 [Android Wear](http://arstechnica.com/gadgets/2014/03/in-depth-with-android-wear-googles-quantum-leap-of-a-smartwatch-os/) 的默认输入界面。

谷歌甚至还在输入之外的地方使用语音识别。谷歌的语音识别技术被用在了转述 Youtube 视频上,它能自动生成字幕供听障用户观看。生成的字幕甚至被谷歌做成了索引,所以你可以搜索某句话在视频的哪里说过。语音是许多产品的未来,并且这项长期计划将谷歌带入了屈指可数的拥有自家语音识别服务的公司行列。大部分其它的语音识别产品,像苹果的 Siri 和三星设备,只能使用 Nuance 的语音识别,并且为其支付了授权费。

在计算机听觉系统设立运行之后,谷歌下一步将把这项策略应用到计算机视觉上。这就是为什么像 Google Goggles,Google 图像搜索和 [Project Tango](http://arstechnica.com/gadgets/2014/02/googles-project-tango-is-a-smartphone-with-kinect-style-computer-vision/) 这样的项目存在的原因。就像 GOOG-411 的那段日子,这些项目还处在早期阶段。当[谷歌的机器人部门](http://arstechnica.com/gadgets/2013/12/google-robots-former-android-chief-will-lead-google-robotics-division/)造出了机器人,它会需要看和听,谷歌的计算机视觉和听觉项目会给谷歌一个先机。

---

[Ron Amadeo](http://arstechnica.com/author/ronamadeo) / Ron是Ars Technica的评论编缉,专注于安卓系统和谷歌产品。他总是在追寻新鲜事物,还喜欢拆解事物看看它们到底是怎么运作的。 [@RonAmadeo](https://twitter.com/RonAmadeo)

---

via: <http://arstechnica.com/gadgets/2016/10/building-android-a-40000-word-history-of-googles-mobile-os/13/>

译者:[alim0x](https://github.com/alim0x) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创翻译,[Linux中国](http://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,045 | 如何在 Shell 脚本中执行语法检查调试模式 | http://www.tecmint.com/check-syntax-in-shell-script/ | 2016-12-19T09:19:23 | [

"脚本",

"调试"

] | https://linux.cn/article-8045-1.html | 我们开启了 Shell 脚本调试系列文章,先是解释了不同的调试选项,下面介绍[如何启用 Shell 调试模式](/article-8028-1.html)。

写完脚本后,建议在运行脚本之前先检查脚本中的语法,而不是查看它们的输出以确认它们是否正常工作。

在本系列的这一部分,我们将了解如何使用语法检查调试模式。记住我们之前在本系列的[第一部分](/article-8028-1.html)中解释了不同的调试选项,在这里,我们将使用它们来执行脚本调试。

### 启用 verbose 调试模式

在进入本指导的重点之前,让我们简要地探索下 **verbose 模式**。它可以用 `-v` 调试选项来启用,它会告诉 shell 在读取时显示每行。

要展示这个如何工作,下面是一个示例脚本来[批量将 PNG 图片转换成 JPG 格式](/article-8014-1.html)。

将下面内容输入(或者复制粘贴)到一个文件中。

```

#!/bin/bash

#convert

for image in *.png; do

convert "$image" "${image%.png}.jpg"

echo "image $image converted to ${image%.png}.jpg"

done

exit 0

```

接着保存文件,并用下面的命令使脚本可执行:

```

$ chmod +x script.sh

```

我们可以执行脚本并显示它被 Shell 读取到的每一行:

```

$ bash -v script.sh

```

*显示shell脚本中的所有行*

### 在 Shell 脚本中启用语法检查调试模式

回到我们主题的重点,`-n` 激活语法检查模式。它会让 shell 读取所有的命令,但是不会执行它们,它(shell)只会检查语法。

一旦 shell 脚本中发现有错误,shell 会在终端中输出错误,不然就不会显示任何东西。

激活语法检查的命令如下:

```

$ bash -n script.sh

```

因为脚本中的语法是正确的,上面的命令不会显示任何东西。所以,让我们尝试删除结束 for 循环的 `done` 来看下是否会显示错误:

下面是修改过的含有 bug 的批量将 png 图片转换成 jpg 格式的脚本。

```

#!/bin/bash

#script with a bug

#convert

for image in *.png; do

convert "$image" "${image%.png}.jpg"

echo "image $image converted to ${image%.png}.jpg"

exit 0

```

保存文件,接着运行该脚本并执行语法检查:

```

$ bash -n script.sh

```

*检查 shell 脚本语法*

从上面的输出中,我们看到我们的脚本中有一个错误,for 循环缺少了一个结束的 `done` 关键字。shell 脚本从头到尾检查文件,一旦没有找到它(`done`),shell 会打印出一个语法错误:

```

script.sh: line 11: syntax error: unexpected end of file

```

我们可以同时结合 verbose 模式和语法检查模式:

```

$ bash -vn script.sh

```

*在脚本中同时启用 verbose 检查和语法检查*

另外,我们可以通过修改脚本的首行来启用脚本检查,如下面的例子:

```

#!/bin/bash -n

#altering the first line of a script to enable syntax checking

#convert

for image in *.png; do

convert "$image" "${image%.png}.jpg"

echo "image $image converted to ${image%.png}.jpg"

exit 0

```

如上所示,保存文件并在运行中检查语法:

```

$ ./script.sh

script.sh: line 12: syntax error: unexpected end of file

```

此外,我们可以用内置的 set 命令来在脚本中启用调试模式。

下面的例子中,我们只检查脚本中的 for 循环语法。

```

#!/bin/bash

#using set shell built-in command to enable debugging

#convert

#enable debugging

set -n

for image in *.png; do

convert "$image" "${image%.png}.jpg"

echo "image $image converted to ${image%.png}.jpg"

#disable debugging

set +n

exit 0

```

再一次保存并执行脚本:

```

$ ./script.sh

```

总的来说,我们应该保证在执行 Shell 脚本之前先检查脚本语法以捕捉错误。

请在下面的反馈栏中,给我们发送关于这篇指导的任何问题或反馈。在这个系列的第三部分中,我们会解释并使用 shell 追踪调试模式。

---

作者简介:

Aaron Kili 是一个 Linux 及 F.O.S.S 热衷者,即将是 Linux 系统管理员、web 开发者,目前是 TecMint 的内容创作者,他喜欢用电脑工作,并热心分享知识。

---

via: <http://www.tecmint.com/check-syntax-in-shell-script/>

作者:[Aaron Kili](http://www.tecmint.com/author/aaronkili/) 译者:[geekpi](https://github.com/geekpi) 校对:[jasminepeng](https://github.com/jasminepeng)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,047 | 双赢:开源 .Net ,微软收获了大批开发者 | http://www.cio.com/article/3150814/application-development/win-win-open-source-net-pays-off-for-devs.html | 2016-12-20T08:22:00 | [

"微软",

"开源",

".Net"

] | https://linux.cn/article-8047-1.html | 就在两年前,微软做了一件令人意想不到的事情:[它宣称将开源其 .Net 开发框架](/article-4209-1.html),这包括 [.Net Core](/article-4821-1.html) 及 [ASP.Net](/article-4940-1.html) 等。这份公告非常令人吃惊,因为微软长久以来一直仇视开源项目,担忧开源软件破坏其软件生态。

随着微软 CEO 纳德拉宣称“[微软爱 Linux](/article-4923-1.html)”,微软在[开源方面的举措频频](/article-6774-1.html),不仅仅在 GitHub 上其名下的几个[仓库活跃非凡](/article-7776-1.html),而且也和各种开源厂商积极[展开合作](/article-6528-1.html)。

不管微软积极拥抱开源背后的想法是什么,或许是想通过开源销售更多的软件或者云服务,也有可能是想吸引更多的开发者到微软平台上,但是目前看起来微软这步棋是下对了。从微软[开源 .Net](/article-6727-1.html) 和 [ASP.Net](/article-6921-1.html) 之后的分析看,微软的开源战略已经值回票价了。

微软现在将 .Net Core 定位为跨平台开发框架,不只是 Windows,而且也延伸到了 MacOS 和 Linux 平台之上。.Net Core RC1 是 2015 年 11 月发布到 GitHub 上的,而今年 6 月就发布了 1.0 版本。开发者们对此表示认可,微软合作伙伴总监项目经理 Scott Hunter 如是说:

>

> “40% 的 .Net Core 客户是新进入该平台的用户,这就是我们(开源)的目的,我们希望吸引新的用户。”

>

>

>

由于 .Net Core 的开源,过去一年以来, .Net 的开发者增加了 61%。 Hunter 在 11 月的一次讲演中提到,GitHub 上 .Net 上的开发活跃度增长极快。

虽然 .Net Core 并没有直接给微软带来收入,但是其潜在地增加了收益。Rob Sanfilippo 说,“可以说,这项技术间接地通过 Azure 服务和微软开发者工具增加了微软的收入。”。

### 程序员们表现活跃

.Net 程序员和博客作者 [Matt Warren](http://mattwarren.org/) 把.Net 的开源称之为“成功”。[其数据](/article-6921-1.html)明确地显示社区积极地参与了微软在 GitHub 上开源的多个仓库的活动。

“开源社区汇报了问题和建议,并通过发送拉取请求(PR)而实际贡献了代码,经过一段时间之后,这些代码就会被包括到产品里面,而社区的贡献量还在持续增长”,Warren 说,“我积极跟踪和参与了 [CoreCLR](https://github.com/dotnet/coreclr/) 和 [.Net Core Lab](https://github.com/dotnet/corefxlab/) 这些仓库的讨论,因此获得了社区贡献的第一手资料。”

微软的举措是否完全成功还不能完全定论,未来或许还有变数,但是这终究是从封闭走向开放的一步。他说,“我的意思是,他们并不是仅仅把源代码放在那里就行了,而是努力让社区可以参与进来。”

### 微软最近发布的 Visual Studio for Mac 也为 .Net Core 带来了利好

“这是 Visual Studio IDE 首次发布到非 Windows 平台上(Visual Studio Code 是不同的技术,而且它根本不算 IDE),它是基于微软收购的 Xamarin 的技术,重点关注于 .Net Core 开发”,Sanfillippo 说,“这次发布近一步带动了 .Net Core 的发展。”

微软最近也准备在 Visual Studio 2017 IDE 中增强 .Net Core 工具,包括简化 .Net Core 项目文件的格式。

微软开源 .Net 让外界对它的观感有所改变, Warren 说,“现在感觉(微软)更开放和更平易近人了。”

相对于某些公司,虽然开源社区还对微软抱有一定的疑虑,但是显然,微软已经不是开源社区最敌视的公司了。

参考:[CIO](http://www.cio.com/article/3150814/application-development/win-win-open-source-net-pays-off-for-devs.html)、 [Matt Warren](http://mattwarren.org/)、[microsoft](https://www.microsoft.com/)

| 301 | Moved Permanently | null |

8,048 | CentOS 7.3 安装指南 | http://www.tecmint.com/centos-7-3-installation-guide/ | 2016-12-20T09:12:00 | [

"CentOS"

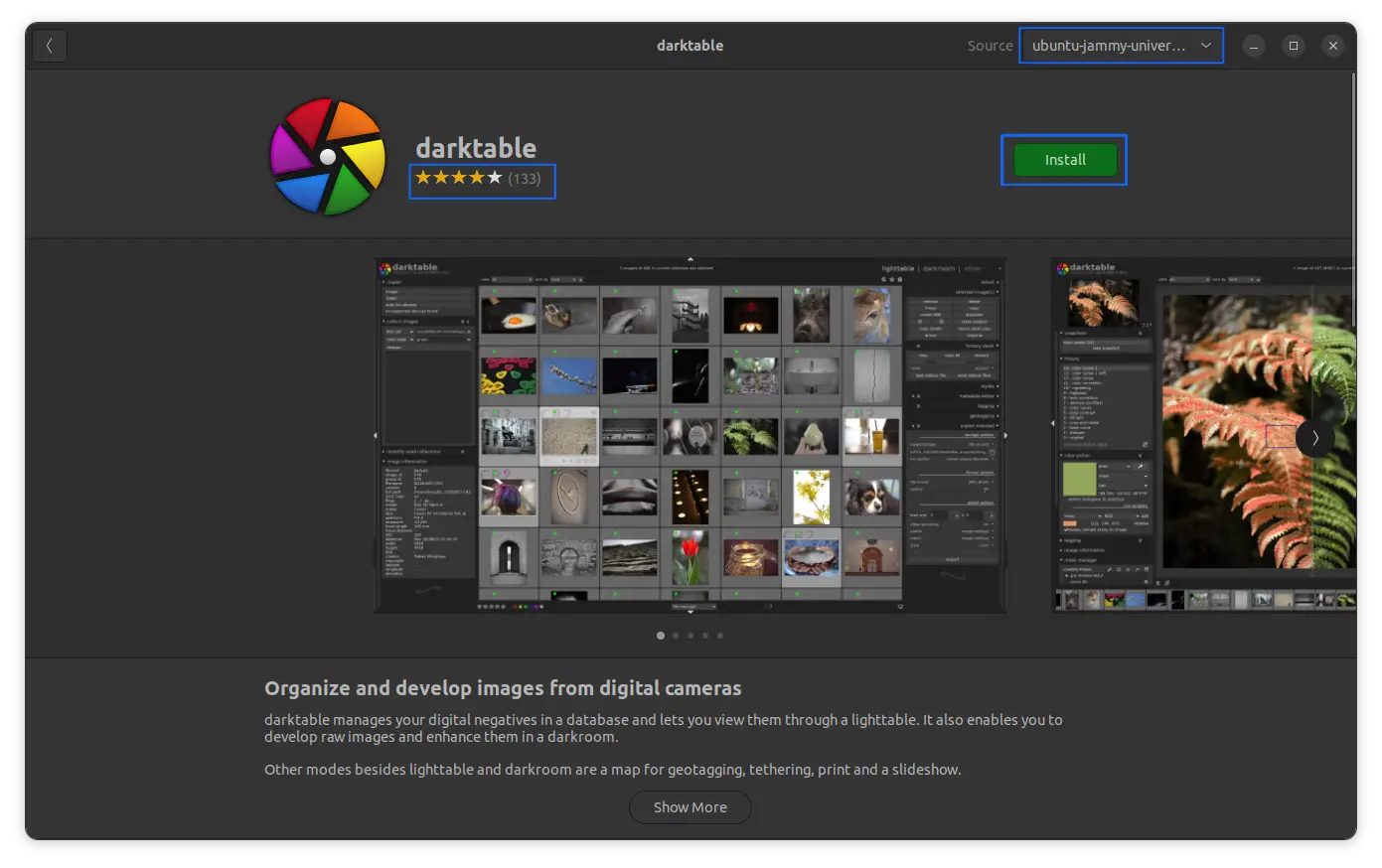

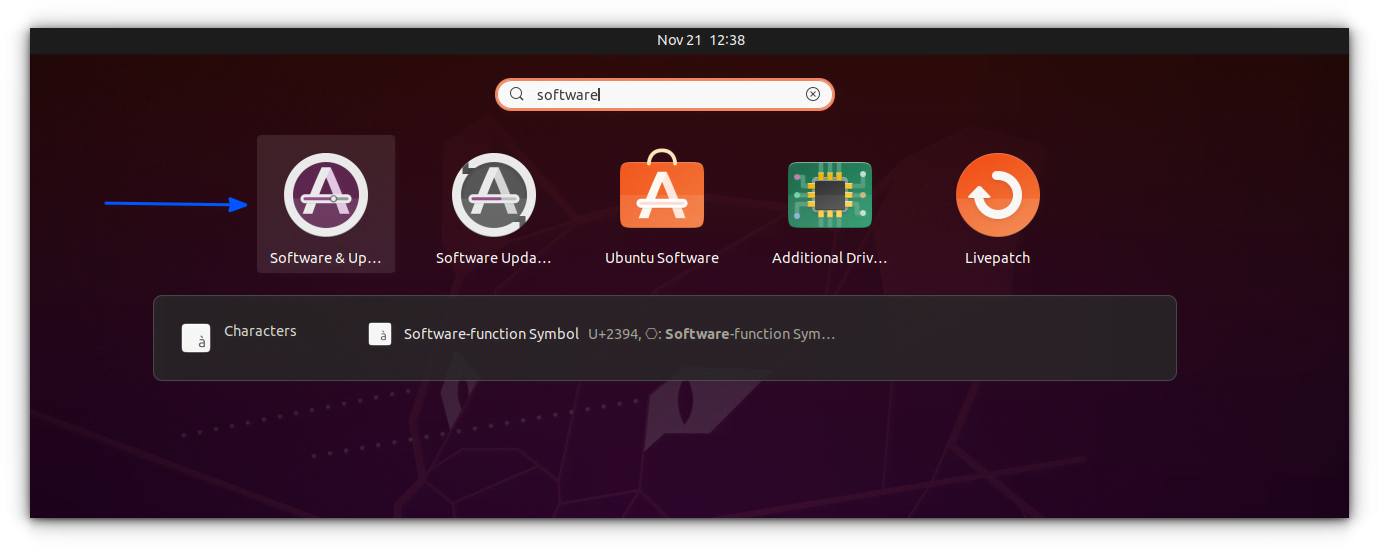

] | https://linux.cn/article-8048-1.html | 基于 Red Hat 企业版的源代码的最新版本的 CentOS 7 在今年的 12月[发布了 CentOS Linux 7 (1611)](/article-8046-1.html#3_1420) ,包含了许多 bug 修复、新的包更新,比如 Samba、Squid、libreoffice、SELinux、systemd 及其它软件,并支持第七代 Intel 酷睿 i3、i5、i7 处理器。

本指南会向你展示如何在 UEFI 的机器上使用 DVD ISO 镜像来安装 CentOS 7.3。

如果你要是用 RHEL,看下我们的 [RHEL 7.3 安装指南](/article-8067-1.html)。

#### 要求

* [下载 CentOS 7.3 ISO 镜像](http://isoredirect.centos.org/centos/7/isos/x86_64/CentOS-7-x86_64-DVD-1611.iso)

要在 UEFI 的机器上正确安装 CentOS 7.3,首先按下键(`F2`、`F11` 或 `F12`,取决与你的主板类型)进入主板的 UEFI 设置,并且确保 QuickBoot/FastBoot 以及 Secure Boot 已被禁用。

### CentOS 7.3 安装

1、 在你从上面的链接下载完成镜像之后,使用 [Rufus](https://rufus.akeo.ie/)将它烧录到 DVD 或者创建一个可启动的 UEFI 兼容 USB 盘。

将 USB/DVD 放入主板上连接的驱动器中,重启电脑并用特定的功能键(`F12`、 `F10`,取决于主板类型)让 BIOS/UEFI 从 DVD/USB 启动。

ISO 镜像启动完成后,你机器上会显示如下首屏。在菜单中选择 “Install CentOS 7”并按下回车继续。

*CentOS 7.3 启动菜单*

2、 在安装镜像加载到内存完成后,会显示一个欢迎页面。选择你在安装中使用的语言并按下“<ruby> 继续 <rp> ( </rp> <rt> Continue </rt> <rp> ) </rp></ruby>”按钮。

*选择 CentOS 7.3 安装语言*

3、 在下一个页面点击“<ruby> 日期和时间 <rp> ( </rp> <rt> Date and Time </rt> <rp> ) </rp></ruby>”,从地图中选择你的地理位置。确认日期和时间正确配置了并点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮来回到主安装界面。

*CentOS 7.3 安装总结*

*选择日期和时间*

4、 点击“<ruby> 键盘 <rp> ( </rp> <rt> Keyboard </rt> <rp> ) </rp></ruby>”菜单进入键盘布局页面。选择或者添加一个键盘布局并点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮继续。

*选择键盘布局*

5、 接下来,为你的系统添加或者配置一个语言并点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮进入下一步。

*选择语言支持*

6、 在这步中,你可以通过选择列表中安全配置来设置你的系统“<ruby> 安全策略 <rp> ( </rp> <rt> Security Policy </rt> <rp> ) </rp></ruby>”。

点击选择配置按钮来选择你想要的安全配置并点击“<ruby> 应用安全策略 <rp> ( </rp> <rt> Apply security policy </rt> <rp> ) </rp></ruby>”按钮到 On。点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮后继续安装流程。

*启用 CentOS 7.3 安全策略*

7、 下一步中你可以点击“<ruby> 软件选择 <rp> ( </rp> <rt> Software Selection </rt> <rp> ) </rp></ruby>”按钮来配置你的基础机器环境。

左边的列表是你可以选择安装桌面环境(Gnome、KDE Plasma 或者创意工作站)或者安装一个服务器环境(Web 服务器、计算节点、虚拟化主机、基础设施服务器、带图形界面的服务器或者文件及打印服务器)或者执行一个最小化的安装。

为了随后能自定义你的系统,选择最小化安装并附加兼容库,点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮继续。

*CentOS 7.3 软件选择*

对于完整的 Gnome 或者 KDE 桌面环境,使用下面的截图作为指引。

*Gnome 桌面软件选择*

*KDE 桌面软件选择*

8、 假设你要在服务器上安装一个图形界面,选择左边那栏“<ruby> 带 GUI 的服务器 <rp> ( </rp> <rt> Server with GUI </rt> <rp> ) </rp></ruby>”那项,并在右边那栏中根据你需要提供给客户端的服务选择合适的附加软件。

你可以选择的服务是非常多样化的,从备份、DNS 或者 e-mail 服务到文件存储服务、FTP、HA 或者监控工具。只选择对你网络设置最重要的服务。

*选择带 GUI 的服务器*

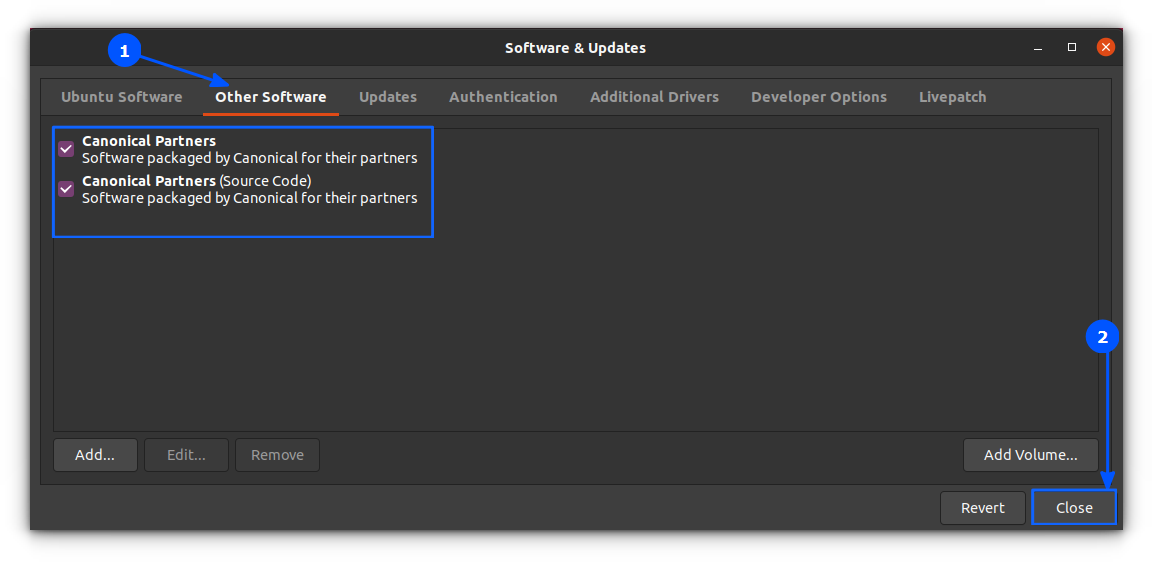

9、 如果你不使用特定的网络协议比如 HTTP、HTTPS、FTP 或者 NFS 的额外仓库,安装源保持默认,并点击“<ruby> 安装位置 <rp> ( </rp> <rt> Installation Destination </rt> <rp> ) </rp></ruby>”来创建一个磁盘分区。

在“<ruby> 设备选择 <rp> ( </rp> <rt> Device selection </rt> <rp> ) </rp></ruby>”页面,确保你已经选择了本地磁盘。同样,在“<ruby> 其他存储选项 <rp> ( </rp> <rt> Other Storage Options </rt> <rp> ) </rp></ruby>”中确保选择了“<ruby> 自动配置分区 <rp> ( </rp> <rt> Automatically configure partitioning </rt> <rp> ) </rp></ruby>”。

这个选项可以确保你的磁盘会恰当地根据磁盘空间和 Linux 文件系统层次结构进行分区。它会为你自动创建 `/(root)`、`/home`和 swap 分区。点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”来应用磁盘分区方案并回到主安装界面。

重要提醒:如果你想要创建自定义分区及自定义分区大小,你可以选择“<ruby> 我要配置分区 <rp> ( </rp> <rt> I will configure partitioning </rt> <rp> ) </rp></ruby>”选项来创建自定义分区。

*安装 CentOS 7.3 安装位置*

10、 接下来,如果你想要释放系统内存,点击 KDUMP 选项并禁用它。点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”并回到主安装界面。

*Kdump 选择*

11、 在下一步中设置你的主机名并启用网络服务。点击“<ruby> 网络和主机名 <rp> ( </rp> <rt> Network & Hostname </rt> <rp> ) </rp></ruby>”,在主机名中输入你的 FQDN(完整限定网域名称),如果你在局域网中有一个 DHCP 服务器,将以太网按钮从 OFF 切换到 ON 来激活网络接口。

*设置网络及主机名*

12、 为了静态配置你的网络接口,点击“<ruby> 配置 <rp> ( </rp> <rt> Configure </rt> <rp> ) </rp></ruby>”按钮,手动如截图所示添加 IP 设置,并点击“<ruby> 保存 <rp> ( </rp> <rt> Save </rt> <rp> ) </rp></ruby>”按钮来应用更改。完成后,点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮来回到主安装菜单。

*配置网络和 IP 地址*

13、 最后检查下所有到目前为止的配置,如果一切没问题,点击“<ruby> 开始安装 <rp> ( </rp> <rt> Begin Installation </rt> <rp> ) </rp></ruby>”按钮开始安装。

*开始 CentOS 7.3 安装向导*

14、 开始安装后,一个新的设置用户界面会显示出来。首先点击 “<ruby> root 密码 <rp> ( </rp> <rt> ROOT PASSWORD </rt> <rp> ) </rp></ruby>”并添加一个强密码。

root 账户是每个 Linux 系统的最高管理账户密码,它拥有所有的权限。设置完成后点击完成按回到用户设置界面。

*选择 root 密码*

*设置 root 密码*

15、 用 root 账户运行系统是非常不安全和危险的,因此建议你点击“<ruby> 创建用户 <rp> ( </rp> <rt> User Creation </rt> <rp> ) </rp></ruby>”按钮创建一个新的系统账户来[执行每日的系统任务](http://www.tecmint.com/file-and-directory-management-in-linux/)。

添加新的用户,并同时选择下面的两个选项来授予用户 root 权限以及每次在登录系统时手动输入密码。

当你完成最后一项点击“<ruby> 完成 <rp> ( </rp> <rt> Done </rt> <rp> ) </rp></ruby>”按钮并等待安装完成。

*创建用户账户*

16、 几分钟后安装程序会报告 CentOS 已经成功安装在你机器中。要使用系统,你只需要移除安装媒介并重启机器。

*CentOS 7.3 安装完成*

17、 重启之后,使用安装中创建的用户登录系统,并且用 root 权限执行下面的命令来执行系统更新。

```

$ sudo yum update

```

*更新 CentOS 7.3*

所有 [yum 管理器](http://www.tecmint.com/20-linux-yum-yellowdog-updater-modified-commands-for-package-mangement/)的问题都选择`yes`,最后再次重启电脑(使用 `sudo init 6`)来应用新的内核升级。

```

$ sudo init 6

```

就是这样!在你的机器中享受最新的 CentOS 7.3 吧。

---

作者简介:

Matei Cezar

我是一个电脑上瘾的家伙,一个开源和 Linux 系统软件的粉丝,有大约 4 年的 Linux 桌面、服务器和 bash 脚本的经验。

---

via: <http://www.tecmint.com/centos-7-3-installation-guide/>

作者:[Matei Cezar](http://www.tecmint.com/author/cezarmatei/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,049 | Ubuntu 调查发现,大部分人从不更新他们的物联网设备 | https://insights.ubuntu.com/2016/12/15/research-consumers-are-terrible-at-updating-their-connected-devices/ | 2016-12-20T09:23:29 | [

"IoT",

"固件",

"安全"

] | https://linux.cn/article-8049-1.html | 许多物联网设备的用户鲜于更新他们的联网设备,而这正是造成许多物联网安全漏洞的根本原因。

Ubuntu 最近调查了 2000 名消费者以了解其是如何使用他们的联网设备的。该调查结果披露了令人吃惊的结果,仅有 31% 的人会在设备有固件更新后尽快进行更新,而近 40% 的人则从不会主动对设备固件进行更新!换句话说,这部分用户让他们的设备开着,暴露在 DDoS 和各种窃取隐私的攻击之下。

消费者们不能(也不应该)预料到每个重要的软件更新,虽然这很简单,但是并不现实。几乎没有消费者会去专门看看他们遇到的问题是否解决了。根据投票结果,近 2/3 的消费者认为更新固件不是他们的责任,22% 的人认为这是软件开发者的工作,而 18% 的人认为这是设备厂商的责任。

显然,自动更新是一个解决方案,但是自动更新也会带来一些安全隐患。而且,很多厂商很少更新他们的设备固件,尤其是比较老的设备,更是更新频度极少。

那么你对物联网设备安全及设备固件更新方面有什么看法?

| 301 | null |

|

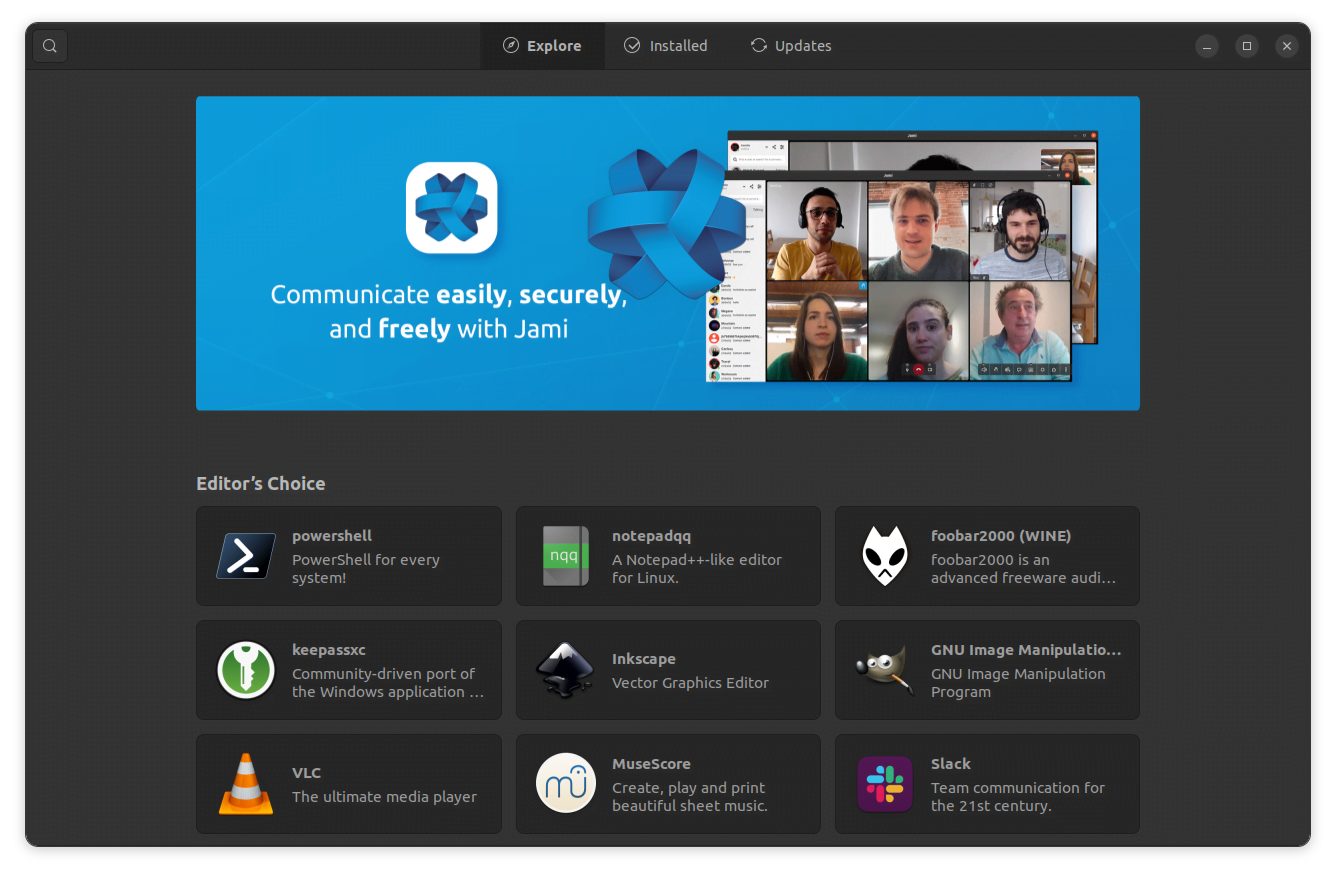

8,050 | 24 款必备的 Linux 桌面应用(2016 版) | https://itsfoss.com/essential-linux-applications | 2016-12-21T08:41:00 | [

"Linux",

"软件",

"桌面"

] | https://linux.cn/article-8050-1.html |

>

> 摘要:Linux 的必备软件有哪些?这将会是一个非常主观的回答,主要取决于你出于什么目的才使用桌面版 Linux。不过有一些必备的 Linux 桌面应用是大部分 Linux 用户都可能会用到的,这里将会列出不管在哪个发行版中你都应该安装的 Linux 桌面应用。

>

>

>

在 Linux 中,所有的一切都有多种可选方案的。首先,你会选择一个发行版,对吧?你可能需要尝试过多个发行版才能选出自己喜欢的风味。你是否还试过很多个音乐播放器?它们还是有很多选择的吧?

但并不是所有的这些应用都一样——有些以简洁为目标,而另一些则可能会提供大量的特性。根据自身的需求选择一款正确的应用也是一件相当困惑和累人的任务。就让我们来使这个过程变得容易一些吧。

### Linux 用户最好的自由软件

在这里,我把自己喜欢用的 Linux 必备软件以几个类型列出来。当然不能说这些是最好的,但在我尝试了大量的各类软件之后,最后才得到这个分类列表。所以,非常欢迎你在评论区畅言自己最喜欢的应用。

### Web浏览器

*Web 浏览器*

#### [Google Chrome](https://www.google.com/chrome/browser)

Google Chrome 是一个功能完备、性能强悍的 web 浏览器。它具备了非常彪悍的同步功能,同时还提供大量的功能扩展插件。如果那你习惯于 Google 的软件生态,那么 Chrome 绝对是你的不二选择。当然,假如你想要一个开源的解决方案,那么你可以试试 [Chromium](https://www.chromium.org/Home),Google Chrome 就是基于 Chromium 构建的。

#### [Firefox](https://www.mozilla.org/en-US/firefox)

如果你并非 Google Chrome 迷,那就试试 Firefox。它有着比较久的历史,也是一个稳定而健壮的 web 浏览器。

#### [Vivaldi](https://vivaldi.com/)

如果说你想尝试新鲜事物并做一些改变,那么,你可以试试 Vivaldi,它为 web 浏览器带来了全新的使用方式,由前 Opera 项目成员基于 Chromium 项目开发。它开源、轻量级,同时不失定制性。尽管它还很年轻,缺少一些特性,但真的让人感觉清爽,可以完成你绝大多数的工作。

推荐阅读:[Otter 浏览器给 Opera 粉丝带来希望](https://itsfoss.com/otter-browser-review/)

### 下载管理器

*下载管理器*

#### [Uget](http://ugetdm.com/)

Uget 是我见过最好的下载管理器了。其源码是开放的,同时提供给你在下载浏览器中所想到的一切功能。其中,高级设置选项可以用来更好的管理下载。它支持排队下载和断点下载、支持多连接来下载大体积文件、支持通过不同分类来下载到不同目录等等。

#### [Xdm](http://xdman.sourceforge.net/)

Xdm (Xtreme Download Manager,极限下载管理器) 是一款用 Java 开发的功能强大且开源的工具。有着所有下载管理器的必备功能,包括:视频捕获器、智能调度和浏览器集成。

推荐阅读:[Linux 下 4 个最佳下载管理器](https://itsfoss.com/4-best-download-managers-for-linux/)

### BitTorrent 客户端

*BitTorrent 客户端*

#### [Deluge](http://deluge-torrent.org/)

Deluge 是一个开源的 BitTorrent 客户端,有着漂亮的用户界面。假如你习惯使用 Windows 下的 uTorrent,你就会知道两者有着很多的相似之处。它有大量的配置选项和插件来帮你应付各种下载任务。

#### [Transmission](https://transmissionbt.com/)

Transmission 是最轻量级的 Bittorrent 客户端——开源、有着最轻量级的用户界面。在多数的 Linux 发行版中都预装了 Transmission。

推荐阅读:[Ubuntu 下五个最好的 BT 客户端](/article-6095-1.html)

### 云存储

*云存储*

#### [Dropbox](https://www.dropbox.com/)

Dropbox 是目前最流行云存储服务之一。你注册之后就有 2 GB 的免费空间。Dropbox 提供了一个健壮而简洁的 Linux 客户端。

#### [Mega](https://mega.nz/)

Mega 提供了 50 GB 的免费空间,但其最好的一点却非免费空间之大,而是它为你的文件传输提供了点对点加密。它在 Linux 平台上也有一个可靠的客户端,名为 MEGAsync。

推荐阅读:[Linux 下最佳免费云服务](https://itsfoss.com/cloud-services-linux/)

### 即时消息软件

*即时消息软件*

#### [Pidgin](https://www.pidgin.im/)

Pidgin 是一个开源的即时消息客户端,支持多个聊天平台,包括 Facebook、Google Talk、Yahoo,甚至是 IRC。它还可以通过第三方插件来进行扩展,这样可以把很多功能集成到 Pidgin 中去。

#### [Skype](https://www.skype.com/)

我想,应该所有人都知道 Skype 吧,它是目前最流行的视频聊天平台。近期,它又为 Linux 平台[发布了一个全新的桌面客户端](/article-7574-1.html)。

推荐阅读:[Linux 上的最佳消息应用](https://itsfoss.com/best-messaging-apps-linux/)

### 办公套件

*办公套件*

#### [LibreOffice](https://www.libreoffice.org/)

LibreOffice 是 Linux 平台下开发活跃度最高的开源办公套件。它有六大核心模块:Writer (文字处理)、Calc (电子表格)、Impress (文稿演示)、Draw (图像绘制)、Math (数学公式)、Base (数据库),并且,这些模块都支持多种文件格式。当然,LibreOffice 也是支持第三方扩展的,多数的 Linux 发行版都用它作为默认的办公套件。

#### [WPS Office](https://www.wps.com/)

如果想要尝试 LibreOffice 之外的办公套件,WPS Office 当然是不容错过的,它支持 Writer (文字处理)、presentation (文稿演示)、spreadsheets (电子表格)。

推荐阅读:[微软 Office 办公套件的最佳开源替代品](https://itsfoss.com/best-free-open-source-alternatives-microsoft-office/)

### 音乐播放器

*音乐播放器*

#### [Lollypop](http://gnumdk.github.io/lollypop-web/)

这是一个相对较新的音乐播放器。Lollypop 是开源的,有着非常漂亮的用户界面,提供了非常友好的歌曲管理、播放历史支持、在线电台和派对模式。尽管这是一个很简单的音乐播放器,没有太多的高级特性,但还是值得一试的。

#### [RhythmBox](https://wiki.gnome.org/Apps/Rhythmbox)

Rhythmbox 最初是为 Gnome 开发的音乐播放器,但现在已经可以很好的在其他的桌面环境中工作。它可以完成音乐播放器的所有基本任务,包括 CD 转录 & 刻录、播放历史等,而且还支持 iPod。

#### [CMUS](https://cmus.github.io/)

假如你是极简主义派,并深爱着终端界面,那么 cmus 很合适你。就个人而言,我很喜欢并一直在用这个软件。它是类 Unix 平台下一个相当小巧、响应速度快、有着功能强大的控制台音乐播放器,具备了音乐播放器所有基本特性。通过其它的扩展和脚本,你可以使它功能更加丰富。

推荐阅读:[在 Ubuntu 14.04 和 Linux Mint 17 安装 Tomahawk 播放器](https://itsfoss.com/install-tomahawk-ubuntu-1404-linux-mint-17/)

### 视频播放器

*视频播放器*

#### [VLC](http://www.videolan.org/)

VLC 是一个开源的媒体播放器,具有简洁、速度快、轻量级而功能强大等特点。它做到了真正的开箱即用,几乎支持所有你想到的视频格式,而且可以播放在线流媒体。当然,它支持一些非常棒的插件来完成不同的任务,比方说在播放视频时下载对应的字幕。

#### [Kodi](https://kodi.tv/)

Kodi 是一个功能完备的媒体播放器,开源并流行于其用户群体中。它可以处理本地或者网络存储中的视频、音乐、图片、播客甚至是游戏,你还有使用它来录制 TV。Kodi 可以通过附件和不同的皮肤来自定义。

推荐阅读:[Linux 上的 4 种格式转换器](https://itsfoss.com/format-factory-alternative-linux/)

### 图像编辑器

*图像编辑器*

#### [GIMP](https://www.gimp.org/)

GIMP 是 Linux 平台下 Photoshop 的替代方案。它是开源的,是一个全功能、专业的图像编辑软件,打包了非常多的工具用来处理各类图像。在此基础上,还有大量的定制选项以及第三方插件可以用于增强用户的使用体验。

#### [Krita](https://krita.org/en/)

Krita 主要是一个绘图工具,但也可以用来编辑图像。它同样也是开源的,也打包了很多精致且高级的工具。

推荐阅读:[Linux 上最佳图像应用](https://itsfoss.com/image-applications-ubuntu-linux/)

### 文本编辑器