code

stringlengths 30

403k

| size

int64 31

406k

| license

stringclasses 10

values |

|---|---|---|

##Union Find

###Basic Java Model

优化前合并与查找时间复杂度都是O(n)

Compressed path优化后 都是O(1)

union find不支持删除操作

###Implementation

```java

class UnionFind{

/*

用数组或者hashmap都可以

*/

HashMap<Integer, Integer> hashmap = new HashMap<Integer, Integer>();

UnionFind(HashSet<Integer> hashSet){

for(Integer now : hashSet) {

hashmap.put(now, now);

}

}

int find(int x){

/*

当没找到自己是根节点的时候,就继续深度遍历进入曾祖父找,直到找到最后的根节点

*/

int parent = hashmap.get(x);

while(parent!=hashmap.get(parent)) {

parent = hashmap.get(parent);

}

return parent;

}

int compressed_find(int x){

int parent = hashmap.get(x);

while(parent!=hashmap.get(parent)) {

parent = hashmap.get(parent);

}

int temp = -1;

int fa = hashmap.get(x);

while(fa!=hashmap.get(fa)) {

temp = hashmap.get(fa);

hashmap.put(fa, parent) ;

fa = temp;

}

return parent;

}

void union(int x, int y){

int root_x = find(x);

int root_y = find(y);

if(root_x != root_y) {

hashmap.put(root_x, root_y);

}

}

}

```

###题目参考

- Find the Weak Connected Component in the Directed Graph

###课件参考

###Better Solution

#### just change the root of p to q, not every element to q

###Still two ways to better to improve

#### 1: Weighted quick-union

#### 2: Path Compression

####Summary

| 1,770 | MIT |

次に、登録を試みる前にユーザーが認証されるように、プッシュ通知を登録する方法を変更する必要があります。

1. Visual Studio のソリューション エクスプローラーで、**Application\_Launching** イベント ハンドラー内の app.xaml.cs プロジェクト ファイルを開き、**AcquirePushChannel** メソッドの呼び出しをコメントアウトまたは削除します。

2. **AcquirePushChannel** メソッドへのアクセス制限を `private` から `public` に変更し、`static` 修飾子を追加します。

3. MainPage.xaml.cs プロジェクト ファイルを開き、**OnNavigatedTo** メソッドのオーバーライドを次のコードに置き換えます。

protected override async void OnNavigatedTo(NavigationEventArgs e)

{

await AuthenticateAsync();

App.AcquirePushChannel();

RefreshTodoItems();

}

<!---HONumber=Oct15_HO3--> | 619 | CC-BY-3.0 |

---

title: 教程:创建使用 Microsoft 标识平台进行身份验证的 Android 应用 | Azure

titleSuffix: Microsoft identity platform

description: 在本教程中,我们生成一个使用 Microsoft 标识平台登录用户的 Android 应用,并获取访问令牌以代表用户调用 Microsoft Graph API。

services: active-directory

author: mmacy

manager: CelesteDG

ms.service: active-directory

ms.subservice: develop

ms.topic: tutorial

ms.workload: identity

ms.date: 11/26/2019

ms.author: hahamil

ms.reviewer: brandwe

ms.custom: aaddev, identityplatformtop40

ms.openlocfilehash: 7d297d96ba764c812a3d4db6d9383122c73cfe31

ms.sourcegitcommit: 126ee1e8e8f2cb5dc35465b23d23a4e3f747949c

ms.translationtype: HT

ms.contentlocale: zh-CN

ms.lasthandoff: 02/10/2021

ms.locfileid: "100103135"

---

# <a name="tutorial-sign-in-users-and-call-the-microsoft-graph-api-from-an-android-application"></a>教程:从 Android 应用程序登录用户并调用 Microsoft Graph API

在本教程中,你要构建一个与 Microsoft 标识平台集成的 Android 应用,用户可登录该应用并获取访问令牌以调用 Microsoft Graph API。

完成本教程后,应用程序将接受个人 Microsoft 帐户(包括 outlook.com、live.com 和其他帐户)进行登录,还能够接受使用 Azure Active Directory 的任何公司或组织的工作或学校帐户进行登录。

在本教程中:

> [!div class="checklist"]

> * 在 Android Studio 中创建 Android 应用项目

> * 在 Azure 门户中注册应用

> * 添加代码以支持用户登录和注销

> * 添加代码以调用 Microsoft Graph API

> * 测试应用程序

## <a name="prerequisites"></a>先决条件

* Android Studio 3.5+

## <a name="how-this-tutorial-works"></a>本教程工作原理

本教程中的应用会将用户登录并代表他们获取数据。 该数据可通过一个受保护的 API (Microsoft 图形 API) 进行访问,该 API 需要授权并且受 Microsoft 标识平台保护。

更具体说来:

* 你的应用将通过浏览器或 Microsoft Authenticator 和 Intune 公司门户登录用户。

* 最终用户将接受应用程序请求的权限。

* 将为你的应用颁发 Microsoft Graph API 的一个访问令牌。

* 该访问令牌将包括在对 Web API 的 HTTP 请求中。

* 处理 Microsoft Graph 响应。

该示例使用适用于 Android 的 Microsoft 身份验证库 (MSAL) 来实现身份验证:[com.microsoft.identity.client](https://javadoc.io/doc/com.microsoft.identity.client/msal)。

MSAL 将自动续订令牌,在设备上的其他应用之间提供单一登录 (SSO),并管理帐户。

本教程演示简化的示例,介绍如何使用适用于 Android 的 MSAL。 为简单起见,本教程仅使用“单帐户模式”。 若要探索更复杂的场景,请参阅 GitHub 上已完成的[工作代码示例](https://github.com/Azure-Samples/ms-identity-android-java/)。

## <a name="create-a-project"></a>创建一个项目

如果你还没有 Android 应用程序,请按照以下步骤设置新项目。

1. 打开 Android Studio,然后选择“启动新的 Android Studio 项目” 。

2. 选择“基本活动”,再选择“下一步” 。

3. 命名应用程序。

4. 保存包名称。 以后需将它输入 Azure 门户中。

5. 将语言从“Kotlin” 更改为“Java” 。

6. 将“最低 API 级别” 设置为 **API 19** 或更高,然后单击“完成”。

7. 在项目视图的下拉列表中选择“项目” ,以便显示源和非源的项目文件,然后打开 **app/build.gradle**,将 `targetSdkVersion` 设置为 `28`。

## <a name="integrate-with-the-microsoft-authentication-library"></a>与 Microsoft 身份验证库集成

### <a name="register-your-application"></a>注册应用程序

1. 登录 <a href="https://portal.azure.com/" target="_blank">Azure 门户</a>。

1. 如果有权访问多个租户,请使用顶部菜单中的“目录 + 订阅”筛选器:::image type="icon" source="./media/common/portal-directory-subscription-filter.png" border="false":::,选择要在其中注册应用程序的租户。

1. 搜索并选择“Azure Active Directory” 。

1. 在“管理”下,选择“应用注册” > “新建注册” 。

1. 输入应用程序的 **名称**。 应用的用户可能会看到此名称,你稍后可对其进行更改。

1. 选择“注册” 。

1. 在“管理”下,选择“身份验证” > “添加平台” > “Android” 。

1. 输入项目的包名称。 如果下载了代码,则该值为 `com.azuresamples.msalandroidapp`。

1. 在“配置 Android 应用”页的“签名哈希”部分,选择“生成开发签名哈希”。 然后复制用于平台的 KeyTool 命令。

安装 KeyTool.exe,使其作为 Java 开发工具包 (JDK) 的一部分。 还必须安装 OpenSSL 工具才能执行 KeyTool 命令。 有关详细信息,请参阅[有关如何生成密钥的 Android 文档](https://developer.android.com/studio/publish/app-signing#generate-key)。

1. 生成由 KeyTool 生成的 **签名哈希**。

1. 选择“配置”并保存出现在“Android 配置”页中的“MSAL 配置”,以便在稍后配置应用时输入它 。

1. 选择“完成”。

### <a name="configure-your-application"></a>配置应用程序

1. 在 Android Studio 的项目窗格中,导航到 **app\src\main\res**。

1. 右键单击“res” ,选择“新建” > “目录”。 输入 `raw` 作为新目录名称,然后单击“确定”。

1. 在 **app** > **src** > **main** > **res** > **raw** 中,新建名为 `auth_config_single_account.json` 的 JSON 文件,然后粘贴以前保存的 MSAL 配置。

在“重定向 URI”下方,粘贴:

```json

"account_mode" : "SINGLE",

```

配置文件应与如下示例类似:

```json

{

"client_id" : "0984a7b6-bc13-4141-8b0d-8f767e136bb7",

"authorization_user_agent" : "DEFAULT",

"redirect_uri" : "msauth://com.azuresamples.msalandroidapp/1wIqXSqBj7w%2Bh11ZifsnqwgyKrY%3D",

"broker_redirect_uri_registered" : true,

"account_mode" : "SINGLE",

"authorities" : [

{

"type": "AAD",

"audience": {

"type": "AzureADandPersonalMicrosoftAccount",

"tenant_id": "common"

}

}

]

}

```

本教程仅演示如何在单帐户模式下配置应用。 查看文档,详细了解[单帐户模式与多帐户模式](./single-multi-account.md)以及[配置应用](./msal-configuration.md)

4. 在 **app** > **src** > **main** > **AndroidManifest.xml** 中,将以下 `BrowserTabActivity` 活动添加到应用程序主体。 该条目允许 Microsoft 在完成身份验证后回调应用程序:

```xml

<!--Intent filter to capture System Browser or Authenticator calling back to our app after sign-in-->

<activity

android:name="com.microsoft.identity.client.BrowserTabActivity">

<intent-filter>

<action android:name="android.intent.action.VIEW" />

<category android:name="android.intent.category.DEFAULT" />

<category android:name="android.intent.category.BROWSABLE" />

<data android:scheme="msauth"

android:host="Enter_the_Package_Name"

android:path="/Enter_the_Signature_Hash" />

</intent-filter>

</activity>

```

将 `android:host=` 值替换为在 Azure 门户中注册的包名称。

将 `android:path=` 值替换为在 Azure 门户中注册的密钥哈希。 签名哈希不应进行 URL 编码 。 确保签名哈希的开头有前导 `/`。

将用来替换 `android:host` 值的“包名称”应类似于:“com.azuresamples.msalandroidapp”。

将用来替换 `android:path` 值的“签名哈希”应类似于:“/1wIqXSqBj7w+h11ZifsnqwgyKrY=”。

还可以在应用注册的“身份验证”边栏选项卡中找到这些值。 请注意,重定向 URI 将如下所示:“msauth://com.azuresamples.msalandroidapp/1wIqXSqBj7w%2Bh11ZifsnqwgyKrY%3D”。 尽管签名哈希会在此值末尾进行 URL 编码,但签名哈希不应在 `android:path` 值中进行 URL 编码 。

## <a name="use-msal"></a>使用 MSAL

### <a name="add-msal-to-your-project"></a>将 MSAL 添加到项目

1. 在 Android Studio 项目窗口中,导航到 app > src > build.gradle,然后添加以下内容 :

```gradle

repositories{

jcenter()

}

dependencies{

implementation 'com.microsoft.identity.client:msal:2.+'

implementation 'com.microsoft.graph:microsoft-graph:1.5.+'

}

packagingOptions{

exclude("META-INF/jersey-module-version")

}

```

[有关 Microsoft Graph SDK 的详细信息](https://github.com/microsoftgraph/msgraph-sdk-java/)

### <a name="required-imports"></a>要求的导入

将以下内容添加到 app > src > main> java > com.example(yourapp) > MainActivity.java 的顶部

```java

import android.os.Bundle;

import android.util.Log;

import android.view.View;

import android.widget.Button;

import android.widget.TextView;

import android.widget.Toast;

import androidx.annotation.NonNull;

import androidx.annotation.Nullable;

import androidx.appcompat.app.AppCompatActivity;

import com.google.gson.JsonObject;

import com.microsoft.graph.authentication.IAuthenticationProvider; //Imports the Graph sdk Auth interface

import com.microsoft.graph.concurrency.ICallback;

import com.microsoft.graph.core.ClientException;

import com.microsoft.graph.http.IHttpRequest;

import com.microsoft.graph.models.extensions.*;

import com.microsoft.graph.requests.extensions.GraphServiceClient;

import com.microsoft.identity.client.AuthenticationCallback; // Imports MSAL auth methods

import com.microsoft.identity.client.*;

import com.microsoft.identity.client.exception.*;

```

## <a name="instantiate-publicclientapplication"></a>实例化 PublicClientApplication

#### <a name="initialize-variables"></a>初始化变量

```java

private final static String[] SCOPES = {"Files.Read"};

/* Azure AD v2 Configs */

final static String AUTHORITY = "https://login.microsoftonline.com/common";

private ISingleAccountPublicClientApplication mSingleAccountApp;

private static final String TAG = MainActivity.class.getSimpleName();

/* UI & Debugging Variables */

Button signInButton;

Button signOutButton;

Button callGraphApiInteractiveButton;

Button callGraphApiSilentButton;

TextView logTextView;

TextView currentUserTextView;

```

### <a name="oncreate"></a>onCreate

在 `MainActivity` 类中,参阅下方的 onCreate() 方法以使用 `SingleAccountPublicClientApplication` 实例化 MSAL。

```java

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

initializeUI();

PublicClientApplication.createSingleAccountPublicClientApplication(getApplicationContext(),

R.raw.auth_config_single_account, new IPublicClientApplication.ISingleAccountApplicationCreatedListener() {

@Override

public void onCreated(ISingleAccountPublicClientApplication application) {

mSingleAccountApp = application;

loadAccount();

}

@Override

public void onError(MsalException exception) {

displayError(exception);

}

});

}

```

### <a name="loadaccount"></a>loadAccount

```java

//When app comes to the foreground, load existing account to determine if user is signed in

private void loadAccount() {

if (mSingleAccountApp == null) {

return;

}

mSingleAccountApp.getCurrentAccountAsync(new ISingleAccountPublicClientApplication.CurrentAccountCallback() {

@Override

public void onAccountLoaded(@Nullable IAccount activeAccount) {

// You can use the account data to update your UI or your app database.

updateUI(activeAccount);

}

@Override

public void onAccountChanged(@Nullable IAccount priorAccount, @Nullable IAccount currentAccount) {

if (currentAccount == null) {

// Perform a cleanup task as the signed-in account changed.

performOperationOnSignOut();

}

}

@Override

public void onError(@NonNull MsalException exception) {

displayError(exception);

}

});

}

```

### <a name="initializeui"></a>initializeUI

侦听按钮并相应地调用方法或日志错误。

```java

private void initializeUI(){

signInButton = findViewById(R.id.signIn);

callGraphApiSilentButton = findViewById(R.id.callGraphSilent);

callGraphApiInteractiveButton = findViewById(R.id.callGraphInteractive);

signOutButton = findViewById(R.id.clearCache);

logTextView = findViewById(R.id.txt_log);

currentUserTextView = findViewById(R.id.current_user);

//Sign in user

signInButton.setOnClickListener(new View.OnClickListener(){

public void onClick(View v) {

if (mSingleAccountApp == null) {

return;

}

mSingleAccountApp.signIn(MainActivity.this, null, SCOPES, getAuthInteractiveCallback());

}

});

//Sign out user

signOutButton.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

if (mSingleAccountApp == null){

return;

}

mSingleAccountApp.signOut(new ISingleAccountPublicClientApplication.SignOutCallback() {

@Override

public void onSignOut() {

updateUI(null);

performOperationOnSignOut();

}

@Override

public void onError(@NonNull MsalException exception){

displayError(exception);

}

});

}

});

//Interactive

callGraphApiInteractiveButton.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

if (mSingleAccountApp == null) {

return;

}

mSingleAccountApp.acquireToken(MainActivity.this, SCOPES, getAuthInteractiveCallback());

}

});

//Silent

callGraphApiSilentButton.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

if (mSingleAccountApp == null){

return;

}

mSingleAccountApp.acquireTokenSilentAsync(SCOPES, AUTHORITY, getAuthSilentCallback());

}

});

}

```

> [!Important]

> 使用 MSAL 注销会从应用程序中删除有关用户的所有已知信息,但是用户的设备上仍然有一个活动会话。 如果用户尝试再次登录,则可能会看到登录 UI,但由于设备会话仍处于活动状态,可能无需重新输入其凭据。

### <a name="getauthinteractivecallback"></a>getAuthInteractiveCallback

用于交互式请求的回调。

```java

private AuthenticationCallback getAuthInteractiveCallback() {

return new AuthenticationCallback() {

@Override

public void onSuccess(IAuthenticationResult authenticationResult) {

/* Successfully got a token, use it to call a protected resource - MSGraph */

Log.d(TAG, "Successfully authenticated");

/* Update UI */

updateUI(authenticationResult.getAccount());

/* call graph */

callGraphAPI(authenticationResult);

}

@Override

public void onError(MsalException exception) {

/* Failed to acquireToken */

Log.d(TAG, "Authentication failed: " + exception.toString());

displayError(exception);

}

@Override

public void onCancel() {

/* User canceled the authentication */

Log.d(TAG, "User cancelled login.");

}

};

}

```

### <a name="getauthsilentcallback"></a>getAuthSilentCallback

用于无提示请求的回调

```java

private SilentAuthenticationCallback getAuthSilentCallback() {

return new SilentAuthenticationCallback() {

@Override

public void onSuccess(IAuthenticationResult authenticationResult) {

Log.d(TAG, "Successfully authenticated");

callGraphAPI(authenticationResult);

}

@Override

public void onError(MsalException exception) {

Log.d(TAG, "Authentication failed: " + exception.toString());

displayError(exception);

}

};

}

```

## <a name="call-microsoft-graph-api"></a>调用 Microsoft Graph API

以下代码演示如何使用 Graph SDK 调用 GraphAPI。

### <a name="callgraphapi"></a>callGraphAPI

```java

private void callGraphAPI(IAuthenticationResult authenticationResult) {

final String accessToken = authenticationResult.getAccessToken();

IGraphServiceClient graphClient =

GraphServiceClient

.builder()

.authenticationProvider(new IAuthenticationProvider() {

@Override

public void authenticateRequest(IHttpRequest request) {

Log.d(TAG, "Authenticating request," + request.getRequestUrl());

request.addHeader("Authorization", "Bearer " + accessToken);

}

})

.buildClient();

graphClient

.me()

.drive()

.buildRequest()

.get(new ICallback<Drive>() {

@Override

public void success(final Drive drive) {

Log.d(TAG, "Found Drive " + drive.id);

displayGraphResult(drive.getRawObject());

}

@Override

public void failure(ClientException ex) {

displayError(ex);

}

});

}

```

## <a name="add-ui"></a>添加 UI

### <a name="activity"></a>活动

如果要根据本教程为 UI 建模,则以下方法可提供有关更新文本和侦听按钮的指导。

#### <a name="updateui"></a>updateUI

根据登录状态启用/禁用按钮,并设置文本。

```java

private void updateUI(@Nullable final IAccount account) {

if (account != null) {

signInButton.setEnabled(false);

signOutButton.setEnabled(true);

callGraphApiInteractiveButton.setEnabled(true);

callGraphApiSilentButton.setEnabled(true);

currentUserTextView.setText(account.getUsername());

} else {

signInButton.setEnabled(true);

signOutButton.setEnabled(false);

callGraphApiInteractiveButton.setEnabled(false);

callGraphApiSilentButton.setEnabled(false);

currentUserTextView.setText("");

logTextView.setText("");

}

}

```

#### <a name="displayerror"></a>displayError

```java

private void displayError(@NonNull final Exception exception) {

logTextView.setText(exception.toString());

}

```

#### <a name="displaygraphresult"></a>displayGraphResult

```java

private void displayGraphResult(@NonNull final JsonObject graphResponse) {

logTextView.setText(graphResponse.toString());

}

```

#### <a name="performoperationonsignout"></a>performOperationOnSignOut

在 UI 中更新文本以表示注销的方法。

```java

private void performOperationOnSignOut() {

final String signOutText = "Signed Out.";

currentUserTextView.setText("");

Toast.makeText(getApplicationContext(), signOutText, Toast.LENGTH_SHORT)

.show();

}

```

### <a name="layout"></a>布局

示例 `activity_main.xml` 文件,显示按钮和文本框。

```xml

<?xml version="1.0" encoding="utf-8"?>

<LinearLayout xmlns:android="http://schemas.android.com/apk/res/android"

xmlns:tools="http://schemas.android.com/tools"

android:id="@+id/activity_main"

android:layout_width="match_parent"

android:layout_height="match_parent"

android:background="#FFFFFF"

android:orientation="vertical"

tools:context=".MainActivity">

<LinearLayout

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:orientation="horizontal"

android:paddingTop="5dp"

android:paddingBottom="5dp"

android:weightSum="10">

<Button

android:id="@+id/signIn"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="5"

android:gravity="center"

android:text="Sign In"/>

<Button

android:id="@+id/clearCache"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="5"

android:gravity="center"

android:text="Sign Out"

android:enabled="false"/>

</LinearLayout>

<LinearLayout

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:gravity="center"

android:orientation="horizontal">

<Button

android:id="@+id/callGraphInteractive"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="5"

android:text="Get Graph Data Interactively"

android:enabled="false"/>

<Button

android:id="@+id/callGraphSilent"

android:layout_width="0dp"

android:layout_height="wrap_content"

android:layout_weight="5"

android:text="Get Graph Data Silently"

android:enabled="false"/>

</LinearLayout>

<TextView

android:text="Getting Graph Data..."

android:textColor="#3f3f3f"

android:layout_width="match_parent"

android:layout_height="wrap_content"

android:layout_marginLeft="5dp"

android:id="@+id/graphData"

android:visibility="invisible"/>

<TextView

android:id="@+id/current_user"

android:layout_width="match_parent"

android:layout_height="0dp"

android:layout_marginTop="20dp"

android:layout_weight="0.8"

android:text="Account info goes here..." />

<TextView

android:id="@+id/txt_log"

android:layout_width="match_parent"

android:layout_height="0dp"

android:layout_marginTop="20dp"

android:layout_weight="0.8"

android:text="Output goes here..." />

</LinearLayout>

```

## <a name="test-your-app"></a>测试应用

### <a name="run-locally"></a>在本地运行

构建应用并将其部署到测试设备或模拟器。 你应能够登录并获取 Azure AD 或个人 Microsoft 帐户的令牌。

你登录后,此应用将显示从 Microsoft Graph `/me` 终结点返回的数据。

PR 4

### <a name="consent"></a>同意

任何用户首次登录你的应用时,Microsoft 标识都将提示他们同意所请求的权限。 某些 Azure AD 租户已禁用用户同意功能,这要求管理员代表所有用户同意。 若要支持此场景,需创建自己的租户或获得管理员的同意。

## <a name="clean-up-resources"></a>清理资源

如果不再需要,请删除[注册应用程序](#register-your-application) 步骤中创建的应用对象。

[!INCLUDE [Help and support](../../../includes/active-directory-develop-help-support-include.md)]

## <a name="next-steps"></a>后续步骤

在我们的多部分场景系列中,详细了解如何构建可调用受保护 Web API 的移动应用。

> [!div class="nextstepaction"]

> [方案:用于调用 Web API 的移动应用程序](scenario-mobile-overview.md) | 20,333 | CC-BY-4.0 |

---

id: 2855

title: 免费PDF虚拟打印机

date: 2014-04-22T18:29:44+08:00

author: chonghua

layout: post

guid: http://hechonghua.com/?p=2855

permalink: /free-pdf-creator/

categories:

- 软件资源

tags:

- pdf

---

一般来说,要与其他用户分享文档的最佳方法就是将文档转换成PDF格式,因为PDF格式不存在平台的问题,几乎有人用的平台就能支持PDF,而且PDF体积小巧、排版一致,成为事实上的标准。通常我们一般使用Adobe Acrobat系列软件来生成PDF文档,但是,Adobe Acrobat体积巨大,售价不菲,不是每个人都用得起的。其它的像是Openoffice,Word等软件,虽然可以输出为PDF格式,当有很大的局限性,只能生成所支持格式的PDF。所以通用的做法就是安装一个PDF虚拟打印机。

<!--more-->

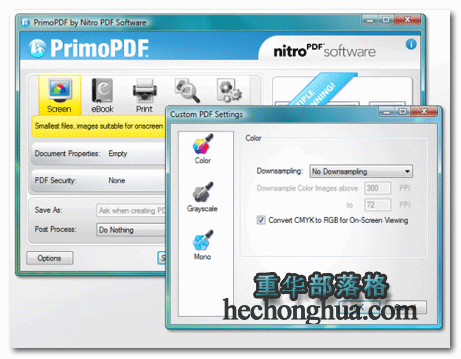

<a href="http://download.cnet.com/PrimoPDF/3000-2016_4-10264577.html" target="_blank">PrimoPDF</a>

PrimoPDF是一个免费、使用简单的 PDF 转文件软件,这套PrimoPDF可以”伪装”自己是一台打印机,然后把所有可以打印的文件都用PDF格式输出,所以不论是Word、html、 Excel、jpg文件等等,只要是可以打印的文件,全部都可以转成PDF格式。而且输出的文件无水印,没有有效期。PrimoPDF号称是世界上最好的免费PDF虚拟打印机,在Download下载站排名第一,名符其实,值得一试。并且PrimoPDF还是开放源代码的。

#### [PDFCreator](http://www.pdfforge.org/pdfcreator)

除了安装成为打印驱动外, PDFCreator 还可以与.ps文件关联,这样可以手动将PostScript文件转换为 PDF 格式。

OpenCD 项目已经选择 PDFCreator 做为 自由开源软件(FOSS) 计划中Windows下制作 PDF 文件的最佳软件。

<img src="http://chonghua-1251666171.cos.ap-shanghai.myqcloud.com/PDFCreator.png" width="600" height="589" alt="免费PDF虚拟打印机" />

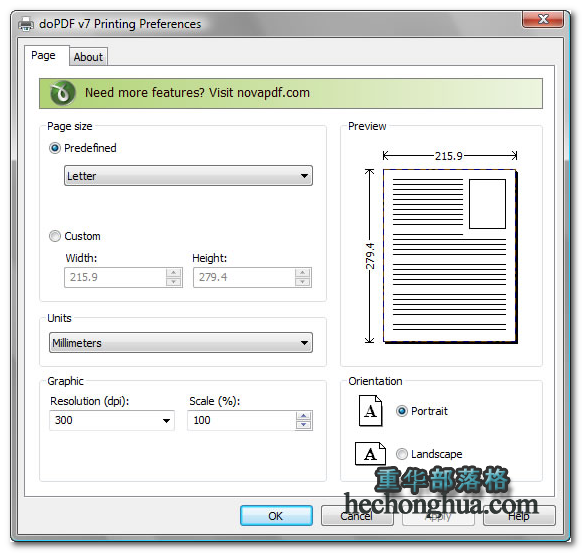

#### <a href="http://www.dopdf.com/cn/" target="_blank">doPDF</a>

doPDF 是一个免费的PDF转换器,可同时运用于商业和个人,它把自己安装为一个打印机驱动,允许从任意一个有打印输出的Windows程序中打印,还包含缩放,质量定义和页面大小定义。不需要第三方软件,像是 GhostScript 或是 .NET Framework 就可以建立 PDF 文件,这使得 doPDF 程序的文件大小,要比其它免费 PDF 打印机小非常多。官方原生多语言。

#### <a href="http://www.cutepdf.com/Products/CutePDF/writer.asp" target="_blank">CutePDF Writer</a>

CutePDF家族包括多种软件,其中此款免费,可以满足基本的打印生成PDF的需求。它也是基于GS,因此,请先从CutePDF网站下载并安装 [<a href="http://www.cutepdf.com/download/converter.exe" target="_blank">GPL Ghostscript转换程序</a>],然后再装CutePDF Writer。

它只有打印生成PDF的基本功能。如果需要页面多合一、删加页、旋转、页面大小、文件信息更改、加密等功能,可以使用下文介绍的相关工具。也可以下载 [CutePDF Writer Companion],与Writer无缝集成,实现更多功能。注意Companion内有一广告插件,可选择安装。

<img src="http://chonghua-1251666171.cos.ap-shanghai.myqcloud.com/cutepdf.png" width="600" height="540" alt="免费PDF虚拟打印机" />

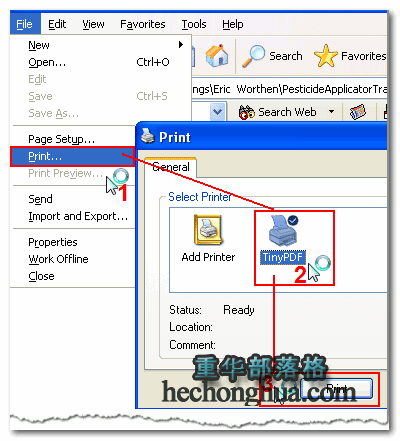

#### <a href="http://www.tinypdf.com/" target="_blank">TinyPDF</a>

TinyPDF是一款小巧免费的PDF虚拟打印机程序,几乎可以把任何可打印的文档创建成专业品质的 PDF 文件。 。它不依赖Acrobat、GhostScript等程序,可以生成高质量的PDF文档。

本文为翻译文章,原文:<a title="http://dailytechpost.com/2014/04/12/free-pdf-creator/" href="http://dailytechpost.com/2014/04/12/free-pdf-creator/" target="_blank">http://dailytechpost.com/2014/04/12/free-pdf-creator/</a> | 2,566 | MIT |

---

layout: post

category: "DS"

title: "关于test数据的省时省力的方法"

---

* content

{:toc}

# 引入

关于测试数据,本来不应该给予过多的关注,但是,很多时候我们在调试数据上面浪费

了很多的时间,下面,这篇文章我将持续的更新,介绍自己方法。

# 打印

首先,写出一个头文件:

```c

#include<stdlib.h>

/*

*

* 使用方法,只需在主函数中声明i,j;

* Right now, i dont have realize extern from "header.h",

* Only to use "cat macro.h >> filename" ;

* 2016-03-11

*

*/

#define print_maritx_int(n,a) \

for (i = 0; i < n ;i++) \

{ \

printf("\n"); \

for (j = 0; j < n; j++) \

printf("%d\t",a[i][j]); \

}

```

目前我还没有实现导入外部头文件的方法使用这个宏,我的本意是是在需要的源文件

插入:

> extern print_maritx_int(n,a);

可惜,不给力,每次给我报错误,不知道是哪里的问题。

现在的解决方案很简单,就是这个头文件放在手头上,暂时将需要的宏用命令插进去。 | 639 | MIT |

---

author: alkohli

ms.service: storsimple

ms.topic: include

ms.date: 10/26/2018

ms.author: alkohli

ms.openlocfilehash: 350dbc286c060ad10c21ebe1e8715b910871f837

ms.sourcegitcommit: 48592dd2827c6f6f05455c56e8f600882adb80dc

ms.translationtype: HT

ms.contentlocale: ja-JP

ms.lasthandoff: 10/26/2018

ms.locfileid: "50165583"

---

<!--author=alkohli last changed: 11/02/17 -->

#### <a name="to-install-updates-via-the-azure-portal"></a>Azure Portal を使用して更新プログラムをインストールするには

1. StorSimple デバイス マネージャーに移動し、**[デバイス]** を選択します。 サービスに接続されているデバイスの一覧から、更新するデバイスを選択してクリックします。

2. **[設定]** ブレードで **[デバイスの更新プログラム]** をクリックします。

3. ソフトウェアの更新プログラムが利用可能な場合は、メッセージが表示されます。 更新プログラムを確認するには、**[スキャン]** をクリックします。 実行しているソフトウェアのバージョンをメモしておきます。

スキャンが開始され、正常に完了すると、その旨が通知されます。

4. 更新プログラムのスキャンが完了したら、**[更新プログラムのダウンロード]** をクリックします。

5. **[新しい更新プログラム]** ブレードで、リリース ノートを確認します。 更新プログラムをダウンロードしたら、インストールを確認する必要があることにもご注意ください。 Click **OK**.

6. アップロードが開始され、正常に完了すると、その旨が通知されます。

5. **[デバイスの更新プログラム]** ブレードで **[インストール]** をクリックします。

6. **[新しい更新プログラム]** ブレードで、更新には中断が伴うという警告が表示されます。 仮想アレイが単一ノード デバイスであるため、更新された後にデバイスが再起動されます。 これにより、進行中の IO が中断されます。 **[OK]** をクリックして、更新プログラムをインストールします。

7. インストール ジョブの開始されると、その旨が通知されます。

8. インストール ジョブが正常に完了したら、**[デバイスの更新プログラム]** ブレードの **[ジョブの表示]** リンクをクリックして、インストールを監視します。

**[更新プログラムのインストール]** ブレードに移動します。 ここでは、ジョブの詳細情報を確認できます。

9. 更新プログラム 0.6 (10.0.10293.0) のソフトウェア バージョンを実行している仮想アレイで開始した場合は、この時点で更新プログラム 1 が実行されており、アップデートは完了となります。 残りの手順を省略できます。 更新プログラム 0.6 (10.0.10293.0) より前のソフトウェア バージョンを実行している仮想アレイで開始した場合、この時点で更新プログラム 0.6 に更新されます。 更新プログラムが利用できることを示すメッセージがまた表示されます。 手順 4 - 8 を繰り返して更新プログラム 1 をインストールします。

| 2,971 | BSD-Source-Code |

# 2021-11-25

共 212 条

<!-- BEGIN ZHIHUQUESTIONS -->

<!-- 最后更新时间 Thu Nov 25 2021 23:00:55 GMT+0800 (China Standard Time) -->

1. [陕西潼关肉夹馍协会官网疑似被黑客攻击,黑底绿字「无良协会」飘屏,具体情况如何?反映了哪些问题?](https://www.zhihu.com/question/501213997)

1. [11 月 25 日上海市新增 3 例本土确诊病例,目前当地情况如何?](https://www.zhihu.com/question/501530186)

1. [土耳其总统反向操作,坚持降息对抗通胀,近期里拉大贬值,一周暴跌 20%,苹果暂停该地区销售,你怎么看?](https://www.zhihu.com/question/501178367)

1. [如何看待上海宣布生育假从 30 天增加到 60 天?此举对促进生育将产生怎样的影响?](https://www.zhihu.com/question/501477980)

1. [学生因被困酒店厕所 16 小时错过专升本考试索赔 13 万,此次事件中酒店该承担哪些责任?](https://www.zhihu.com/question/500837857)

1. [《梦想改造家》建筑师陶磊住房被指违建,镇城管称「已前往测绘」,如果情况属实他会面临哪些责任?](https://www.zhihu.com/question/500878603)

1. [00 后上班太懒散,领导「发火」骂了滚,年轻人「发火」叫记者,两人谁该「发火」?](https://www.zhihu.com/question/489482590)

1. [如何看待甘肃白银当地居民认为,陶磊在《梦想改造家》中花费 132 万的改造房不如自家 5 万的房子?](https://www.zhihu.com/question/501407445)

1. [高校打印店张贴欠费 0.75 元学生照片,该处理方式是否妥当?如果你是打印店老板会怎么做?](https://www.zhihu.com/question/500904587)

1. [11 月 25 日杭州新增两例新冠肺炎无症状感染者,其中一人为浙大教职工,还有哪些信息值得关注?](https://www.zhihu.com/question/501588574)

1. [如何看待淄博一中学被曝要求高一学完高中全部课程,劝成绩好的学生「学习艺术,冲击清华美术学院」?](https://www.zhihu.com/question/501520341)

1. [我爸因为樊登说牛肉致痴不让我吃牛肉了,我该怎么办?](https://www.zhihu.com/question/499979556)

1. [如何看待中科大 5 名学生凌晨两点半发现实验室漏水,处置后被奖励 12 万元?科研人经常熬夜工作吗?](https://www.zhihu.com/question/501465611)

1. [如何看待腾讯手游《火影忍者》川剧自来也要 2000 元以上引争议后,官方迅速退费,忍者免费的处理?](https://www.zhihu.com/question/501092943)

1. [英国威廉王子称「由于人口增长,非洲野生动物面临的压力越来越大」,如何看待其言论?](https://www.zhihu.com/question/501356246)

1. [梦想改造家陶磊设计的西北红砖房怎么补救才能挽回节目口碑?](https://www.zhihu.com/question/501141628)

1. [字节跳动旗下大力教育将彻底放弃中小学业务,被裁员工获赔 n+2,被裁的两千名员工将何去何从?](https://www.zhihu.com/question/501362474)

1. [为什么川渝地区吃火锅时喜欢蘸油碟,而北方地区更喜欢麻酱呢?](https://www.zhihu.com/question/333401552)

1. [水浒里,西门庆为什么不给武大郎一笔钱,买下潘金莲做长久夫妻,而要害了武大性命?](https://www.zhihu.com/question/492755627)

1. [《英雄联盟》退役选手良小伞发声寻求试训机会,你有什么想说的?](https://www.zhihu.com/question/501340027)

1. [媒体称 BLACKPINK 成员 LISA 接种疫苗后确诊感染新冠,目前情况如何?](https://www.zhihu.com/question/501326049)

1. [上百商户被「库尔勒香梨协会」起诉,近期此类「地名+产品」模式起诉多发,这些协会是否合理使用商标专利法?](https://www.zhihu.com/question/501510540)

1. [杨幂现在的状态还适合演少女吗?](https://www.zhihu.com/question/499576882)

1. [面对一个长期不工作的老公,怎么办?](https://www.zhihu.com/question/403831716)

1. [如果你现在月薪过万,存款六位数,想花一万块买个相机过分吗?](https://www.zhihu.com/question/500982491)

1. [德国又一州将尝试完全使用 Linux 和 LibreOffice,对此你有哪些看法?](https://www.zhihu.com/question/500653831)

1. [如何评价杨紫在电视剧《女心理师》中的表现?](https://www.zhihu.com/question/500930603)

1. [心理咨询师是如何看待《女心理师》这部剧的?](https://www.zhihu.com/question/500981544)

1. [假如你写御兽流小说,御使什么才是最离谱又合理的?](https://www.zhihu.com/question/497887574)

1. [你的研究生导师是什么样的?](https://www.zhihu.com/question/298181420)

1. [初高中生年轻人应该追逐梦想,还是提高学历?](https://www.zhihu.com/question/500783038)

1. [因为intp一直不回消息,我生气之后被她冷处理,现在应该怎么办?](https://www.zhihu.com/question/494482491)

1. [如何看待郑州一女子辞职前骗走同事们 200 万后消失,她可能承担那些责任?同事间借款需要注意哪些事宜?](https://www.zhihu.com/question/501135400)

1. [离开互联网算法岗,切入最近大行其道的AI生物医药研发靠谱吗?](https://www.zhihu.com/question/488346668)

1. [我是个高三美术生,今天上了色彩课,然后发现了自己是个色盲,红绿不分,我该怎么办?](https://www.zhihu.com/question/421975708)

1. [多方消息指向 Uzi 将于 2021 转会期复出,他现在的实力状态还能适应职业的强度吗?](https://www.zhihu.com/question/501083156)

1. [如何评价《令人心动的 offer》第三季第三期(下)?](https://www.zhihu.com/question/501344261)

1. [动画《新秦时明月》开播,你感觉如何?](https://www.zhihu.com/question/501068047)

1. [花呗启动品牌隔离,将成为蚂蚁消金专属消费信贷品牌,与之前有哪些不同?会带来怎样的影响?](https://www.zhihu.com/question/501248601)

1. [如何看待宝可梦 DP 游戏《精灵宝可梦:晶灿钻石/明亮珍珠》复刻版?](https://www.zhihu.com/question/446607805)

1. [今年冬天计划滑雪旅行,国内有哪些推荐的雪场?](https://www.zhihu.com/question/499977639)

1. [是什么让你抛弃了 Windows 而转向 Mac?](https://www.zhihu.com/question/20585523)

1. [《黑客帝国:矩阵重生》确认引进,将于全国影院上映,时隔 20 年你觉得这部的票房和口碑还能爆吗?](https://www.zhihu.com/question/501056268)

1. [有什么适合冬天喝的甜甜的咖啡?](https://www.zhihu.com/question/499058418)

1. [科幻走向现实!NASA今天发射「飞镖」探测器拟将小行星撞离原轨道以保护地球,你如何看待这次科技探索?](https://www.zhihu.com/question/501257766)

1. [有没有舍不得换掉的全面屏手机壁纸?](https://www.zhihu.com/question/420662927)

1. [如何看待大疆与长光辰芯联合推出国产 8K 全画幅传感器?](https://www.zhihu.com/question/500958484)

1. [《甄嬛传》中的果郡王为什么不讨喜呢?换演员会好点吗?](https://www.zhihu.com/question/499278485)

1. [有哪些你一直坚持的好习惯?](https://www.zhihu.com/question/329310508)

1. [《复仇者联盟 4》之后的漫威电影质量是不是不如以前了?](https://www.zhihu.com/question/499936712)

1. [如何看待央视新闻 AI 手语主播正式亮相,将从冬奥会开始全年无休提供手语服务?](https://www.zhihu.com/question/501336223)

1. [什么事情是你当了老板才知道的?](https://www.zhihu.com/question/364147974)

1. [你有哪些「后悔没早读」的书籍?](https://www.zhihu.com/question/483988438)

1. [如何看待《中共中央、国务院关于加强新时代老龄工作的意见》鼓励成年子女与老年父母就近居住或共同生活?](https://www.zhihu.com/question/501345877)

1. [如何看待衡水居民拨打政务热线遭工作人员辱骂「打 12345 的人基本上都是废了」?暴露出什么问题?](https://www.zhihu.com/question/501356830)

1. [高三复读,做什么都是独来独往,自己感觉也挺好的,可能别人就觉得我挺孤独的,独来独往好吗?](https://www.zhihu.com/question/501219417)

1. [歼-15 舰载机着舰首飞成功 9 周年,你对国产舰载机有哪些期待?](https://www.zhihu.com/question/500989797)

1. [NBA 21-22 赛季 76 人 96:116 勇士,库里 25+10 带队逆转,如何评价这场比赛?](https://www.zhihu.com/question/501453709)

1. [对于中年人来说,哪些渠道比较好找工作?](https://www.zhihu.com/question/501060050)

1. [都说读博选导师大于学校排名,可是这个事情的界限在哪?](https://www.zhihu.com/question/500366814)

1. [云南哀牢山究竟有多凶险?](https://www.zhihu.com/question/500806226)

1. [NBA 21-22 赛季湖人加时 124:116 步行者,詹姆斯复出砍 39 分,如何评价这场比赛?](https://www.zhihu.com/question/501395527)

1. [二战法国你是贝当,你会投降吗?](https://www.zhihu.com/question/495356179)

1. [网传四川苍溪一网红被丈夫杀害,警方回应正在调查,事件具体情况如何?](https://www.zhihu.com/question/501279542)

1. [如何看待《原神》竞速榜榜首玩家 SanaQwQ 直播融号?《原神》圣遗物机制是否存在不合理?](https://www.zhihu.com/question/501360404)

1. [如何跟孩子解释「为什么方便面是卷曲的而不是直的」?](https://www.zhihu.com/question/499991484)

1. [当孩子问「鱼儿用什么呼吸」该如何回答?](https://www.zhihu.com/question/498110403)

1. [21-22 赛季欧冠曼城 2:1 巴黎圣日耳曼,如何评价这场比赛?](https://www.zhihu.com/question/501391765)

1. [恋爱之后让你明白了什么?](https://www.zhihu.com/question/36951304)

1. [如何以「我亲手杀了他,却世世守着他轮回」为开头写一个故事?](https://www.zhihu.com/question/493667312)

1. [目前预算不足,是选择廉价 CPU 和较好的 GPU,还是选择较好的 CPU 再整个亮机卡?](https://www.zhihu.com/question/500896127)

1. [11 月 25 日是国际反家暴日,应如何预防、处理家暴?有哪些行之有效的措施?](https://www.zhihu.com/question/501434696)

1. [如何看待 FPX 前员工对 Doinb 的评价?](https://www.zhihu.com/question/500876559)

1. [如何看待小米高管表示「小米第三季度市场占有率下降」主要与 iPhone 13 表现强势有关?](https://www.zhihu.com/question/501311080)

1. [如何看待游戏《FIFA Online 4》成为杭州亚运会正式项目?](https://www.zhihu.com/question/500782086)

1. [进入二次元世界,一千万或者考入 985 学校,你会选择哪一个?](https://www.zhihu.com/question/498766373)

1. [电影《教父》中有哪些易被忽略却令人深思的小细节?](https://www.zhihu.com/question/22920209)

1. [国内新造车企业势头很猛,它们是昙花一现还是有核心科技?](https://www.zhihu.com/question/501320667)

1. [有哪些物品,很适合小厨房的收纳整理?](https://www.zhihu.com/question/447760903)

1. [文科生和理科生看书角度是否真的不同?](https://www.zhihu.com/question/499811733)

1. [有哪些发朋友圈的沙雕文案?](https://www.zhihu.com/question/486583833)

1. [《知否》没如兰出身好,也没墨兰受宠,吴大娘子为何只看中明兰?](https://www.zhihu.com/question/402223494)

1. [2021 世乒赛周启豪负波尔成国乒出局第 1 人,张本 3:4 遭逆转淘汰, 男单战况很意外?](https://www.zhihu.com/question/501400188)

1. [大学四年时间,物理学能学到什么水平?](https://www.zhihu.com/question/496319121)

1. [写小说的时候,如何才能让相爱的两个人物变得对立?](https://www.zhihu.com/question/487057977)

1. [国内的哪个游戏质量可以超过《原神》?](https://www.zhihu.com/question/497894517)

1. [看完杨紫的新剧 《女心理师》你最大的感受是什么?](https://www.zhihu.com/question/501089687)

1. [如何评价美剧《鹰眼》第一集和第二集?](https://www.zhihu.com/question/501227929)

1. [普通人有没有必要打灭活新冠疫苗第三针?](https://www.zhihu.com/question/501376193)

1. [华为最新发布的新款二合一笔记本 MateBook E 的性价比如何,是否值得入手?](https://www.zhihu.com/question/499657277)

1. [巴巴多斯不再承认英女王为国家元首,英媒急呼「巴巴多斯成了小中国」,如何看待这种联想?](https://www.zhihu.com/question/500722409)

1. [没有玩过战地风云系列、想入手《战地2042》,要做什么准备吗?](https://www.zhihu.com/question/500579949)

1. [有没有什么又甜又虐的小说推荐?](https://www.zhihu.com/question/364002744)

1. [如何评价虚拟偶像 A-SOUL 对部分高校大学生的吸引力如此之大?](https://www.zhihu.com/question/500900104)

1. [如何看待电影《永恒族》导演赵婷力排众议,在片中保留了「黑人对广岛核爆痛哭反思」的剧情?](https://www.zhihu.com/question/501419451)

1. [如何评价2021年APMCM亚太地区大学生数学建模竞赛(2021亚太赛)?](https://www.zhihu.com/question/431888513)

1. [如何看待生活中经常出现「人工智能翻车」的情况,目前人工智能技术究竟发展到什么程度了?](https://www.zhihu.com/question/501007277)

1. [当孩子问「世界上最小的鱼是什么」该如何回答?](https://www.zhihu.com/question/499988560)

1. [大数据显示互联网大厂诉讼原告胜诉率高,判决结果与「主客场」无关,透露了什么信息?](https://www.zhihu.com/question/501073126)

1. [网传云南哀牢山遇难地质人员仅配备一次性塑料雨衣,或与其失温有关,是真的吗?为何会出现这种情况?](https://www.zhihu.com/question/501150344)

1. [可以推荐一些好吃的零食吗?](https://www.zhihu.com/question/488750070)

1. [动画《英雄联盟双城之战》中,希尔科为什么这么想杀蔚而不是收留蔚?](https://www.zhihu.com/question/499278184)

1. [为什么三大民工漫(死神,火影,海贼)没有龙珠呢?](https://www.zhihu.com/question/500713159)

1. [为什么公司永远都问不到员工离职的真实原因?](https://www.zhihu.com/question/493844417)

1. [用奖学金买 iPhone 13 会不会对不起父母?](https://www.zhihu.com/question/499188066)

1. [钱少但清闲的工作要继续吗?](https://www.zhihu.com/question/499243830)

1. [美国地铁被非裔暴徒殴打的华裔女性,被曝为「黑命贵」运动支持者,如何看待亚裔被反向歧视?](https://www.zhihu.com/question/501138781)

1. [瓜迪奥拉究竟是一个什么样的人?](https://www.zhihu.com/question/23158804)

1. [用极端落后技术(至少落后两代)造先进武器会造出什么奇葩来?](https://www.zhihu.com/question/478170187)

1. [如何看待四川开展超时加班专项执法检查,会带来哪些影响?](https://www.zhihu.com/question/501035523)

1. [如何评价华为调侃美国「黑五」,所有美国在售手机享 100% 折扣,随后又表示他们不能在美国卖任何东西?](https://www.zhihu.com/question/500998306)

1. [如何跟孩子解释「为什么要说‘上’厕所,‘下’厨房呢」?](https://www.zhihu.com/question/501106093)

1. [夏天的脚臭,冬天还会有味儿吗?](https://www.zhihu.com/question/500361037)

1. [如何看待山东两服务员调包 18 瓶茅台无人喝出异常,这两位服务员需要承担什么法律责任?](https://www.zhihu.com/question/500892506)

1. [下身胖怎么穿衣服显得好看?](https://www.zhihu.com/question/499186668)

1. [如何评价原神2.3版本北斗邀约任务?](https://www.zhihu.com/question/501265316)

1. [被要过微信的女生是因为长的好看吗?](https://www.zhihu.com/question/500613155)

1. [2021 年感恩节有哪些文案呢?](https://www.zhihu.com/question/497964014)

1. [如何看待菲律宾总统候选人登中业岛「宣誓主权」,收到短信「欢迎来到中国」?](https://www.zhihu.com/question/501177599)

1. [有哪些年轻人喜欢用,市面上比较热销的家电?](https://www.zhihu.com/question/500930342)

1. [如何评价《令人心动的 offer》第三季第三期(上)?](https://www.zhihu.com/question/501087282)

1. [动画《英雄联盟双城之战》希尔科和蔚到底谁更爱爆爆/金克丝?](https://www.zhihu.com/question/500576254)

1. [2021 KPL 秋季赛LGD大鹅 3:1 成都AG,如何评价这场比赛?](https://www.zhihu.com/question/501344594)

1. [无忧无虑且家里有钱漂亮的女生是什么样的?](https://www.zhihu.com/question/369021998)

1. [当面试官问「你能加班吗」是想问什么?怎么回答能加分?](https://www.zhihu.com/question/499229089)

1. [iPhone 15 概念设计图曝光,15 可能做出哪些升级和改变?](https://www.zhihu.com/question/501241765)

1. [天坑专业能考研吗?应该及时跑路转专业吗?](https://www.zhihu.com/question/499498038)

1. [如何评价人生一串第三季第二期?](https://www.zhihu.com/question/501347707)

1. [如何评价游戏《钢铁雄心》新 DLC 绝不后退(No Step Back)?](https://www.zhihu.com/question/501129988)

1. [阿斯伯格综合征的手写字体都是什么样的?](https://www.zhihu.com/question/427380255)

1. [如何看待 2021 转会期 Doinb 加入 LNG 战队?](https://www.zhihu.com/question/500652422)

1. [公司没有签劳动合同,员工申请仲裁,公司一定会输吗?](https://www.zhihu.com/question/500865462)

1. [11 月 25 日是感恩节,你有哪些感谢的话想对「旅行路上帮助过你的陌生人」说?](https://www.zhihu.com/question/494873539)

1. [杭州上调新房限价,个别板块涨了 2000 元/平方米。此政策有何影响?](https://www.zhihu.com/question/500937937)

1. [如何看待卖肉夹馍商户因「潼关」两个字被告?此事与逍遥镇胡辣汤是否有相同性质?](https://www.zhihu.com/question/501098535)

1. [网传腾讯旗下 App 不得新上架或版本更新,腾讯回应正配合监管部门进行合规检测,还有哪些信息值得关注?](https://www.zhihu.com/question/501292908)

1. [如何看待张艺兴作为艺人代表在 2021 中国网络媒体论坛上发表的演讲?](https://www.zhihu.com/question/501301934)

1. [上班第一天就听到同事吐槽公司,我该怎么办?](https://www.zhihu.com/question/491853906)

1. [《长津湖》票房超《战狼2》登顶中国影史票房第一,具有哪些意义?](https://www.zhihu.com/question/500714490)

1. [拉夏贝尔被申请破产清算,或将告别 A 股,曾经的「国民女装」为何会走向衰落?](https://www.zhihu.com/question/501088802)

1. [健身小白刚办了健身卡,在不请私教的情况下该如何训练?](https://www.zhihu.com/question/315892465)

1. [如何评价 A-Soul 的嘉然?](https://www.zhihu.com/question/443450817)

1. [媒体爆料称汪小菲已有新欢,大 S 和经纪人暂未回应, 如何评价两人的婚姻?](https://www.zhihu.com/question/500948534)

1. [如何看待继逍遥镇胡辣汤事件后,陕西潼关肉夹馍协会起诉数百家小吃店,近期有 210 个开庭公告?](https://www.zhihu.com/question/501235190)

1. [如何看待各大博物馆都在推出「考古式」盲盒?盲盒经济还会持续多久?](https://www.zhihu.com/question/501058715)

1. [客观评价一下白百何的演技?](https://www.zhihu.com/question/58843765)

1. [如果果郡王当初喜欢的是安陵容会怎么样呢?](https://www.zhihu.com/question/488825490)

1. [有哪些性价比高的粉底液值得推荐?](https://www.zhihu.com/question/314574738)

1. [为什么很多人说喜剧是最难演绎的?](https://www.zhihu.com/question/264359919)

1. [NBA 21-22 赛季湖人 100:106 尼克斯,威少 31+13+10,如何评价这场比赛?](https://www.zhihu.com/question/501138591)

1. [如何评价游戏扳机 Game Trigger 这家投资机构?](https://www.zhihu.com/question/407985683)

1. [新手该如何提高写作能力?](https://www.zhihu.com/question/500781048)

1. [21-22 赛季欧冠切尔西 4:0 尤文图斯,如何评价这场比赛?](https://www.zhihu.com/question/501133461)

1. [有没有特别委屈的文案?](https://www.zhihu.com/question/440934709)

1. [编程那么难,为什么不弄一个大众一学就会的计算机语言呢?](https://www.zhihu.com/question/500406718)

1. [为什么自己总是一个人?](https://www.zhihu.com/question/495160153)

1. [看了动画《英雄联盟双城之战》,符文大陆会不会成为下一个漫威宇宙?](https://www.zhihu.com/question/499364068)

1. [我们读书的意义是什么呢?](https://www.zhihu.com/question/499129635)

1. [如何向孩子解释「为什么飞机能飞上天」?](https://www.zhihu.com/question/500256610)

1. [适合在北方冬季穿的厚外套有哪些推荐?](https://www.zhihu.com/question/493413782)

1. [过生日,男朋友送了一条金项链,该收吗?](https://www.zhihu.com/question/500064501)

1. [可以分享一下伤感文案吗?](https://www.zhihu.com/question/479988450)

1. [如何跟 5 岁的小孩子解释宇宙飞船和飞机有什么不一样?](https://www.zhihu.com/question/447361031)

1. [11 月 23 日北京中关村地库一比亚迪电动汽车起火,事故原因可能是什么?目前情况如何?](https://www.zhihu.com/question/500960060)

1. [哪种食物有利于美白皮肤?](https://www.zhihu.com/question/468527303)

1. [在你生命中,对你最重要的是什么?](https://www.zhihu.com/question/499281115)

1. [你感觉能力跟学历哪个更重要?](https://www.zhihu.com/question/497552777)

1. [衣服被同学弄丢了,该怎么解决?](https://www.zhihu.com/question/498942241)

1. [在你熟悉的领域里,有哪些创新在悄悄改变生活?](https://www.zhihu.com/question/500695607)

1. [广东一老人洗虾手指遭刺被迫截肢保命,被海鲜扎伤为什么伤害这么大?日常处理食材有没有什么技巧?](https://www.zhihu.com/question/500889984)

1. [如果人类是反刍动物,胃病患者数量是否会大幅度减少?](https://www.zhihu.com/question/496418756)

1. [快三十了,干了快九年的工作在一线城市月入 4~6k 还要继续吗?](https://www.zhihu.com/question/500698069)

1. [你觉得打工好还是创业好呢?](https://www.zhihu.com/question/492063575)

1. [安全工程出来之后找工作怎么样,工资多少?](https://www.zhihu.com/question/495287420)

1. [国台办称「大陆正规划两岸交通建设,福建完成与金门、马祖通桥初步方案」,这对两岸经济发展有哪些积极意义?](https://www.zhihu.com/question/501194267)

1. [我们辛苦地工作就只是为了生活上的享受吗?](https://www.zhihu.com/question/500228773)

1. [当孩子问「地球上的水是从哪里来的」该如何回答?](https://www.zhihu.com/question/499988775)

1. [当孩子问「鱼类是否会飞翔」该如何回答?](https://www.zhihu.com/question/498110417)

1. [如何看待《令人心动的 offer 》中提到的医生职业成长期的「熬」,好医生都是熬出来的么?](https://www.zhihu.com/question/500764689)

1. [电影《沙丘》其实换个中世纪魔幻背景也毫无问题吧?](https://www.zhihu.com/question/500488287)

1. [公务员考试是本科毕业就考好,还是考研后再考?](https://www.zhihu.com/question/499679435)

1. [云南 4 名地质队员遇难,搜救队员称「或因罗盘失灵,失温所致」,失温有多可怕?哪些装备能更好保护他们?](https://www.zhihu.com/question/500928729)

1. [孩子情绪崩溃,母亲不理解孩子的心理,作为父亲怎么做合适?](https://www.zhihu.com/question/495643871)

1. [研一新生,写了一篇较差的论文发给导师,感觉要被批评,怎么办?](https://www.zhihu.com/question/491096343)

1. [你住过最贵的酒店是哪家?](https://www.zhihu.com/question/35236983)

1. [郑州 8 元爱心面馆老板疑被同行威胁,涉事者将承担怎样的责任?该如何解决爱心与同行竞争间的矛盾?](https://www.zhihu.com/question/500812179)

1. [做独立游戏制作人真的很难吗?](https://www.zhihu.com/question/431681557)

1. [语文作文里面有什么高级词汇能替换众所周知的词语?](https://www.zhihu.com/question/318964543)

1. [女生写起点男频小说,有哪些难度?](https://www.zhihu.com/question/501183300)

1. [生活好浮躁,有哪些反焦虑的句子?](https://www.zhihu.com/question/489496108)

1. [《女心理师》有哪些戳中你的细节?](https://www.zhihu.com/question/500980783)

1. [武汉警方已受理「女子以死对抗遛狗人」案,称该案为「重大疑难案件」,如何从法律角度分析其立案难点?](https://www.zhihu.com/question/501171913)

1. [隐晦表达爱意的文案有哪些?](https://www.zhihu.com/question/489364707)

1. [有什么类似《国王排名》这样好看的动漫?](https://www.zhihu.com/question/497075886)

1. [有哪些描写雪的很美的诗词?](https://www.zhihu.com/question/302508179)

1. [当今最前沿的理论物理学家都在干什么?是否还有一场物理学革命在前方等着我们?](https://www.zhihu.com/question/499914286)

1. [如何评价动画《英雄联盟:双城之战》中的角色「梅尔」?](https://www.zhihu.com/question/499027801)

1. [如何看待网易云音乐将于 12 月 2 日挂牌上市?这对在线音乐市场有什么影响?](https://www.zhihu.com/question/500928888)

1. [怎样看待年轻人「辞职式养生」?反映了哪些问题?](https://www.zhihu.com/question/496961304)

1. [如何看待公司同工不同酬的现象?](https://www.zhihu.com/question/388136268)

1. [男女朋友存在的意义是什么,谈恋爱的意义何在?](https://www.zhihu.com/question/61467321)

1. [湖南一女主播喝药自杀,骨灰被殡葬从业者掉包配阴婚,涉案人员将面临什么处罚?起到了什么警示作用?](https://www.zhihu.com/question/501012306)

1. [如果高铁上有一节车厢承包给电影院搞成观影车厢是不是个好主意?](https://www.zhihu.com/question/499915495)

1. [建筑师和设计师怎么看待《梦想改造家》第三季第八期陶磊的作品?](https://www.zhihu.com/question/500723840)

1. [下雪天为什么这么浪漫?](https://www.zhihu.com/question/266462404)

1. [中演协将吴亦凡、郑爽、张哲瀚等 88 人列入警示名单,你有什么想说的?还有哪些信息值得关注?](https://www.zhihu.com/question/501054451)

1. [东部战区回应美舰过航台湾海峡称「将采取一切必要措施,坚决反制一切威胁挑衅」,释放了什么信号?](https://www.zhihu.com/question/501017271)

1. [11 月 22 日俄前司令「库尔斯克号核潜艇沉没原因为与北约潜艇相撞」,发生此次事故的原因有哪些?](https://www.zhihu.com/question/500818710)

1. [调查报告显示「超九成大学生认为直播行业有发展前景」,反映了哪些问题?该行业发展现状如何?](https://www.zhihu.com/question/500697906)

1. [程序员周报写不出来怎么办?](https://www.zhihu.com/question/495754023)

1. [动物是住在动物园好,还是住在野外好?](https://www.zhihu.com/question/500225337)

1. [天冷的时候,家中的哪些地方特别有「温暖的治愈感」?](https://www.zhihu.com/question/496406610)

<!-- END ZHIHUQUESTIONS --> | 16,530 | MIT |

---

layout: article

title: "三天打鱼两天晒网"

date: 2022-02-05

mode: immersive

header:

theme: dark

article_header:

type: overlay

theme: dark

background_color: '#203028'

background_image:

gradient: 'linear-gradient(135deg, rgba(34, 139, 87 , .4), rgba(139, 34, 139, .4))'

src: assets/images/cover.jpg

modify_date: 2022-02-05

author: "Bedoom"

mathjax_autoNumber: false

show_tags: true

tags:

- 考研心得

---

考研虽然不如高考,但也是千军万马过独木桥。于我而言,考试向来不是难事,8 门科目,1 周时间,就足以不会挂科。但,如果这样,我能考研吗?

<!--more-->

考研人中有比我努力的,有比我聪明的,有比我能熬的,那这样的我想来结果并不是很好。因此我寻求改变。

往常,早上我总是在GitHub中寻找有意思、有趣的项目,加以实现。这一个月里,因为选课太肝,因此学习爬虫基础,以减轻选课压力;因为在bilibili上看到一个qq机器人,因此接触nonebot;因为过年抢红包,因此看了看Hamibot的编写脚本方式,但由于JavaScript没有学,我又去学了一下JavaScript。而现在我又在看机器学习相关内容。

今年,我要考研,但我却没有办法权衡二者的时间,有时我会一天都在弄脚本,所以高数忘了学。最近心情有些急躁,因为没有退路,但我并不喜欢被动,我想要主动权,但是没有办法得到。ε=(´ο`*)))唉,这是我最后一个项目了吧,往后,要考研啦!

计算机行业不存在大器晚成,年轻就应该多闯闯,看遍大千世界,经历人间百态。毕竟 35 岁危机并不会消失,所以程序员也是一个青春饭?不管怎样,选择的路,就算是爬也要到达终点。加油,奥利给

| 1,215 | MIT |

---

toc : true

title : "JMS实现参数的集中式管理"

description : "JMS实现参数的集中式管理"

zhuan : true

tags : [

"JMS",

"UCM"

]

date : "2017-09-05 17:12:36"

categories : [

"JMS",

"技术"

]

menu : "main"

---

# 点评

虽然现在开源的UCM套件很多,UCM统一配置管理(百度的disconf、阿里的diamond、点评的lion,等很多开源的)。但是很多人是知其然不知其所以然,刚好发现下面这篇文章可以作为原理的教程文章,使用JMS、Redis、Zookeeper简单的实现UCM基本功能,作为学习交流还是很不错的。

文章转自:https://my.oschina.net/OutOfMemory/blog/1510101

作者:@ksfzhaohui

## 前言

JMS的发布订阅机制也能实现类似的功能,集群节点通过订阅指定的节点,同时使用JMS对消息的过滤器功能,实现对指定参数的更新,本文将介绍通过JMS实现简单的参数集中式管理。

## Maven引入

Spring相关的jar引入参考上一篇文章

```xml

<dependency>

<groupId>javax.jms</groupId>

<artifactId>jms</artifactId>

<version>1.1</version>

</dependency>

<dependency>

<groupId>org.apache.activemq</groupId>

<artifactId>activemq-all</artifactId>

<version>5.10.0</version>

</dependency>

```

## 目标

1. 可以同时配置监听多个节点如/app1,/app2;

2. 希望只需要配置如/app1,就能够监听其子节点如/app1/modual1以及子节点的子节点如/app1/modual1/xxx/…;

3. 服务器启动能获取当前指定父节点下的所有子节点数据;

4. 在添加节点或者在更新节点数据的时候能够动态通知,这样代码中就能够实时获取最新的数据;

5. spring配置中可以从Zookeeper中读取参数进行初始化。

虽然在实现的方式上有点区别,但是最终达成的目标是一致的,同样列出了这5条目标

## 实现

MQWatcher主要用来和JMS建立连接,同时订阅指定节点,建立点对点连接,过滤出需要监听的数据,更新数据,初始化数据,存储数据等

InitConfServer主要作为点对点连接的服务器端用来初始化数据

1.同时配置监听多个节点

提供一个字符串数组给用户用来添加需要监听的节点:

```java

private String[] keyPatterns;

```

2.能够监听其子节点以及子节点的子节点

使用了一种和Zookeeper不一样的方式,JMS的方式是将所有的数据变更都发送到订阅者,然后订阅者通过过滤出需要的数据进行更新

```java

/** MQ的过滤器 **/

private StringBuffer keyFilter = new StringBuffer();

private final String TOPIC = "dynamicConfTopic";

private void watcherPaths() throws JMSException {

Topic topic = session.createTopic(TOPIC);

MessageConsumer consumer = session.createConsumer(topic, keyFilter.toString());

consumer.setMessageListener(new MessageListener() {

@Override

public void onMessage(Message message) {

try {

String key = message.getStringProperty(IDENTIFIER);

TextMessage tm = (TextMessage) message;

keyValueMap.put(key, tm.getText());

LOGGER.info("key = " + key + ",value = " + tm.getText());

} catch (JMSException e) {

LOGGER.error("onMessage error", e);

}

}

});

}

```

对TOPIC进行了订阅,并且指定了过滤器keyFilter,keyFilter正是基于keyPatterns组装而成的

```java

private final String IDENTIFIER = "confKey";

/**

* 生成接受过滤器

*/

private void generateKeyFilter() {

for (int i = 0; i < keyPatterns.length; i++) {

keyFilter.append(IDENTIFIER + " LIKE '" + keyPatterns[i] + "%'");

if (i < keyPatterns.length - 1) {

keyFilter.append(" OR ");

}

}

LOGGER.info("keyFilter : " + keyFilter.toString());

}

```

对指定的属性IDENTIFIER,通过LIKE和OR关键字进行过滤

3.服务器启动初始化节点数据

通过点对点的方式,在服务器启动时通过请求响应模式来获取初始化数据

```java

private final String QUEUE = "dynamicConfQueue";

/**

* 初始化key-value值

*

* @throws JMSException

*/

private void initKeyValues() throws JMSException {

TemporaryQueue responseQueue = null;

MessageProducer producer = null;

MessageConsumer consumer = null;

Queue queue = queueSession.createQueue(QUEUE);

TextMessage requestMessage = queueSession.createTextMessage();

requestMessage.setText(generateKeyString());

responseQueue = queueSession.createTemporaryQueue();

producer = queueSession.createProducer(queue);

consumer = queueSession.createConsumer(responseQueue);

requestMessage.setJMSReplyTo(responseQueue);

producer.send(requestMessage);

MapMessage receiveMap = (MapMessage) consumer.receive();

@SuppressWarnings("unchecked")

Enumeration<String> mapNames = receiveMap.getPropertyNames();

while (mapNames.hasMoreElements()) {

String key = mapNames.nextElement();

String value = receiveMap.getStringProperty(key);

keyValueMap.put(key, value);

LOGGER.info("init key = " + key + ",value = " + value);

}

}

```

通过对指定QUEUE请求,同时建立一个临时的响应QUEUE,然后接受一个MapMessage,用来初始化keyValueMap

4.监听节点数据的变更

通过发布订阅模式,接受所有数据,然后进行过滤,目标2中已经有相关实现

5.spring配置中可以从Zookeeper中读取参数进行初始化

```java

public class MQPropPlaceholderConfigurer extends PropertyPlaceholderConfigurer {

private MQWatcher mqwatcher;

@Override

protected Properties mergeProperties() throws IOException {

return loadPropFromMQ(super.mergeProperties());

}

/**

* 从MQ中加载配置的常量

*

* @param result

* @return

*/

private Properties loadPropFromMQ(Properties result) {

mqwatcher.watcherKeys();

mqwatcher.fillProperties(result);

return result;

}

}

```

通过以上的处理,可以使用如下简单的配置来达到目标:

```xml

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xmlns:aop="http://www.springframework.org/schema/aop"

xmlns:tx="http://www.springframework.org/schema/tx"

xsi:schemaLocation="http://www.springframework.org/schema/aop http://www.springframework.org/schema/aop/spring-aop-3.0.xsd

http://www.springframework.org/schema/beans http://www.springframework.org/schema/beans/spring-beans-3.0.xsd

http://www.springframework.org/schema/tx http://www.springframework.org/schema/tx/spring-tx-3.0.xsd">

<bean id="person" class="zh.maven.DynamicConf.Person">

<property name="name">

<value>${/a2/m1}</value>

</property>

<property name="address">

<value>${/a3/m1/v2}</value>

</property>

<property name="company">

<value>${/a3/m1/v2/t2}</value>

</property>

</bean>

<bean id="mqwatcher" class="zh.maven.DynamicConf.mq.MQWatcher">

<property name="keyPatterns" value="/a2,/a3" />

</bean>

<bean id="propertyConfigurer" class="zh.maven.DynamicConf.mq.MQPropPlaceholderConfigurer">

<property name="mqwatcher" ref="mqwatcher"></property>

</bean>

</beans>

```

## 测试

1.启动ActiveMQ

```

activemq.bat

```

2.InitConfServer启动

用来监听集群节点的初始化请求,获取到集群节点发送来的keyPatterns,然后将符合其模式的数据封装成MapMessage发送给集群节点

```java

@Override

public void onMessage(Message message) {

try {

TextMessage receiveMessage = (TextMessage) message;

String keys = receiveMessage.getText();

LOGGER.info("keys = " + keys);

MapMessage returnMess = session.createMapMessage();

returnMess.setStringProperty("/a2/m1", "zhaohui");

returnMess.setStringProperty("/a3/m1/v2", "nanjing");

returnMess.setStringProperty("/a3/m1/v2/t2", "zhaohui");

QueueSender sender = session.createSender((Queue) message.getJMSReplyTo());

sender.send(returnMess);

} catch (Exception e) {

LOGGER.error("onMessage error", e);

}

}

```

以上代码只是进行了简单的模拟,提供了一个思路

3.启动Main类

```java

public class Main {

public static void main(String[] args) throws Exception {

ApplicationContext context = new ClassPathXmlApplicationContext(new String[] { "spring-config.xml" });

Person person = (Person) context.getBean("person");

System.out.println(person.toString());

}

}

```

4.启动TopicPublisher

定时发布数据,同时查看集群节点的Main类日志输出

```java

public class TopicPublisher {

private static final String TOPIC = "dynamicConfTopic";

private static final String IDENTIFIER = "confKey";

public static void main(String[] args) throws JMSException {

ActiveMQConnectionFactory factory = new ActiveMQConnectionFactory("tcp://localhost:61616");

Connection connection = factory.createConnection();

connection.start();

Session session = connection.createSession(false, Session.AUTO_ACKNOWLEDGE);

Topic topic = session.createTopic(TOPIC);

MessageProducer producer = session.createProducer(topic);

producer.setDeliveryMode(DeliveryMode.NON_PERSISTENT);

int i=1;

while (true) {

TextMessage message = session.createTextMessage();

message.setStringProperty(IDENTIFIER, "/a2/"+i);

message.setText("message_" + System.currentTimeMillis());

producer.send(message);

System.out.println("Sent message: " + message.getText());

try {

Thread.sleep(2000);

} catch (InterruptedException e) {

e.printStackTrace();

}

i++;

}

}

}

```

日志输出如下:

```log

2017-08-14 21:52:23 - keyFilter : confKey LIKE '/a2%' OR confKey LIKE '/a3%'

2017-08-14 21:52:24 - init key = /a3/m1/v2/t2,value = zhaohui

2017-08-14 21:52:24 - init key = /a3/m1/v2,value = nanjing

2017-08-14 21:52:24 - init key = /a2/m1,value = zhaohui

2017-08-14 21:52:24 - Pre-instantiating singletons in org.springframework.beans.factory.support.DefaultListableBeanFactory@223dd567: defining beans [person,mqwatcher,propertyConfigurer]; root of factory hierarchy

name = zhaohui,address = nanjing,company = zhaohui

2017-08-14 21:52:33 - key = /a2/1,value = message_1502718753819

2017-08-14 21:52:35 - key = /a2/2,value = message_1502718755832

2017-08-14 21:52:37 - key = /a2/3,value = message_1502718757846

2017-08-14 21:52:39 - key = /a2/4,value = message_1502718759860

2017-08-14 21:52:41 - key = /a2/5,value = message_1502718761876

```

## 总结

通过JMS实现了一个简单的参数化平台系统,当然想在生产中使用还有很多需要优化的地方,本文在于提供一个思路;后续有时间准备对DynamicConf提供更加完善的方案。 | 9,205 | MIT |

<!--

* @Author: your name

* @Date: 2021-01-27 14:31:52

* @LastEditTime: 2021-02-22 17:31:07

* @LastEditors: Please set LastEditors

* @Description: In User Settings Edit

* @FilePath: \electron-serialport-start\README.md

-->

## electron 和 serialport 项目整合(编译打包成安装包全流程)

项目地址: 项目地址: https://github.com/han-guang-xue/electronSerialport

下载项目

```shell

cnpm|npm install #安装包依赖

npm run rebuild #编译serialport文件

npm run builder #打包并发布

```

## 使用 electron-builder 打包碰见的问题

碰见的问题:

1. 在使用 electron-rebuild 重新编译之后开发环境中是正常使用,但是 electron-build 打包之后,串口连接返回错误状态码(electron 版本是 9.0.5)

解决方案: 替换 electron 版本为 11.1.0

2. 替换 electron 版本为 11.1.0 之后, 直接使用 electron-builder 编译打包, 串口接口使用报错; 报错信息:

```java

TypeError: Third argument must be a function

at internal/util.js:297:30

at new Promise (<anonymous>)

at open (internal/util.js:296:12)

at WindowsBinding.open (C:\Program Files\client\resources\app\node_modules\serialport\node_modules\@serialport\bindings\lib\win32.js:56:22)

at processTicksAndRejections (internal/process/task_queues.js:97:5)

```

解决方案: 在 package.json 中的 build 中配置 `"buildDependenciesFromSource":true,`

```json

"build": {

"directories": {"output":"E:\\YCXGIT\\building\\build17"},

"asar":false,

"buildDependenciesFromSource":true,

"appId": "com.vasen.serialport",

"mac": {

"target": [

"dmg"

]

},

"win": {

"target": [

"nsis"

]

},

"nsis": {

"oneClick": false,

"perMachine": true,

"allowElevation": true,

"allowToChangeInstallationDirectory": true

}

},

```

## electron 实现单例程序

该方式只针对 electron@3 以上的

```JavaScript

const getTheLock = app.requestSingleInstanceLock()

if (!getTheLock) {

app.quit()

return

} else {

app.on('second-instance', (event, commandLine, workingDirectory) => {

//isMinimized 判断窗口是否最小化

if (loginWin) {

if (loginWin.isMinimized()) loginWin.restore()

loginWin.focus() //聚焦

}

if (mainWin) {

if (mainWin.isMinimized()) mainWin.restore()

mainWin.focus()

}

})

app.on('ready', createLoginWin)

}

```

## electron 中如何使用 jquery, 去除 require 导入模块引起的冲突

在创建窗体的时候添加属性 `nodeIntegration: false`

```JavaScript

webPreferences: {

nodeIntegration: false

}

``` | 2,260 | CC0-1.0 |

---

layout: post

title: "设计模式:观察者模式"

subtitle: "观察者模式"

date: 2016--08-21 15:20:00

author: "Lushun"

header-img: "img/post-bg-2015.jpg"

catalog: true

tags:

- 设计模式

---

## 设计原则

为了交互对象的松耦合设计而努力。

## 定义

定义了对象之间的一对多依赖,这样一来,当一个对象改变状态时,它的所有依赖者都会收到通知并自动更新。

## 类图

## 代码

{% highlight ruby %}

public interface Subject {

void addObserver(Observer observer);

void removeObserver(Observer observer);

void notifyObservers();

}

public class WeatherSubject implements Subject {

private double temprature;

private double humidity;

private double pressure;

/*

* 增加heat属性,只需要修改这个WeatherSubject类,和Test测试类,不需要修改观察者类。

*/

private double heat;

private List<Observer> observers = new ArrayList<>();

public WeatherSubject() {

super();

}

public WeatherSubject(double temprature, double humidity, double pressure,double heat) {

super();

this.temprature = temprature;

this.humidity = humidity;

this.pressure = pressure;

this.heat = heat;

}

@Override

public void addObserver(Observer observer) {

observers.add(observer);

}

@Override

public void removeObserver(Observer observer) {

int index = observers.indexOf(observer);

if(index>=0)

observers.remove(index);

}

@Override

public void notifyObservers() {

for(Observer observer : observers)

observer.update();

}

public void measurementsChanged(){

notifyObservers();

}

@Override

public String toString() {

return "WeatherSubject [temprature=" + temprature + ", humidity="

+ humidity + ", pressure=" + pressure + ", heat=" + heat + "]";

}

}

public interface Observer {

public void update();

public void unregitst(Subject subject);

public void regist(Subject subject);

}

public interface Displayable {

public void display();

}

public class ConcurrentConditionObserver implements Observer, Displayable {

private Subject subject;

public ConcurrentConditionObserver(Subject subject) {

super();

this.subject = subject;

this.subject.addObserver(this);

}

public Subject getSubject() {

return subject;

}

public void setSubject(Subject subject) {

this.subject = subject;

}

@Override

public void display() {

System.out.println(subject.toString());

}

@Override

public void update() {

System.out.println("更新当前天气板:"+subject);

display();

}

@Override

public void unregitst(Subject subject) {

this.subject.removeObserver(this);

}

@Override

public void regist(Subject subject) {

setSubject(subject);

subject.addObserver(this);

}

}

public class ForecastObserver implements Observer, Displayable {

private Subject subject;

public ForecastObserver(Subject subject) {

super();

this.subject = subject;

this.subject.addObserver(this);

}

public Subject getSubject() {

return subject;

}

public void setSubject(Subject subject) {

this.subject = subject;

}

@Override

public void display() {

System.out.println(subject.toString());

}

@Override

public void update() {

System.out.println("更新了天气预告板:"+subject.getClass());

display();

}

@Override

public void unregitst(Subject subject) {

this.subject.removeObserver(this);

}

@Override

public void regist(Subject subject) {

setSubject(subject);

subject.addObserver(this);

}

}

{% endhighlight %} | 3,585 | Apache-2.0 |

### # 文本<a id="文本"></a>

> 数据绑定最常见的形式就是使用“Mustache”语法 (双大括号) 的文本插值:

`<span>{{message}}</span>`

`v-once指令`数据只会在页面创建的时候插入一次,update时不再改变

```html

<!--

Vue 会`响应式`刷新

每当数据更新,Mustache中的变量都会更新。

可以通过v-once指令,实现只插入一次。

-->

<span v-once>{{message}}</span>

```

### # HTML<a id="文本"></a>

> 默认情况下Mustache会将HTML渲染成文本,为了渲染真的HTML,需要使用`v-html指令`

```html

<p>Using mustaches: {{ rawHtml }}</p>

<p>Using v-html directive: <span v-html="rawHtml"></span></p>

```

> <div id="app-1">

<p>Using mustaches: {{ rawHtml }}</p>

<p>Using v-html directive: <span v-html="rawHtml"></span></p>

</div>

### # Attribute<a id="Attribute"></a>

Mustache 语法不能作用在 HTML attribute 上,遇到这种情况应该使用 `v-bind` 指令:

> 即不能这么使用:

`<span id="{{id}}"></span>`

> 遇到这种情况要使用指令

> `<span v-bind:id="id"></span>`

对于布尔 attribute (它们只要存在就意味着值为 `true`),`v-bind` 工作起来略有不同,在这个例子中:

`<button v-bind:disabled="isButtonDisabled"></button>`

> <div id="app-2">

<button v-bind:disabled="isButtonDisabled1">不能使用</button>

<button v-bind:disabled="isButtonDisabled2">可以使用</button>

</div>

### # 使用JavaScript表达式<a id="使用JavaScript表达式"></a>

> `JavaScript`原生的一些方法

例如:

```html

{{number + 1}}

{{ok ? 'yes' : 'no'}}

{{message.split('').reverse.join('')}}

<div v-bind:id="'list-' + id"></div>

```

> <div id="app-3">

<p>number: {{number}}</p>

<p>number + 1: {{number + 1}}</p>

<p>ok: {{ok}}</p>

<p>ok: {{ok ? 'yes' : 'no'}}</p>

<p>message: {{message}}</p>

<p>message reverse: {{message.split('').reverse().join('')}}</p>

</div>

每个绑定的表达式必须是单个表达式,所以一些不会被解析。

```html

<!-- 这是语句,不是表达式 -->

{{ var a = 1 }}

<!-- 流控制也不会生效,请使用三元表达式 -->

{{ if (ok) { return message } }}

```

<script>

new Vue({

el: '#app-1',

data: {

rawHtml: '<span>测试插入原生HTML</span>'

}

});

new Vue({

el: '#app-2',

data: {

isButtonDisabled1: true,

isButtonDisabled2: false,

}

});

new Vue({

el: '#app-3',

data: {

number: 2,

ok: true,

message: 'this is some text!!!',

}

});

</script> | 2,008 | MIT |

# Typeh<img src="../images/title-logo.png" align="top" width="24px">le

为所有运行时可序列化的值自动生成 Typescript 类型和接口

[English](../README.md) | [简体中文](#)

Typehole 是 Visual Studio Code 的 TypeScript 开发工具,它通过将运行时的值从 Node.js 或浏览器应用程序中桥接到代码编辑器来自动创建静态类型。当您需要 API 响应的类型或想要得到来自 JS 模块值的类型时,它是非常有用的。

<br/>

<br/>

## 安装

安装 [Visual Studio Code - extension](https://marketplace.visualstudio.com/items?itemName=rikurouvila.typehole) 即可,不需要额外的构建工具或编译器插件。

## 它是如何工作的?

1. 从一个接口中获得 `any` / `unknown` 类型的值的类型。

```typescript

const response = await axios.get("https://reddit.com/r/typescript.json");

const data /* any */ = response.data;

```

2. 通过选择表达式并按 ⌘ + 打开 **Quick Fix** 菜单,将值放置在 typeholes 中。 (macOS) 或 ctrl + . (Windows) 并选择 **Add a typehole**。

```typescript

type RedditResponse = any; // 由扩展插入的类型占位符

const response = await axios.get("https://reddit.com/r/typescript.json");

const data: RedditResponse = typehole.t(response.data);

```

3. 在浏览器或 Node.js 中运行您的代码。 Typehole 会在运行时捕获该值并将其发送回您的代码编辑器。VSCode 扩展会记录捕获的值,将来自该 typehole 的所有值转换为一个 interface 并将其插入到同一个模块中。

```typescript

interface RedditResponse {

/* ✨ 实际的字段和类型是自动生成的 ✨ */

}

const response = await axios.get("https://reddit.com/r/typescript.json");

const data: RedditResponse = typehole.t(response.data);

```

4. 移除 typehole,就完成了所有的操作。 Typeholes 仅用于开发阶段,所以您不应该提交它们。 Typehole 为您提供了 2 个 [命令](#命令) 来轻松移除 typehole

```typescript

interface RedditResponse {

/* ✨ 实际的字段和类型是自动生成的 ✨ */

}

const response = await axios.get("https://reddit.com/r/typescript.json");

const data: RedditResponse = response.data;

```

这个插件任然是实验性质的,如有问题请反馈 issues

## 特性

- 从运行中的值生成 Typescript 类型

- 使用不同的值多次运行代码,从而增加您的类型<br/><br/><img width="500" src="../images/samples.gif" />

- 使用代码操作将值自动包装到 typeholes<br/><br/><img width="500" src="../images/code-action.png" />

### 值能够自动的被转换为类型

所有原始值和 JSON 可序列化的值。

- Booleans

- Numbers

- Strings

- Arrays

- Objects

- null

因此,您可以其作为 HTTP 请求有效负载,接收的所有值都可以转换为 interface。

从 1.4.0 开始,支持 Promise。所有其他值(函数等)将被输入为 `any`。

## 命令

- 默认情况下不需要手动启动和停止服务器。 添加第一个 typehole 后,服务器将启动。

## 扩展设置

| 设置 | 类型 | 默认值 | 描述 |

| ------------------------------- | ----------------- | --------- | ------------------------------------------------ |

| typehole.runtime.autoInstall | boolean | true | 添加第一个 typehole 时自动安装 Typehole 运行时包 |

| typehole.runtime.projectPath | string | | 安装 Typehole 运行时的项目目录 |

| typehole.runtime.packageManager | npm \| yarn | npm | 安装运行时使用的包管理器 |

| typehole.runtime.extensionPort | number | 17341 | 监听传入示例的 HTTP 扩展的 HTTP 端口 |

| typehole.typeOrInterface | interface \| type | interface | 生成类型的关键字 |

## 运行时

Typehole 运行时的工作是捕获代码中的值,并将它们以序列化格式发送给扩展。

```typescript

import typehole from "typehole";

// -> POST http://extension/samples {"id": "t", "sample": "value"}

typehole.t("value");

// -> POST http://extension/samples {"id": "t1", "sample": 23423.432}

typehole.t1(23423.432);

// -> POST http://extension/samples {"id": "t2", "sample": {"some": "value"}}

typehole.t2({ some: "value" });

```

typehole 是通过您的 typehole 调用的方法名来识别的。 调用 `.t2()` 的时候会给这个 hole 一个 id "t2".因为 ids 的存在, 所以扩展知道值来自代码中的什么地方。

大部分情况下, 你应该为所有的 holes 使用唯一的 id. 然而, 如果您希望将许多 holes 中的值记录到同一类型中,您可以使用相同的 id。

有时候, 扩展可能与您的代码不在同一台主机上运行, 你想配置运行时发送值的地址。 在 Docker 容器内运行的 Node.js 应用程序就是这样一种情况。但是,在大多数情况下,您不需要配置任何内容。

```typescript

import typehole, { configure } from "typehole";

configure({

extensionHost: "http://host.docker.internal:17341",

});

```

### 可用的运行时设置

| 设置 | 类型 | 默认值 | 描述 |

| ------------- | ------ | ---------------------- | -------------------------- |

| extensionHost | string | http://localhost:17341 | 扩展 HTTP 监听器的运行地址 |

## 已知问题

- Typehole 服务器不能在 2 个 VSCode 编辑器中同时运行,因为服务器端口硬编码为 17341

## 发行说明

## [1.7.0] - 2021-07-08

### Added

- 新选项”typehole.typeOrInterface"添加用于使用' type '关键字而不是' interface '。 这一切都归功于 @akafaneh 🎉

## [1.6.3] - 2021-06-20

### Fixed

- 修复代码格式生成损坏/重复的代码

## [1.6.2] - 2021-05-22

### Fixed

- 修复了将字段标记为可选的空值。 `[{"foo": null}, {"foo": 2}]` 现在生成一个 type `{foo: null | number}[]` 而不是像以前一样生成 `{foo?: number}[]`. 应该被修复 [#14](https://github.com/rikukissa/typehole/issues/14)

## [1.6.1] - 2021-05-22

### Fixed

- 修复插入了类型的文件的自动格式化

## [1.6.0] - 2021-05-20

### Added

- 用于配置扩展服务器端口和运行时主机地址的选项。 地址 [#13](https://github.com/rikukissa/typehole/issues/13)

## [1.5.1] - 2021-05-18

### Fixed

- 多个 typeholes 可以使用同一个 id。 它们的每一次更新都会更新附加到孔上的所有类型。 例如,当您希望有多个 typeholes 更新相同的类型时,这很有用。

- 当生成的顶层类型是一个 `ParenthesizedType` 的时候,不会再有重复的 interfaces。

- 当 interface 和 typehole 不在同一个文件的时候,interface 不会更新。

- 当编辑器中聚焦其他文件时,类型不会更新。

- `typehole.tNaN` [issue](https://github.com/rikukissa/typehole/issues/7) 当有非`t<number>`格式的 typeholes 的时候

## [1.5.0] - 2021-05-15

### Added

- 支持推断 Promises 👀

### Fixed

- 如果你的代码中有 typehole,那么 runtime 也会在启动时安装

- AutoDiscoveredN 类型不再重复

## [1.4.1] - 2021-05-09

### Fixed

- 非序列化的诊断现在每个 typehole 只显示一次。 以前,工具提示可能有多次相同的警告。

- 删除所有的 typeholes 后,服务器会停止。重新启动服务器现在也可以工作。

### Added

## [1.4.0] - 2021-05-09

### Added

- 样本收集。 为一个 typehole 提供多个不同的值,生成的类型将基于这些值进行优化。

## [1.3.0] - 2021-05-08

### Added

- 项目路径、包管理器和是否应该自动安装运行时的配置选项

## [1.1.0] - 2021-05-08

### Added

- 所有生成的接口和类型别名的自动 PascalCase 转换

---

**尽情畅享!** | 5,431 | MIT |

---

layout: post # 使用的布局(不需要改)

title: Lychee自建图床配置教程 # 标题

subtitle: 基于Apache2+PHP+MariaDB #副标题

date: 2020-01-21 # 时间

author: zhaiyunfan # 作者

header-img: img/post-cover-Lychee.jpg #这篇文章标题背景图片

catalog: true # 是否归档

tags: #标签

- 教程

- Apache2

- PHP

- MariaDB

- Ubuntu

- Lychee

---

## 前言

对于一个*blog*来说,图文并茂是最基本的要求。*GitHub Page*没办法把做到把repo中的图片插入并显示到正文中 ~~也不应该,因为很不优雅~~ 所以一个可以上传图片并提供外链的图床就成了必需品。

免费的图床稳定性堪忧,付费服务对于学生来说性价比又有一点低,于是在*GitHub*上找了很久之后,锁定了[*Lychee*](https://github.com/LycheeOrg/Lychee)这套开源图床

于是也就理所应当的在阿里云用上了学生特惠的低价服务器 ~~感谢马云爸爸~~ 。配置的过程本来以为很简单,但在因为不熟悉*Linux*系统和整套*PHP*+*Nginx*+*MySQL*体系的缘故,前前后后踩了好几天的坑

为了方便后来人,这里提供一套已经在*Ubuntu16.04*环境下完整测试保证正常的配置流程,其中,弃用了原本性能更强的*Nginx*框架改用了*PHP*下配置更友好的*Apache2* *web*服务器,你只需要跟着整个安装步骤走,就一定可以正确的配置好属于你的个人图床

>注意:[*Lychee*](https://github.com/LycheeOrg/Lychee)现在有更新的[*Lychee-Laravel*](https://github.com/LycheeOrg/Lychee-Laravel),下文中所有提及*Lychee*处所指均为*Lychee-Laravel*,所配置的网站亦基于后者,如果你遇到意料之外的错误,既可以在评论区与我沟通,也可以在[*Lychee-Laravel*](https://github.com/LycheeOrg/Lychee-Laravel)处查阅*LycheeOrg*提供的*wiki*,如果这依然没有解决你的问题,你可以访问[他们的讨论组](https://gitter.im/LycheeOrg/Lobby)来求教,社区中的维护者们都非常nice! ~~没有嫌弃我糟糕的散装英语~~

那么,让我们开始吧!

## 预备工作

>这里以阿里云上标准的*ECH*服务器为例,预装环境为*Ubuntu16.04*,由于各人可能使用不同的云服务 ~~如腾讯云~~ 这里不再赘述服务器的申请过程。同时由于现在各家云服务的控制台操作已经基本傻瓜化,我们假定你已经使用SSH连接上了你的服务器

在利用*SSH*远程连接到你的服务器上之后,会自动启动一个终端

由于整个服务器刚刚初始化,在配置网站环境前需要先更新一下你的本地包索引,保证可以获取最新的软件

先后应用以下两个命令

apt-get update

apt-get upgrade

>关于这两个命令的意义和区别,总的来说,*apt-get update*就是访问服务器,更新可获取软件及其版本信息,但仅仅给出一个可更新的list,具体更新需要使用*apt-get upgrade*,此命令可以执行你已安装的全部软件的更新操作

如果没有报错则是更新成功,可以进行环境的配置工作

## 安装工作

### 安装*Apache2*

>*Apache2 HTTP*服务器是世界上使用最广泛的*Web*服务器。它提供了许多强大的功能,包括动态加载模块,强大的媒体支持,以及与其他流行软件的广泛集成。在这个项目的部署中我们使用*Apache2*而非性能更强的*Nginx*的原因是前者配置时更友好

使用*apt-get*命令可以很方便的安装*Apache2*,更新完本地包索引后直接使用命令:

apt-get install apache2

确认安装后,*apt-get*将安装*Apache2*和所有必需的依赖项。

如果没有报错则是安装成功,使用命令:

service apache2 status

确认一下*Apache2*的运行状态,如果返回类似于:

● apache2.service - LSB: Apache2 web server

Loaded: loaded (/etc/init.d/apache2; bad; vendor preset: enabled)

Drop-In: /lib/systemd/system/apache2.service.d

└─apache2-systemd.conf

Active: active (running) since Tue 2020-01-21 13:38:25 CST; 44min ago

Docs: man:systemd-sysv-generator(8)

CGroup: /system.slice/apache2.service

├─3298 /usr/sbin/apache2 -k start

├─3301 /usr/sbin/apache2 -k start

└─3302 /usr/sbin/apache2 -k start

则证明运行正常,此时可以直接在浏览器地址栏直接输入你服务器的**ip地址**,如果显示了*Apache2*的默认欢迎界面,则证明配置成功;如果访问失败,则需要更改你云端服务器防火墙的安全策略,这块的步骤将在后文讲述*MariaDB*的配置方法时介绍,如果需要你可以先直接跳到后面那节来先配置好

### 安装*PHP*

运行以下命令:

apt-get install software-properties-common

apt-get install python-software-properties

add-apt-repository ppa:ondrej/php && sudo apt-get update

>上面这三步是在安装必要的依赖项。由于我使用的阿里云镜像默认最高只能安装*PHP7.0*,而Lychee最低需要*PHP7.1*才能正常运行,所以这里添加了*PHP*官方的*ppa*软件源以直接获取目标版本的*PHP*

apt install libapache2-mod-php7.3

>这一步安装了*Apache2*的*PHP7.3*模块本体,安装完成之后可以使用命令:

php -v

来确认*PHP*的安装情况,如果显示类似于:

PHP 7.3.13-1+ubuntu16.04.1+deb.sury.org+1 (cli) (built: Dec 18 2019 14:48:32) ( NTS )

Copyright (c) 1997-2018 The PHP Group

Zend Engine v3.3.13, Copyright (c) 1998-2018 Zend Technologies

with Zend OPcache v7.3.13-1+ubuntu16.04.1+deb.sury.org+1, Copyright (c) 1999-2018, by Zend Technologies

的结果则证明安装成功,上文结果显示已安装了*PHP7.3*,这是*Lychee*官方推荐的版本

然后安装之后从*GitHub*拉取*Lychee*必备的*Git*模块

apt install git

安装完成后开始安装Lychee必备的几个*PHP*模块,分别是:

apt install php7.3-mysql

apt install php7.3-imagick

apt install php7.3-mbstring

apt install php7.3-json

apt install php7.3-gd

apt install php7.3-xml

apt install php7.3-zip

这里安装完后可以使用:

php -m

命令显示全部已安装模块,来确认一下是否安装了全部必需的模块,这里包括:

session exif mbstring gd mysqli json zip imagick

全部安装完成后顺便安装一下*Lychee*展开安装时必备的软件,其中最重要的就是*Composer*

>*Composer*是*PHP*的一个依赖管理工具。我们可以在项目中声明所依赖的外部工具库,*Composer*会帮你安装这些依赖的库文件,有了它,我们就可以很轻松的使用一个命令将其他人的优秀代码引用到我们的项目中来。

为了安装*Composer*,我们一般会直接使用:

apt-get install composer

但是对于阿里云这里有一些问题:阿里云默认的镜像中,即使执行了命令:

apt-get update

apt-get upgrade

*apt*能自动安装的*Composer*的最新版本仍为*1.0.0(beta)*,而且无法更新!而当极低版本的*Composer*搭配高版本的*PHP*如*PHP7*时,由于在版本更迭中*PHP*的语法已发生了一些变化,*Composer*完全处于无法使用的状态,不论你执行什么命令,都会跳出*ERROR*:

[ErrorException]

"continue" targeting switch is equivalent to "break". Did you mean to use "continue 2"?

所以为了从源头上规避这一问题,我们使用**阿里云提供的全量镜像**进行手动安装

首先使用此命令进行下载:

curl -O https://mirrors.aliyun.com/composer/composer.phar

从阿里云下载*Composer*本体完成后,使用此命令重命名:

mv composer.phar composer

接着添加可执行权限:

chmod +x composer

最后将该文件放到/usr/local/bin下:

mv composer /usr/local/bin

这样就安装完成了,可以直接使用composer命令,在终端输入:

composer

如果正常显示了*Composer*的欢迎界面,即表明功能正常

而对于国内用户来说,在*Composer*的使用过程中官方源的下载速度实在令人难以恭维,所以可以使用国内的镜像,这里以阿里云镜像为例,推荐进行全局配置(所有项目都会使用该镜像地址):

composer config -g repo.packagist composer https://mirrors.aliyun.com/composer/

没有*ERROR*则为安装正常

注:此处可能提醒:

Do not run Composer as root/super user! See https://getcomposer.org/root for details

这是一个安全性提醒,你输入的命令仍会被正常执行,但使用*root*用户使用*Composer*

确实是不安全的,这里推荐读者访问[该界面](https://getcomposer.org/root)进行进一步的了解

接着安装一下unzip模块

apt-get install unzip

以备后用

至此*PHP*的基础安装就完成了,稍后还需进一步配置

### 安装Mariadb

>MariaDB数据库管理系统是*MySQL*的一个分支,主要由开源社区在维护,采用*GPL*授权许可*。MariaDB*的目的是完全兼容*MySQL*,包括API和命令行,使之能轻松成为*MySQL*的代替品。

在本项目中我们使用*MariaDB*替代标准*MySQL*,来提供数据库支持。若想安装*MariaDB*,运行命令:

apt install mariadb-server

即可直接通过*apt*安装*MariaDB*

## 配置工作

安装完毕后我们仍需对环境进行进一步配置才能拉取*Lychee*

### 配置*PHP*

在[*Lychee-Laravel*](https://github.com/LycheeOrg/Lychee-Laravel)的*GitHub*主页上,推荐修改*PHP*的配置文件以保证上传图片时文件大小上限得到合理配置,如下文:

To use Lychee without restrictions, we recommend to increase the values of the following properties in php.ini. If you are processing large photos or videos, you may need to increase them further.

max_execution_time = 200

post_max_size = 100M

upload_max_filesize = 20M

memory_limit = 256M

使用以下命令,按上文修改你的*PHP*配置:

vim /etc/php/7.3/cli/php.ini

>准确来说这里应当修改你自己服务器上的、正在使用中的版本的*PHP*的*php.ini*文件,所以你需要修改的文件所在路径可能会与我给出的不同。这里假定你完全按照我描述的步骤操作,那么你的安装路径理应和我相同,则按我的命令修改指定文件理应也不会出错

### 配置*MariaDB*

在这一步中,我们预先在*MariaDB*中为*Lychee*创建一个数据库,并为之创建权限足够的用户

使用命令访问*MariaDB*:

mysql

如果显示类似以下字样:

Welcome to the MariaDB monitor. Commands end with ; or \g.

Your MariaDB connection id is 42

Server version: 10.0.38-MariaDB-0ubuntu0.16.04.1 Ubuntu 16.04

Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

则你已经正常安装MariaDB并且已进入了其控制台,接下来创建Lychee的*Database*和*user*,先后使用以下命令:

create database lychee;

CREATE USER lychee@localhost IDENTIFIED BY 'password';

GRANT ALL ON *.* TO lychee@localhost WITH GRANT OPTION;

FLUSH PRIVILEGES;

其中*password*填你自己准备设置的密码

>以上四条语句的含义分别是:1.创建一个名为*lychee*的*database* 2.创建一个名为*lychee*的*user*,并将其密码设置为你自定义的*password* 3.给*user*:*lychee*全部权限 4.刷新缓存,确认修改

操作完成后可以使用命令:

show databases;

来显示所有*Database*,以确认是否创建成功,如果一切成功,使用命令:

exit;

可以退出*MariaDB*系统,返回终端

### 配置防火墙规则

>安全起见你的云服务供应商一般默认会关闭很多*高危端口*,而这里我们需要用其中的3306端口来远程访问*MySQL*,这里以阿里云为例

为了保证服务器的安全,阿里云的默认安全组会关闭*MySQL*和*MariaDB*远程连接时必需端口的入向访问(默认一般使用3306端口),为了允许客户机远程访问服务器数据库,需要修改安全组规则,按以下步骤操作

1. 进入阿里云服务器的控制台

2. 进入本实例安全组标签

3. 在安全组列表中找到本实例,点击配置规则

4. 选择快速创建规则

5. 在自定义端口处选择*TCP*,端口填3306

6. 授权对象填 *0.0.0.0/0*

7. 描述可以填*MySQL*以备忘

8. 确认修改

同理可以开放80、443以及一切你工程中需要开放的端口,不再赘述。使用*Navicat*等软件可以确认你的MariaDB数据库的访问情况,如果一切正常,至此,前期的所有预备环境的安装都已完成了

## 安装配置*Lychee*

准备好了一切必须的环境条件,现在安装并配置*Lychee*

首先从*GitHub*上*clone*整个*repo*,切换到目标路径后使用*Git*即可达成这一目标:

cd /var/www/html

git clone --recurse-submodules https://github.com/LycheeOrg/Lychee-Laravel.git

等待*clone*完成后,按照以下步骤:

首先切换到刚刚拉取下来的目录里,重命名*env*文件:

cd Lychee-Laravel

cp .env.example .env

# edit .env to match the parameters

然后使用vim编辑刚刚重命名的文件

vim .env

找到类似于下文的行:

DB_CONNECTION=mysql

DB_HOST=[你的数据库地址]

DB_PORT=[端口(3306)]

DB_DATABASE=[数据库]