id

int64 2.05k

16.6k

| title

stringlengths 5

75

| fromurl

stringlengths 19

185

| date

timestamp[s] | tags

sequencelengths 0

11

| permalink

stringlengths 20

37

| content

stringlengths 342

82.2k

| fromurl_status

int64 200

526

⌀ | status_msg

stringclasses 339

values | from_content

stringlengths 0

229k

⌀ |

|---|---|---|---|---|---|---|---|---|---|

8,516 | Samba 系列(九):将 CentOS 7 桌面系统加入到 Samba4 AD 域环境中 | http://www.tecmint.com/join-centos-7-to-samba4-active-directory/ | 2017-05-17T14:57:00 | [

"samba"

] | https://linux.cn/article-8516-1.html | 这篇文章讲述了如何使用 Authconfig-gtk 工具将 CentOS 7 桌面系统加入到 Samba4 AD 域环境中,并使用域帐号登录到 CentOS 系统。

### 要求

1、[在 Ubuntu 系统中使用 Samba4 创建活动目录架构](/article-8065-1.html)

2、[CentOS 7.3 安装指南](/article-8048-1.html)

### 第一步:在 CentOS 系统中配置 Samba4 AD DC

1、在将 CentOS 7 加入到 Samba4 域环境之前,你得先配置 CentOS 系统的网络环境,确保在 CentOS 系统中通过 DNS 可以解析到域名。

打开网络设置,关闭有线网卡。打开下方的设置按钮,手动编辑网络设置,指定 DNS 的 IP 地址为 Samba4 AD DC 服务器的 IP 地址。

设置完成之后,应用配置,并打开有线网卡。

*网络设置*

*配置网络*

2、下一步,打开网络配置文件,在文件末尾添加一行域名信息。这样能确保当你仅使用主机名来查询域中的 DNS 记录时, DNS 解析器会自动把域名添加进来。

```

$ sudo vi /etc/sysconfig/network-scripts/ifcfg-eno16777736

```

添加下面一行:

```

SEARCH="your_domain_name"

```

**

*网卡配置*

3、最后,重启网卡服务以应用更改,并验证解析器的配置文件是否正确配置。我们通过使用 ping 命令加上 DC 服务器的主机名或域名以验证 DNS 解析能否正常运行。

```

$ sudo systemctl restart network

$ cat /etc/resolv.conf

$ ping -c1 adc1

$ ping -c1 adc2

$ ping tecmint.lan

```

*验证网络配置是否正常*

4、同时,使用下面的命令来配置你的主机名,然后重启计算机以应用更改:

```

$ sudo hostnamectl set-hostname your_hostname

$ sudo init 6

```

使用下面的命令来验证主机名是否正确配置:

```

$ cat /etc/hostname

$ hostname

```

5、最后一步配置是使用下面的命令来保证系统时间跟 Samba4 AD DC 服务器的时间同步:

```

$ sudo yum install ntpdate

$ sudo ntpdate -ud domain.tld

```

### 第二步:安装要加入 Samba4 AD DC 所必需的软件包

6、为了将 CentOS 7 加入到活动目录域中,你需要使用下面的命令来安装相关的软件包:

```

$ sudo yum install samba samba samba-winbind krb5-workstation

```

7、最后,安装 CentOS 软件库中提供的图形化界面软件包: Authconfig-gtk 。该软件用于将 CentOS 系统集成到域环境中。

```

$ sudo yum install authconfig-gtk

```

### 第三步:将 CentOS 7 桌面系统集成到 Samba4 AD DC 域环境中

8、将 CentOS 加入到域的过程非常简单。使用有 root 权限的帐号在命令行下打开 Authconfig-gtk 程序,然后按下图所示修改相关配置即可:

```

$ sudo authconfig-gtk

```

打开身份或认证配置页面:

* 用户帐号数据库 : 选择 Winbind

* Winbind 域 : 你的域名

* 安全模式 : ADS

* Winbind ADS 域 : 你的域名.TLD

* 域控制器 : 域控服务器的全域名

* 默认Shell : /bin/bash

* 勾选允许离线登录

*域认证配置*

打开高级选项配置页面:

* 本地认证选项 : 支持指纹识别

* 其它认证选项 : 用户首次登录创建家目录

*高级认证配置*

9、修改完上面的配置之后,返回到身份或认证配置页面,点击加入域按钮,在弹出的提示框点保存即可。

*身份和认证*

*保存认证配置*

10、保存配置之后,系统将会提示你提供域管理员信息以将 CentOS 系统加入到域中。输入域管理员帐号及密码后点击 OK 按钮,加入域完成。

*加入 Winbind 域环境*

11、加入域后,点击应用按钮以让配置生效,选择所有的 windows 并重启机器。

*应用认证配置*

12、要验证 CentOS 是否已成功加入到 Samba4 AD DC 中,你可以在安装了 [RSAT 工具](/article-8097-1.html) 的 windows 机器上,打开 AD 用户和计算机工具,点击域中的计算机。

你将会在右侧看到 CentOS 主机信息。

*活动目录用户和计算机*

### 第四步:使用 Samba4 AD DC 帐号登录 CentOS 桌面系统

13、选择使用其它账户,然后输入域帐号和密码进行登录,如下图所示:

```

Domain\domain_account

或

[email protected]

```

**

*使用其它账户*

**

*输入域用户名*

14、在 CentOS 系统的命令行中,你也可以使用下面的任一方式来切换到域帐号进行登录:

```

$ su - domain\domain_user

$ su - [email protected]

```

**

*使用域帐号登录*

*使用域帐号邮箱登录*

15、要为域用户或组添加 root 权限,在命令行下使用 root 权限帐号打开 `sudoers` 配置文件,添加下面一行内容:

```

YOUR_DOMAIN\\domain_username ALL=(ALL:ALL) ALL #For domain users

%YOUR_DOMAIN\\your_domain\ group ALL=(ALL:ALL) ALL #For domain groups

```

**

*指定用户和用户组权限*

16、使用下面的命令来查看域控制器信息:

```

$ sudo net ads info

```

**

*查看域控制器信息*

17、你可以在安装了 Winbind 客户端的机器上使用下面的命令来验证 CentOS 加入到 Samba4 AD DC 后的信任关系是否正常:

```

$ sudo yum install samba-winbind-clients

```

然后,执行下面的一些命令来查看 Samba4 AD DC 的相关信息:

```

$ wbinfo -p ### Ping 域名

$ wbinfo -t ### 检查信任关系

$ wbinfo -u ### 列出域用户帐号

$ wbinfo -g ### 列出域用户组

$ wbinfo -n domain_account ### 查看域帐号的 SID 信息

```

**

*查看 Samba4 AD DC 信息*

18、如果你想让 CentOS 系统退出域环境,使用具有管理员权限的帐号执行下面的命令,后面加上域名及域管理员帐号,如下图所示:

```

$ sudo net ads leave your_domain -U domain_admin_username

```

**

*退出 Samba4 AD 域*

这篇文章就写到这里吧!尽管上面的这些操作步骤是将 CentOS 7 系统加入到 Samba4 AD DC 域中,其实这些步骤也同样适用于将 CentOS 7 桌面系统加入到 Microsoft Windows Server 2008 或 2012 的域中。

---

作者简介:

我是一个电脑迷,开源 Linux 系统和软件爱好者,有 4 年多的 Linux 桌面、服务器系统使用和 Base 编程经验。

---

via: <http://www.tecmint.com/join-centos-7-to-samba4-active-directory/>

作者:[Matei Cezar](http://www.tecmint.com/author/cezarmatei/) 译者:[rusking](https://github.com/rusking) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,517 | 如何安装 pandom : 一个针对 Linux 的真随机数生成器 | https://www.howtoforge.com/tutorial/how-to-install-pandom-a-true-random-number-generator/ | 2017-05-17T20:44:28 | [

"随机数",

"pandom"

] | https://linux.cn/article-8517-1.html |

本教程只针对 amd64/x86\_64 架构 Linux 内核版本大于等于 2.6.9 的系统。本文将解释如何安装 [pandom](http://ncomputers.org/pandom),这是一个由 ncomputers.org 维护的定时抖动真随机数生成器。

### 简介

在现在的计算机状况下,比如说配置了固态硬盘(SSD)的个人电脑和虚拟专用服务器(VPS)的环境中,Linux 内核内置的真随机数发生器提供的吞吐量很低。

而出于各种不同的加密目的使得对真随机数的需求持续增长,从而使得这个低吞吐量问题在 Linux 实现中变得越来越严重。

在与上述相同的物理或者虚拟环境下,并假设没有其它进程以 root 身份向 `/dev/random` 进行写操作的话,64 [ubits](http://ncomputers.org/ubit)/64 bits 的 pandom 可以以 8 KiB/s 的速率生成随机数。

### 1 pandom 的安装

#### 1.1 获得 root 权限

Pandom 必须以 root 身份来安装,所以在必要的时候请运行如下命令:

```

su -

```

#### 1.2 安装编译所需的依赖

为了下载并安装 pandom,你需要 GNU `as` 汇编器、GNU `make`、GNU `tar` 和 GNU `wget` (最后两个工具通常已被安装)。随后你可以按照你的意愿卸载它们。

**基于 Arch 的系统:**

```

pacman -S binutils make

```

**基于 Debian 的系统:**

```

apt-get install binutils make

```

基于 Red Hat 的系统:

```

dnf install binutils make

yum install binutils make

```

**基于 SUSE 的系统:**

```

zypper install binutils make

```

#### 1.3 下载并析出源码

下面的命令将使用 `wget` 和 `tar` 从 ncomputers.org 下载 pandom 的源代码并将它们解压出来:

```

wget http://ncomputers.org/pandom.tar.gz

tar xf pandom.tar.gz

cd pandom/amd64-linux

```

#### 1.4 在安装前进行测试 (推荐)

这个被推荐的测试将花费大约 8 分钟的时间,它将检查内核支持情况并生成一个名为 `checkme` 的文件(在下一节中将被分析)。

```

make check

```

#### 1.5 确定系统的初始化程序

在安装 pandom 之前,你需要知道你的系统使用的是哪个初始化程序。假如下面命令的输出中包含 `running`,则意味着你的系统使用了 `systemd`,否则你的系统则可能使用了一个 `init.d` 的实现(例如 upstart、sysvinit)。

```

systemctl is-system-running

running

```

#### 1.6 安装 pandom

一旦你知道了你的系统使用何种 Linux 实现,那么你就可以相应地安装 pandom 了。

**使用基于 init.d 作为初始化程序(如: upstart、sysvinit)的系统:**

假如你的系统使用了一个 init.d 的实现(如: upstart、sysvinit),请运行下面的命令来安装 pandom:

```

make install-init.d

```

**以 systemd 作为初始化程序的系统:**

假如你的系统使用 `systemd`,则请运行以下命令来安装 pandom:

```

make install-systemd

```

### 2 checkme 文件的分析

在使用 pandom 进行加密之前,强烈建议分析一下先前在安装过程中生成的 `checkme` 文件。通过分析我们便可以知道用 pandom 生成的数是否真的随机。本节将解释如何使用 ncomputers.org 的 shell 脚本 `entropyarray` 来测试由 pandom 产生的输出的熵及序列相关性。

**注**:整个分析过程也可以在另一台电脑上完成,例如在一个笔记本电脑或台式机上。举个例子:假如你正在一个资源受到限制的 VPS 上安装 pandom 程序,或许你更倾向于将 `checkme` 复制到自己的个人电脑中,然后再进行分析。

#### 2.1 获取 root 权限

`entropyarray` 程序也必须以 root 身份来安装,所以在必要时请运行如下命令:

```

su -

```

#### 2.2 安装编译所需的依赖

为了下载并安装 `entropyarray`, 你需要 GNU g++ 编译器、GNU `make`、GNU `tar` 和 GNU `wget`。在随后你可以任意卸载这些依赖。

**基于 Arch 的系统:**

```

pacman -S gcc make

```

**基于 Debian 的系统:**

```

apt-get install g++ make

```

**基于 Red Hat 的系统:**

```

dnf install gcc-c++ make

yum install gcc-c++ make

```

**基于 SUSE 的系统:**

```

zypper install gcc-c++ make

```

#### 2.3 下载并析出源码

以下命令将使用 `wget` 和 `tar` 从 ncomputers.org 下载到 entropyarray 的源码并进行解压:

```

wget http://ncomputers.org/rearray.tar.gz

wget http://ncomputers.org/entropy.tar.gz

wget http://ncomputers.org/entropyarray.tar.gz

tar xf entropy.tar.gz

tar xf rearray.tar.gz

tar xf entropyarray.tar.gz

```

#### 2.4 安装 entropyarray

**注**:如果在编译过程中报有关 `-std=c++11` 的错误,则说明当前系统安装的 GNU g++ 版本不支持 ISO C++ 2011 标准,那么你可能需要在另一个支持该标准的系统中编译 ncomputers.org/entropy 和 ncomputers.org/rearray (例如在一个你喜爱的较新的 Linux 发行版本中来编译)。接着使用 `make install` 来安装编译好的二进制文件,再接着你可能想继续运行 `entropyarray` 程序,或者跳过运行该程序这一步骤,然而我还是建议在使用 pandom 来达到加密目地之前先分析一下 `checkme` 文件。

```

cd rearray; make install; cd ..

cd entropy; make install; cd ..

cd entropyarray; make install; cd ..

```

#### 2.5 分析 checkme 文件

**注**:64 [ubits](http://ncomputers.org/ubit) / 64 bits 的 pandom 实现所生成的结果中熵应该高于 `15.977` 且 `max` 字段低于 `70`。假如你的结果与之相差巨大,或许你应该按照下面第 5 节介绍的那样增加你的 pandom 实现的不可预测性。假如你跳过了生成 `checkme` 文件的那一步,你也可以使用其他的工具来进行测试,例如 [伪随机数序列测试](http://www.fourmilab.ch/random/)。

```

entropyarray checkme

entropyarray in /tmp/tmp.mbCopmzqsg

15.977339

min:12

med:32

max:56

15.977368

min:11

med:32

max:58

15.977489

min:11

med:32

max:59

15.977077

min:12

med:32

max:60

15.977439

min:8

med:32

max:59

15.977374

min:13

med:32

max:60

15.977312

min:12

med:32

max:67

```

#### 2.6 卸载 entropyarray (可选)

假如你打算不再使用 `entropyarray`,那么你可以按照你自己的需求卸载它:

```

cd entropyarray; make uninstall; cd ..

cd entropy; make uninstall; cd ..

cd rearray; make uninstall; cd ..

```

### 3 使用 debian 的软件仓库来进行安装

假如你想在你基于 debian 的系统中让 pandom 保持更新,则你可以使用 ncomputers.org 的 debian 软件仓库来安装或者重新安装它。

#### 3.1 获取 root 权限

以下的 debian 软件包必须以 root 身份来安装,所以在必要时请运行下面这个命令:

```

su -

```

#### 3.2 安装密钥

下面的 debian 软件包中包含 ncomputers.org debian 软件仓库的公匙密钥:

```

wget http://ncomputers.org/debian/keyring.deb

dpkg -i keyring.deb

rm keyring.deb

```

#### 3.3 安装软件源列表

下面这些 debian 软件包含有 ncomputers.org debian 软件仓库的软件源列表,这些软件源列表对应最新的 debian 发行版本(截至 2017 年)。

**注**:你也可以将下面的以 `#` 注释的行加入 `/etc/apt/sources.list` 文件中,而不是为你的 debian 发行版本安装对应的 debian 软件包。但假如这些源在将来改变了,你就需要手动更新它们。

**Wheezy:**

```

#deb http://ncomputers.org/debian wheezy main

wget http://ncomputers.org/debian/wheezy.deb

dpkg -i wheezy.deb

rm wheezy.deb

```

Jessie:

```

#deb http://ncomputers.org/debian jessie main

wget http://ncomputers.org/debian/jessie.deb

dpkg -i jessie.deb

rm jessie.deb

```

**Stretch:**

```

#deb http://ncomputers.org/debian stretch main

wget http://ncomputers.org/debian/stretch.deb

dpkg -i stretch.deb

rm stretch.deb

```

#### 3.4 升级软件源列表

一旦密钥和软件源列表安装完成,则可以使用下面的命令来更新:

```

apt-get update

```

#### 3.5 测试 pandom

测试完毕后,你可以随意卸载下面的软件包。

**注**:假如你已经在你的 Linux 中测试了 pandom , 则你可以跳过这一步。

```

apt-get install pandom-test

pandom-test

generating checkme file, please wait around 8 minutes ...

entropyarray in /tmp/tmp.5SkiYsYG3h

15.977366

min:12

med:32

max:57

15.977367

min:13

med:32

max:57

15.977328

min:12

med:32

max:61

15.977431

min:12

med:32

max:59

15.977437

min:11

med:32

max:57

15.977298

min:11

med:32

max:59

15.977196

min:10

med:32

max:57

```

#### 3.6 安装 pandom

```

apt-get install pandom

```

### 4 管理 pandom

在 pandom 安装完成后,你可能想对它进行管理。

#### 4.1 性能测试

pandom 提供大约 8 kB/s 的随机数生成速率,但它的性能可能根据环境而有所差异。

```

dd if=/dev/random of=/dev/null bs=8 count=512

512+0 records in

512+0 records out

4096 bytes (4.1 kB, 4.0 KiB) copied, 0.451253 s, 9.1 kB/s

```

#### 4.2 熵和序列相关性检验

除了 ncomputers.org/entropyarray,还存在更多的测试,例如 [Ilja Gerhardt 的 NIST 测试套件](https://gerhardt.ch/random.php)。

```

entropyarray /dev/random 1M

```

#### 4.3 系统服务

pandom 还可以以系统服务的形式运行。

**基于 init.d 的初始化系统(如 upstart、sysvinit):**

```

/etc/init.d/random status

/etc/init.d/random start

/etc/init.d/random stop

/etc/init.d/random restart

```

**以 systemd 作为初始化程序的系统:**

```

systemctl status random

systemctl start random

systemctl stop random

systemctl restart random

```

### 5 增强不可预测性或者性能

假如你想增加你编译的 pandom 程序的不可预测性或者性能,你可以尝试增加或删减 CPU 时间测量选项。

#### 5.1 编辑源文件

请按照自己的意愿,在源文件 `test.s` 和 `tRNG.s` 中增加或者移除 `measurement blocks` 字段。

```

#measurement block

mov $35,%rax

syscall

rdtsc

[...]

#measurement block

mov $35,%rax

syscall

rdtsc

[...]

```

#### 5.2 测试不可预测性

我们总是建议在使用个人定制的 pandom 实现来用于加密目地之前,先进行一些测试。

```

make check

```

#### 5.3 安装定制的 pandom

假如你对测试的结果很满意,你就可以使用下面的命令来安装你的 pandom 实现。

```

make install

```

更多额外信息及更新详见 <http://ncomputers.org/pandom> 。

(题图:Pixabay,CC0)

---

via: <https://www.howtoforge.com/tutorial/how-to-install-pandom-a-true-random-number-generator/>

作者:[Oliver](https://www.howtoforge.com/tutorial/how-to-install-pandom-a-true-random-number-generator/) 译者:[FSSlc](https://github.com/FSSlc) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK | # How to install pandom: a true random number generator for Linux

### On this page

[Introduction](#introduction)[1 Installation of pandom](#-installation-of-pandom)[1.1 Gain root access](#-gain-root-access)[1.2 Install build dependencies](#-install-build-dependencies)[Arch based systems](#arch-based-systems)[Debian based systems](#debian-based-systems)[Red Hat based systems](#red-hat-based-systems)[SUSE based systems](#suse-based-systems)[1.3 Download and extract sources](#-download-and-extract-sources)[1.4 Test before installing (recommended)](#-test-before-installing-recommended)[1.5 Determine init system](#-determine-init-system)[1.6 Install pandom](#-install-pandom)[init.d based init system (e.g: upstart, sysvinit)](#initd-based-init-system-eg-upstart-sysvinit)[systemd as init system](#systemd-as-init-system)

[2 Analysis of checkme file](#-analysis-of-checkme-file)[3 Installation using debian repository](#-installation-using-debian-repository)[4 Managing pandom](#-managing-pandom)[5 Increasing unpredictability or performance](#-increasing-unpredictability-or-performance)

This tutorial is for amd64 / x86_64 linux kernel versions greater and equal to 2.6.9. It explains how to install [pandom](http://ncomputers.org/pandom): a timing jitter true random number generator maintained by ncomputers.org

## Introduction

The built-in Linux kernel true random number generator provides low throughput under modern circumstances, as for example: personal computers with solid state drives (SSD) and virtual private servers (VPS).

This problem is becoming popular in linux implementations, because of the continuously increasing need for true random numbers, mainly by diverse cryptographic purposes.

Pandom outputs around 8 KiB/s entropy of 64 [ubits](http://ncomputers.org/ubit) / 64 bits, is compatible with physical and virtual environments and assumes, that no other process running as root user writes to /dev/random.

## 1 Installation of pandom

### 1.1 Gain root access

Pandom must be installed as root, run this command if needed.

su -

### 1.2 Install build dependencies

In order to download and install pandom, you need: GNU **as**sembler, GNU **make**, GNU **tar** and GNU **wget** (the last two usually installed already). You may uninstall them later at will.

### Arch based systems

pacman -S binutils make

### Debian based systems

apt-get install binutils make

### Red Hat based systems

dnf install binutils make

yum install binutils make

### SUSE based systems

zypper install binutils make

### 1.3 Download and extract sources

These commands download and extract the sources of pandom from ncomputers.org using **wget** and **tar**.

wget[http://ncomputers.org/pandom.tar.gz]

tar xf pandom.tar.gz

cd pandom/amd64-linux

### 1.4 Test before installing (recommended)

This recommended test takes around 8 minutes. It checks for kernel support and generates a file named **checkme** (analyzed on the next section).

make check

### 1.5 Determine init system

Before installing pandom, you need to know, which init software does your system use. If the following command outputs the word **running**, it means that your system is using **systemd**, otherwise it is likely, that your system is using an **init.d** implementation (e.g: upstart, sysvinit). There might be some exceptions, more information in these [unix.stackexchange.com](http://unix.stackexchange.com/a/18210/94448) answers.

systemctl is-system-running

running

### 1.6 Install pandom

Once you know which system does your linux implementation use, then you may install pandom accordingly.

### init.d based init system (e.g: upstart, sysvinit)

Install pandom running this command, if your system is using an **init.d** implementation (e.g: upstart, sysvinit).

make install-init.d

### systemd as init system

Install pandom running this command, if your system is using **systemd**.

make install-systemd

## 2 Analysis of checkme file

Before using pandom for cryptographic purposes, it is highly recommended to analyze **checkme** file generated during the installation process in the previous section of this tutorial. This task is useful for knowing if the numbers are truly random or not. This section explains how to analyze **checkme** file using ncomputers.org/**entropyarray**: a shell script, that tests entropy and serial correlation of its input.

**Note**: this analysis might be run in another computer, such as a laptop or desktop computer. For example: if you are installing pandom in a constrained-resources virtual private server (VPS), you might opt to copy **checkme** file to your personal computer, in order to analyze it there.**You may also use Entropy Online Tester**.

### 2.1 Gain root access

Entropyarray must be installed as root, run this command if needed.

su -

### 2.2 Install build dependencies

In order to download and install entropyarray, you need: GNU **g++** compiler, GNU **make**, GNU **tar** and GNU **wget** (the last two usually installed already). You may uninstall them later at will.

### Arch based systems

pacman -S gcc make

### Debian based systems

apt-get install g++ make

### Red Hat based systems

dnf install gcc-c++ make

yum install gcc-c++ make

### SUSE based systems

zypper install gcc-c++ make

### 2.3 Download and extract sources

These commands download and extract the sources of entropyarray from ncomputers.org using **wget** and **tar**.

wget[http://ncomputers.org/rearray.tar.gz]

wget[http://ncomputers.org/entropy.tar.gz]

wget[http://ncomputers.org/entropyarray.tar.gz]

tar xf entropy.tar.gz

tar xf rearray.tar.gz

tar xf entropyarray.tar.gz

### 2.4 Install entropyarray

**Note**: errors regarding -std=c++11 mean that the GNU **g++** compiler version doesn't support ISO C++ 2011 standard. You may try to compile ncomputers.org/**entropy** and ncomputers.org/**rearray** in another system that supports it (e.g: GNU g++ in a newer version of your favorite linux distribution) and then install the compiled binaries using **make install** in the system you would like to run **entropyarray**, or skip this step, despite it is highly recommended that you analyze **checkme** file before using pandom for any cryptographic purpose.

cd rearray; make install; cd ..

cd entropy; make install; cd ..

cd entropyarray; make install; cd ..

### 2.5 Analyze checkme file

**Note**: 64 [ubits](http://ncomputers.org/ubit) / 64 bits pandom implementations should result this test with entropy above **15.977** and **max** frequency below **70**. If your results differ too much, you may try to increase the unpredictability of your pandom implementation as described in the fifth section of this tutorial. In case you skipped the last step, you may use other tools such as [pseudorandom number sequence test](http://www.fourmilab.ch/random/).

entropyarray checkme

entropyarray in /tmp/tmp.mbCopmzqsg

15.977339

min:12

med:32

max:56

15.977368

min:11

med:32

max:58

15.977489

min:11

med:32

max:59

15.977077

min:12

med:32

max:60

15.977439

min:8

med:32

max:59

15.977374

min:13

med:32

max:60

15.977312

min:12

med:32

max:67

### 2.6 Uninstall entropyarray (optional)

If you plan to not use entropyarray any more, then you might want to uninstall it at will.

cd entropyarray; make uninstall; cd ..

cd entropy; make uninstall; cd ..

cd rearray; make uninstall; cd ..

## 3 Installation using debian repository

If you would like to keep pandom updated on your debian based system, you may opt to install / reinstall it using ncomputers.org debian repository.

### 3.1 Gain root access

The below debian packages must be installed as root, run this command if needed.

su -

### 3.2 Install keyring

This debian package includes the public key of the ncomputers.org debian repository.

wget[http://ncomputers.org/debian/keyring.deb]

dpkg -i keyring.deb

rm keyring.deb

### 3.3 Install sources list

These debian packages include the sources list of the ncomputers.org debian repository according to the latest debian distributions (year 2017).

**Note**: It is also possible to write the commented lines below in **/etc/apt/sources.list**, instead of installing the respective debian package for your debian distribution, but if these sources change in the future, then you would need to update them manually.

### Wheezy

#deb[http://ncomputers.org/debian]wheezy main

wget[http://ncomputers.org/debian/wheezy.deb]

dpkg -i wheezy.deb

rm wheezy.deb

### Jessie

#deb[http://ncomputers.org/debian]jessie main

wget[http://ncomputers.org/debian/jessie.deb]

dpkg -i jessie.deb

rm jessie.deb

### Stretch

#deb[http://ncomputers.org/debian]stretch main

wget[http://ncomputers.org/debian/stretch.deb]

dpkg -i stretch.deb

rm stretch.deb

### 3.4 Update sources list

Once the keyring and sources list are installed.

apt-get update

### 3.5 Test pandom

Once tested, you may uninstall the below package at will.

**Note**: if you have already tested pandom in your linux implementation, you may skip this step.

apt-get install pandom-test

pandom-test

generating checkme file, please wait around 8 minutes ...

entropyarray in /tmp/tmp.5SkiYsYG3h

15.977366

min:12

med:32

max:57

15.977367

min:13

med:32

max:57

15.977328

min:12

med:32

max:61

15.977431

min:12

med:32

max:59

15.977437

min:11

med:32

max:57

15.977298

min:11

med:32

max:59

15.977196

min:10

med:32

max:57

### 3.6 Install pandom

apt-get install pandom

## 4 Managing pandom

After pandom was installed, you might want to manage it.

### 4.1 Performance test

Pandom offers around 8 kilobytes per second, but its performance may vary depending on the environment.

dd if=/dev/random of=/dev/null bs=8 count=512

512+0 records in

512+0 records out

4096 bytes (4.1 kB, 4.0 KiB) copied, 0.451253 s, 9.1 kB/s

### 4.2 Entropy and serial correlation test

Besides of ncomputers.org/**entropyarray**, there are more tests, for example [NIST testsuite by Ilja Gerhardt](https://gerhardt.ch/random.php).

entropyarray /dev/random 1M

### 4.3 System service

Pandom runs as a system service.

### init.d based init system (e.g: upstart, sysvinit)

/etc/init.d/random status

/etc/init.d/random start

/etc/init.d/random stop

/etc/init.d/random restart

### systemd as init system

systemctl status random

systemctl start random

systemctl stop random

systemctl restart random

## 5 Increasing unpredictability or performance

If you would like to try to increase the unpredictabiity or the performance of your pandom implementation, you may try to add or delete CPU time measurements.

### 5.1 Edit source files

In the source files **test.s** and **tRNG.s** add or remove measurement blocks at will.

#measurement block

mov $35,%rax

syscall

rdtsc

[...]

#measurement block

mov $35,%rax

syscall

rdtsc

[...]

### 5.2 Test the unpredictability

We recommend to always test any personalized pandom implementation before using it for cryptographic purposes.

make check

### 5.3 Install personalized pandom

If you are happy with the results, then you may install your personalized pandom implementation.

make install

Additional information and updates: [http://ncomputers.org/pandom](http://ncomputers.org/pandom) |

8,518 | LinuxKit:在容器中运行容器 | http://www.devsecops.cc/devsecops/containers.html | 2017-05-18T10:29:00 | [

"容器",

"LinuxKit",

"Docker"

] | https://linux.cn/article-8518-1.html |

一些令人振奋的消息引发了我对今年 DockerCon 的兴趣,在这次会议中,无可争议的容器巨头公司 Docker 发布了一个新的操作系统:LinuxKit。

这家容器巨头宣布的是一个灵活的、可扩展的操作系统,而为了可移植性,系统服务也是运行在容器之中。甚至,令人惊讶的是,就连 Docker 运行时环境也是运行在容器内!

在本文中,我们将简要介绍一下 LinuxKit 中所承诺的内容,以及如何自己尝试一下这个不断精简、优化的容器。

### 少即是多

不可否认的是,用户一直在寻找一个可以运行他们的微服务的精简版本的 Linux 。通过容器化,你会尽可能地最小化每个应用程序,使其成为一个适合于运行在其自身容器内的独立进程。但是,由于你需要对那些驻留容器的宿主机出现的问题进行修补,因此你不断地在宿主机间移动容器。实际上,如果没有像 Kubernetes 或 Docker Swarm 这样的编排系统,容器编排几乎总是会导致停机。

不用说,这只是让你保持操作系统尽可能小的原因之一。

我曾多次在不同场合重复过的最喜爱的名言,来自荷兰的天才程序员 Wietse Zweitze,他为我们提供了重要的 Email 软件 Postfix 和 TCP Wrappers 等知名软件。

在 [Postfix 网站](http://www.postfix.org/TLS_README.html) 指出,即使你编码和 Wietse 一样小心,“每 1000 行[你]就会在 Postfix 中引入一个额外的 bug”。从我的专业的 DevSecOps 角度看,这里提到的“bug” 可以将其大致看做安全问题。

从安全的角度来看,正是由于这个原因,代码世界中“少即是多”。简单地说,使用较少的代码行有很多好处,即安全性、管理时间和性能。对于初学者来说,这意味着安全漏洞较少,更新软件包的时间更短,启动时间更快。

### 深入观察

考虑下在容器内部运行你的程序。

一个好的起点是 [Alpine Linux](https://alpinelinux.org/downloads/),它是一个苗条、精简的操作系统,通常比那些笨重的系统更受喜欢,如 Ubuntu 或 CentOS 等。Alpine 还提供了一个 miniroot 文件系统(用于容器内),最近我看到的大小是惊人的 1.8M。事实上,这个完整的 Linux 操作系统下载后有 80M。

如果你决定使用 Alpine Linux 作为 Docker 基础镜像,那么你可以在 Docker Hub 上[找到](https://hub.docker.com/_/alpine)一个, 它将其描述为:“一个基于 Alpine Linux 的最小 Docker 镜像,具有完整的包索引,大小只有5 MB!”

据说无处不在的 “Window 开始菜单” 文件也是大致相同的大小!我没有验证过,也不会进一步评论。

讲真,希望你去了解一下这个创新的类 Unix 操作系统(如 Alpine Linux)的强大功能。

### 锁定一切

再说一点,Alpine Linux 是(并不惊人)基于 [BusyBox](https://busybox.net/),这是一套著名的打包了 Linux 命令的集合,许多人不会意识到他们的宽带路由器、智能电视,当然还有他们家庭中的物联网设备就有它。

Alpine Linux 站点的“[关于](https://www.alpinelinux.org/about/)”页面的评论中指出:

>

> “Alpine Linux 的设计考虑到安全性。内核使用 grsecurity/PaX 的非官方移植进行了修补,所有用户态二进制文件都编译为具有堆栈保护的地址无关可执行文件(PIE)。 这些主动安全特性可以防止所有类别的零日漏洞和其它漏洞利用。”

>

>

>

换句话说,这些捆绑在 Alpine Linux 中的精简二进制文件提供的功能通过了那些行业级安全工具筛选,以缓解缓冲区溢出攻击所带来的危害。

### 多只袜子

你可能会问,为什么当我们谈及 Docker 的新操作系统时,容器的内部结构很重要?

那么,你可能已经猜到,当涉及容器时,他们的目标是精简。除非绝对必要,否则不包括任何东西。所以你可以放心地清理橱柜、花园棚子、车库和袜子抽屉了。

Docker 的确因为它们的先见而获得声望。据报道,2 月初,Docker 聘请了 Alpine Linux 的主要推动者 Nathaniel Copa,他帮助将默认的官方镜像库从 Ubuntu 切换到 Alpine。Docker Hub 从新近精简镜像节省的带宽受到了赞誉。

并且最新的情况是,这项工作将与最新的基于容器的操作系统相结合:Docker 的 LinuxKit。

要说清楚的是 LinuxKit 注定不会代替 Alpine,而是位于容器下层,并作为一个完整的操作系统出现,你可以高兴地启动你的运行时守护程序(在这种情况下,是生成你的容器的Docker 守护程序 )。

### 原子计划

经过精心调试的宿主机绝对不是一件新事物(以前提到过嵌入式 Linux 的家用设备)。在过去几十年中一直在优化 Linux 的天才在某个时候意识到底层的操作系统才是快速生产含有大量容器主机的关键。

例如,强大的红帽长期以来一直在出售已经贡献给 [Project Atomic](http://www.projectatomic.io/) 的 [红帽 Atomic](https://www.redhat.com/en/resources/red-hat-enterprise-linux-atomic-host) 。后者继续解释:

>

> “基于 Red Hat Enterprise Linux 或 CentOS 和 Fedora 项目的成熟技术,Atomic Host 是一个轻量级的、不可变的平台,其设计目的仅在于运行容器化应用程序。”

>

>

>

将底层的、不可变的 Atomic OS 作为红帽的 OpenShift PaaS(平台即服务)产品推荐有一个很好理由:它最小化、高性能、尖端。

### 特性强大

在 Docker 关于 LinuxKit 的公告中,“少即是多”的口号是显而易见的。实现 LinuxKit 愿景的项目显然是不小的事业,它由 Docker 老将和 [Unikernel](https://en.wikipedia.org/wiki/Unikernel) 的主管 Justin Cormack 指导,并与 HPE、Intel、ARM、IBM 和 Microsoft LinuxKit 合作,可以运行在从大型机到基于物联网的冰柜之中。

LinuxKit 的可配置性、可插拔性和可扩展性将吸引许多寻求建立其服务基准的项目。通过开源项目,Docker 明智地邀请每个人全身心地投入其功能开发,随着时间的推移,它会像好的奶酪那样成熟。

### 布丁作证

按照该发布消息中所承诺的,那些急于使用新系统的人不用再等待了。如果你准备着手 LinuxKit,你可以从 GitHub 中开始:[LinuxKit](https://github.com/linuxkit/linuxkit)。

在 GitHub 页面上有关于如何启动和运行一些功能的指导。

时间允许的话我准备更加深入研究 LinuxKit。对有争议的 Kubernetes 与 Docker Swarm 编排功能对比会是有趣的尝试。此外,我还想看到内存占用、启动时间和磁盘空间使用率的基准测试。

如果该承诺可靠,则作为容器运行的可插拔系统服务是构建操作系统的迷人方式。Docker 在[博客](https://blog.docker.com/2017/04/introducing-linuxkit-container-os-toolkit))中提到:“因为 LinuxKit 是原生容器,它有一个非常小的尺寸 - 35MB,引导时间非常小。所有系统服务都是容器,这意味着可以删除或替换所有的内容。”

我不知道你觉得怎么样,但这非常符合我的胃口。

### 呼叫警察

除了我站在 DevSecOps 角度看到的功能,我会看看其对安全的承诺。

Docker 在他们的博客上引用来自 NIST([国家标准与技术研究所](https://www.nist.gov/))的话:

>

> “安全性是最高目标,这与 NIST 在其《应用程序容器安全指南》草案中说明的保持一致:‘使用容器专用操作系统而不是通用操作系统来减少攻击面。当使用专用容器操作系统时,攻击面通常比通用操作系统小得多,因此攻击和危及专用容器操作系统的机会较少。’”

>

>

>

可能最重要的容器到主机和主机到容器的安全创新是将系统容器(系统服务)完全地沙箱化到自己的非特权空间中,而只给它们需要的外部访问。

通过<ruby> 内核自我保护项目 <rt> Kernel Self Protection Project </rt></ruby>([KSPP](https://kernsec.org/wiki/index.php/Kernel_Self_Protection_Project))的协作来实现这一功能,我很满意 Docker 开始专注于一些非常值得的东西上。对于那些不熟悉的 KSPP 的人而言,它存在理由如下:

>

> “启动这个项目的的假设是内核 bug 的存在时间很长,内核必须设计成可以防止这些缺陷的危害。”

>

>

>

KSPP 网站进一步表态:

>

> “这些努力非常重要并还在进行,但如果我们要保护我们的十亿 Android 手机、我们的汽车、国际空间站,还有其他运行 Linux 的产品,我们必须在上游的 Linux 内核中建立积极的防御性技术。我们需要内核安全地出错,而不只是安全地运行。”

>

>

>

而且,如果 Docker 最初只是在 LinuxKit 前进了一小步,那么随着时间的推移,成熟度带来的好处可能会在容器领域中取得长足的进步。

### 终点还远

像 Docker 这样不断发展壮大的巨头无论在哪个方向上取得巨大的飞跃都将会用户和其他软件带来益处。

我鼓励所有对 Linux 感兴趣的人密切关注这个领域。

---

via: <http://www.devsecops.cc/devsecops/containers.html>

作者:[Chris Binnie](http://www.devsecops.cc/) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 307 | Temporary Redirect | null |

8,519 | 如何在 Linux 中使用 Asciinema 进行录制和回放终端会话 | https://linuxconfig.org/record-and-replay-terminal-session-with-asciinema-on-linux | 2017-05-18T11:59:00 | [

"终端",

"记录"

] | https://linux.cn/article-8519-1.html |

### 简介

Asciinema 是一个轻量并且非常高效的终端会话录制器。使用它可以录制、回放和分享 JSON 格式的终端会话记录。与一些桌面录制器,比如 Recordmydesktop、Simplescreenrecorder、Vokoscreen 或 Kazam 相比,Asciinema 最主要的优点是,它能够以通过 ASCII 文本以及 ANSI 转义码编码来录制所有的标准终端输入、输出和错误信息。

事实上,即使是很长的终端会话,录制出的 JSON 格式文件也非常小。另外,JSON 格式使得用户可以利用简单的文件转化器,将输出的 JSON 格式文件嵌入到 HTML 代码中,然后分享到公共网站或者使用 asciinema 账户分享到 Asciinema.org 。最后,如果你的终端会话中有一些错误,并且你还懂一些 ASCI 转义码语法,那么你可以使用任何编辑器来修改你的已录制终端会话。

**难易程度:**

很简单!

**标准终端:**

* **#** - 给定命令需要以 root 用户权限运行或者使用 `sudo` 命令

* **$** - 给定命令以常规权限用户运行

### 从软件库安装

通常, asciinema 可以使用你的发行版的软件库进行安装。但是,如果不可以使用系统的软件库进行安装或者你想安装最新的版本,那么,你可以像下面的“从源代码安装”部分所描述的那样,使用 Linuxbrew 包管理器来执行 Asciinema 安装。

**在 Arch Linux 上安装:**

```

# pacman -S asciinema

```

**在 Debian 上安装:**

```

# apt install asciinema

```

**在 Ubuntu 上安装:**

```

$ sudo apt install asciinema

```

**在 Fedora 上安装:**

```

$ sudo dnf install asciinema

```

### 从源代码安装

最简单并且值得推荐的方式是使用 Linuxbrew 包管理器,从源代码安装最新版本的 Asciinema 。

#### 前提条件

下面列出的前提条件是安装 Linuxbrew 和 Asciinema 需要满足的依赖关系:

* git

* gcc

* make

* ruby

在安装 Linuxbrew 之前,请确保上面的这些包都已经安装在了你的 Linux 系统中。

**在 Arch Linux 上安装 ruby:**

```

# pacman -S git gcc make ruby

```

**在 Debian 上安装 ruby:**

```

# apt install git gcc make ruby

```

**在 Ubuntu 上安装 ruby:**

```

$ sudo apt install git gcc make ruby

```

**在 Fedora 上安装 ruby:**

```

$ sudo dnf install git gcc make ruby

```

**在 CentOS 上安装 ruby:**

```

# yum install git gcc make ruby

```

#### 安装 Linuxbrew

Linuxbrew 包管理器是苹果的 MacOS 操作系统很受欢迎的 Homebrew 包管理器的一个复刻版本。还没发布多久,Homebrew 就以容易使用而著称。如果你想使用 Linuxbrew 来安装 Asciinema,那么,请运行下面命令在你的 Linux 版本上安装 Linuxbrew:

```

$ ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Linuxbrew/install/master/install)"

```

现在,Linuxbrew 已经安装到了目录 `$HOME/.linuxbrew/` 下。剩下需要做的就是使它成为可执行 `PATH` 环境变量的一部分。

```

$ echo 'export PATH="$HOME/.linuxbrew/bin:$PATH"' >>~/.bash_profile

$ . ~/.bash_profile

```

为了确认 Linuxbrew 是否已经安装好,你可以使用 `brew` 命令来查看它的版本:

```

$ brew --version

Homebrew 1.1.7

Homebrew/homebrew-core (git revision 5229; last commit 2017-02-02)

```

#### 安装 Asciinema

安装好 Linuxbrew 以后,安装 Asciinema 就变得无比容易了:

```

$ brew install asciinema

```

检查 Asciinema 是否安装正确:

```

$ asciinema --version

asciinema 1.3.0

```

### 录制终端会话

经过一番辛苦的安装工作以后,是时候来干一些有趣的事情了。Asciinema 是一个非常容易使用的软件。事实上,目前的 1.3 版本只有很少的几个可用命令行选项,其中一个是 `--help` 。

我们首先使用 `rec` 选项来录制终端会话。下面的命令将会开始录制终端会话,之后,你将会有一个选项来丢弃已录制记录或者把它上传到 asciinema.org 网站以便将来参考。

```

$ asciinema rec

```

运行上面的命令以后,你会注意到, Asciinema 已经开始录制终端会话了,你可以按下 `CTRL+D` 快捷键或执行 `exit` 命令来停止录制。如果你使用的是 Debian/Ubuntu/Mint Linux 系统,你可以像下面这样尝试进行第一次 asciinema 录制:

```

$ su

Password:

# apt install sl

# exit

$ sl

```

一旦输入最后一个 `exit` 命令以后,将会询问你:

```

$ exit

~ Asciicast recording finished.

~ Press <Enter> to upload, <Ctrl-C> to cancel.

https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4

```

如果你不想上传你的私密命令行技巧到 asciinema.org 网站,那么有一个选项可以把 Asciinema 记录以 JSON 格式保存为本地文件。比如,下面的 asciinema 记录将被存为 `/tmp/my_rec.json`:

```

$ asciinema rec /tmp/my_rec.json

```

另一个非常有用的 asciinema 特性是时间微调。如果你的键盘输入速度很慢,或者你在进行多任务,输入命令和执行命令之间的时间会比较长。Asciinema 会记录你的实时按键时间,这意味着每一个停顿都将反映在最终视频的长度上。可以使用 `-w` 选项来缩短按键的时间间隔。比如,下面的命令将按键的时间间隔缩短为 0.2 秒:

```

$ asciinema rec -w 0.2

```

### 回放已录制终端会话

有两种方式可以来回放已录制会话。第一种方式是直接从 asciinema.org 网站上播放终端会话。这意味着,你之前已经把录制会话上传到了 asciinema.org 网站,并且需要提供有效链接:

```

$ asciinema play https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4

```

另外,你也可以使用本地存储的 JSON 文件:

```

$ asciinema play /tmp/my_rec.json

```

如果要使用 `wget` 命令来下载之前的上传记录,只需在链接的后面加上 `.json`:

```

$ wget -q -O steam_locomotive.json https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4.json

$ asciinema play steam_locomotive.json

```

### 将视频嵌入 HTML

最后,asciinema 还带有一个独立的 JavaScript 播放器。这意味者你可以很容易的在你的网站上分享终端会话记录。下面,使用一段简单的 `index.html` 代码来说明这个方法。首先,下载所有必要的东西:

```

$ cd /tmp/

$ mkdir steam_locomotive

$ cd steam_locomotive/

$ wget -q -O steam_locomotive.json https://asciinema.org/a/7lw94ys68gsgr1yzdtzwijxm4.json

$ wget -q https://github.com/asciinema/asciinema-player/releases/download/v2.4.0/asciinema-player.css

$ wget -q https://github.com/asciinema/asciinema-player/releases/download/v2.4.0/asciinema-player.js

```

之后,创建一个新的包含下面这些内容的 `/tmp/steam_locomotive/index.html` 文件:

```

<html>

<head>

<link rel="stylesheet" type="text/css" href="./asciinema-player.css" />

</head>

<body>

<asciinema-player src="./steam_locomotive.json" cols="80" rows="24"></asciinema-player>

<script src="./asciinema-player.js"></script>

</body>

</html>

```

完成以后,打开你的网页浏览器,按下 `CTRL+O` 来打开新创建的 `/tmp/steam_locomotive/index.html` 文件。

### 结论

正如前面所说的,使用 asciinema 录制器来录制终端会话最主要的优点是它的输出文件非常小,这使得你的视频很容易分享出去。上面的例子产生了一个包含 58472 个字符的文件,它是一个只有 58 KB 大 小的 22 秒终端会话视频。如果我们查看输出的 JSON 文件,会发现甚至这个数字已经非常大了,这主要是因为一个 “蒸汽机车” 已经跑过了终端。这个长度的正常终端会话一般会产生一个更小的输出文件。

下次,当你想要在一个论坛上询问关于 Linux 配置的问题,并且很难描述你的问题的时候,只需运行下面的命令:

```

$ asciinema rec

```

然后把最后的链接贴到论坛的帖子里。

### 故障排除

#### 在 UTF-8 环境下运行 asciinema

错误信息:

```

asciinema needs a UTF-8 native locale to run. Check the output of `locale` command.

```

解决方法: 生成并导出 UTF-8 语言环境。例如:

```

$ localedef -c -f UTF-8 -i en_US en_US.UTF-8

$ export LC_ALL=en_US.UTF-8

```

---

via: <https://linuxconfig.org/record-and-replay-terminal-session-with-asciinema-on-linux>

作者:[Lubos Rendek](https://linuxconfig.org/record-and-replay-terminal-session-with-asciinema-on-linux) 译者:[ucasFL](https://github.com/ucasFL) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 403 | Forbidden | null |

8,520 | 甲骨文的政策更改提高了其在 AWS 上的价格 | http://windowsitpro.com/cloud/oracle-policy-change-raises-prices-aws | 2017-05-18T15:01:00 | [

"甲骨文",

"Oracle",

"AWS"

] | https://linux.cn/article-8520-1.html |

>

> 这种改变使得在 AWS 上实施甲骨文的软件的价格翻了一番,它已经安静地生效了,而几乎没有通知用户。

>

>

>

之前有消息传出,甲骨文使亚马逊云上的产品价格翻了一倍。它在[如何计算 AWS 的虚拟 CPU](https://oracle-base.com/blog/2017/01/28/oracles-cloud-licensing-change-be-warned/) 上耍了一些花招。它这么做也没有任何宣扬。该公司的新定价政策于 1 月 23 日生效,直到 1 月 28 日都几乎没有被人注意到, 甲骨文的关注者 Tim Hall 偶然发现 Big Red 公司的 [甲骨文软件云计算环境许可](http://www.oracle.com/us/corporate/pricing/cloud-licensing-070579.pdf)文件并披露了出来。

乍一看,这一举动似乎并不太大,因为它仅将甲骨文的 AWS 定价与 Microsoft Azure 的价格相提并论。但是 Azure 只有市场领先的 AWS 体量的三分之一,所以如果你想在云中销售许可证,AWS 是合适的地方。虽然此举可能或可能不会影响已经在 AWS 上使用甲骨文产品的用户,但是尚不清楚新规则是否适用于已在使用产品的用户 - 它肯定会让一些考虑可能使用甲骨文的用户另寻它处。

这个举动的主要原因是显而易见的。甲骨文希望使自己的云更具吸引力 - 这让 [The Register 观察](https://www.theregister.co.uk/2017/01/30/oracle_effectively_doubles_licence_fees_to_run_in_aws/)到一点:“拉里·埃里森确实承诺过甲骨文的云将会更快更便宜”。更快和更便宜仍然有待看到。如果甲骨文的 SPARC 云计划启动,并且按照广告的形式执行,那么可能会更快,但是更便宜的可能性较小。甲骨文以对其价格的强硬态度而著称。

随着其招牌数据库和业务栈销售的下滑,并且对 Sun 公司的 74 亿美元的投资并未能按照如期那样,甲骨文将其未来赌在云计算上。但是甲骨文来晚了,迄今为止,它的努力似乎还没有结果, 一些金融预测者并没有看到甲骨文云的光明前景。他们说,云是一个拥挤的市场,而四大公司 - 亚马逊、微软、IBM 和谷歌 - 已经有了领先优势。

确实如此。但是甲骨文面临的最大的障碍是,好吧,就是甲骨文。它的声誉在它之前。

保守地说这个公司并不是因为明星客户服务而闻名。事实上,各种新闻报道将甲骨文描绘成一个恶霸和操纵者。

例如,早在 2015 年,甲骨文就因为它的云并不像预期那样快速增长而越来越沮丧,开始[激活业内人士称之为的“核特权”](http://www.businessinsider.com/oracle-is-using-the-nuclear-option-to-sell-its-cloud-software-2015-7)。它会审核客户的数据中心,如果客户不符合规定,将发出“违规通知” - 它通常只适用于大规模滥用情况,并命令客户在 30 天内退出使用其软件。

或许你能想到,大量投入在甲骨文软件平台上的大公司们绝对不能在短时间内迁移到另一个解决方案。甲骨文的违规通知将会引发灾难。

商业内幕人士 Julie Bort 解释到:“为了使违规通知消失 - 或者减少高额的违规罚款 - 甲骨文销售代表通常希望客户向合同中添加云额度”。

换句话说,甲骨文正在使用审计来扭转客户去购买它的云,而无论他们是否有需要。这种策略与最近 AWS 价格翻倍之间也可能存在联系。Hall 的文章的评论者指出,围绕价格提升的秘密背后的目的可能是触发软件审计。

使用这些策略的麻烦迟早会出来。消息一旦传播开来,你的客户就开始寻找其他选项。对 Big Red 而言或许是时候参考微软的做法,开始建立一个更好和更温和的甲骨文,将客户的需求放在第一位。

(题图:[windowsitpro](http://windowsitpro.com/))

---

via: <http://windowsitpro.com/cloud/oracle-policy-change-raises-prices-aws>

作者:[Christine Hall](http://windowsitpro.com/author/christine-hall) 译者:[geekpi](https://github.com/geekpi) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

8,521 | 该死,原生移动应用的开发成本太高了! | https://hackernoon.com/the-cost-of-native-mobile-app-development-is-too-damn-high-4d258025033a | 2017-05-19T10:28:00 | [

"JavaScript",

"移动应用"

] | https://linux.cn/article-8521-1.html |

>

> 一个有价值的命题

>

>

>

我们遇到了一个临界点。除去少数几个特别的的用例之外,使用原生框架和原生应用开发团队构建、维护移动应用再也没有意义了。

*在美国,雇佣 [iOS,Android](http://www.indeed.com/salary),[JavaScript](http://www.payscale.com/research/US/Skill=JavaScript/Salary) 开发人员的平均花费*

在过去的几年,原生移动应用开发的费用螺旋式上升,无法控制。对没有大量资金的新创业者来说,创建原生应用、MVP 设计架构和原型的难度大大增加。现有的公司需要抓住人才,以便在现有应用上进行迭代开发或者构建一个新的应用。要尽一切努力才能留住最好的人才,与 [世界各地的公司](http://blogs.wsj.com/cio/2016/09/30/tech-talent-war-moves-to-africa/) 拼尽全力[争个](http://www.bizjournals.com/charlotte/how-to/human-resources/2016/12/employers-offer-premium-wages-skilled-workers.html)[高](https://www.cnet.com/news/silicon-valley-talent-wars-engineers-come-get-your-250k-salary/)[下](http://www.nytimes.com/2015/08/19/technology/unicorns-hunt-for-talent-among-silicon-valleys-giants.html)。

*2015 年初,原生方式和混合方式开发 MVP 设计架构的费用[对比](http://www.comentum.com/mobile-app-development-cost.html)*

### 这一切对于我们意味着什么?

如果你的公司很大或者有足够多的现金,旧思维是只要你在原生应用开发方面投入足够多的资金,就高枕无忧。但事实不再如此。

Facebook 是你最不会想到的在人才战中失败的公司(因为他们没有失败),它也遇到了原生应用方面金钱无法解决的问题。他们的移动应用庞大而又复杂,[他们发现编译它竟然需要 15 分钟](https://devchat.tv/react-native-radio/08-bridging-react-native-components-with-tadeu-zagallo)。这意味着哪怕是极小的用户界面改动,比如移动几个点,测试起来都要花费几个小时(甚至几天)。

除了冗长的编译时间,应用的每一个小改动在测试时都需要在两个完全不同的环境(IOS 和 Android)实施,开发团队需要使用两种语言和框架工作,这趟水更浑了。

Facebook 对这个问题的解决方案是 [React Native](https://facebook.github.io/react-native/)。

### 能不能抛弃移动应用,仅面向 Web 呢?

[一些人认为移动应用的末日已到](https://medium.com/javascript-scene/native-apps-are-doomed-ac397148a2c0#.w06yd23ej)。尽管我很欣赏、尊重 [Eric Elliott](https://medium.com/u/c359511de780) 和他的工作,但我们还是通过考察一些近期的数据,进而讨论一下某些相反的观点:

*人们在移动应用上花费的[时间](http://www.smartinsights.com/mobile-marketing/mobile-marketing-analytics/mobile-marketing-statistics/attachment/percent-time-spent-on-mobile-apps-2016/)(2016年4月)*

>

> 人们使用 APP 的时间占使用手机总时长的 90%

>

>

>

目前世界上有 25 亿人在使用移动手机。[这个数字增长到 50 亿的速度会比我们想象的还要快。](http://ben-evans.com/benedictevans/2016/12/8/mobile-is-eating-the-world) 在正常情况下,丢掉 45 亿人的生意,或者抛弃有 45 亿人使用的应用程序是绝对荒唐且行不通的。

老问题是原生移动应用的开发成本对大多数公司来说太高了。然而,面向 web 的开发成本也在增加。[在美国,JavaScript 开发者的平均工资已达到 $97,000.00](http://www.indeed.com/salary?q1=javascript+developer&l1=united+states&tm=1)。

伴随着复杂性的增加以及对高质量 web 开发的需求暴涨,雇佣一个 JavaScript 开发者的平均价格直逼原生应用开发者。论证 web 开发更便宜已经没用了。

### 那混合开发呢?

混合应用是将 HTML5 应用内嵌在原生应用的容器里,并且提供实现原生平台特性所需的权限。Cordova 和 PhoneGap 就是典型的例子。

如果你想构建一个 MVP 设计架构、一个产品原型,或者不担心对原生应用的模仿的用户体验,那么混合应用会很适合你。但谨记如果你最后想把它转为原生应用,整个项目都得重写。

此领域有很多创新的东西,我最喜欢的当属 [Ionic Framework](https://ionicframework.com/)。混合开发正变得越来越好,但还不如原生开发那么流畅自然。

有很多公司,包括最严峻的初创公司,也包括大中规模的公司,混合应用在质量上的表现似乎没有满足客户的要求,给人的感觉是活糙、不够专业。

[听说应用商店里的前 100 名都不是混合应用](https://medium.com/lunabee-studio/why-hybrid-apps-are-crap-6f827a42f549#.lakqptjw6),我没有证据支持这一观点。如果说有百分之零到百分之五是混合应用,我就不怀疑了。

>

> [我们最大的错误是在 HTML5 身上下了太多的赌注](https://techcrunch.com/2012/09/11/mark-zuckerberg-our-biggest-mistake-with-mobile-was-betting-too-much-on-html5/) — 马克·扎克伯格

>

>

>

### 解决方案

如果你紧跟移动开发动向,那么你绝对听说过像 [NativeScript](https://www.nativescript.org/) 和 [React Native](https://facebook.github.io/react-native/) 这样的项目。

通过这些项目,使用由 JavaScript 写成的基本 UI 组成块,像常规 iOS 和 Android 应用那样,就可以构建出高质量的原生移动应用。

你可以仅用一位工程师,也可以用一个专业的工程师团队,通过 React Native 使用 [现有代码库](https://github.com/necolas/react-native-web) 或者 [底层技术](https://facebook.github.io/react/) 进行跨平台移动应用开发、[原生桌面开发](https://github.com/ptmt/react-native-macos),甚至还有 web 开发。把你的应用发布到 APP Store 上、 Play Store 上,还有 Web 上。如此可以在保证不丧失原生应用性能和质量的同时,使成本仅占传统开发的一小部分。

通过 React Native 进行跨平台开发时重复使用其中 90% 的代码也不是没有的事,这个范围通常是 80% 到 90%。

如果你的团队使用 React Native, 既可以消除团队之间的分歧,也可以让 UI 和 API 的设计更一致,还可以加快开发速度。

在编译时不需要使用 React Native,在保存时应用可以实时更新,也加快了开发速度。

React Native 还可以使用 [Code Push](http://microsoft.github.io/code-push/) 和 [AppHub](https://apphub.io/) 这样的工具来远程更新你的 JavaScript 代码。这意味着你可以向用户实时推送更新、新特性,快速修复 bug,绕过打包、发布这些工作,绕过 App Store、Google Play Store 的审核,省去了耗时 2 到 7 天的过程(App Store 一直是整个过程的痛点)。混合应用的这些优势原生应用不可能比得上。

如果这个领域的创新力能像刚发行时那样保持,将来你甚至可以为 [Apple Watch](https://github.com/elliottsj/apple-watch-uikit)、[Apple TV](https://github.com/douglowder/react-native-appletv),和 [Tizen](https://www.tizen.org/blogs/srsaul/2016/samsung-committed-bringing-react-native-tizen) 这样的平台开发应用。

>

> NativeScript 依然是个相当年轻的框架驱动,Angular 版本 2,[上个月刚刚发布测试版](http://angularjs.blogspot.com/2016/09/angular2-final.html)。但只要它保持良好的市场份额,未来就很有前途。

>

>

>

你可能还不知道世界上一些最能创新、最大的科技公司在这类技术上下了很大的赌注,特别是 [React Native](https://facebook.github.io/react-native/)。

我供职过的多家企业以及世界 500 强公司目前都在转移至 React Native。

### 在产品中特别注意使用 React Native

看下面的例子,[这是一个使用 React Native 技术的著名应用列表](https://facebook.github.io/react-native/showcase.html)。

#### Facebook

*Facebook 公司的 React Native 应用*

Facebook 的两款应用 [Ads Manager](https://play.google.com/store/apps/details?id=com.facebook.adsmanager) 和 [Facebook Groups](https://itunes.apple.com/us/app/facebook-groups/id931735837?mt=8) 都在使用 React Native 技术,并且[将会应用到实现动态消息的框架上](https://devchat.tv/react-native-radio/40-navigation-in-react-native-with-eric-vicenti)。

Facebook 也会投入大量的资金创立和维护像 React Native 这样的开源项目,而且开源项目的开发者最近已经创建很多了不起的项目,这是很了不起的工作,像我以及全世界的业务每天都从中享受诸多好处。

#### Instagram

*Instagram*

Instagram 应用的一部分已经使用了 React Native 技术。

#### Airbnb

*Airbnb*

Airbnb 的很多东西正用 React Native 重写。(来自 [Leland Richardson](https://medium.com/u/41a8b1601c59))

超过 90% 的 Airbnb 旅行平台都是用 React Native 写的。(来自 [spikebrehm](https://medium.com/u/71a78c1b069b))

#### Vogue

*Vogue 是 2016 年度十佳应用之一*

Vogue 这么突出不仅仅因为它也用 React Native 写成,而是[因为它被苹果公司评为年度十佳应用之一](http://www.highsnobiety.com/2016/12/08/iphone-apps-best-of-the-year-2016/)。

#### 沃尔玛

*Walmart Labs*

查看这篇 [Keerti](https://medium.com/@Keerti) 的[文章](https://medium.com/walmartlabs/react-native-at-walmartlabs-cdd140589560#.azpn97g8t)来了解沃尔玛是怎样看待 React Native 的优势的。

#### 微软

微软在 React Native 身上下的赌注很大。

它早已发布多个开源工具,包括 [Code Push](http://microsoft.github.io/code-push/)、[React Native VS Code](https://github.com/Microsoft/vscode-react-native),以及 [React Native Windows](https://github.com/ReactWindows/react-native-windows),旨在帮助开发者向 React Native 领域转移。

微软考虑的是那些已经使用 React Native 为 iOS 和 Android 开发应用的开发者,他们可以重用高达 90% 的代码,不用花费太多额外的时间和成本就可将应用发布到 Windows 上。

微软对 React Native 生态的贡献十分广泛,过去几年在开源界的表现很抢眼。

### 结论

移动应用界面设计和移动应用开发要进行范式转变,下一步就是 React Native 以及与其相似的技术。

#### 公司

如果你的公司正想着削减成本、加快开发速度,而又不想在应用质量和性能上妥协,这是最适合使用 React Native 的时候,它能提高你的净利润。

#### 开发者

如果你是一个开发者,想进入一个将来会快速发展的领域,我强烈推荐你把 React Native 列入你的学习清单。

如果了解 JavaScript,你会入门很快,工具我首推 [Exponent](https://medium.com/u/df61a4267d7a),其他的就看你怎么想了。使用 Exponent 开发者可以轻松的编译、测试和发布跨 Windows 和 MacOS 两个平台的 React Native 应用。

如果已经是一位原生应用开发者,你更会受益匪浅。因为在需要时你能够胜任深入研究原生应用边缘的工作。虽然不会经常用到,但在团队需要时这可是十分宝贵的能力。

我花了很多时间来学习、指导别人 React Native。因为它让我十分激动,而且使用这个框架创作应用也是我一个平淡的小乐趣。

感谢阅读。

---

作者简介:

教授和构建 React Native 应用的软件开发专家

---

via: <https://hackernoon.com/the-cost-of-native-mobile-app-development-is-too-damn-high-4d258025033a>

作者:[Nader Dabit](https://hackernoon.com/@dabit3) 译者:[fuowang](https://github.com/fuowang) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 200 | OK |

If you’re interested in learning more about React Native for your company or team, check out [React Native Training.](http://reactnative.training/?ref=hackernoon.com)

*A tipping point has been reached.* With the exception of a few unique use cases, it no longer makes sense to build and maintain your mobile applications using native frameworks and native development teams.

Average cost of employing iOS, Android, and JavaScript developers in the United States ([http://www.indeed.com/salary](http://www.indeed.com/salary?ref=hackernoon.com), [http://www.payscale.com/research/US/Skill=JavaScript/Salary](http://www.payscale.com/research/US/Skill=JavaScript/Salary?ref=hackernoon.com))

The cost of native mobile application development has been spiraling out of control for the past few years. It has become increasingly difficult for new startups without substantial funding to create native apps, MVPs and prototypes. Existing companies, who need to hold on to talent in order to iterate on existing applications or build new applications, are [fighting](http://www.bizjournals.com/charlotte/how-to/human-resources/2016/12/employers-offer-premium-wages-skilled-workers.html?ref=hackernoon.com) [tooth](https://www.cnet.com/news/silicon-valley-talent-wars-engineers-come-get-your-250k-salary/?ref=hackernoon.com) and [nail](http://www.nytimes.com/2015/08/19/technology/unicorns-hunt-for-talent-among-silicon-valleys-giants.html?ref=hackernoon.com) [with companies from all around the world](http://blogs.wsj.com/cio/2016/09/30/tech-talent-war-moves-to-africa/?ref=hackernoon.com) and will do whatever it takes to retain the best of the best.

Cost of developing an MVP early 2015, Native vs Hybrid ([Comomentum.com](http://www.comentum.com/mobile-app-development-cost.html?ref=hackernoon.com))

If you are a huge company or you are flush with cash, the old thinking was that as long as you threw enough money at native application development, you did not have anything to worry about. This is no longer the case.

Facebook, the last company in the world who you would think of as behind in the war for talent (because they aren’t), was facing problems with their native app that money could not fix. The application had gotten so large and complex that [they were seeing compilation times of up to 15 minutes for their mobile app](https://devchat.tv/react-native-radio/08-bridging-react-native-components-with-tadeu-zagallo?ref=hackernoon.com). This means that even testing minor user interface changes, like moving something around by a couple of points, could take hours (or even days).

In addition to the long compilation times, any time they needed to test a small change to their app the update needed to be implemented and tested in two completely different environments (iOS and Android) with teams working with different languages and frameworks, muddying the waters even more.

Facebook’s solution to this problem is [React Native](https://facebook.github.io/react-native/?ref=hackernoon.com).

[Some people think mobile apps are doomed.](https://medium.com/javascript-scene/native-apps-are-doomed-ac397148a2c0?ref=hackernoon.com#.w06yd23ej) While I really enjoy and respect [Eric Elliott](https://medium.com/@_ericelliott?ref=hackernoon.com) and his work, let’s take a look at some recent data and discuss some opposing viewpoints:

Time spent in mobile apps (April 2016, [smartinsights.com](http://www.smartinsights.com/mobile-marketing/mobile-marketing-analytics/mobile-marketing-statistics/attachment/percent-time-spent-on-mobile-apps-2016/?ref=hackernoon.com))

90% of Time on Mobile is Spent in Apps

There are 2.5 billion people on mobile phones in the world right now. [That number is going to be 5 billion sooner than we think.](http://ben-evans.com/benedictevans/2016/12/8/mobile-is-eating-the-world?ref=hackernoon.com) *It is absolutely insane to think that leaving 4.5 billion people out of your business or application makes sense* *in most scenarios.*

The old argument was that native mobile application development was too expensive for most companies. While this was true, the cost of web development is also on the rise, with [the average salary of a JavaScript developer in the US being in the range of $97,000.00](http://www.indeed.com/salary?q1=javascript%20developer&l1=united%20states&tm=1&ref=hackernoon.com).

With the increased complexity and skyrocketing demand for high quality web development, the average price for a JavaScript developer is inching towards that of a Native developer. Arguing that web development is cheaper is no longer a valid argument.

Hybrid apps are HTML5 apps that are wrapped inside of a native container and provide access to native platform features. Cordova and PhoneGap are prime examples.

*If you’re looking to build an MVP, prototype, or are not worried about the user experience mimicking that of a native app, then a hybrid app may work for you, keeping in mind the entire project will need to be rewritten if you do end up wanting to go native.*

There are many innovative things going on in this space, my favorite being the [Ionic Framework](https://ionicframework.com/?ref=hackernoon.com). Hybrid is getting better and better, but it is still not as fluid or natural feeling as Native.

For many companies, including most serious startups as well as medium and large sized companies, hybrid apps may not deliver the quality that they want and that their customers demand, leaving the feeling unpolished and less professional.

[While I have read and heard that of the top 100 apps on the app store, zero of them are hybrid,](https://medium.com/lunabee-studio/why-hybrid-apps-are-crap-6f827a42f549?ref=hackernoon.com#.lakqptjw6) I have not been able to back up this claim with evidence, but I would not doubt if the number were between zero and 5, and this is for a reason.

[Our Biggest Mistake Was Betting Too Much On HTML5]— Mark Zuckerberg

If you’ve been keeping up with the mobile development landscape you have undoubtedly heard of projects such as [NativeScript](https://www.nativescript.org/?ref=hackernoon.com) and [React Native](https://facebook.github.io/react-native/?ref=hackernoon.com).

These projects allow you to build native quality mobile applications with JavaScript and use the same fundamental UI building blocks as regular iOS and Android apps.

With React Native **you can have a single engineer or team of engineers specialize in cross platform mobile app development**, [native desktop development](https://github.com/ptmt/react-native-macos?ref=hackernoon.com), and even web development [using the existing codebase](https://github.com/necolas/react-native-web?ref=hackernoon.com) or [the underlying technology](https://facebook.github.io/react/?ref=hackernoon.com), shipping your applications to the App Store, the Play Store, and the Web for a fraction of the traditional cost without losing out on the benefits of native performance and quality.

It is not unheard of for React Native apps to reuse up to 90% of their code across platforms, though the range is usually between 80% and 90%.

If your company is using React Native, it eliminates the divide between teams resulting in more consistency in both the UI and the APIs being built, speeding up the development time.

There is no need for compilation with React Native, as the app updates instantly when saving, also speeding up development time.

React Native also allows you to use tools such as [Code Push](http://microsoft.github.io/code-push/?ref=hackernoon.com) and [AppHub](https://apphub.io/?ref=hackernoon.com) to remotely update your JavaScript code. This means that you can push updates, features, and bug fixes instantly to your users, bypassing the labor of bundling, submitting, and having your app accepted to the App and Google play stores, a process that can take between 2 and 7 days (the App Store being the main pain point in this process). This is something that is not possible with native apps, though is possible with hybrid apps.

If innovation in this space continues as it has been since it’s release, in the future you will even be able to build for platforms such as the [Apple Watch](https://github.com/elliottsj/apple-watch-uikit?ref=hackernoon.com) , [Apple TV](https://github.com/douglowder/react-native-appletv?ref=hackernoon.com), and [Tizen](https://www.tizen.org/blogs/srsaul/2016/samsung-committed-bringing-react-native-tizen?ref=hackernoon.com) to name a few.

NativeScript is still fairly new as the framework powering it, Angular 2,

[was just released out of beta a few months ago,]but it too has a promising future as long as Angular2 holds on to a decent share of the market.

What you may not know is that some of **the most innovative and largest technology companies in the world are betting big on these types of technologies,** specifically [React Native.](https://facebook.github.io/react-native/?ref=hackernoon.com)

I have also spoken to and am working with multiple enterprise and fortune 500 companies currently making the switch to React Native.

Along with the below examples, [here is a list of notable apps using React Native.](https://facebook.github.io/react-native/showcase.html?ref=hackernoon.com)

React Native Apps by Facebook

Facebook is now using React Native for both [Ads Manager](https://play.google.com/store/apps/details?id=com.facebook.adsmanager&ref=hackernoon.com) and [Facebook Groups,](https://itunes.apple.com/us/app/facebook-groups/id931735837?mt=8&ref=hackernoon.com) and [will be implementing the framework to power it’s news feed.](https://devchat.tv/react-native-radio/40-navigation-in-react-native-with-eric-vicenti?ref=hackernoon.com)

Facebook also spends a lot of money creating and maintaining open source projects such as React Native, and t[hey and their open source developers have done a fantastic job lately by creating a lot of awesome projects](https://code.facebook.com/projects/?ref=hackernoon.com) that people like me and businesses all around the world benefit greatly from using on a daily basis.

React Native has been implemented in parts of the Instagram mobile app.

Airbnb

Much of Airbnb is being rewritten in React Native (via [Leland Richardson](https://medium.com/@intelligibabble?ref=hackernoon.com))

Over 90% of the Airbnb Trips Platform is written in React Native (via [spikebrehm](https://medium.com/@spikebrehm?ref=hackernoon.com))

Vogue Top 10 apps of 2016

Vogue stands out not only because it was also written in React Native, but [because it was ranked as one of the 10 Best Apps of the Year, according to Apple](http://www.highsnobiety.com/2016/12/08/iphone-apps-best-of-the-year-2016/?ref=hackernoon.com).

**Walmart**

Walmart Labs

Check out [this](https://medium.com/walmartlabs/react-native-at-walmartlabs-cdd140589560?ref=hackernoon.com#.azpn97g8t) blog post by [Keerti](https://medium.com/@Keerti?ref=hackernoon.com) to learn more about how Walmart is taking advantage of React Native.

**Microsoft**

Microsoft is betting heavily on React Native.

They have already release multiple open source tools, including [Code Push](http://microsoft.github.io/code-push/?ref=hackernoon.com), [React Native VS Code,](https://github.com/Microsoft/vscode-react-native?ref=hackernoon.com) and [React Native Windows](https://github.com/ReactWindows/react-native-windows?ref=hackernoon.com), in the shift towards helping developers in the React Native space.

Their thoughts behind this are that if people are already building their apps using React Native for iOS and Android, and they can reuse up to 90% of their code, then s_hipping to Windows costs them little extra relative to the cost && time already spent building the app in the first place._

Microsoft has contributed extensively to the React Native ecosystem and have done an excellent job in the Open Source space over the past few years.

React Native and similar technologies are the next step and a paradigm shift in how we will build mobile UIS and mobile applications.

**Companies**

If your company is looking to cut costs and speed up development time without compromising on quality or performance, React Native is ready for prime time and will benefit your bottom line.

**Developers**

If you are a developer and want to enter into an rapidly evolving space with substantial future up side, I would highly recommend looking at adding React Native to your list of things to learn.

If you know JavaScript, you can hit the ground running very quickly, and I would recommend first trying it out using [Exponent](https://medium.com/@expo?ref=hackernoon.com) and seeing what you think. Exponent allows developers to easily build, test ,and deploy cross platform React Native apps on both Windows and macOS.

If you are already a native Developer, you will benefit especially because you will be able to competently dig into the native side of things when needed, something that is not needed often but when needed is a highly valuable skill to have on a team.

I have spent a lot of my time learning and teaching others about React Native because I am extremely excited about it and it is just plain fun to create apps using the framework.

Thanks for reading.

My Name is

[Nader Dabit]. I am a Developer Advocate at[AWS Mobile]working with projects like[AppSync]and[Amplify], and the founder of[React Native Training].

If you enjoyed this article, please recommend and share it! Thanks for your time |

8,522 | 美联邦法院裁定:GPL 是可执行的合约 | https://qz.com/981029/a-federal-court-has-ruled-that-an-open-source-license-is-an-enforceable-contract/ | 2017-05-19T09:07:00 | [

"GPL",

"开源许可证"

] | https://linux.cn/article-8522-1.html | 韩国一家开发了 Hancom Office 办公软件的公司在其字处理软件中集成了开源软件 Ghostscript,但是没有遵守 Ghostscript 的 GNU GPL 许可证而开源,也没有为该软件付费。近日,该韩国公司被美国联邦法院裁定其违约。

Ghostscript 是一个开源软件,由 Artifex 公司开发,其采用了两种许可证:

* GNU GPL 许可证

* 商业付费许可证

如果要免费使用 Ghostscript,Hancom 就需要遵循该软件的开源许可证,即 GNU GPL。该许可证要求,如果你的软件中使用了采用该许可协议的软件,并公开发布的话,就需要也采用同样的 GNU GPL 许可证开源。也就是说, Hancom 需要开源其整个办公软件套件。

否则,Hancom 就需要向 Ghostscript 的开发商 Artifex 公司支付商业许可证费用。Artifex 允许商业或其它闭源软件开发商绕开严格的开源许可证 GNU GPL,只要付费就行。

但是 Hancom 从 2013 年在其软件中使用了 Ghostscript 之后,却什么都没做:既没有开源其软件,也没有向 Artifex 公司付商业许可证的费用。

在 2016 年底,交涉无果的 Artifex 公司向美国加利福尼亚北部地区法院发起了诉讼。

“在发现 Hancom 违反了 GNU GPL 许可证,侵犯了 Artifex 的 Ghostscript 的宝贵版权之后,Artifex 要求 Hancom 停止其侵权行为,并为其多年无版权使用 Ghostscript 支付合理的版权费用,”该公司陈述到,“Hancom 拒绝了该要求,Artifex 转而寻求本法院责令 Hancom 停止进一步侵权并支付其滥用 Artifex 的开源许可证的费用。”

Artifex 还提到 Hancom 在 2015 年收入了 8630 万美元。

像 GUN GPL 这样的开源许可证的可执行性长期以来一直是一个悬而未决的法律问题。美国联邦巡回法庭在 2006 年的一个判例,雅各布森诉卡泽尔案中,对开源许可证的侵犯裁定可视作对版权申明的处理。但是在本案之前,这种侵犯开源许可证是否可以依法视作侵犯合约并未裁定。

Hancom 尝试发起动议以驳回该诉讼,其认为该公司并未签署任何东西,所以该许可证并不是真正的合约。

“并不是这样”,杰奎琳·斯科特·科里法官在 4 月 25 日的议案中说。她说 GNU GPL “规定了如果用户没有获取商业许可证,即表示同意其条款。原告称被告没有获取商业许可证,并公开表明其在 GNU GPL 下使用 Ghostscript。这些指控足以为合约的存在而辩护。”

科里法官驳回了 Hancom 的动议。按照这样的做法,就树立了像 GNU GPL 这样的开源许可证可以被视作法律合约的先例,在开发商违反了开源许可证时会被起诉。这对于开源社区来说是一个重大胜利。

当然,Artifex 是否可以最终赢得这一诉讼,还要看后继的上诉和裁定。

| 301 | Moved Permanently | null |

8,523 | Rowhammer:针对物理内存的攻击可以取得 Android 设备的 root 权限 | http://www.csoonline.com/article/3134726/security/physical-ram-attack-can-root-android-and-possibly-other-devices.html | 2017-05-20T08:32:00 | [

"Rowhammer",

"攻击"

] | https://linux.cn/article-8523-1.html |

>

> 攻击者确实可以在物理存储单元中实现位翻转来达到侵入移动设备与计算机的目的

>

>

>

研究者们发现了一种新的在不利用任何软件漏洞情况下,利用内存芯片物理设计上的弱点来侵入 Android 设备的方式。这种攻击技术同样可以影响到其它如 ARM 和 X86 架构的设备与计算机。

这种称之为“Rowhammer”的攻击起源于过去十多年中将更多的 DRAM(动态随机存取存储器)容量封装进越来越小的芯片中,这将导致在特定情况下存储单元电子可以从相邻两<ruby> 行 <rt> row </rt></ruby>的一边泄漏到另一边。(LCTT 译注:参见 [https://en.wikipedia.org/wiki/Row\_hammer)](https://en.wikipedia.org/wiki/Row_hammer%EF%BC%89)

例如,反复且快速的访问相同的物理储存位置,这种被称为 “<ruby> 锤击 <rt> hammering </rt></ruby>” 的行为可以导致相邻位置的位值从 0 反转成 1,或者相反。

虽然这样的电子干扰已经被生产商知晓并且从可靠性角度研究了一段时间了,因为内存错误能够导致系统崩溃。而研究者们现在展示了在可控方式的触发下它所存在的严重安全隐患。

在 2015 年 4 月,来自谷歌 Project Zero 项目的研究者公布了两份基于内存 “Rowhammer”漏洞对于 x86-64 CPU 架构的 [提权利用](http://www.computerworld.com/article/2895898/google-researchers-hack-computers-using-dram-electrical-leaks.html)。其中一份利用可以使代码从谷歌的 Chrome 浏览器沙盒里逃逸并且直接在系统上执行,另一份可以在 Linux 机器上获取内核级权限。

此后,其他的研究者进行了更深入的调查并且展示了[通过网站中 JaveScript 脚本进行利用的方式](http://www.computerworld.com/article/2954582/security/researchers-develop-astonishing-webbased-attack-on-a-computers-dram.html)甚至能够影响运行在云环境下的[虚拟服务器](http://www.infoworld.com/article/3105889/security/flip-feng-shui-attack-on-cloud-vms-exploits-hardware-weaknesses.html)。然而,对于这项技术是否可以应用在智能手机和移动设备大量使用的 ARM 架构中还是有疑问的。

现在,一队成员来自荷兰阿姆斯特丹自由大学、奥地利格拉茨技术大学和加州大学圣塔芭芭拉分校的 VUSec 小组,已经证明了 Rowhammer 不仅仅可以应用在 ARM 架构上并且甚至比在 x86 架构上更容易。

研究者们将他们的新攻击命名为 Drammer,代表了 Rowhammer 确实存在,并且计划于周三在维也纳举办的第 23 届 ACM 计算机与通信安全大会上展示。这种攻击建立在之前就被发现与实现的 Rowhammer 技术之上。

VUSec 小组的研究者已经制造了一个适用于 Android 设备的恶意应用,当它被执行的时候利用不易察觉的内存位反转在不需要任何权限的情况下就可以获取设备根权限。

研究者们测试了来自不同制造商的 27 款 Android 设备,21 款使用 ARMv7(32-bit)指令集架构,其它 6 款使用 ARMv8(64-bit)指令集架构。他们成功的在 17 款 ARMv7 设备和 1 款 ARMv8 设备上实现了为反转,表明了这些设备是易受攻击的。

此外,Drammer 能够与其它的 Android 漏洞组合使用,例如 [Stagefright](http://www.csoonline.com/article/3045836/security/new-stagefright-exploit-puts-millions-of-android-devices-at-risk.html) 或者 [BAndroid](https://www.vusec.net/projects/bandroid/) 来实现无需用户手动下载恶意应用的远程攻击。

谷歌已经注意到了这一类型的攻击。“在研究者向谷歌漏洞奖励计划报告了这个问题之后,我们与他们进行了密切的沟通来深入理解这个问题以便我们更好的保护用户,”一位谷歌的代表在一份邮件申明中这样说到。“我们已经开发了一个缓解方案,将会包含在十一月的安全更新中。”(LCTT 译注:缓解方案,参见 <https://en.wikipedia.org/wiki/Vulnerability_management>)

VUSec 的研究者认为,谷歌的缓解方案将会使得攻击过程更为复杂,但是它不能修复潜在的问题。

事实上,从软件上去修复一个由硬件导致的问题是不现实的。硬件供应商正在研究相关问题并且有可能在将来的内存芯片中被修复,但是在现有设备的芯片中风险依然存在。

更糟的是,研究者们说,由于有许多因素会影响到攻击的成功与否并且这些因素尚未被研究透彻,因此很难去说有哪些设备会被影响到。例如,内存控制器可能会在不同的电量的情况下展现不同的行为,因此一个设备可能在满电的情况下没有风险,当它处于低电量的情况下就是有风险的。

同样的,在网络安全中有这样一句俗语:<ruby> 攻击将变本加厉,如火如荼 <rt> Attacks always get getter, they never get worse </rt></ruby>。Rowhammer 攻击已经从理论变成了现实可能,同样的,它也可能会从现在的现实可能变成确确实实的存在。这意味着今天某个设备是不被影响的,在明天就有可能被改进后的 Rowhammer 技术证明它是存在风险的。

Drammer 在 Android 上实现是因为研究者期望研究基于 ARM 设备的影响,但是潜在的技术可以被使用在所有的架构与操作系统上。新的攻击相较于之前建立在运气与特殊特性与特定平台之上并且十分容易失效的技术已经是一个巨大的进步了。

Drammer 攻击的实现依靠于被包括图形、网络、声音等大量硬件子系统所使用的 DMA(直接存储访问)缓存。Drammer 的实现采用了所有操作系统上都有的 Android 的 ION 内存分配器、接口与方法,这给我们带来的警示是该论文的主要贡献之一。

“破天荒的,我们成功地展示了我们可以做到,在不依赖任何特定的特性情况下完全可靠的证明了 Rowhammer”, VUSec 小组中的其中一位研究者 Cristiano Giuffrida 这样说道。“攻击所利用的内存位置并非是 Android 独有的。攻击在任何的 Linux 平台上都能工作 -- 我们甚至怀疑其它操作系统也可以 -- 因为它利用的是操作系统内核内存管理中固有的特性。”

“我期待我们可以看到更多针对其它平台的攻击的变种,”阿姆斯特丹自由大学的教授兼 VUSec 系统安全研究小组的领导者 Herbert Bos 补充道。

在他们的[论文](https://vvdveen.com/publications/drammer.pdf)之外,研究者们也释出了一个 Android 应用来测试 Android 设备在当前所知的技术条件下受到 Rowhammer 攻击时是否会有风险。应用还没有传上谷歌应用商店,可以从 [VUSec Drammer 网站](https://www.vusec.net/projects/drammer/) 下载来手动安装。一个开源的 Rowhammer 模拟器同样能够帮助其他的研究者来更深入的研究这个问题。

---

via:<http://www.csoonline.com/article/3134726/security/physical-ram-attack-can-root-android-and-possibly-other-devices.html>

作者:[Lucian Constantin](http://www.csoonline.com/author/Lucian-Constantin/) 译者:[wcnnbdk1](https://github.com/wcnnbdk1) 校对:[wxy](https://github.com/wxy)

本文由 [LCTT](https://github.com/LCTT/TranslateProject) 原创编译,[Linux中国](https://linux.cn/) 荣誉推出

| 301 | Moved Permanently | null |

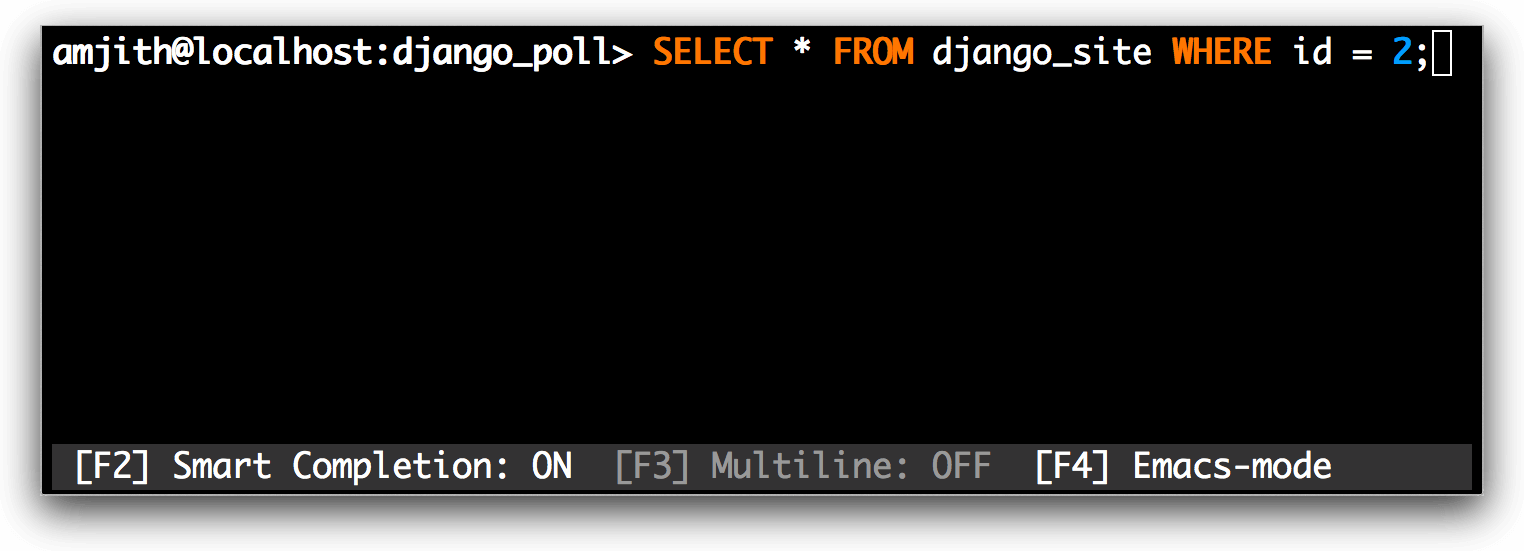

8,524 | GraphQL 用例:使用 Golang 和 PostgreSQL 构建一个博客引擎 API | http://alexandrutopliceanu.ro/post/graphql-with-go-and-postgresql | 2017-05-19T11:18:22 | [

"GraphQL",

"图数据库"

] | https://linux.cn/article-8524-1.html |

### 摘要

GraphQL 在生产环境中似乎难以使用:虽然对于建模功能来说图接口非常灵活,但是并不适用于关系型存储,不管是在实现还是性能方面。

在这篇博客中,我们会设计并实现一个简单的博客引擎 API,它支持以下功能:

* 三种类型的资源(用户、博文以及评论)支持多种功能(创建用户、创建博文、给博文添加评论、关注其它用户的博文和评论,等等。)

* 使用 PostgreSQL 作为后端数据存储(选择它因为它是一个流行的关系型数据库)。

* 使用 Golang(开发 API 的一个流行语言)实现 API。

我们会比较简单的 GraphQL 实现和纯 REST 替代方案,在一种普通场景(呈现博客文章页面)下对比它们的实现复杂性和效率。

### 介绍

GraphQL 是一种 IDL(<ruby> 接口定义语言 <rp> ( </rp> <rt> Interface Definition Language </rt> <rp> ) </rp></ruby>),设计者定义数据类型和并把数据建模为一个<ruby> 图 <rp> ( </rp> <rt> graph </rt> <rp> ) </rp></ruby>。每个顶点都是一种数据类型的一个实例,边代表了节点之间的关系。这种方式非常灵活,能适应任何业务领域。然而,问题是设计过程更加复杂,而且传统的数据存储不能很好地映射到图模型。阅读*附录1*了解更多关于这个问题的详细信息。

GraphQL 在 2014 年由 Facebook 的工程师团队首次提出。尽管它的优点和功能非常有趣而且引人注目,但它并没有得到大规模应用。开发者需要权衡 REST 的设计简单性、熟悉性、丰富的工具和 GraphQL 不会受限于 CRUD(LCTT 译注:Create、Read、Update、Delete) 以及网络性能(它优化了往返服务器的网络)的灵活性。

大部分关于 GraphQL 的教程和指南都跳过了从数据存储获取数据以便解决查询的问题。也就是,如何使用通用目的、流行存储方案(例如关系型数据库)为 GraphQL API 设计一个支持高效数据提取的数据库。

这篇博客介绍构建一个博客引擎 GraphQL API 的流程。它的功能相当复杂。为了和基于 REST 的方法进行比较,它的范围被限制为一个熟悉的业务领域。

这篇博客的文章结构如下:

* 第一部分我们会设计一个 GraphQL 模式并介绍所使用语言的一些功能。

* 第二部分是 PostgreSQL 数据库的设计。

* 第三部分介绍了使用 Golang 实现第一部分设计的 GraphQL 模式。

* 第四部分我们以从后端获取所需数据的角度来比较呈现博客文章页面的任务。

### 相关阅读

* 很棒的 [GraphQL 介绍文档](http://graphql.org/learn/)。

* 该项目的完整实现代码在 [github.com/topliceanu/graphql-go-example](https://github.com/topliceanu/graphql-go-example)。

### 在 GraphQL 中建模一个博客引擎

下述*列表1*包括了博客引擎 API 的全部模式。它显示了组成图的顶点的数据类型。顶点之间的关系,也就是边,被建模为指定类型的属性。

```

type User {

id: ID

email: String!

post(id: ID!): Post

posts: [Post!]!

follower(id: ID!): User

followers: [User!]!

followee(id: ID!): User

followees: [User!]!

}

type Post {

id: ID

user: User!

title: String!

body: String!

comment(id: ID!): Comment

comments: [Comment!]!

}

type Comment {

id: ID

user: User!

post: Post!

title: String

body: String!

}

type Query {

user(id: ID!): User

}

type Mutation {

createUser(email: String!): User

removeUser(id: ID!): Boolean

follow(follower: ID!, followee: ID!): Boolean

unfollow(follower: ID!, followee: ID!): Boolean

createPost(user: ID!, title: String!, body: String!): Post

removePost(id: ID!): Boolean

createComment(user: ID!, post: ID!, title: String!, body: String!): Comment

removeComment(id: ID!): Boolean

}

```

*列表1*

模式使用 GraphQL DSL 编写,它用于定义自定义数据类型,例如 `User`、`Post` 和 `Comment`。该语言也提供了一系列原始数据类型,例如 `String`、`Boolean` 和 `ID`(它是`String` 的别名,但是有顶点唯一标识符的额外语义)。

`Query` 和 `Mutation` 是语法解析器能识别并用于查询图的可选类型。从 GraphQL API 读取数据等同于遍历图。需要提供这样一个起始顶点;该角色通过 `Query` 类型来实现。在这种情况中,所有图的查询都要从一个由 id `user(id:ID!)` 指定的用户开始。对于写数据,定义了 `Mutation` 顶点。它提供了一系列操作,建模为能遍历(并返回)新创建顶点类型的参数化属性。*列表2*是这些查询的一些例子。

顶点属性能被参数化,也就是能接受参数。在图遍历场景中,如果一个博文顶点有多个评论顶点,你可以通过指定 `comment(id: ID)` 只遍历其中的一个。所有这些都取决于设计,设计者可以选择不提供到每个独立顶点的直接路径。

`!` 字符是一个类型后缀,适用于原始类型和用户定义类型,它有两种语义:

* 当被用于参数化属性的参数类型时,表示这个参数是必须的。

* 当被用于一个属性的返回类型时,表示当顶点被获取时该属性不会为空。

* 也可以把它们组合起来,例如 `[Comment!]!` 表示一个非空 Comment 顶点链表,其中 `[]`、`[Comment]` 是有效的,但 `null, [null], [Comment, null]` 就不是。

*列表2* 包括一系列用于博客 API 的 `curl` 命令,它们会使用 mutation 填充图然后查询图以便获取数据。要运行它们,按照 [topliceanu/graphql-go-example](https://github.com/graphql/graphql-js) 仓库中的指令编译并运行服务。

```

# 创建用户 1、2 和 3 的更改。更改和查询类似,在该情景中我们检索新创建用户的 id 和 email。

curl -XPOST http://vm:8080/graphql -d 'mutation {createUser(email:"[email protected]"){id, email}}'

curl -XPOST http://vm:8080/graphql -d 'mutation {createUser(email:"[email protected]"){id, email}}'

curl -XPOST http://vm:8080/graphql -d 'mutation {createUser(email:"[email protected]"){id, email}}'

# 为用户添加博文的更改。为了和模式匹配我们需要检索他们的 id,否则会出现错误。

curl -XPOST http://vm:8080/graphql -d 'mutation {createPost(user:1,title:"post1",body:"body1"){id}}'

curl -XPOST http://vm:8080/graphql -d 'mutation {createPost(user:1,title:"post2",body:"body2"){id}}'

curl -XPOST http://vm:8080/graphql -d 'mutation {createPost(user:2,title:"post3",body:"body3"){id}}'

# 博文所有评论的更改。`createComment` 需要用户 id,标题和正文。看列表 1 的模式。

curl -XPOST http://vm:8080/graphql -d 'mutation {createComment(user:2,post:1,title:"comment1",body:"comment1"){id}}'

curl -XPOST http://vm:8080/graphql -d 'mutation {createComment(user:1,post:3,title:"comment2",body:"comment2"){id}}'

curl -XPOST http://vm:8080/graphql -d 'mutation {createComment(user:3,post:3,title:"comment3",body:"comment3"){id}}'

# 让用户 3 关注用户 1 和用户 2 的更改。注意 `follow` 更改只返回一个布尔值而不需要指定。

curl -XPOST http://vm:8080/graphql -d 'mutation {follow(follower:3, followee:1)}'

curl -XPOST http://vm:8080/graphql -d 'mutation {follow(follower:3, followee:2)}'

# 用户获取用户 1 所有数据的查询。

curl -XPOST http://vm:8080/graphql -d '{user(id:1)}'

# 用户获取用户 2 和用户 1 的关注者的查询。

curl -XPOST http://vm:8080/graphql -d '{user(id:2){followers{id, email}}}'

curl -XPOST http://vm:8080/graphql -d '{user(id:1){followers{id, email}}}'

# 检测用户 2 是否被用户 1 关注的查询。如果是,检索用户 1 的 email,否则返回空。

curl -XPOST http://vm:8080/graphql -d '{user(id:2){follower(id:1){email}}}'

# 返回用户 3 关注的所有用户 id 和 email 的查询。

curl -XPOST http://vm:8080/graphql -d '{user(id:3){followees{id, email}}}'

# 如果用户 3 被用户 1 关注,就获取用户 3 email 的查询。

curl -XPOST http://vm:8080/graphql -d '{user(id:1){followee(id:3){email}}}'

# 获取用户 1 的第二篇博文的查询,检索它的标题和正文。如果博文 2 不是由用户 1 创建的,就会返回空。

curl -XPOST http://vm:8080/graphql -d '{user(id:1){post(id:2){title,body}}}'

# 获取用户 1 的所有博文的所有数据的查询。

curl -XPOST http://vm:8080/graphql -d '{user(id:1){posts{id,title,body}}}'

# 获取写博文 2 用户的查询,如果博文 2 是由 用户 1 撰写;一个现实语言灵活性的例证。

curl -XPOST http://vm:8080/graphql -d '{user(id:1){post(id:2){user{id,email}}}}'

```

*列表2*

通过仔细设计 mutation 和类型属性,可以实现强大而富有表达力的查询。

### 设计 PostgreSQL 数据库

关系型数据库的设计,一如以往,由避免数据冗余的需求驱动。选择该方式有两个原因:

1. 表明实现 GraphQL API 不需要定制化的数据库技术或者学习和使用新的设计技巧。

2. 表明 GraphQL API 能在现有的数据库之上创建,更具体地说,最初设计用于 REST 后端甚至传统的呈现 HTML 站点的服务器端数据库。

阅读 *附录1* 了解关于关系型和图数据库在构建 GraphQL API 方面的区别。*列表3* 显示了用于创建新数据库的 SQL 命令。数据库模式和 GraphQL 模式相对应。为了支持 `follow/unfollow` 更改,需要添加 `followers` 关系。

```

CREATE TABLE IF NOT EXISTS users (

id SERIAL PRIMARY KEY,

email VARCHAR(100) NOT NULL

);

CREATE TABLE IF NOT EXISTS posts (

id SERIAL PRIMARY KEY,

user_id INTEGER NOT NULL REFERENCES users(id) ON DELETE CASCADE,

title VARCHAR(200) NOT NULL,

body TEXT NOT NULL

);

CREATE TABLE IF NOT EXISTS comments (

id SERIAL PRIMARY KEY,

user_id INTEGER NOT NULL REFERENCES users(id) ON DELETE CASCADE,

post_id INTEGER NOT NULL REFERENCES posts(id) ON DELETE CASCADE,

title VARCHAR(200) NOT NULL,

body TEXT NOT NULL

);

CREATE TABLE IF NOT EXISTS followers (

follower_id INTEGER NOT NULL REFERENCES users(id) ON DELETE CASCADE,

followee_id INTEGER NOT NULL REFERENCES users(id) ON DELETE CASCADE,

PRIMARY KEY(follower_id, followee_id)

);

```

*列表3*

### Golang API 实现

本项目使用的用 Go 实现的 GraphQL 语法解析器是 `github.com/graphql-go/graphql`。它包括一个查询解析器,但不包括模式解析器。这要求开发者利用库提供的结构使用 Go 构建 GraphQL 模式。这和 [nodejs 实现](https://github.com/graphql/graphql-js) 不同,后者提供了一个模式解析器并为数据获取暴露了钩子。因此 *列表1* 中的模式只是作为指导使用,需要转化为 Golang 代码。然而,这个*“限制”*提供了与抽象级别对等的机会,并且了解模式如何和用于检索数据的图遍历模型相关。*列表4* 显示了 `Comment` 顶点类型的实现:

```

var CommentType = graphql.NewObject(graphql.ObjectConfig{

Name: "Comment",

Fields: graphql.Fields{

"id": &graphql.Field{

Type: graphql.NewNonNull(graphql.ID),

Resolve: func(p graphql.ResolveParams) (interface{}, error) {

if comment, ok := p.Source.(*Comment); ok == true {

return comment.ID, nil

}

return nil, nil

},

},

"title": &graphql.Field{

Type: graphql.NewNonNull(graphql.String),

Resolve: func(p graphql.ResolveParams) (interface{}, error) {

if comment, ok := p.Source.(*Comment); ok == true {

return comment.Title, nil

}

return nil, nil

},

},

"body": &graphql.Field{

Type: graphql.NewNonNull(graphql.ID),

Resolve: func(p graphql.ResolveParams) (interface{}, error) {

if comment, ok := p.Source.(*Comment); ok == true {

return comment.Body, nil

}

return nil, nil

},

},

},

})

func init() {

CommentType.AddFieldConfig("user", &graphql.Field{

Type: UserType,

Resolve: func(p graphql.ResolveParams) (interface{}, error) {

if comment, ok := p.Source.(*Comment); ok == true {

return GetUserByID(comment.UserID)

}

return nil, nil

},

})

CommentType.AddFieldConfig("post", &graphql.Field{

Type: PostType,

Args: graphql.FieldConfigArgument{

"id": &graphql.ArgumentConfig{

Description: "Post ID",

Type: graphql.NewNonNull(graphql.ID),

},

},

Resolve: func(p graphql.ResolveParams) (interface{}, error) {

i := p.Args["id"].(string)

id, err := strconv.Atoi(i)

if err != nil {

return nil, err

}

return GetPostByID(id)

},

})

}

```

*列表4*

正如 *列表1* 中的模式,`Comment` 类型是静态定义的一个有三个属性的结构体:`id`、`title` 和 `body`。为了避免循环依赖,动态定义了 `user` 和 `post` 两个其它属性。

Go 并不适用于这种动态建模,它只支持一些类型检查,代码中大部分变量都是 `interface{}` 类型,在使用之前都需要进行类型断言。`CommentType` 是一个 `graphql.Object` 类型的变量,它的属性是 `graphql.Field` 类型。因此,GraphQL DSL 和 Go 中使用的数据结构并没有直接的转换。

每个字段的 `resolve` 函数暴露了 `Source` 参数,它是表示遍历时前一个节点的数据类型顶点。`Comment` 的所有属性都有作为 source 的当前 `CommentType` 顶点。检索`id`、`title` 和 `body` 是一个直接属性访问,而检索 `user` 和 `post` 要求图遍历,也需要数据库查询。由于它们非常简单,这篇文章并没有介绍这些 SQL 查询,但在*参考文献*部分列出的 github 仓库中有。

### 普通场景下和 REST 的对比

在这一部分,我们会展示一个普通的博客文章呈现场景,并比较 REST 和 GraphQL 的实现。关注重点会放在入站/出站请求数量,因为这些是造成页面呈现延迟的最主要原因。

场景:呈现一个博客文章页面。它应该包含关于作者(email)、博客文章(标题、正文)、所有评论(标题、正文)以及评论人是否关注博客文章作者的信息。*图1* 和 *图2* 显示了客户端 SPA、API 服务器以及数据库之间的交互,一个是 REST API、另一个对应是 GraphQL API。

```

+------+ +------+ +--------+

|client| |server| |database|

+--+---+ +--+---+ +----+---+

| GET /blogs/:id | |

1\. +-------------------------> SELECT * FROM blogs... |

| +--------------------------->

| <---------------------------+

<-------------------------+ |

| | |

| GET /users/:id | |

2\. +-------------------------> SELECT * FROM users... |

| +--------------------------->

| <---------------------------+

<-------------------------+ |

| | |

| GET /blogs/:id/comments | |

3\. +-------------------------> SELECT * FROM comments... |

| +--------------------------->

| <---------------------------+

<-------------------------+ |

| | |

| GET /users/:id/followers| |

4\. +-------------------------> SELECT * FROM followers.. |

| +--------------------------->

| <---------------------------+

<-------------------------+ |

| | |

+ + +

```

*图1*

```

+------+ +------+ +--------+

|client| |server| |database|

+--+---+ +--+---+ +----+---+

| GET /graphql | |

1\. +-------------------------> SELECT * FROM blogs... |