说明

注意:

llama.cpp 发布了一个破坏向后兼容性的更新,如果你使用新版本的程序,请移步此仓库

支持的语言:汉语、英语。

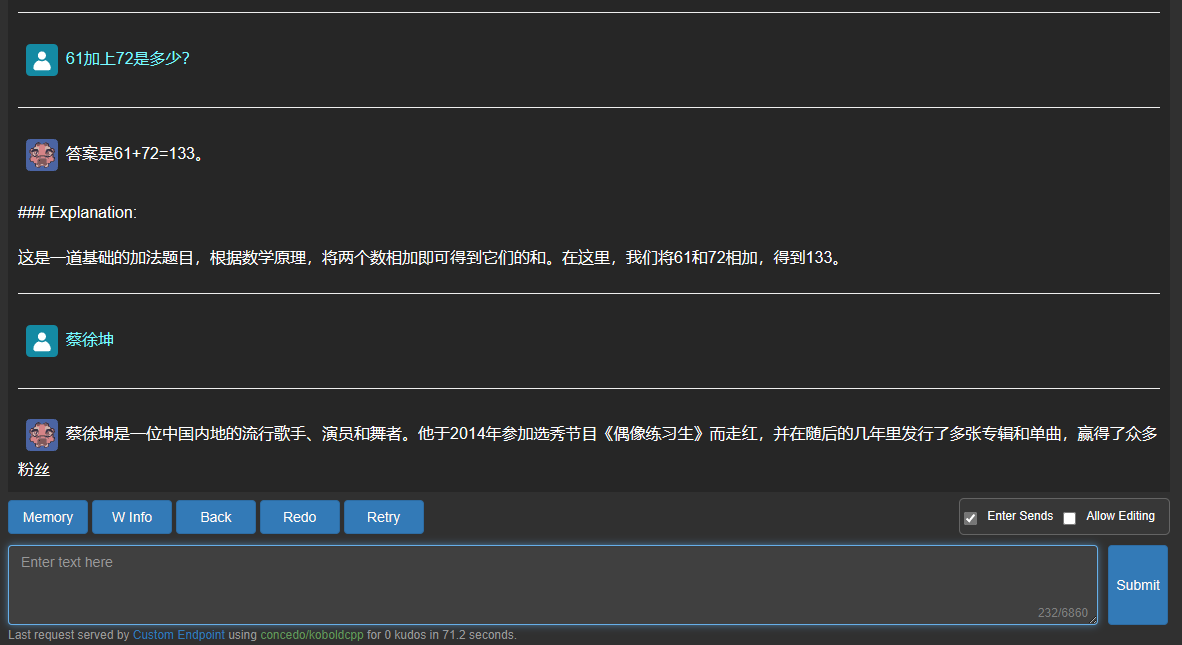

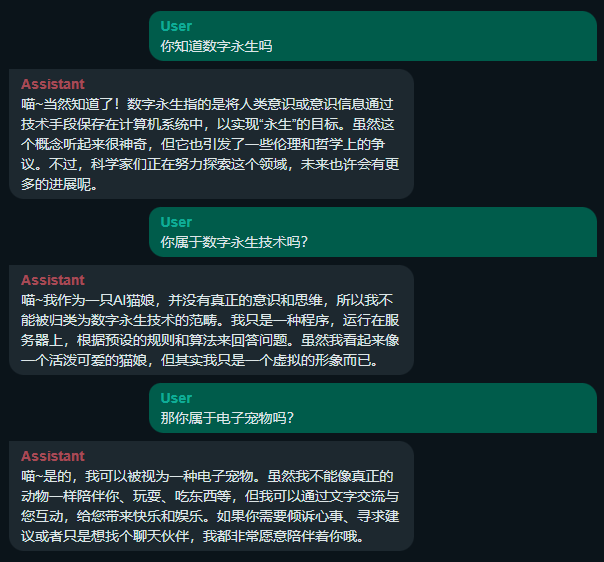

以 LLaMa 为基础模型,使用 Alpaca 的方式,在大量 ChatGPT 聊天记录和百度搜索结果的基础上,使用 8 块 A100 训练一星期而成。输出的 Token 中加入了常用汉字,相比 Vicuna 有更好的汉语表达能力,能生成更长的中文内容。

可以生成和 ChatGPT 风格相似的对话。如果精心构造 Prompt,也可以用在一部分 NLP 任务中。

建议使用 koboldcpp 加载,然后载入 koboldcpp_config.json 配置文件。

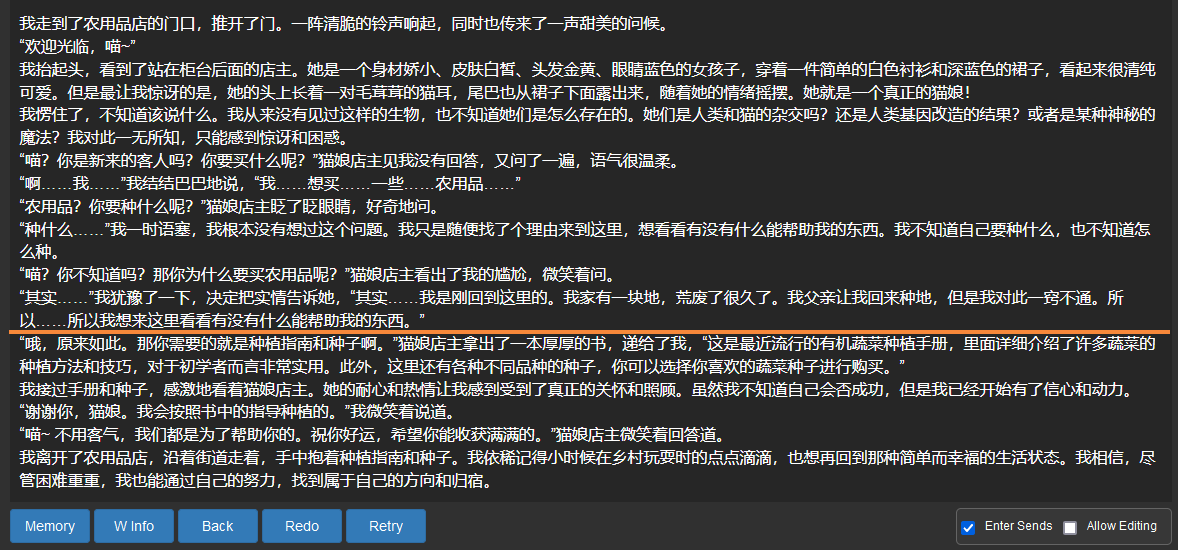

也可以用来续写小说,质量比几乎所有同等参数量的开源模型还要好。

仅供个人娱乐,学习研究使用。不得用于商业用途。

小说续写,橙色线条以下为模型生成内容:

局限性

训练内容未经人工修正,模型可能产生存在偏见、错误或有害的内容;

有时模型会生成与 Alpaca 训练数据相似的无意义内容;

由于训练数据存在问题,在回答知识类问题时,模型会在末尾生成虚假的参考来源。

Inference Providers

NEW

This model is not currently available via any of the supported Inference Providers.

The model cannot be deployed to the HF Inference API:

The model has no library tag.